核心点:完整讲解Transformer模型!

让我们用简单的语言来解释:想象一下,你正在阅读一本书,书中的每个字都很重要。但如果你每次只能关注一个字,理解整本书就会变得很慢。而Transformer模型就像是赋予你超能力,让你一次性查看整页的所有字,并根据上下文判断哪些字更重要。这样,你就能更快、更准确地理解书的内容。

基本概念

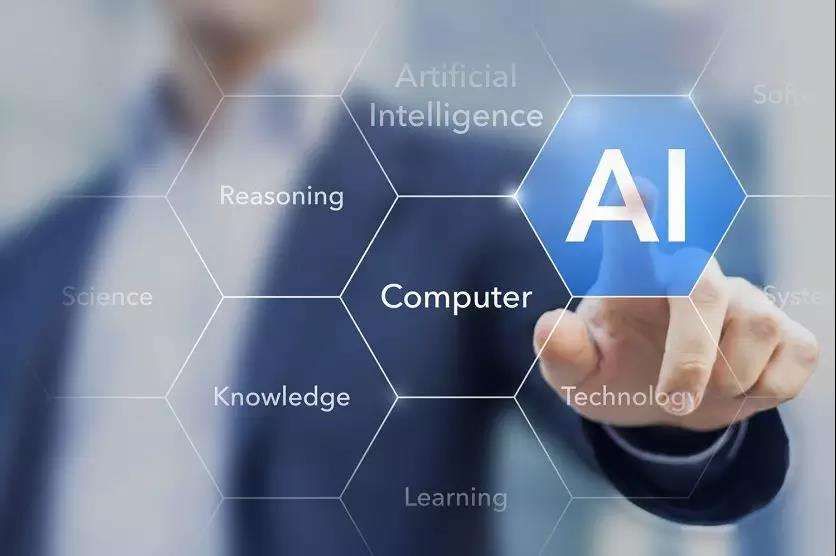

Transformer模型是一种用于处理语言数据的神经网络模型,非常适合用于翻译、文本生成和理解等任务。它是在2017年由谷歌的研究团队提出的,已经成为自然语言处理(NLP)领域的主流方法。Transformer模型通过引入围绕自注意力机制的新颖方法,重塑了自然语言处理(NLP)的格局。

下面,从是什么?结构组成、注意力机制、多头注意力先进行解释~

是什么?

Transformer是一种深度学习模型,用于处理和生成自然语言。它能理解人类语言并生成类似的文本,成为AI领域的重要突破。

结构组成

"Transformer模型,其核心元素包括编码器(Encoder)和解码器(Decoder),各自扮演着读取与生成文本的重任。它们的协同工作主要通过一种独特的“注意力机制”(Attention Mechanism)实现,使得机器能够精准理解并回应输入信息。"

注意力机制

注意力机制,作为Transformer模型的精髓所在,赋予其独特的“关注”能力。这种机制让模型能全面审视输入数据,而非逐一处理词汇。譬如,面对一句长句,模型能同时顾及其中的每一个字,从而提高处理效率。

"Transformer模型的卓越之处在于其独创的“多头注意力”机制。这一机制使得模型能够从多个并行的关注视角进行运算,极大地增强了信息的捕捉能力。这就如同拥有多个独立的观察者,每个都能够发现不同的细节,从而为我们提供了全面、深入的理解。"

那么,为什么 Transformer如此重要?!

首先是,高效处理长文本。

优化后的文章:

"Transformer模型以并行处理和注意力机制,摒弃了传统RNN在处理长文本时的低效性,从而提升了对长文本的处理效率。"

其次,更好的表现。

Transformer模型在NLP任务中大放异彩,如机器翻译、文本摘要和问答系统等。其速度与准确率兼具优势。

Transformer模型凭借其独特的注意力机制和结构设计,在处理自然语言方面相较于传统方法更具高效性和准确性,成为现代NLP任务中至关重要的关键技术。

理论基础

为了便于理解,下面我们会分为以下几个部分进行讲解:

- 输入表示

- 注意力机制

- 多头注意力

- 前馈神经网络

- 位置编码

- 整个Transformer整体架构

1. 输入表示(Input Representation)

将文本转换为向量形式是处理自然语言的关键步骤。我们通常使用词嵌入技术来表示每个单词。假设输入句子的长度为$n$,词嵌入的维度为$d$,那么输入可以表示为一个$n \times d$的矩阵。

2. 注意力机制(Attention Mechanism)

注意力机制,作为Transformer的灵魂,通过计算三个矩阵:查询矩阵、键矩阵和值矩阵,实现对输入序列的深入理解。

- 查询矩阵

- 键矩阵

- 值矩阵

其中, 、 和 是可训练的权重矩阵。

2.1 计算注意力得分

注意力得分通过点积计算得到:

2.2 详细步骤

- 计算点积:

- 除以 :

- 应用 softmax: ,得到注意力权重矩阵

- 加权求和:

3. 多头注意力机制(Multi-head Attention)

多头注意力机制是一种将输入分成多个头进行独立计算的机制,然后将结果拼接起来并投影到输出空间。这种机制可以提高模型的性能和效率。

3.1 分头计算

假设有 个头,每个头的维度为 :

每个头独立计算注意力:

3.2 拼接与线性变换

将所有头的输出拼接起来:

其中 是可训练的投影矩阵。

4. 前馈神经网络(Feed Forward Neural Network)

"注意力头的产出,经由前馈神经网络深化处理。该网络结构包含两个线性变换和ReLU激活函数。"

其中, 和 是权重矩阵, 和 是偏置。

5. 位置编码(Positional Encoding)

Transformer模型中的位置编码是一种将词向量中添加位置信息的技术,可以让Transformer模型理解序列中每个词的相对位置,提高模型对文本的理解能力。位置编码可以通过正弦和余弦函数生成。

对于输入位置 和维度 :

将位置编码添加到输入嵌入向量中:

6. Transformer整体架构

一个完整的Transformer模型由多个编码器层和解码器层组成。

6.1 编码器层(Encoder Layer)

每个编码器层包括以下几个步骤:

- 多头注意力机制:

- 残差连接和层归一化:

- 前馈神经网络:

- 残差连接和层归一化:

6.2 解码器层(Decoder Layer)

每个解码器层与编码器层类似,但多了一个编码器-解码器注意力层:

- 自注意力机制(Masked MultiHead Attention):

- 残差连接和层归一化:

- 编码器-解码器注意力机制: (这里 是解码器的输出, 和 是编码器的输出)

- 残差连接和层归一化:

- 前馈神经网络:

- 残差连接和层归一化:

7. 总结

- 输入嵌入:将输入文本转化为嵌入向量,加上位置编码。

- 多头注意力机制:计算查询、键和值的注意力,捕捉输入的不同部分。

- 前馈神经网络:通过两个线性变换和ReLU激活处理注意力输出。

- 残差连接和层归一化:保持网络的稳定性和信息流动。

这种架构让Transformer模型在处理自然语言任务方面大放异彩,轻松应对长文本并生成高质量的输出。

完整案例

Transformer是一种基本的框架,它在自然语言处理领域中被广泛应用。下面是一些关键代码,可以帮助你开始构建和理解Transformer。

import numpy as np

import pandas as pd

import tensorflow as tf

from sklearn.model_selection import train_test_split

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

df = pd.read_csv('IMDB Dataset.csv')

# 数据预处理

df['text'] = df['review'].str.lower() # 将文本转换为小写

df['text'] = df['text'].str.replace('<br />', ' ') # 清洗HTML标签

# 划分训练集和测试集

train_texts, val_texts, train_labels, val_labels = train_test_split(df['text'], df['sentiment'], test_size=0.2, random_state=42)

数据处理

在Transformer模型中,将文本转换为数字序列以便处理。Tokenizer在此过程中发挥关键作用,实现文本向量化。

# 设定参数

max_len = 200 # 句子的最大长度

vocab_size = 10000 # 词汇表的大小

embedding_dim = 128 # 词嵌入的维度

# 实例化和拟合Tokenizer

tokenizer = Tokenizer(num_words=vocab_size, oov_token='<OOV>')

tokenizer.fit_on_texts(train_texts)

# 序列化文本

train_sequences = tokenizer.texts_to_sequences(train_texts)

val_sequences = tokenizer.texts_to_sequences(val_texts)

# 填充序列

train_padded = pad_sequences(train_sequences, maxlen=max_len, padding='post', truncating='post')

val_padded = pad_sequences(val_sequences, maxlen=max_len, padding='post', truncating='post')

构建Transformer模型

这是一个精简的Transformer模型示例,包括自注意力层、前馈神经网络层和残差连接,以提高文本生成的效果。

from tensorflow.keras.layers import Input, Dense, Embedding, GlobalAveragePooling1D, Dropout

from tensorflow.keras.layers import LayerNormalization, MultiHeadAttention, Dense, GlobalAveragePooling1D

from tensorflow.keras.models import Model

class MultiHeadSelfAttention(tf.keras.layers.Layer):

def __init__(self, embed_dim, num_heads=8):

super(MultiHeadSelfAttention, self).__init__()

self.embed_dim = embed_dim

self.num_heads = num_heads

self.head_dim = embed_dim // num_heads

assert embed_dim % num_heads == 0

self.query_dense = Dense(embed_dim)

self.key_dense = Dense(embed_dim)

self.value_dense = Dense(embed_dim)

self.combine_heads = Dense(embed_dim)

def call(self, inputs):

query = self.query_dense(inputs)

key = self.key_dense(inputs)

value = self.value_dense(inputs)

query = self.split_heads(query)

key = self.split_heads(key)

value = self.split_heads(value)

scaled_attention = self.self_attention(query, key, value)

scaled_attention = tf.transpose(scaled_attention, perm=[0, 2, 1, 3])

original_shape = tf.shape(scaled_attention)

scaled_attention = tf.reshape(scaled_attention,

(original_shape[0], original_shape[1], self.embed_dim))

outputs = self.combine_heads(scaled_attention)

return outputs

def split_heads(self, x):

batch_size = tf.shape(x)[0]

x = tf.reshape(x, (batch_size, -1, self.num_heads, self.head_dim))

return tf.transpose(x, perm=[0, 2, 1, 3])

def self_attention(self, query, key, value):

matmul_qk = tf.matmul(query, key, transpose_b=True)

depth = tf.cast(tf.shape(key)[-1], tf.float32)

logits = matmul_qk / tf.math.sqrt(depth)

attention_weights = tf.nn.softmax(logits, axis=-1)

output = tf.matmul(attention_weights, value)

return output

class TransformerBlock(tf.keras.layers.Layer):

def __init__(self, embed_dim, num_heads, ff_dim, rate=0.1):

super(TransformerBlock, self).__init__()

self.att = MultiHeadSelfAttention(embed_dim, num_heads)

self.ffn = tf.keras.Sequential([

Dense(ff_dim, activation='relu'),

Dense(embed_dim)

])

self.layernorm1 = LayerNormalization(epsilon=1e-6)

self.layernorm2 = LayerNormalization(epsilon=1e-6)

self.dropout1 = Dropout(rate)

self.dropout2 = Dropout(rate)

def call(self, inputs, training=None):

attn_output = self.att(inputs)

attn_output = self.dropout1(attn_output, training=training)

out1 = self.layernorm1(inputs + attn_output)

ffn_output = self.ffn(out1)

ffn_output = self.dropout2(ffn_output, training=training)

return self.layernorm2(out1 + ffn_output)

# 构建Transformer模型

embed_dim = embedding_dim

num_heads = 8

ff_dim = 128

inputs = Input(shape=(max_len,))

embedding_layer = Embedding(vocab_size, embed_dim)(inputs)

transformer_block = TransformerBlock(embed_dim, num_heads, ff_dim)(embedding_layer)

pooling_layer = GlobalAveragePooling1D()(transformer_block)

outputs = Dense(1, activation='sigmoid')(pooling_layer)

model = Model(inputs=inputs, outputs=outputs)

训练和评估模型

import tensorflow as tf

from tensorflow.keras.callbacks import ModelCheckpoint

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 定义回调函数

callbacks = [

tf.keras.callbacks.EarlyStopping(patience=3, monitor='val_loss'),

ModelCheckpoint('./transformer_model.weights.h5', save_best_only=True, save_weights_only=True)

]

# 训练模型时使用这些回调函数

history = model.fit(train_padded, train_labels, epochs=20, batch_size=32,

validation_data=(val_padded, val_labels), callbacks=callbacks)

# 评估模型

model.evaluate(val_padded, val_labels)

可视化训练过程

import matplotlib.pyplot as plt

# 绘制训练 & 验证的准确率值

plt.plot(history.history['accuracy'])

plt.plot(history.history['val_accuracy'])

plt.title('Model accuracy')

plt.ylabel('Accuracy')

plt.xlabel('Epoch')

plt.legend(['Train', 'Val'], loc='upper left')

plt.show()

# 绘制训练 & 验证的损失值

plt.plot(history.history['loss'])

plt.plot(history.history['val_loss'])

plt.title('Model loss')

plt.ylabel('Loss')

plt.xlabel('Epoch')

plt.legend(['Train', 'Val'], loc='upper left')

plt.show()

在这段代码中,我们构建了一个简约的Transformer模型,并在IMDB数据集上进行了文本分类实践。

您可以根据实际需求进行深入优化,例如调整超参数、增加层数、探索更复杂的数据集等,以提升模型性能。

模型分析

在IMDb电影评论情感分析案例中,我们采用了Transformer模型。以下将总结Transformer的优点和缺点,并与其他相似算法进行对比,探讨何时选择Transformer以及何时考虑其他方案。

Transformer模型的优缺点

优点

- Transformer模型,凭借其不受序列长度限制的特点,能有效捕捉长距离依赖关系,为处理长文本提供优势。

- "Transformer模型的并行计算特性,摒弃了递归结构,让输入数据得以平行处理,从而大幅提升训练效率。"

- Transformer模型,适应性强:无论数据集大小或计算资源有限,通过堆叠层数和注意力头数,轻易提升效能。

- "微调预训练的Transformer模型(如BERT、GPT等),轻松应对各类任务,卓越表现令人叹为观止。"

缺点

- "Transformer模型的卓越性能依赖于海量训练数据,对于稀缺数据任务,可能无法发挥其最大潜力。"

与其他算法的对比

RNN(循环神经网络)

- 优点:

- 能够处理变长序列数据。

- 模型参数较少,适合小规模数据集和较短序列。

- 缺点:

- 难以捕捉长距离依赖关系。

- 训练时无法并行,速度较慢。

- 易于出现梯度消失和梯度爆炸问题。

LSTM(长短期记忆网络)和 GRU(门控循环单元)

- 优点:

- 能够捕捉较长的依赖关系,比RNN效果好。

- 在一定程度上缓解梯度消失问题。

- 缺点:

- 仍然无法与Transformer的并行计算相比,训练速度较慢。

- 模型复杂度较高,训练资源需求大。

CNN(卷积神经网络)

- 优点:

- 可以捕捉局部特征,适合图像和一些文本任务。

- 计算效率高,可以并行计算。

- 缺点:

- 难以捕捉长距离依赖关系。

- 通常需要固定大小的输入,对于变长序列不够灵活。

何时使用Transformer模型

- Transformer模型在追求高性能任务中表现卓越,特别是预训练模型(如BERT、GPT等),为准确率和性能带来最佳结果。

最后

Transformer模型在NLP任务中独领风骚,尤其适用于冗长文本、高精度需求和计算资源丰富场景。尽管训练过程漫长且消耗大量资源,但其卓越性能和并行计算优势使其成为NLP领域的翘楚。然而,对于资源有限、数据集规模较小或实时性要求高的任务,传统的RNN、LSTM及轻量级CNN可能更具优势。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-