亚马逊 Bedrock 平台推出 Llama 3.2 模型:多模态视觉和轻量级模型

概述

由 Meta 提供的最新 Llama 3.2 模型现已在 Amazon Bedrock 平台上推出。这一新模型系列标志着 Meta 在大型语言模型(LLM)领域的最新进展,它在多种应用场景中提供了更强大的功能和更广泛的适用性。这些新模型注重负责任的创新和系统级安全,展现出在多个行业标准测试中的领先性能,并引入了一系列新功能,以助力构建新一代人工智能体验。

Llama 3.2 模型系列

Llama 3.2 系列模型涵盖了不同规模,从 1B 和 3B 参数的轻量级纯文本模型,适合边缘设备使用,到 11B 和 90B 参数的中小型模型,能够执行包括高分辨率图像多模态处理在内的复杂推理任务。Llama 3.2 的 11B 和 90B 模型是首批支持视觉任务的版本,它们通过新模型架构将图像编码器的表示集成到语言模型之中。这些模型旨在更有效地处理人工智能工作负载,降低延迟,并增强性能,使其适用于各种应用程序。

主要特点

- 多模态视觉识别:新模型能够理解图像和文本,提供更丰富的交互体验。

- 轻量级模型:适合在资源受限的设备上运行,如移动设备和物联网设备。

- 强大的语言处理能力:支持长文本生成、多语言翻译、编程、数学问题解决以及高级推理任务。

- 支持多种语言:增强了对八种语言的支持,包括英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语。

使用 Llama 3.2 模型

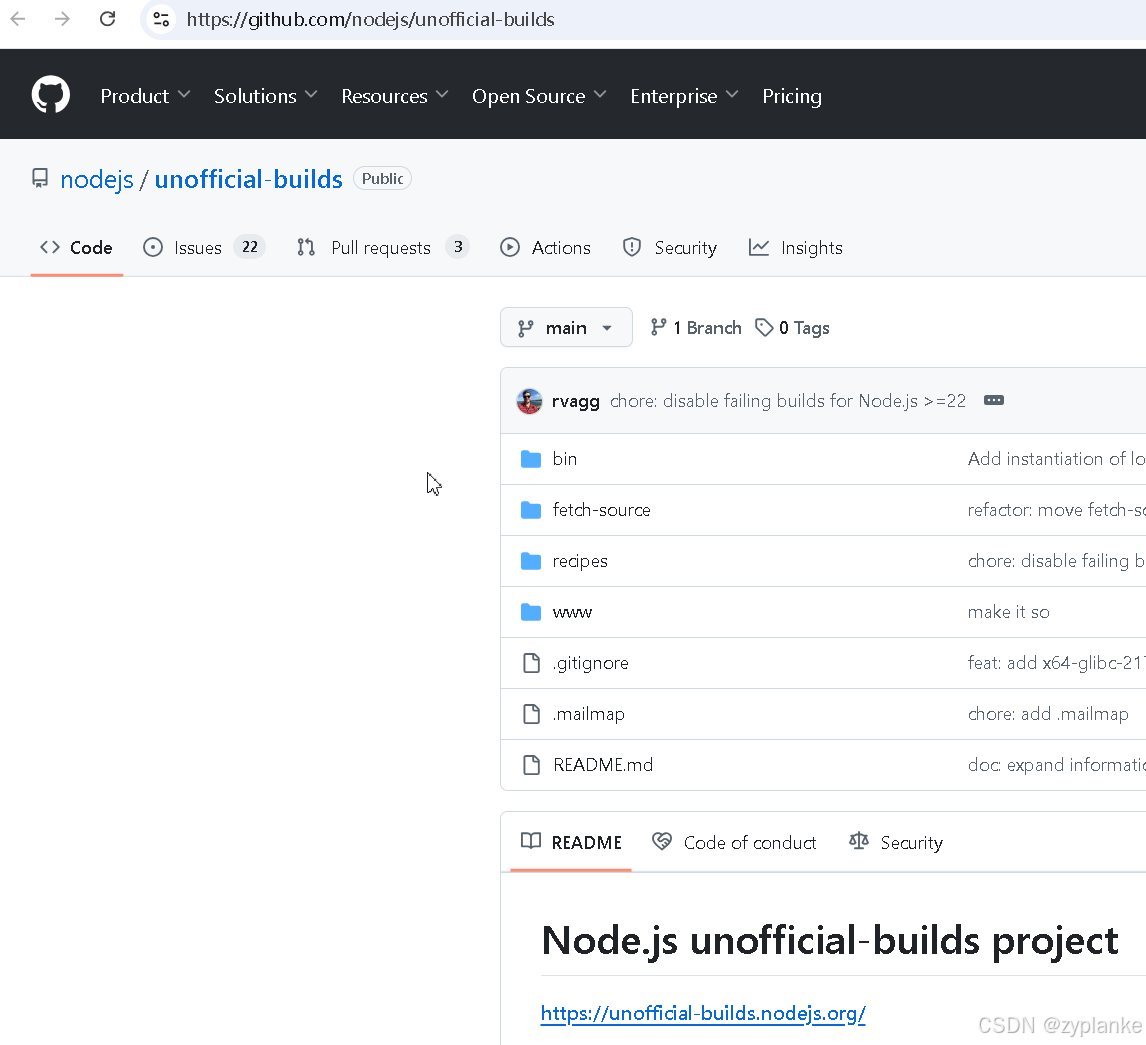

要开始使用 Llama 3.2 模型,您需要导航到 Amazon Bedrock 控制台,然后在导航窗格中选择“模型访问”。在那里,您可以请求访问新的 Llama 3.2 模型:Llama 3.2 1B、3B、11B Vision 和 90B Vision。

视觉功能测试

为了测试新的视觉功能,您可以从我们的示例网站下载一张 PNG 格式的图表,其内容涉及可再生能源发电份额。该图表的分辨率非常高,您可以将其大小调整为 1024 像素宽。

在 Amazon Bedrock 控制台中,选择“Playgrounds”下的“聊天”,选择“Meta”作为类别,然后选择“Llama 3.2 90B Vision”模型。

使用“选择文件”来选择已调整大小的图表图像,并使用此提示:

根据这张图表,欧洲哪些国家的份额最高?

选择“运行”,模型就会分析图像并返回结果。

编程方式访问模型

您还可以通过 AWS 命令行界面 (AWS CLI) 和 AWS SDK 以编程方式访问模型。与使用 Llama 3.1 模型相比,您只需要按照文档中的说明更新模型 ID。您还可以为美国和欧盟使用新的跨区域推理端点。

Llama 3.2 模型架构

Llama 3.2 在前辈产品成功的基础上,引入了先进的架构设计,致力于提供最优的性能和广泛的适用性:

- 自回归语言模型:Llama 3.2 的核心采用了优化的转换器架构,它能够基于之前的上下文预测接下来的内容,从而生成文本。

- 微调技术:Llama 3.2 的指令调整版本采用了两种关键技术:监督式微调 (SFT) 和基于人工反馈的强化学习 (RLHF)。

- 多模态功能:对于 11B 和 90B Vision 模型,Llama 3.2 引入了一种新的图像理解方法。

注意事项

Meta 的 Llama 3.2 模型现已在以下 AWS 区域的 Amazon Bedrock 中全面推出:

- Llama 3.2 1B 和 3B 模型可在美国西部(俄勒冈)和欧洲(法兰克福)使用,并通过跨区域推理在美国东部(俄亥俄州、弗吉尼亚北部)和欧洲(爱尔兰、巴黎)使用。

- Llama 3.2 11B Vision 和 90B Vision 模型可在美国西部(俄勒冈)使用,并通过跨区域推理在美国东部(俄亥俄州、弗吉尼亚北部)使用。

![【YOLOv10改进[SPPF]】使用 v9的SPPELAN替换SPPF模块 + 含全部代码和详细修改方式](https://i-blog.csdnimg.cn/direct/0fad740337c24406bab712d12da1210e.png)