来源:ICML-2024

题目:Token-Specific Watermarking with Enhanced Detectability and Semantic Coherence for Large Language Models

参考文献格式:Huo, M., Somayajula, S.A., Liang, Y., Zhang, R., Koushanfar, F. & Xie, P.. (2024). Token-Specific Watermarking with Enhanced Detectability and Semantic Coherence for Large Language Models. (ICML 2024

研究背景

2017年,Google提出一种基于自注意力机制的特征提取器Transformer模型,相比传统的RNN模型,具有更好的并行性能和更短的训练时间,突破了远距离文本依赖的学习限制

Large Language Models:得益于Transformer架构的出色可并行性和容量,使LLMs可以参数规模更为庞大,理解上下文和生成语言的能力不断增加,并得到广泛应用

模型在处理文本时,能够同时关注输入中的所有词汇,无论句子长短,都能精准捕捉到远距离的语义关联

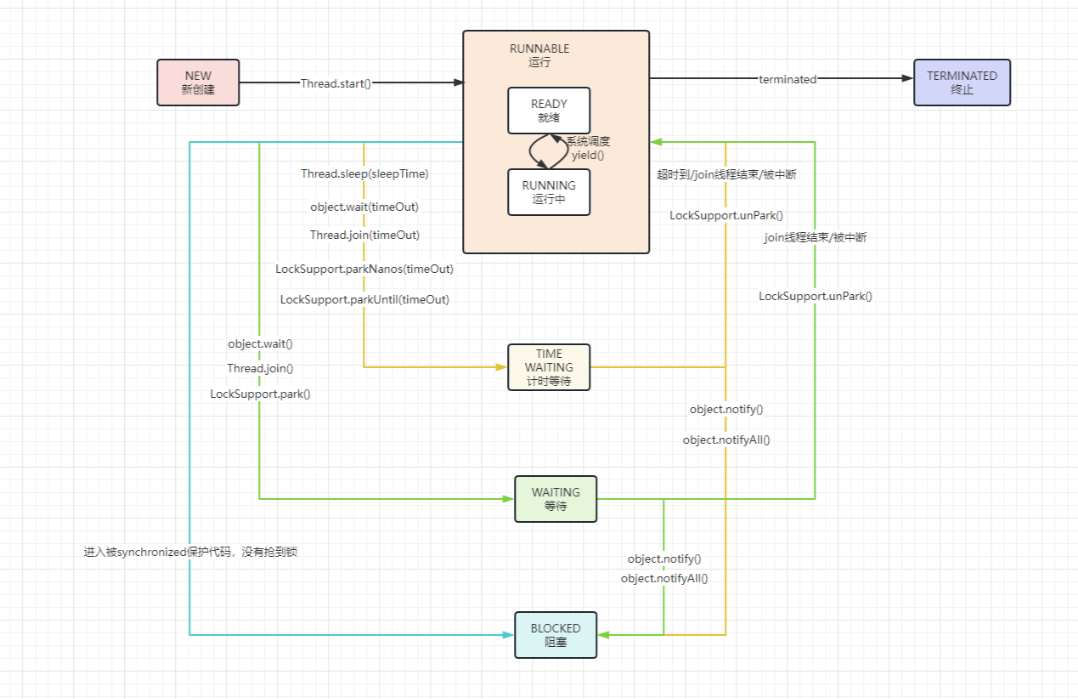

模型由编码器(Encoder)和 解码器(Decoder)两部分组成,相比于传统的RNN模型,具有更好的并行性能和更短的训练时间,能够更好地捕捉长距离依赖关系。Transformer架构的出色可并行性和容量,它已成为开发各种LLMs的事实标配,使得将语言模型扩展到数千亿或数万亿参数成为可能。CLS是个特殊标记,起始位置。在训练阶段,使用大量文本数据集对LLM进行训练,使其学习语言的模式和结构。

训练的目标通常是让模型能够预测下一个最可能的单词或令牌(token),这基于给定的前文序列。

训练过程中,模型会调整其内部参数,以最小化预测错误,这通常通过优化算法(如随机梯度下降)来实现。

一旦模型训练完成,它就能够接收输入(如一段文本或提示)并生成输出。 对于给定的输入序列,模型会计算每个可能的输出令牌的概率分布,这些概率分布通常表示为“逻辑”(logits)

令牌采样(Token Sampling):

从逻辑值中采样以生成最终的文本输出。这个过程可以采用不同的采样技术,如贪婪采样、束搜索(beam search)或核采样(nucleus sampling)。

贪婪采样会选取概率最高的令牌作为输出,而束搜索会考虑概率最高的几个令牌组合,核采样则在考虑概率的同时保持输出的多样性。

而水印技术在这一背景下至关重要,它涉及在 LLM 推理阶段将隐藏标记嵌入文本中,这些标记对人类不可察觉。水印分类如下:

区分AI生成文本和人类编写文本,可用于监管检测LLM生成的文本成为一项关键任务,支撑着AI伦理和安全的更广泛目标。

租用OpenAI的接口,利用聊天的结果来优化自家的大模型

前述方法在文本水印方面取得了显著进展。然而,它们通常依赖于可能导致不自然修改的特定规则,可能会降低文本质量。如果这些线索被人类攻击者检测到,他们可能会设计水印移除攻击或尝试伪造水印

模型水印分类

基于规则的水印:通过文本转换嵌入水印,同时确保整体语义连贯性不受影响。这些转换涉及改变词汇属性、操纵语言特征或替换同义词。

基于规则方法的一个显著限制是它们容易受到攻击(例如,用同义词替换单词)

神经水印:利用神经网络将水印嵌入文本并进行解码,然后使用一个消息解码器从这个水印文本中提取LLM签名,由于通常涉及复杂的神经网络以插入水印,在文本生成和水印检测期间产生高计算成本;

推理时水印:在推理期间将统计信号插入模型logits中以提高可检测性,但会降低语义连贯性,因此提出了一系列工作来解决这个问题。

大语言模型水印框架结构

不区分绿色列表

水印效果的丧失:水印的目的是在一个可控和可检测的方式中,对文本进行微小的修改。如果你让所有单词都成为绿色列表的一部分,那么在生成文本时,模型实际上不会受到任何限制,水印的效果就会丧失。

检测困难:水印检测算法依赖于绿色列表和红色列表之间的平衡来检测文本。如果所有单词都是绿色列表的一部分,那么检测算法将无法通过统计方法(如计算绿色列表单词的比例)来识别文本是否包含水印。

文本质量不变:从积极的方面来看,如果所有单词都是绿色列表的一部分,那么理论上水印算法对文本质量的影响将降至最低。然而,这也意味着水印失去了其应有的功能。

z-score(z 分数)是用来检测文本中水印存在与否的一个统计量。它基于统计假设测试,特别是一个比例的 z-检验。z 分数计算的目的是确定文本中绿色列表(Green List)词汇的出现频率是否超出了随机选择时的预期范围,从而判断文本是否被嵌入了水印。

z-score,𝑧=𝑠𝐺−𝛾𝑇/𝑇𝛾1−𝛾z=(|s|_G-γT)/√(Tγ(1-γ) )

KGW水印举例:

KGW水印技术是一个两阶段过程:

1、在文本生成期间嵌入水印,在生成令牌 s(t) 时,前一个令牌 s(t−1) 的哈希值作为随机种子,

将词汇表 V 分割成一个包含总词汇表比例γ的绿色列表 和包含剩余的 (1−γ)比例的词汇表,称为红色列表。

参数 𝛾γ,称为分割比例( splitting ratio ),例参数 γ =0.20,则绿色列表为总词汇表大小的20%,

而一个常数水印logits,记为 𝛿δ,会被加到绿色列表令牌的逻辑值上。

2、基于这些调整后的逻辑值采样下一个令牌,软提示使用绿色列表令牌。

𝑠𝐺−𝛾𝑇|s|_G-γT,其中 𝑠𝐺|s|_G表示水印文本中绿色列表令牌的计数,𝑇T表示文本的长度。

计算出的z-score超过预定阈值时,认为成功检测到水印

提出的算法

引入了一种新的多目标优化(MOO)水印方法

利用轻量级网络生成特定于token的两个超参数:分割比例(𝛾γ)和水印logits(δ)

通过动态调整分割比例( γ )和水印logits(δ),

利用 MOO 优化检测和语义目标函数,优化可检测性和语义连贯性。

测量有水印文本和无水印文本之间的可检测性通过基于文本中绿色令牌计数的单侧z检验来评估

Token嵌入:

可检测性通过修改版 z-score来评估

语义连贯性通过 余弦相似度 来评估

使用多目标优化 MOO来优化分割比例 𝛾 、附加Logits 𝛿的δ的选择

余弦相似度用于评估水印文本和未水印文本之间的语义相似性。通过计算文本的嵌入向量(通常是通过神经网络模型如SimCSE得到的)之间的余弦相似度,可以量化文本在语义上保持一致的程度。这对于确保水印过程不会对文本的语义质量产生负面影响是很重要。

优化变量是γ和δ生成器网络的权重参数,因为sw的水印由这些网络控制。由于生成sw的RoBERTa-base模型 fθfθ 和生成sw的LLM共享相同的分词器,我们直接使用LLM生成的嵌入作为 fθfθ 的输入,使得操作关于γ和δ生成器网络的参数是可微的。

实验效果

多目标优化效果:

检查了为不同令牌学习到的水印logits(δ)和分割比例(γ)。对于每个词性(part-of-speech, POS)类别计算了基于带有此类别标签的前一个令牌生成的γ和δ值的平均值和标准差。

在十个文本上进行,每个文本包含200个有水印的token。

当前一个token是形容词(ADJ)或限定词(DET)时,倾向于分配较低的γ和δ值,而ADJ和DET通常在名词之前。降低γ会导致选择较少的绿色令牌,同时降低δ会导致对这些选定令牌应用较小的水印logits值,可以减弱这些词带有水印的可能性。

在ADJ和DET之后的令牌应用较弱的水印,促进了下一个具有最高模型逻辑值的令牌的选择,这最有可能是名词,因此增强了语义连贯性和句法一致性。

标点符号(PUNCT)代表句子或短语的结束,通过为标点之后的token分配更多的γ和δ值,就有更多单词放入绿色列表,提高选词的自由度,嵌入水印的同时不会对语义连贯性产生太多影响。

对两种常见水印攻击

1)改写攻击(Paraphrase Attack)

2)复制粘贴攻击(Copy-Paste Attack)

目的都是为了覆盖、隐藏水印

下图是使用Dipper改写LLM来执行改写攻击。基于T5-XXL模型微调,攻击更有效

改写强度设置为推荐水平,lex=40(词汇相似度) div=100(多样性)

总结:

1、介绍了一种新颖的多目标优化框架,用于在推理时对大型语言模型(LLMs)进行水印处理

2、旨在同时优化两个轻量级网络,负责生成特定于标记的分割比率和水印logits

3、核心目标是最小化检测损失和语义损失, 寻找Pareto最优解

4、结果表明在提高Pareto前沿方面优于现有技术,在抵抗改写攻击、复制粘贴攻击方面有更好的鲁棒性