引言

在深度学习领域,卷积神经网络(CNN)的发展一直推动着图像识别、目标检测等任务的进步。然而,随着网络层数的增加,传统的CNN面临着梯度消失和梯度爆炸等难题,限制了深层网络的训练效果。为了克服这些挑战,微软亚洲研究院的何恺明等人于2015年提出了残差网络(ResNet),这一创新不仅解决了深层网络的训练问题,还极大地推动了深度学习的发展。本文将详细介绍ResNet残差网络的基本原理、优势、应用以及面临的挑战。

梯度消失和梯度爆炸

梯度消失和梯度爆炸是深度神经网络训练过程中可能遇到的两个重要问题。梯度消失指的是在反向传播过程中,由于网络层数过多或激活函数的性质,导致梯度在逐层传递时逐渐减小到接近于零,从而使得靠近输入层的网络权重更新缓慢或几乎不更新,影响模型的训练效果和性能。相反,梯度爆炸则是指在某些情况下,梯度在反向传播过程中会逐渐增大,甚至变得非常大,导致模型权重更新时出现不稳定的情况,进而影响模型的收敛性和稳定性。

ResNet的基本原理

残差学习

ResNet的核心思想在于残差学习。在传统的CNN中,每一层的输入都是上一层的输出,即学习的是H(x) = F(x),其中H(x)表示网络的期望映射,F(x)表示网络的实际映射。而在ResNet中,每一层的输入不再是上一层的输出,而是上一层输出与输入的残差,即学习的是F(x) = H(x) - x。这种残差学习的方式使得网络可以更加轻松地学习恒等映射,从而解决了深层网络训练中的梯度问题。

残差结构

残差块

ResNet由多个残差块(Residual Block)组成,每个残差块包含两个主要部分:恒等映射和残差映射。恒等映射即将输入直接传递到输出,而残差映射则对输入进行非线性变换,并与恒等映射相加,形成残差块的输出。这种设计使得模型可以学习到残差,即剩余的映射,而不仅仅是对输入的变换。

跨层连接

在ResNet中,每个残差块都通过跨层连接(Shortcut Connection)实现了恒等映射。这种跨层连接使得梯度可以直接从输出层反向传播到输入层,有效地缓解了深层网络中常见的梯度消失问题。同时,跨层连接也保留了原始特征,使得网络的学习更加顺畅和稳定。

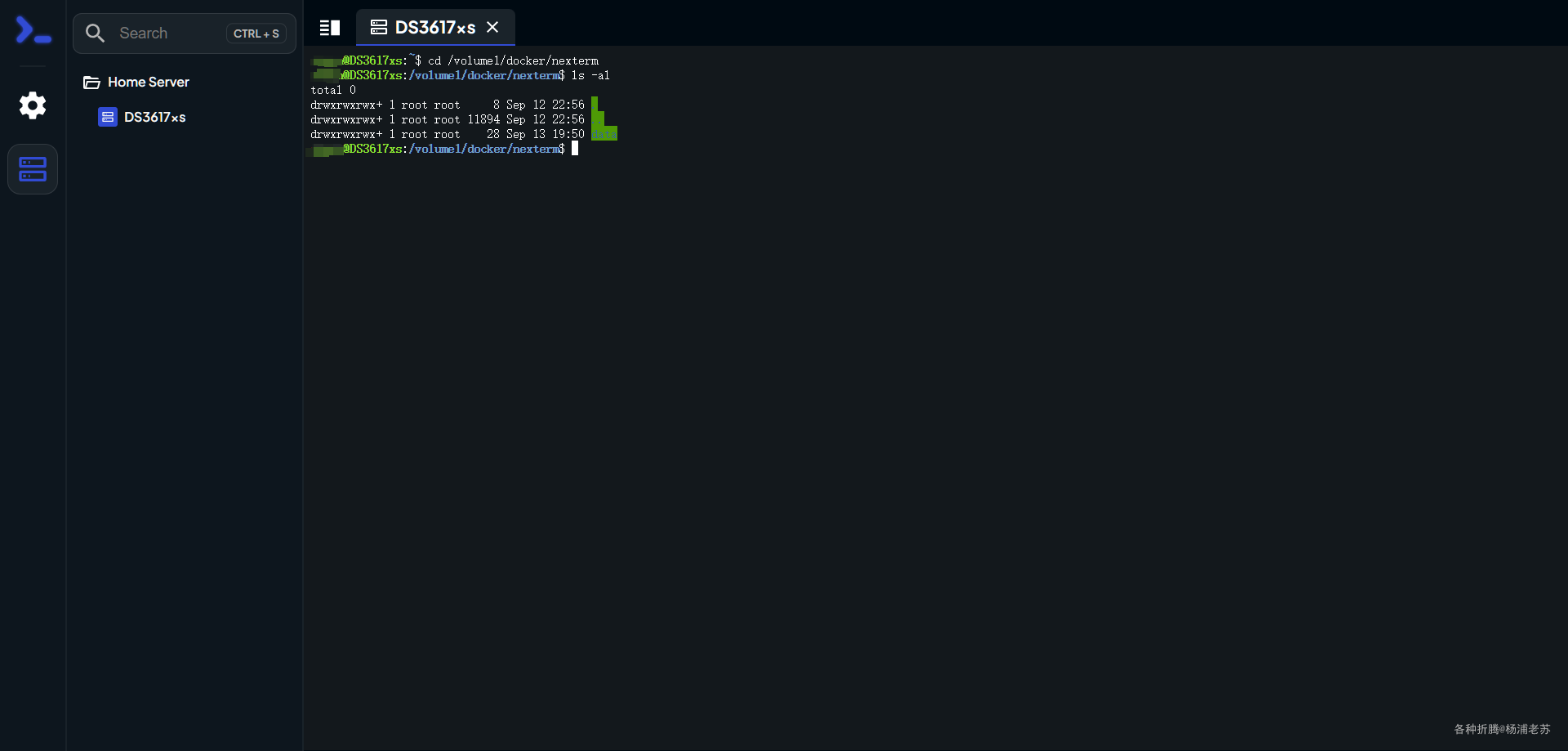

示例:

我们有一个18层的深度网络,用于处理输入图片。该图片初始维度为3244244(分别对应颜色通道数、高度和宽度)。处理流程大致如下:

首先,图片数据通过第一层卷积层,该层使用了64个77大小的卷积核,步长为2,并进行了3层的零填充(padding),以保持输出特征图的大小为112112。这样,第一层输出便是64张112*112的特征图。

随后,这些特征图通过了一个最大池化层,池化窗口大小为33,步长为2,且进行了1层的零填充,从而进一步减少了特征图的尺寸到5656,但特征图的数量(通道数)保持不变,仍为64。

接下来的网络结构采用了残差连接(Residual Connections)的概念。即,在连续几层卷积操作后,不是直接输出最终的特征图,而是将原始输入的特征图(或经过少量处理以匹配维度)与经过多层卷积处理后的特征图相加。在这个特定的例子中,64张56*56的特征图在送入后续两层卷积层之前,会先被复制一份并绕过这两层,随后与这两层卷积处理后的同尺寸特征图在对应像素点上相加,形成新的特征图。这样的设计有助于缓解深层网络训练中的梯度消失问题,提升网络的训练效率和性能。

此过程在网络中重复多次,直到达到预定的深度(虽未具体说明所有层的细节,但总体上遵循了上述的残差连接模式)。

最终,经过多层卷积和残差连接处理后,得到的特征图会被送入一个全局平均池化层,该层将每张特征图的所有像素值平均为一个单一的值,从而进一步减少了数据的维度。随后,这些平均值被作为特征向量输入到一个全连接层中,该全连接层包含1000个神经元,对应于1000个类别的预测输出。这样,网络就完成了从输入图片到1000个预测结果的转换过程

ResNet的优势

加深网络层数

ResNet通过引入残差学习,使得深层网络更容易训练,从而可以构建更深的网络结构。在ImageNet图像分类竞赛中,ResNet-50首次实现了错误率低于人类的表现,证明了深层网络对于图像分类等任务的重要性。

解决梯度消失和梯度爆炸问题:

通过跳跃连接,残差学习使得梯度能够直接传播到较浅的层,从而缓解了梯度在深层网络中的消失或爆炸问题

提升模型精度

更深的网络结构意味着更强的特征提取能力,从而提高了模型的精度。ResNet在多个领域的任务中都取得了优异的表现,如图像分类、目标检测、语义分割等。

提高训练速度和泛化能力

ResNet通过使用批归一化(Batch Normalization)等技术来加速训练过程和提高模型性能。同时,残差连接也提高了模型的泛化能力,使其在不同数据集上都能表现出色。

ResNet的应用

ResNet被广泛应用于计算机视觉和自然语言处理等领域。在计算机视觉领域,ResNet被用于图像分类、目标检测、人脸识别等任务,并取得了显著的效果。例如,在ImageNet图像分类竞赛中,ResNet-50和ResNet-152等模型都取得了优异的成绩。在自然语言处理领域,ResNet也被用于文本分类、机器翻译等任务,展现了其强大的泛化能力。

ResNet面临的挑战

尽管ResNet具有许多优点,但也存在一些挑战:

- 计算资源需求高:特别是在网络较深时,训练和推理过程需要较高的计算资源。

- 过拟合风险:在某些情况下,ResNet可能会过拟合,需要通过正则化等方法进行处理。

- 冗余问题:有研究表明,在深度残差网络中存在大量的冗余,这可能导致模型参数过多,计算效率低下。

为了应对这些挑战,研究者们提出了许多解决方案,如模型压缩、模型加速以及与其他模型的结合等。这些努力不仅提高了ResNet的性能和效率,也推动了深度学习技术的不断发展。

结论

ResNet残差网络作为深度学习的里程碑之一,通过引入残差学习和残差块的设计,解决了深层网络训练中的梯度问题,并显著提高了模型的精度和训练速度。ResNet的成功不仅推动了深度学习领域的发展,也为后续的研究提供了宝贵的经验和启示。在未来的研究中,我们期待看到更多基于ResNet的创新和突破,为人工智能领域的发展做出更大的贡献。