文章目录

- 概览

- 论文开篇

- Introduction

- General Overview

- Pre-Training

- Pre-Training Data

- Model Architecture

- Infrastructure, Scaling, and Efficiency

- Training Recipe

- Post-Training

- Results

- Vision Experiments

- Speech Experiments⭐

- Related Work

- Conclusion

- Llama 3 模型中的数学原理

- 1. 模型结构与基础数学操作

- 2. 自注意力机制的数学基础

- 3. 分组查询注意力(GQA)的数学分析

- 4. 缩放定律与预训练计算复杂性

- 5. 优化算法与梯度下降

- 6. 大规模并行计算中的数学问题

- 7. 数学任务中的表现

- 8. 矩阵分解与稀疏性优化

- 9. 随机性与采样策略

- 10. 基于对抗的训练方法

- 11. 长上下文序列中的记忆机制

- 12. 多任务学习中的数学原理

- 13. 模型校准与安全性

- 总结补充

🍃作者介绍:双非本科大四网络工程专业在读,阿里云专家博主,专注于Java领域学习,擅长web应用开发,目前开始人工智能领域相关知识的学习

🦅个人主页:@逐梦苍穹

📕所属专栏:🌩专栏①:人工智能; 🌩专栏②:速通人工智能相关论文

🌻gitee地址:xzl的人工智能代码仓库

✈ 您的一键三连,是我创作的最大动力🌹

LLaMA、LLaMA2和LLaMA3三篇论文都有速通系列,这是第三篇;

关于另外两篇,请看我的这些文章👇:

LLaMA1:https://xzl-tech.blog.csdn.net/article/details/142282868

LLaMA2:https://xzl-tech.blog.csdn.net/article/details/142315279

概览

这篇论文的标题是《Llama 3 模型群》。它介绍了 Meta 公司最新开发的一组基础模型,被称为 Llama 3。

这些模型代表了新一代的大规模语言模型,能够处理多领域任务,包括多语言文本处理、推理和代码生成。

以下是论文的主要内容概述:

概览:

- Llama 3 是一组基础模型,参数规模高达 4050 亿。这些模型设计用于处理多语言任务、编程、推理和工具使用。

- 模型架构:Llama 3 基于稠密 Transformer 架构,优化了规模、数据质量和计算效率。最大的模型支持 128K token 的上下文窗口。

- 性能:在多个基准测试中,Llama 3 的表现与领先的 GPT-4 等模型相当,覆盖语言理解、代码生成和推理任务。

关键特性:

- 多语言能力:模型使用了规模高达 15 万亿 token 的数据集进行训练,使其能够有效处理多语言任务。

- 可扩展性:Llama 3 的旗舰模型(4050 亿参数)使用了比前代 Llama 2 多 50 倍的计算量(FLOPs),在训练规模和效率上都有显著提升。

- 工具使用与安全性:论文提到了一种优化安全性的模型版本 Llama Guard 3,用于在输入和输出中提高安全性,同时致力于减少偏见,确保人工智能的负责任使用。

- 多模态集成:初步实验将图像、视频和语音识别功能集成到 Llama 3 中,未来可能支持更多多模态任务,目前这些功能尚在开发中。

训练与评估:

- 训练数据:论文详细描述了一个广泛的数据处理管道,重点在于通过去重、启发式过滤和模型质量分类器来提高数据质量。

- 实验结果:模型在多个基准数据集上进行了测试,包括 MMLU、IFEval、GSM8K 等,表现优于较小的模型,并且在与最先进的模型相比时表现出色。

发布与应用:

- 开放发布:Meta 公开发布了多个版本的 Llama 3 模型,并采用更新的 Llama 社区许可证,旨在促进研究界的创新和负责任的 AI 发展。

- 应用场景:Llama 3 具有广泛的应用能力,涵盖语言理解、编程、推理和工具使用等领域,是未来 AI 系统的灵活且强大的基础模型。

该论文还详细讨论了架构、训练基础设施、扩展策略以及未来的发展计划,包括处理长上下文任务和增强多模态功能。Llama 3 模型在多语言和多模态研究领域具有重要的潜力。

论文开篇

这张图片展示了 Meta 公司关于 Llama 3 模型的论文或公告的开头部分,主要介绍了 Llama 3 系列模型的特点和目标。

以下是这段内容的详细解释:

- Llama 3 系列模型的概述

Llama 3 是 Meta 推出的最新基础模型系列,被称为 “herd of language models”(一群语言模型)。这个系列模型旨在原生支持多语言处理、编程、推理和工具使用等任务。

这些模型的设计是为了支持当代人工智能(AI)系统中所需的各种功能。 - 模型的规模和技术细节

最大模型:Llama 3 中最大的模型是一个庞大的 Transformer 模型,拥有 4050 亿(405B) 个参数,并且拥有 128K 个 token 的上下文窗口。这意味着它可以处理大规模的输入文本,能够理解和生成更长、更复杂的文本。

对比:该模型被用来与其他领先的语言模型(例如 GPT-4)进行比较,显示 Llama 3 在许多任务上都具有可比的质量。 - 发布计划

公开发布:Meta 计划公开发布 Llama 3,包括预训练和经过后训练(post-trained)的版本。这个计划还包括了一个名为 Llama Guard 3 的模型,用于输入和输出安全性。这可能是为了防止模型生成不安全或不适当的内容。 - 研究成果

多模态实验:论文还提到了将图像、视频和语音等功能集成到 Llama 3 中的实验,这种方式被称为组合方法(compositional approach)。这意味着 Llama 3 不仅可以处理文本,还可以跨越多种模态进行理解和生成。

性能:研究发现,这种组合方法在图像、视频和语音识别任务上与当前最先进的技术水平(state-of-the-art)具有竞争力。 - 发展状态

当前状态:尽管 Llama 3 已经展示出了强大的能力,但它仍在开发中,尚未广泛发布。 - 总结

Llama 3 是 Meta 最新推出的基础模型系列,旨在与当前最先进的语言模型(如 GPT-4)竞争。它拥有庞大的参数规模和超长的上下文窗口,支持多语言、多模态(图像、视频、语音)等任务。Meta 计划发布该系列模型的不同版本,包括一个用于输入和输出安全性的版本,表明他们重视模型的实际应用和安全性。

Introduction

概述:

"Introduction"部分首先解释了 基础模型(Foundation Models) 的重要性,并指出这些模型是当今许多现代AI系统的基础。

基础模型主要涵盖了语言、视觉、语音等多种模态,支持广泛的AI任务。

作者进一步介绍了Llama 3,这是一组最新的基础模型,涵盖多语言、编程、推理和工具使用等能力。Llama 3系列的最大模型包含 4050亿参数,并且支持最大 128K个Token的上下文窗口,展示了其强大的计算能力。

本部分还介绍了两个主要训练阶段:

- 预训练(Pre-Training):模型在大规模数据上进行训练,任务如下一个词预测或描述生成。

- 后训练(Post-Training):模型进一步微调,以适应人类指令和优化特定能力(如编程、推理等)。

作者指出,Llama 3的设计优化了三个关键因素:数据、规模、复杂性管理,通过对这些方面的调整,显著提高了模型的性能。

论文的观点:

- 基础模型的核心作用:

- 原文:“Foundation models are general models of language, vision, speech, and/or other modalities that are designed to support a large variety of AI tasks. They form the basis of many modern AI systems.”

- 解释: 基础模型是支持语言、视觉、语音等多模态任务的核心,现代许多AI系统都基于这些模型构建。

- Llama 3模型的特点:

- 原文:“The Llama 3 Herd of models natively supports multilinguality, coding, reasoning, and tool usage. Our largest model is dense Transformer with 405B parameters, processing information in a context window of up to 128K tokens.”

- 解释: Llama 3支持多语言、编程、推理和工具使用,其最大版本拥有4050亿参数,能够处理128K的上下文信息。

- 数据和规模的提升:

- 原文:“We pre-train Llama 3 on a corpus of about 15T multilingual tokens, compared to 1.8T tokens for Llama 2.”

- 解释: 与Llama 2相比,Llama 3的预训练数据量从1.8万亿增加到15万亿,大幅提升了模型训练数据的规模。

- 模型的复杂性管理:

- 原文:“We believe there are three key levers in the development of high-quality foundation models: data, scale, and managing complexity.”

- 解释: 作者认为,数据、规模和复杂性管理是发展高质量基础模型的三大关键因素。

通过以上分析,Introduction部分主要介绍了Llama 3模型的总体框架和重要创新点。

General Overview

概述:

"General Overview"部分主要介绍了Llama 3模型的 整体架构及其开发过程。

Llama 3模型的 开发包括两个主要阶段:语言模型预训练和语言模型后训练。

模型架构的主要设计基于Transformer结构,Llama 3使用了海量的多语言文本语料库进行训练,模型的任务是预测下一个Token。

这个训练过程包括从标准预训练到进一步的预训练,以扩展模型的上下文窗口。

除了预训练,后训练阶段对模型进行了指令调整和优化,使其更加符合人类反馈并具备特定的功能,如工具使用和推理能力。

此外,Llama 3在后训练阶段还加入了安全机制,确保模型的输出符合安全要求。

论文的观点:

- 模型的预训练任务:

- 原文:“We start by converting a large, multilingual text corpus to discrete tokens and pre-training a large language model (LLM) on the resulting data to perform next-token prediction.”

- 解释: Llama 3的预训练使用了大量的多语言文本语料,模型的任务是预测下一个Token。

- 上下文窗口的扩展:

- 原文:“We pre-train a model with 405B parameters on 15.6T tokens using a context window of 8K tokens. This standard pre-training stage is followed by a continued pre-training stage that increases the supported context window to 128K tokens.”

- 解释: Llama 3最初的上下文窗口为8000个Token,随后通过进一步的预训练,将支持的上下文窗口扩展到128K个Token,极大地提高了模型处理长文本的能力。

- 后训练任务及能力集成:

- 原文:“We align the model with human feedback in several rounds, each of which involves supervised finetuning (SFT) on instruction tuning data and Direct Preference Optimization (DPO; Rafailov et al., 2024).”

- 解释: 模型的后训练通过多轮监督微调和直接偏好优化(DPO)来对齐人类反馈,使模型能够更好地理解和执行指令。

- 工具使用和多模态能力:

- 原文:“We also perform experiments in which we add image, video, and speech capabilities to Llama 3 using a compositional approach.”

- 解释: Llama 3通过多模态方法集成了图像、视频和语音能力,使其在这些领域的表现与当前的最先进模型相当。

通过这部分分析可以看出,Llama 3不仅通过大规模的预训练掌握了丰富的语言知识,还通过后期的优化提升了其指令跟随和工具使用的能力,并具备了图像、视频和语音等多模态能力。

Pre-Training

1. 概括:

在 “Pre-Training”(预训练) 部分,作者详细介绍了 Llama 3 模型的预训练过程,这包括:

- 训练数据的来源和清理方式。

- 模型的架构和扩展性法则。

- 预训练阶段使用的技巧和方法,如自适应调整数据混合比例、学习率调整等。

- 训练方案(Training Recipe),描述了具体的预训练过程如何执行,包括初始预训练、长上下文预训练和退火(Annealing)。

总体来说,这一部分介绍了 Llama 3 模型如何通过大规模数据预训练以学习语言结构和世界知识,讨论了多种策略来优化预训练性能。

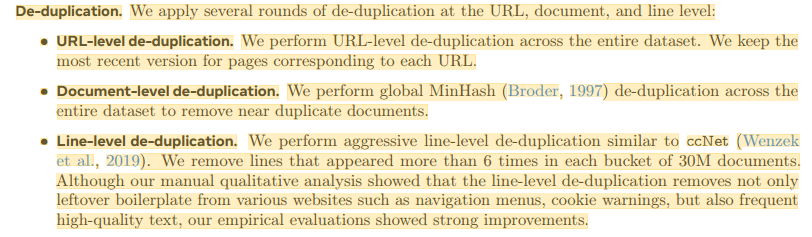

Pre-Training Data

(a) 预训练数据:

作者详细描述了数据的构建和清理过程,以确保高质量的训练数据。

这部分内容讲述了如何过滤掉低质量和不安全的数据,确保数据集的完整性和准确性。

论文原文:

“We create our dataset for language model pre-training from a variety of data sources containing knowledge until the end of 2023. We apply several de-duplication methods and data cleaning mechanisms on each data source to obtain high-quality tokens. We remove domains that contain large amounts of personally identifiable information (PII), and domains with known adult content.” 我们从包含截至2023年底知识的各种数据源中创建了用于语言模型预训练的数据集。我们对每个数据源应用了多种重复数据删除方法和数据清理机制,以获得高质量的标记。我们删除了包含大量个人身份信息(PII)的域名,以及已知包含成人内容的域名。

这一段明确指出了模型预训练数据的来源是来自2023年之前的各种知识来源,数据经过去重和清理,以确保训练数据的高质量。

(b) Web数据清理:

模型的主要数据来源之一是网络数据。为了确保数据的准确性和安全性,使用了专门的过滤器来去除包含敏感信息的内容。

论文原文:

“We implement filters designed to remove data from websites are likely to contain unsafe content or high volumes of PII, domains that have been ranked as harmful according to a variety of Meta safety standards, and domains that are known to contain adult content.” 我们实施了过滤器,旨在删除来自可能包含不安全内容或大量个人身份信息(PII)的网站的数据,这些域名根据Meta的多项安全标准被评为有害,或已知包含成人内容的域名。

这里提到了一些重要的过滤标准,包括删除包含大量PII(个人身份信息)和成人内容的域名。

© 数据去重:

数据去重是为了防止重复内容浪费计算资源,确保训练过程中的每个数据点都能提供新的信息。

论文原文:

作者讨论了在URL、文档和行级别进行的多轮去重操作,确保每条数据都是唯一且有价值的。

(d) 数据混合比例的确定:

为了达到最优的训练效果,作者提出了通过知识分类和扩展性法则来调整数据的混合比例。

这个过程确保不同类别的数据在模型的训练中得到了平衡的考虑。

论文原文:

“To obtain a high-quality language model, it is essential to carefully determine the proportion of different data sources in the pre-training data mix. Our main tools in determining this data mix are knowledge classification and scaling law experiments.” 为了获得高质量的语言模型,必须仔细确定预训练数据集中不同数据源的比例。我们确定这一数据组合的主要工具是知识分类和扩展定律实验。

这个观点强调了在训练过程中数据混合比例的重要性,通过实验和知识分类来优化模型的性能。

(e) 退火(Annealing):

在最后的训练阶段,退火方法被用于对数据混合进行进一步的调整,旨在提升模型在特定领域的表现,尤其是数学和编程推理任务。

论文原文:

“Empirically, we find that annealing (see Section 3.4.3) on small amounts of high-quality code and mathematical data can boost the performance of pre-trained models on key benchmarks.” 根据实证结果,我们发现对少量高质量的代码和数学数据进行退火(见第3.4.3节)可以提升预训练模型在关键基准测试中的表现。

退火技术提升了模型在关键基准上的表现,尤其是在数学和编程领域的推理能力。

Model Architecture

这里作者介绍了Llama 3模型的架构设计及其背后的理论依据。

1. 概括:

在"Model Architecture"部分,作者讨论了Llama 3使用的模型架构。

该架构基于标准的Transformer架构,并结合了一些优化来提高推理速度和效率。模型的架构优化主要集中在查询注意力机制(Grouped Query Attention, GQA)和上下文窗口的处理能力,允许模型支持更长的上下文输入。此外,Llama 3保留了之前版本(Llama 2)的密集Transformer架构,在模型性能和训练规模之间做出平衡。

2. 详细讲解与观点:

(a) 标准的Transformer架构:

Llama 3延续了之前版本使用的标准Transformer架构,其性能的提升主要依赖于更大规模的训练和更高质量的数据,而不是重大架构上的改动。

论文原文:

“Llama 3 uses a standard, dense Transformer architecture (Vaswani et al., 2017). It does not deviate significantly from Llama and Llama 2 (Touvron et al., 2023a,b) in terms of model architecture; our performance gains are primarily driven by improvements in data quality and diversity as well as by increased training scale.” Llama 3使用了标准的密集Transformer架构(Vaswani等人,2017)。在模型架构方面,它与Llama和Llama 2(Touvron等人,2023a,b)没有显著差异;我们的性能提升主要得益于数据质量和多样性的改进以及训练规模的增加。

这段内容表明,Llama 3模型主要在数据质量和训练规模上取得了显著进展,而模型架构本身变化不大。

(b) Grouped Query Attention (GQA):

为了提高推理效率,Llama 3采用了Grouped Query Attention(分组查询注意力机制)。这一技术优化了自注意力机制中的键值头(key-value heads)的处理,减少了推理时所需的计算资源。

论文原文:

“We use grouped query attention (GQA; Ainslie et al. (2023)) with 8 key-value heads to improve inference speed and to reduce the size of key-value caches during decoding.” 我们使用了分组查询注意力(GQA;Ainslie等人,2023),其中包含8个键值头,以提高推理速度并减少解码过程中键值缓存的大小。

通过GQA技术,模型的推理速度得到了提升,并且在解码过程中减少了缓存的使用,提高了效率。

© 注意力掩码的优化:

Llama 3在长文本的处理上也做了一些改进,采用了新的注意力掩码机制来避免同一序列内不同文档之间的自注意力。

论文原文:

"We use an attention mask that prevents self-attention between different documents within the same sequence. We find that this change had limited impact during in standard pre-training, but find it to be important in continued pre-training on very long sequences."我们使用了一种注意力掩码,防止同一序列内不同文档之间的自注意力机制。我们发现这种改变在标准预训练过程中影响有限,但在对非常长的序列进行持续预训练时,这一改变显得至关重要。

这一优化提高了模型在处理长序列文本时的稳定性,特别是在处理超长上下文时的表现。

(d) 词汇表扩展:

为了更好地支持多语言处理,Llama 3的词汇表容量增加到128K个token,其中包含了100K个来自TikToken词汇表的token,以及28K个额外的token,用于更好地处理非英语语言。

论文原文:

"We use a vocabulary with 128K tokens. Our token vocabulary combines 100K tokens from the tiktoken3 tokenizer with 28K additional tokens to better support non-English languages. " 我们使用了包含128K标记的词汇表。我们的词汇表结合了来自tiktoken3分词器的100K标记,并添加了28K个额外标记,以更好地支持非英语语言。

这个扩展使得Llama 3能够在多语言任务中表现得更好,同时也提高了英语文本的压缩率。

(e) RoPE位置编码的调整:

Llama 3还调整了RoPE(旋转位置编码)的基频参数,允许模型支持更长的上下文长度。这一改进使得Llama 3能够处理长达32,768个token的上下文。

论文原文:

“We increase the RoPE base frequency hyperparameter to 500,000. This enables us to better support longer contexts; Xiong et al. (2023) showed this value to be effective for context lengths up to 32,768.” 我们将RoPE(旋转位置编码)的基频超参数增加到500,000。这使我们能够更好地支持更长的上下文长度;Xiong等人(2023)表明该值在支持长度达32,768的上下文时非常有效。

调整RoPE参数使得模型在处理长上下文时表现更加高效,并且能够处理更长的序列。

Infrastructure, Scaling, and Efficiency

1. 概括:

在"Infrastructure, Scaling, and Efficiency"部分,作者重点讲述了Llama 3模型在训练过程中使用的基础设施、扩展方法和效率优化。

这部分内容深入探讨了如何在大规模计算资源上高效训练模型,以及在GPU集群上实现并行计算的策略。

2. 详细讲解与观点:

(a) 基础设施配置:

Llama 3的训练使用了 大规模的GPU集群 进行加速,特别是Meta的生产集群和GPU资源。

这些集群能够为训练提供强大的计算能力,确保Llama 3在训练规模和计算需求上的支持。

论文观点:

"Llama 3 405B is trained on up to 16K H100 GPUs, each running at 700W TDP with 80GB HBM3, using Meta’s Grand Teton AI server platform (Matt Bowman, 2022). "

这说明Llama 3使用了高达16,000块H100 GPU,集成在Meta的服务器平台上进行训练。每块GPU都配置有80GB的高带宽内存(HBM3),为大规模模型提供了充足的存储和计算资源。

(b) 存储解决方案:

在大规模训练过程中,存储吞吐量是一个关键问题,Llama 3使用了Meta的Tectonic分布式文件系统来提供数据存储和高吞吐量支持。

论文观点:

“Tectonic (Pan et al., 2021), Meta’s general-purpose distributed file system, is used to build a storage fabric (Battey and Gupta, 2024) for Llama 3 pre-training. It offers 240 PB of storage out of 7,500 servers equipped with SSDs, and supports a sustainable throughput of 2 TB/s and a peak throughput of 7 TB/s.” Tectonic(Pan等人,2021),Meta的通用分布式文件系统,被用于构建Llama 3预训练的存储结构(Battey和Gupta,2024)。它提供了240 PB的存储容量,由7500台配备SSD的服务器组成,支持每秒2 TB的持续吞吐量和每秒7 TB的峰值吞吐量。

存储系统提供了240 PB的存储容量,并支持2 TB/s的持续吞吐量和7 TB/s的峰值吞吐量。这些高效的存储设施确保了在训练过程中能够处理大量的数据读写需求。

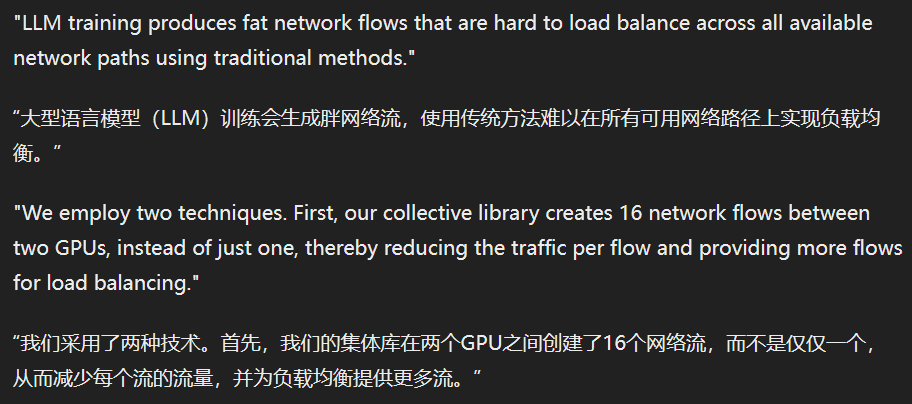

© 网络架构:

Llama 3的训练集群使用了RoCE(基于以太网的远程直接内存访问)和InfiniBand网络,提供了高达400 Gbps的互联带宽来支持GPU之间的通信。

论文观点:

“Llama 3 405B used RDMA over Converged Ethernet (RoCE) fabric based on the Arista 7800 and Minipack2 Open Compute Project4 OCP rack switches. Smaller models in the Llama 3 family were trained using Nvidia Quantum2 Infiniband fabric.” Llama 3 405B模型使用了基于Arista 7800和Minipack2开放计算项目(OCP)机架交换机的收敛以太网远程直接内存访问(RDMA over Converged Ethernet, RoCE)网络结构。Llama 3家族中的较小模型则使用了Nvidia Quantum2 InfiniBand网络结构进行训练。

网络架构的选择使得模型可以高效地在多个GPU之间进行通信,大幅降低了计算延迟,提升了整体训练速度。

(d) 负载均衡与流量优化:

在大规模集群中,负载均衡是一个重要挑战。

Llama 3采用了一些特定的优化技术来解决集群中的通信负载均衡问题。

论文观点:

“LLM training produces fat network flows that are hard to load balance across all available network paths using traditional methods”

“we employ two techniques. First, our collective library creates 16 network flows between two GPUs, instead of just one, thereby reducing the traffic per flow and providing more flows for load balancing.”

通过这种网络流的优化,Llama 3训练能够在多个网络路径上平衡通信流量,避免某些路径出现通信瓶颈,从而提升通信效率。

(e) 模型并行化与扩展:

Llama 3使用了4D并行策略,这包括 张量并行、管道并行、上下文并行和数据并行 四种并行化技术的组合。

这种复杂的并行方式确保了模型能够 高效地分布到多个GPU上进行训练。

论文观点:

“We use 4D parallelism—a combination of four different types of parallelism methods—to shard the model. This approach efficiently distributes computation across many GPUs and ensures each GPU’s model parameters, optimizer states, gradients, and activations fit in its HBM.” 我们使用了4D并行,这是一种结合了四种不同类型的并行方法来分片模型的技术。这种方法能够高效地将计算分布到多个GPU上,并确保每个GPU的模型参数、优化器状态、梯度和激活值都能适应其高带宽内存(HBM)。

4D并行策略通过在不同的并行维度上分割模型,确保每个GPU都能够高效利用其资源,并减少计算瓶颈。

(f) 训练效率的提升:

通过调整并行调度、改进通信协议等方式,Llama 3在训练过程中达到了38-43%的BF16模型FLOPs使用率,这是一种衡量GPU计算效率的重要指标。

论文观点:

“Through careful tuning of the parallelism configuration, hardware, and software, we achieve an overall BF16 Model FLOPs Utilization (MFU; Chowdhery et al. (2023)) of 38-43% for the configurations shown in Table 4.” 通过对并行配置、硬件和软件的精心调优,我们在表4所示的配置中实现了整体BF16模型浮点运算(Model FLOPs Utilization,MFU;Chowdhery等人,2023)38-43%的利用率。

通过这些调优,Llama 3在大规模集群上能够更高效地进行计算,从而节省了训练时间和资源。

Training Recipe

Training Recipe"(训练食谱)部分,作者介绍了Llama 3模型的预训练过程,具体描述了训练的各个阶段,包括初始预训练、长上下文预训练和退火阶段。

每个阶段都有详细的训练步骤和技术方法,以确保模型在不同任务中的高效表现。

1. 概括:

这一部分分为三个主要阶段:

- 初始预训练:使用较短序列长度和较小的批次来提高训练稳定性,随后逐渐增加序列长度和批次以提高效率。

- 长上下文预训练:模型的上下文窗口逐步扩展至128K个token,以提高其处理超长文本的能力。

- 退火阶段:在最后的训练阶段,通过逐步降低学习率并调整数据混合比例,模型的性能在特定领域得到了进一步优化。

2. 详细讲解与观点:

(a) 初始预训练:

Llama 3模型的初始预训练使用了AdamW优化器,并采取了逐步增大的序列长度和批次来稳定训练过程。

模型最初使用4,096个token的序列长度和4M个token的批次,随着训练的进行,批次和序列长度逐渐增加。

论文观点:

“We pre-train Llama 3 405B using AdamW with a peak learning rate of 8 × 10−5 ; a linear warm up of 8,000 steps, and a cosine learning rate schedule decaying to 8 × 10−7 over 1,200,000 steps.” 我们使用AdamW优化器对Llama 3 405B进行预训练,峰值学习率为8 × 10⁻⁵;线性预热8000步,余弦学习率调度在1,200,000步内衰减至8 × 10⁻⁷。

这段描述了初始预训练阶段的优化器、学习率调度等详细信息,强调了预训练过程中的稳定性和高效性。

(b) 长上下文预训练:

在初始预训练之后,Llama 3逐步扩展其上下文窗口至128K个token。这一过程分为六个阶段,模型通过自适应训练来适应更长的上下文输入。

论文观点:

“In the final stages of pre-training, we train on long sequences to support context windows of up to 128K tokens.” 在预训练的最后阶段,我们使用长序列进行训练,以支持最多128K标记的上下文窗口。

“we increased context length gradually in six stages, starting from the original 8K context window and ending in the final 128K context window.” 我们将上下文长度分为六个阶段逐步增加,从最初的8K上下文窗口开始,最终达到128K上下文窗口。

通过逐步扩展上下文窗口,Llama 3能够更好地处理长文本,并且在每个阶段都确保了短上下文任务的性能没有退化。

© 退火阶段:

在预训练的最后阶段,Llama 3通过退火技术逐渐降低学习率,以确保模型在关键任务上的表现进一步提升。

与此同时,数据混合比例也进行了调整,优先使用高质量的数据来优化模型。

论文观点:

“During pre-training on the final 40M tokens, we linearly annealed the learning rate to 0”

“Finally, we compute the average of model checkpoints (Polyak (1991) averaging) during annealing to produce the final pre-trained model.”

退火技术通过平均模型的检查点,确保了模型的最终表现,并且在最后阶段重点使用高质量数据进一步提升性能。

Post-Training

作者介绍了Llama 3模型如何在预训练之后通过一系列后训练步骤进行 微调和优化。

这些后训练阶段主要通过与人类反馈对齐,进一步提升模型在对话、代码生成、推理和其他复杂任务中的表现。

1. 概括:

后训练的目标是通过人类反馈数据进行微调,使得模型能够更好地理解指令并执行任务。

主要方法包括监督微调(SFT)、直接偏好优化(DPO)以及对模型生成数据的采样优化。

这些步骤确保了Llama 3不仅能够处理基本的语言任务,还能够在更复杂的推理、工具使用和安全性方面有所提升。

2. 详细讲解与观点:

(a) 奖励模型与语言模型的结合:

在后训练阶段,首先训练了一个奖励模型(Reward Model, RM),该模型通过人类注释的偏好数据来评分,然后通过这些评分对预训练的语言模型进行优化。

论文观点:

“We first train a reward model on top of the pre-trained checkpoint using human-annotated preference data (see Section 4.1.2). We then finetune pre-trained checkpoints with supervised finetuning (SFT; see Section 4.1.3), and further align the checkpoints with Direct Preference Optimization (DPO; see Section 4.1.4).” 我们首先使用人工标注的偏好数据(见第4.1.2节)在预训练检查点的基础上训练奖励模型。随后,我们通过监督微调(SFT,见第4.1.3节)对预训练检查点进行精调,并进一步使用直接偏好优化(DPO,见第4.1.4节)对检查点进行对齐。

这里作者介绍了如何使用人类反馈对语言模型进行微调和优化,确保模型能够在各种任务中理解并执行更准确的指令。

(b) 监督微调(SFT):

SFT是后训练的关键部分,使用采样到的高质量数据集对模型进行微调。通过人类注释和模型生成的数据,模型在多个迭代中不断优化其输出质量。

论文观点:

“Together with this rejection-sampled data and other data sources (including synthetic data), we finetune the pre-trained language model using a standard cross entropy loss on the target tokens (while masking loss on prompt tokens).” 结合这些通过拒绝采样获得的数据以及其他数据源(包括合成数据),我们使用目标标记上的标准交叉熵损失来对预训练语言模型进行微调(同时对提示标记进行损失掩码处理)。

监督微调通过 标准的交叉熵损失函数,对模型输出的目标token进行训练。

通过对不同的数据集进行多轮迭代优化,模型能够更好地理解指令并执行复杂任务。

© 直接偏好优化(DPO):

DPO是Llama 3后训练的重要组成部分,目的是通过 人类偏好数据 进行对齐,从而使模型输出符合人类期望。

相比其他优化算法,DPO在大规模模型上表现更好,并且计算效率更高。

论文观点:

“We further train our SFT models with Direct Preference Optimization (DPO; Rafailov et al., 2024) for human preference alignment.” 我们进一步使用直接偏好优化(DPO;Rafailov等人,2024)对我们的SFT模型进行训练,以实现与人类偏好的对齐。

相比PPO等算法,DPO在大规模模型上的表现更加出色,特别是在指令遵循任务中的表现尤为显著。

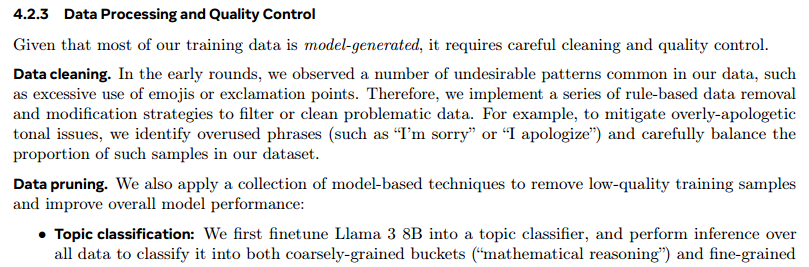

(d) 数据采样与质量控制:

在后训练中,数据的质量至关重要。

Llama 3通过 拒绝采样(Rejection Sampling)策略 从大量模型生成的数据中选取最优输出,并且通过PagedAttention提高了采样效率。

论文观点:

“During rejection sampling (RS), for each prompt collected during human annotation (Section 4.2.1) we sample K (typically between 10 and 30) outputs from the latest chat model policy”

“use our reward model to select the best candidate” 在拒绝采样(RS)过程中,对于每个在人工标注期间收集的提示(见第4.2.1节),我们从最新的聊天模型策略中采样K个输出(通常在10到30个之间)。

通过这种拒绝采样策略,模型在每次提示下生成多个输出,然后通过奖励模型选取最佳输出,确保后训练数据的高质量。

还有一部分不详细展开了,总结:大量的人工——纯牛马:

Results

1. 概述:

在Llama 3论文的"Results"部分,作者主要评估了Llama 3模型在多个基准任务中的表现。

这些任务涵盖了语言理解、代码生成、多语言处理、数学推理等不同领域。

作者针对Llama 3的不同模型版本(8B、70B和405B参数)进行了详细的比较分析,并将其表现与其他主流模型(如GPT-4和Claude 3.5 Sonnet)进行了对比。

评估结果表明,Llama 3在许多领域的表现非常出色。

2. 观点与分析:

预训练语言模型评估 (Pre-trained Language Model Evaluation):

Llama 3被评估的基准任务包括常识推理、知识理解、阅读理解、数学推理、代码生成、对抗性测试等。特别是在数学推理和阅读理解方面,Llama 3的表现超出了其他大多数同类模型。例如,405B模型在数学推理任务GSM8K和ARC-C上获得了最优的结果,展示了Llama 3模型强大的推理和问题解决能力。

论文原文:

“we evaluate Llama 3 on a large number of standard benchmark evaluations shown in Table 8. These evaluations cover eight top-level categories: (1) commonsense reasoning; (2) knowledge; (3) reading comprehension; (4) math, reasoning, and problem solving; (5) long context; (6) code; (7) adversarial evaluations; and (8) aggregate evaluations.” 我们在表8中展示了对Llama 3的大量标准基准测试评估。这些评估涵盖了八个顶级类别:(1)常识推理;(2)知识;(3)阅读理解;(4)数学、推理和问题解决;(5)长上下文;(6)代码;(7)对抗性评估;(8)综合评估。

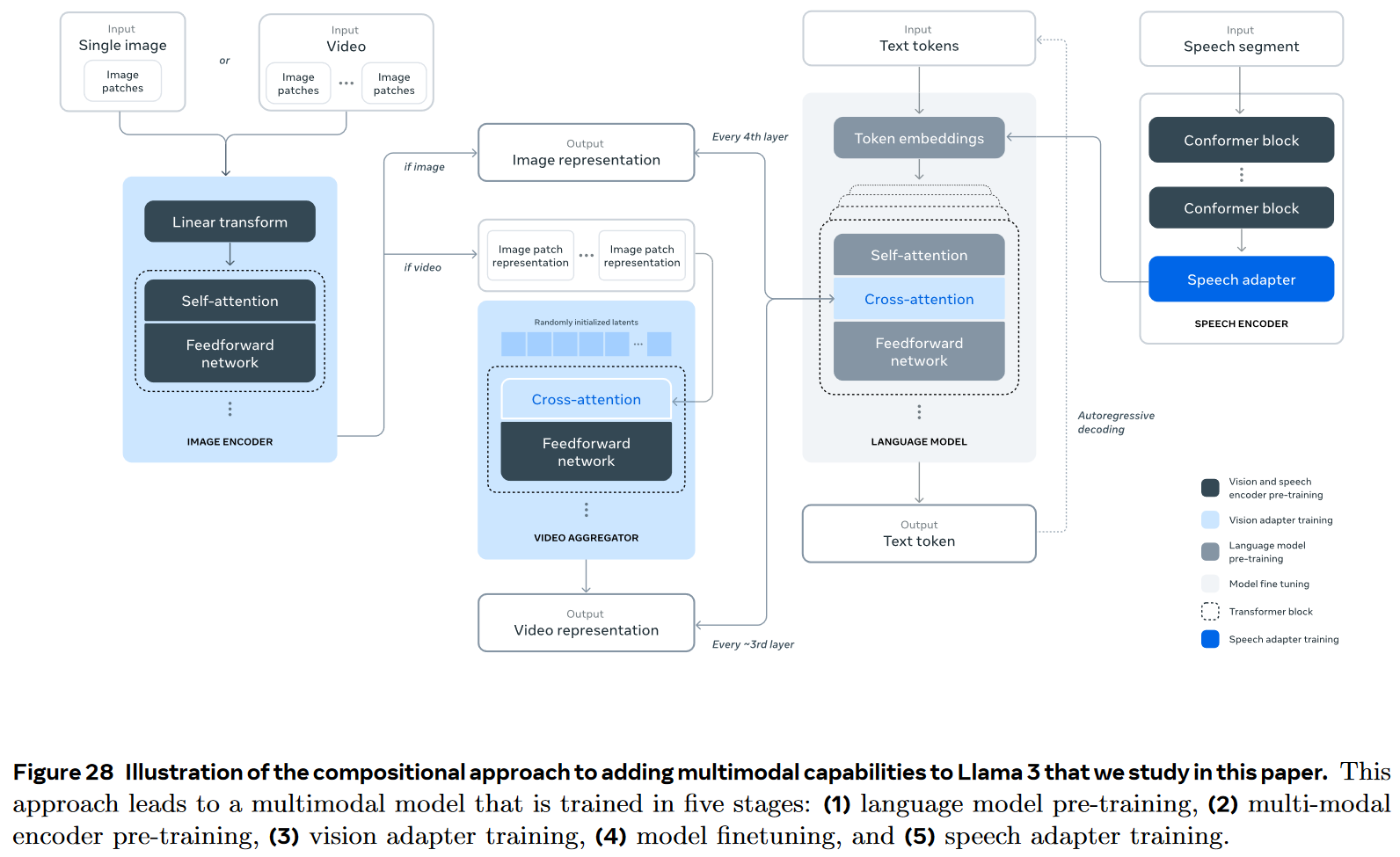

Vision Experiments

1. 概述:

在这部分论文探讨了将视觉识别能力集成到Llama 3模型中的实验。

主要采用了组合的训练方法,这些实验被设计成 跨越图像和视频的多模态任务。

通过使用图像编码器和跨注意力层(cross-attention layers),Llama 3 被扩展为能够处理图像和视频数据的多模态模型。

这些实验分为两个阶段:

- 图像处理阶段:通过将预训练的图像编码器与语言模型结合,训练了一系列跨注意力层以处理图像-文本对。

- 视频处理阶段:进一步增加了处理时间序列信息的聚合层和视频跨注意力层,训练模型识别和处理视频中的时间信息。

通过这些实验,Llama 3 模型展示了如何在语言处理之外,扩展到视觉任务中,如图片和视频理解。

2. 观点与分析:

- 图像实验(Image Experiments):

- Llama 3 的视觉模块通过处理 6B 的图像-文本对数据进行训练。图像的大小被调整到336x336像素,每批次的大小为16,384。

- 质量过滤机制和去重处理使得模型的输入图像数据具备更高的质量和多样性,从而提高模型的图像理解能力。

论文原文:

“we train the model using 6B image-text pairs where each image is resized to fit within four tiles of 336 × 336 pixels. We use a global batch size of 16,384 and a cosine learning rate schedule with initial learning rate 10 × 10−4 and a weight decay of 0:01.” 我们使用了60亿对图像-文本数据对进行模型训练,其中每张图像都被调整大小以适应四块336 × 336像素的网格。我们采用全局批量大小为16,384,使用余弦学习率调度,初始学习率为10 × 10⁻⁴,并设置权重衰减为0.01。

- 视频实验(Video Experiments):

- 视频处理部分通过在预训练的图像权重基础上,增加视频特定的聚合器和跨注意力层进行训练。视频数据的训练使用16帧的采样方法,每帧被处理为四块448x448像素的图像块。

- Llama 3 通过视频适配器在多个长时视频理解任务上展示了出色的表现,尤其是在处理复杂的时间序列任务时具有优势。

论文原文:

“For video pre-training, we start from the image pre-trained and annealed weights as described above. We add the video aggregator and cross-attention layers as described in the architecture, initialized randomly.”

“We uniformly sample 16 frames from the full video, and represent each frame using four chunks, each of size of 448 × 448 pixels.”

- 组合训练的优势(Advantages of Compositional Approach):

- 这种组合方法带来了多个好处:它允许视觉和语言模块并行开发,避免了共同训练视觉和语言数据的复杂性,并确保引入视觉能力不会影响模型在纯文本任务上的表现。

- 这种架构使模型在推理阶段更加高效,因为无需将全分辨率图像通过语言模型的全连接层。

论文原文:

"A compositional approach to foundation model development has several advantages: (1) it enables us to parallelize the development of the vision and language modeling capabilities; (2) it circumvents complexities of joint pre-training on visual and language data that stem from tokenization of visual data, differences in background perplexities of tokens originating from different modalities, and contention between modalities; (3) it guarantees that model performance on text-only tasks is not affected by the introduction of visual-recognition capabilities, and (4) the cross-attention architecture ensures that we do not have to expend compute passing full-resolution images through the increasingly LLM backbones (specifically, the feed-forward networks in each transformer layer), making it more efficient during inference. "

一种基础模型开发的组合方法具有以下几个优势:(1) 它使我们能够并行开发视觉和语言建模能力;(2) 它避免了视觉和语言数据联合预训练的复杂性,这些复杂性源于视觉数据的标记化、不同模态标记的背景复杂度差异以及模态之间的争用;(3) 它保证了在引入视觉识别能力后,模型在仅文本任务上的性能不受影响;(4) 交叉注意力架构确保我们不需要通过日益扩大的大型语言模型(特别是每个Transformer层中的前馈网络)传递全分辨率图像,从而提高推理过程中的效率。

- 数据处理与质量控制(Data Processing and Quality Control):

- 数据集构建过程中使用了复杂的数据处理管道,包括质量过滤、去重、重采样以及OCR(光学字符识别),从而确保用于训练的图像-文本对具有高质量且多样性高。

- 重采样步骤使用了n-gram技术,以提升低频类别和细粒度识别任务的表现。

论文原文:

“We construct this dataset via a complex data processing pipeline that consists of four main stages: (1) quality filtering, (2) perceptual de-duplication, (3) resampling, and (4) optical character recognition.”

我们通过一个复杂的数据处理管道构建了该数据集,该管道由四个主要阶段组成:(1) 质量过滤,(2) 感知去重,(3) 重采样,(4) 光学字符识别(OCR)。

3. 图表说明:

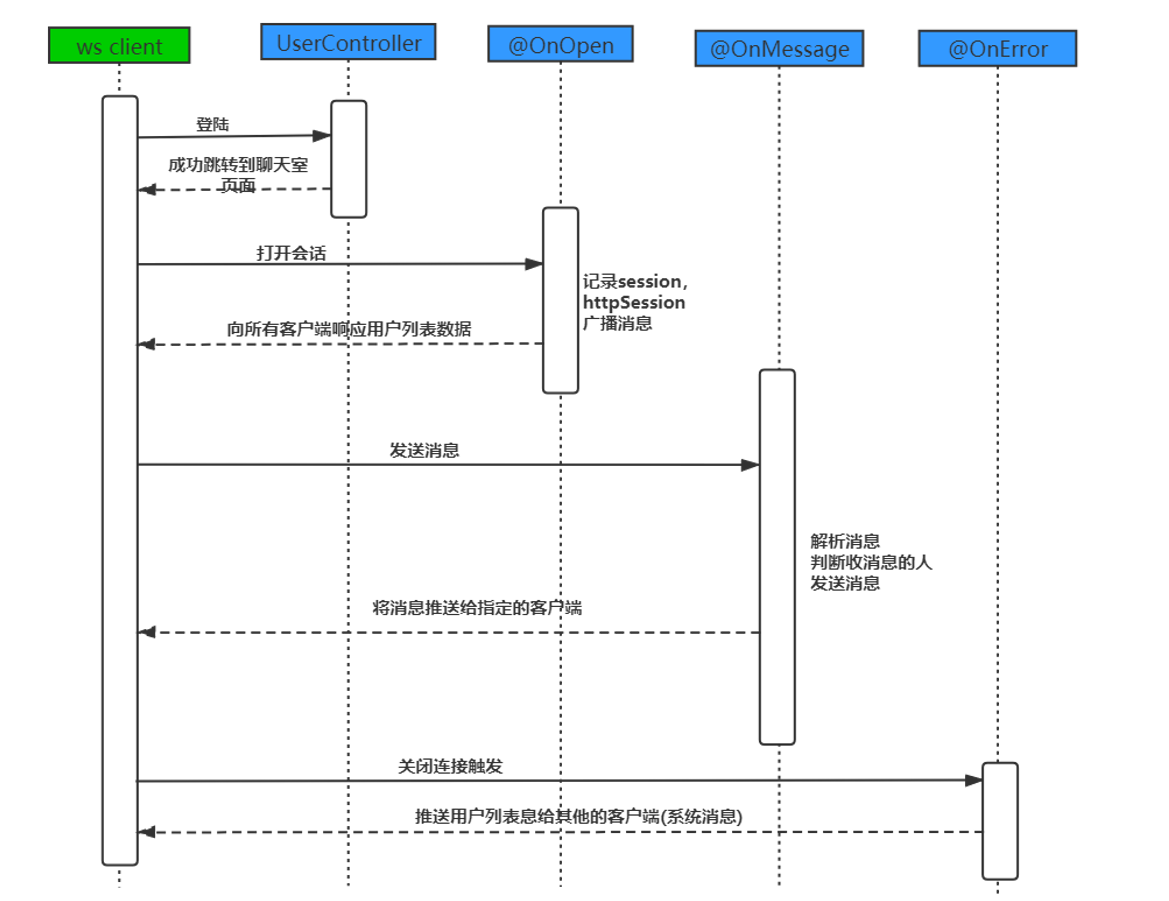

- 图28:多模态架构图(Compositional Approach Illustration)

- 图28展示了Llama 3多模态模型的架构,包括语言模型预训练、多模态编码器的预训练、视觉适配器训练、模型微调、以及语音适配器训练五个阶段。该架构通过组合预训练的图像编码器和语言模型,使得Llama 3可以处理图片和视频任务。

下面对这幅图详细说明一下。

这张图展示了将多模态能力添加到 Llama 3 模型的分阶段训练流程。根据图例和说明,整个训练过程分为五个主要阶段:

- 语言模型预训练(Language model pre-training):

- 首先对语言模型进行单独预训练。输入是文本 token,经过 token embedding 处理后进入 Transformer 的自注意力和前馈网络层进行语言建模。

- 多模态编码器预训练(Multi-modal encoder pre-training):

- 对图像和视频的处理:图像通过编码器,首先通过线性变换和自注意力层生成图像表示。视频输入则是由图像补丁表示汇总后,经过视频聚合器生成视频表示。编码器可以适应图像或视频输入,从而生成对应的图像或视频特征。

- 视觉适配器训练(Vision adapter training):

- 视觉适配器训练是在已经训练好的图像或视频编码器的基础上,增加额外的适配模块(如交叉注意力层),使得图像和视频表示可以与文本表示进行更好地融合。每4层 Transformer 层中增加交叉注意力模块,将视觉表示融入语言模型中。

- 模型微调(Model finetuning):

- 微调过程在特定任务上进行,比如文本生成、图像到文本生成等。此阶段的目的是让多模态模型在特定任务上达到更好的性能。

- 语音适配器训练(Speech adapter training):

- 最后阶段是对语音进行处理。语音片段首先经过语音编码器(由多个 Conformer 块组成),然后通过语音适配器与语言模型进行整合。此阶段可以使模型具备处理语音输入的能力。

总结:

Llama 3 的多模态扩展是通过模块化设计逐步完成的。模型首先进行语言预训练,然后通过适配不同模态的输入(如图像、视频、语音),借助适配器和交叉注意力层,将多模态信息融入语言模型,实现跨模态的推理和生成能力。这种方法为模型添加了视觉、语音处理的能力,能够处理更广泛的任务场景。

Speech Experiments⭐

1. 概述:

“Speech Experiments”部分介绍了Llama 3模型在语音识别、语音生成等方面的实验成果。Llama 3的语音模块通过集成语音编码器与适配器,支持多种语音处理任务,包括自动语音识别(ASR)、语音翻译(AST)、以及生成语音的任务(如文本转语音,TTS)。

Llama 3模型的语音接口还支持34种语言处理。

这些实验展示了Llama 3在跨语言、多模态处理方面的能力,尤其在语音理解和生成方面具有很高的表现。

2. 观点与分析:

- Speech Understanding (语音理解)

- Llama 3在语音理解任务中,使用了由未标注数据进行预训练的语音编码器,并进一步通过带监督的微调,整合语音适配器与预训练的语言模型。这一模块的设计允许Llama 3可以处理语音输入,并进行ASR、AST等任务的推理。

- Llama 3语音接口能够高效处理多语言任务,尤其在零样本推理任务上展现了较强的能力。其模型支持多轮对话以及自动语音问答,且表现出色。

论文原文: “On the input side, the speech module consists of two successive modules: a speech encoder and an adapter. The output of the speech module is directly fed into the language model as token representation, enabling direct interaction between speech and text tokens.” 在输入端,语音模块由两个连续的模块组成:语音编码器和适配器。语音模块的输出被直接作为标记表示输入到语言模型中,从而实现语音和文本标记之间的直接交互。

- Speech Generation (语音生成)

- Llama 3在语音生成上整合了文本归一化(Text Normalization, TN)与韵律建模(Prosody Modeling, PM)两个关键模块。TN模块确保生成语音在语义上的准确性,而PM模块则通过预测韵律特征,提高生成语音的自然度和表现力。

- 在实际推理中,Llama 3的韵律模型能够通过流式的逐个音素处理方式,维持低延迟的同时生成高质量的语音输出。这种设计大大降低了模型的前瞻需求,保证了流式语音生成的实时性。

论文原文: “To enhance the naturalness and expressiveness of synthesized speech, we integrate a decoder-only Transformer-based Prosody model (PM) (Radford et al., 2021) that takes the Llama 3 embeddings as an additional input. This integration leverages the linguistic capabilities of Llama 3” 为了增强合成语音的自然性和表现力,我们集成了一个仅解码器的基于Transformer的韵律模型(Prosody Model, PM)(Radford等人,2021),该模型将Llama 3的嵌入作为额外的输入。此集成利用了Llama 3的语言能力。

- Prosody Modeling Evaluation (韵律建模评估)

- 实验中比较了Llama 3嵌入的韵律模型与传统的流式音素生成模型,结果表明Llama 3的韵律模型在流式生成的实时性与表现力方面都显著优于传统模型。人类评审者在63.6%的情况下更倾向于Llama 3生成的语音。

论文原文: “As shown in Table 35, the Llama 3 8B PM is preferred 60% of the time compared to the streaming baseline, and 63.6% of the time compared to the non-streaming baseline, indicating a significant improvement in perceived quality.” 如表35所示,与流式基线相比,Llama 3 8B韵律模型(PM)在60%的情况下被偏好,且与非流式基线相比,在63.6%的情况下被偏好,这表明在感知质量上有显著提升。

3. 数据与训练细节:

- 数据:Llama 3的语音理解模块使用了大约15M小时的语音录音进行预训练,同时在后续的微调阶段,使用了230K小时的标注语音数据(ASR)与90K小时的语音翻译数据(AST)。该数据集涵盖34种语言,并且采用了自动去重、去噪等多种数据处理方法。

- 模型架构:语音编码器采用了参数量为1B的Conformer架构,而语音适配器包含了100M参数,结合卷积与旋转注意力机制,有效地压缩并处理语音信号,使之与语言模型进行高效集成。

Related Work

1. 概述:

在"Related Work"部分,论文介绍了Llama 3模型的开发和前期工作,涵盖了大规模基础模型在语言、图像、视频和语音处理等多模态领域的研究。

虽然全面的综述不在论文的范围内,但该部分简要提到了一些对Llama 3模型发展有重要影响的开创性研究。

论文讨论了模型的规模扩展、架构选择、小型模型的优化,以及开源基础模型的发展趋势。

2. 观点与分析:

- 语言模型的扩展(Language Models and Scaling)

- Llama 3的开发遵循了基础模型规模不断扩大的趋势,405B参数模型的预训练计算量几乎是Llama 2 70B模型的50倍。尽管Llama 3 405B比一些早期的模型参数更少(如PALM模型),但基于对扩展定律的更好理解,该模型表现更为优异。 这表明通过增加计算量和改善数据,模型性能可以显著提升。论文还指出,虽然GPT-4等模型的具体规模尚不为公众所知,但整体性能与Llama 3具有可比性。

论文原文:

“Llama 3 follows the enduring trend of applying straightforward methods at ever increasing scales in foundation models. Improvements are driven by increased compute and improved data, with the 405B model using almost fifty times the pre-training compute budget of Llama 2 70B”. Llama 3遵循了在基础模型中应用简单方法并不断扩大规模的长期趋势。其改进主要由计算能力的增加和数据质量的提升驱动,405B模型的预训练计算预算几乎是Llama 2 70B的五十倍。

- 小型模型的发展(Small Models Development)

- Llama 3也在小型模型的开发中取得了进展。较小的模型通过训练远超出计算最优点,换取推理效率的提升。论文提到,一种替代路径是通过蒸馏将大型模型转化为小型模型,从而在保持推理性能的同时降低计算成本。

论文原文:

“Developments in smaller models have paralleled those in large models. Models with fewer parameters can dramatically improve inference cost and simplify deployment”. 小模型的发展与大模型的发展并行。参数较少的模型可以显著降低推理成本,并简化部署过程。

- 架构选择(Architectures)

- 虽然Llama 3在架构上与Llama 2相比没有大的改动,但其他模型(如混合专家架构)通过有效增加模型容量,达到了类似的效果。论文指出,Llama 3的表现优于这些模型,表明密集架构并不是扩展的主要限制因素。不过,训练和推理的效率以及模型在大规模训练中的稳定性仍有很多折中之处。

论文原文:

"Llama 3 outperforms these models, suggesting that dense architectures are not the limiting factor, but there remain numerous trade offs in terms of training and inference efficiency, and model stability at scale."Llama 3 的表现优于这些模型,表明密集架构不是限制因素,但在训练和推理效率以及大规模模型稳定性方面仍然存在许多权衡。

- 开源基础模型(Open Source Foundation Models)

- 开源的基础模型近年来迅速发展,Llama 3-405B已经与当前封闭权重的最先进模型竞争。例如,Mistral、Falcon、MPT等模型家族最近发展迅速,Llama 3通过改进的数据和规模化训练,达到了与这些开源模型相当的水准。

论文原文:

"Open weights foundation models have rapidly improved over the last year, with Llama3-405B now competitive with the current closed weight state-of-the-art."开源权重的基础模型在过去一年中迅速提升,Llama 3-405B现已能够与当前闭源权重的最先进模型相媲美。

- 后训练策略(Post-Training Strategy)

- Llama 3的后训练阶段遵循了指令微调和人类反馈对齐的策略,这些技术通过大规模的人类指令和偏好判断提升了预训练模型的表现。

论文原文:

“Post-training Llama 3 follows the established strategy of instruction tuning (Chung et al., 2022; Ouyang et al., 2022) followed by alignment with human feedback (Kaufmann et al., 2023).” Llama 3的后训练阶段遵循了既定的策略,即先进行指令微调(Chung等人,2022;Ouyang等人,2022),然后通过与人类反馈对齐(Kaufmann等人,2023)。

3. 图表与引用工作:

- 在相关工作的引用中,论文提到了多个影响Llama 3模型发展的研究,如Kaplan等(2020)和Hoffmann等(2022)对扩展定律的研究,为模型规模的优化提供了理论依据。

- 在图像、视频和语音处理领域,Llama 3借鉴了很多现有的多模态模型设计,并通过组合架构实现了跨模态的处理能力。

通过“Related Work”部分,Llama 3展示了它在语言模型扩展、小型模型优化和开源基础模型发展中的独特位置,并且通过继承和改进多模态处理技术,实现了更高效的推理和训练性能。

Conclusion

1. 概述:

Llama 3 论文的结论部分总结了其开发过程中的关键发现,模型的潜力,以及未来改进的方向。

Llama 3 的开发被描述为高质量基础模型发展的一个早期阶段,作者认为在模型的数据质量、规模和简单性方面的持续关注是其成功的关键。

尽管进行了大量的实验,论文中指出,复杂的模型架构和训练方法并未带来显著的好处,相反,简单而规模化的方案才是实现最佳效果的核心。

2. 观点与分析:

- 模型质量与规模的关系 (The Relationship Between Model Quality and Scale)

- 作者指出,通过规模化和高质量数据的持续使用,Llama 3 展示了较好的性能提升。尽管模型参数的规模比 Llama 2 提升了50倍,但由于对扩展定律的理解加深,模型能够在相对较少参数的情况下,超越如 PALM 等更大模型的表现。

论文原文:

“Our experience in developing Llama 3 suggests that substantial further improvements of these models are on the horizon. Throughout the development of the Llama 3 model family, we found that a strong focus on high-quality data, scale, and simplicity consistently yielded the best results”. 我们在开发Llama 3的过程中发现,这些模型在未来仍有巨大的改进空间。在Llama 3模型家族的开发过程中,我们发现对高质量数据、规模和简化的强烈关注始终带来了最佳结果。

- 组织决策的影响 (Impact of Organizational Decisions)

- Llama 3 的开发不仅克服了技术难题,还通过一系列聪明的组织决策来 避免过拟合。例如,作者提到,他们使用了独立的团队来处理预训练数据,从而防止数据集与外部基准数据的污染。

论文原文:

“To ensure Llama 3 is not accidentally overfitted on commonly used benchmarks, our pre-training data was procured and processed by a separate team that was strongly incentivized to prevent contamination of that pre-training data with external benchmarks”. 为了确保Llama 3不会在常用基准测试上意外过拟合,我们的预训练数据由一个独立的团队采购和处理,该团队有强烈的激励措施来防止预训练数据被外部基准测试污染。

- 开放模型的责任 (Responsibility of Open Model Release)

- 论文强调,Llama 3 的公开发布不仅是为了推动AI的持续发展,还为了鼓励AI行业内的开放、负责任的模型开发。通过 分享早期的多模态实验结果,作者希望加速该方向的研究,并相信公开发布是推动人工通用智能(AGI)发展的关键步骤。

论文原文:

“We believe that the public release of foundation models plays a key role in the responsible development of such models, and we hope that the release of Llama 3 encourages the industry to embrace the open, responsible development of AGI”. 我们相信,基础模型的公开发布在这些模型的负责任开发中发挥着关键作用,我们希望Llama 3的发布能够鼓励业界拥抱开放、负责任的AGI(通用人工智能)开发。

3. 安全分析与模型发布:

Llama 3 的安全分析得出了积极的结果,促使作者决定公开发布该模型。他们认为这一决定将加速相关领域的研究,并有助于提高AI系统在社会中发挥的作用。

通过这种开放的方式,论文指出 Llama 3 的发布是负责任 AI 开发的一个重要里程碑,有助于全球科研社区发现模型的改进和安全性。

"Conclusion"部分突出了 Llama 3 的未来潜力,强调了高质量数据和简化架构在大规模基础模型开发中的重要性,同时也呼吁负责任的开放式模型开发。

这一结论为模型的进一步研究和改进奠定了基础。

Llama 3 模型中的数学原理

Llama 3 模型中的数学原理涉及多个层面,包括深度学习中的基础数学操作,如线性代数、概率论、微积分,以及更高阶的数学工具,如缩放定律、注意力机制的优化、梯度下降的改进等等。

为了让你全面了解 Llama 3 背后的数学原理,下面将从以下几个主要方面进行深入分析:模型结构与基础数学操作、自注意力机制的数学基础、分组查询注意力(GQA)机制的数学分析、缩放定律与预训练计算复杂性、优化算法与梯度下降、大规模并行计算中的数学问题,并补充特定任务的数学表现(如数学推理)。

1. 模型结构与基础数学操作

Llama 3 采用了标准的 Transformer 架构,这是现代自然语言处理模型中非常常见的设计。该架构中最基础的数学运算涉及到矩阵乘法和线性变换,主要体现在以下几个方面:

- 词嵌入:输入数据经过词嵌入层后被转换为高维向量。这实际上是一个矩阵变换:假设输入词汇的词汇表大小为 V V V,嵌入维度为 d d d,那么嵌入矩阵为 V × d V \times d V×d。通过矩阵乘法,可以将输入的词汇 ID(通常表示为独热编码的向量)映射到嵌入空间。

- 前馈网络(FFN):在 Transformer 中的每一个位置,前馈神经网络(Feed-Forward Network, FFN)是一个两层的全连接网络,通常表示为:

F F N ( x ) = max ( 0 , x W 1 + b 1 ) W 2 + b 2 FFN(x) = \max(0, xW_1 + b_1)W_2 + b_2 FFN(x)=max(0,xW1+b1)W2+b2

其中, x x x 是输入, W 1 W_1 W1、 W 2 W_2 W2 是权重矩阵, b 1 b_1 b1、 b 2 b_2 b2 是偏置向量。这里的数学运算主要是矩阵乘法与加法。

- 残差连接与归一化:Transformer 使用残差连接和 LayerNorm,这部分的数学运算也涉及简单的加法和归一化操作。LayerNorm 通过计算每个输入的均值和方差来进行标准化处理:

LayerNorm ( x ) = x − μ ( x ) σ ( x ) \text{LayerNorm}(x) = \frac{x - \mu(x)}{\sigma(x)} LayerNorm(x)=σ(x)x−μ(x)

其中, μ ( x ) \mu(x) μ(x) 是输入的均值, σ ( x ) \sigma(x) σ(x) 是输入的标准差。

2. 自注意力机制的数学基础

自注意力机制(Self-Attention Mechanism)是 Transformer 架构的核心部分,在这里涉及到的数学运算主要是线性代数和概率论。自注意力机制通过计算不同词汇之间的相似性来决定每个词在句子中的重要性。其核心数学操作如下:

- 查询(Query)、键(Key)、值(Value)的计算:每个输入词被映射成三个向量,称为查询向量 Q Q Q、键向量 K K K和值向量 V V V,它们分别通过与不同的权重矩阵 W Q W_Q WQ、 W K W_K WK、 W V W_V WV相乘得到:

Q = X W Q , K = X W K , V = X W V Q = XW_Q, \quad K = XW_K, \quad V = XW_V Q=XWQ,K=XWK,V=XWV

其中, X X X 是输入的词向量矩阵, W Q W_Q WQ、 W K W_K WK、 W V W_V WV 分别是权重矩阵。

- 注意力分数的计算:通过计算查询向量和键向量的点积,得到每对词之间的相似度。这个点积通过软最大值(softmax)函数进行归一化,转化为注意力权重:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

这里的 1 d k \frac{1}{\sqrt{d_k}} dk1是缩放因子,避免点积值过大,导致softmax梯度消失问题。软最大值函数:

softmax ( z i ) = e z i ∑ j e z j \text{softmax}(z_i) = \frac{e^{z_i}}{\sum_j e^{z_j}} softmax(zi)=∑jezjezi

将注意力分数归一化为一个概率分布。

- 多头注意力机制(Multi-Head Attention):为了让模型能从不同的表示空间学习注意力信息,自注意力机制会被分成多个“头”,即多个不同的查询、键、值空间。每个头的计算是独立的,最后将各个头的结果拼接起来:

MultiHead ( Q , K , V ) = Concat ( head 1 , … , head h ) W O \text{MultiHead}(Q, K, V) = \text{Concat}(\text{head}_1, \dots, \text{head}_h)W_O MultiHead(Q,K,V)=Concat(head1,…,headh)WO

这里的每个 head i \text{head}_i headi都是一个独立的注意力机制结果,最终通过权重矩阵 W O W_O WO线性变换得到输出。

3. 分组查询注意力(GQA)的数学分析

Llama 3 引入了分组查询注意力(Grouped Query Attention, GQA)机制,以提高推理速度并减少解码时的内存占用。其数学原理在于减少注意力头的数量,但通过合理的分组策略,仍然能够捕获全局上下文信息。其核心数学操作如下:

- 分组注意力:在传统的多头注意力机制中,每个查询、键和值向量都需要计算多次,消耗较多的计算资源和内存。GQA 通过将查询向量分组,每组共享相同的键和值向量。这减少了计算复杂度,节省了显存,同时保持了注意力机制的有效性。

- 优化点积计算:通过减少键和值的数量,GQA 有效地降低了点积运算的次数。例如,假设有 8 个查询向量,但只使用 4 个共享的键和值向量组,那么点积计算量就从 64 次减少到了 32 次。

数学上,这一优化方法主要依赖于线性代数中的矩阵分解与简化,在较小的维度上进行注意力权重计算,并通过合理的分组策略来近似全局的注意力效果。

4. 缩放定律与预训练计算复杂性

缩放定律是 Llama 3 背后非常重要的数学工具,它用来确定模型的最佳规模和训练数据量之间的关系。缩放定律基于幂律(Power Law),数学上表现为模型参数量、计算资源(FLOPs)与模型性能之间的关系可以通过一个幂律函数进行描述。

-

模型规模和性能的关系:假设模型的计算量为 C C C,训练数据量为 N N N,那么缩放定律可以表示为:

N ( C ) = A C α N(C) = AC^\alpha N(C)=ACα其中, α \alpha α和 A A A是通过实验拟合得到的常数。通过这种关系,可以预测给定的计算预算下,应该选择多大的模型规模和多少训练数据,才能最大化模型的性能。

-

计算损失与 FLOPs 的关系:在 Llama 3 的训练中,通过大量的实验,绘制出了计算预算(FLOPs)与验证集损失之间的关系曲线。曲线显示,随着计算预算的增加,损失逐渐减少,但在某一规模后,性能提升开始变得不明显,这就是所谓的“计算最优模型”。

5. 优化算法与梯度下降

Llama 3 的训练过程中采用了AdamW 优化器,它是经典 Adam 算法的一个变种,增加了权重衰减(weight decay)的正则化,帮助防止过拟合。AdamW 的数学原理基于梯度下降,但其具体计算方式如下:

- Adam 优化器的更新公式:Adam 通过计算梯度的一阶动量和二阶动量来更新参数,其核心公式为:

m t = β 1 m t − 1 + ( 1 − β 1 ) g t m_t = \beta_1 m_{t-1} + (1 - \beta_1) g_t mt=β1mt−1+(1−β1)gt

v t = β 2 v t − 1 + ( 1 − β 2 ) g t 2 v_t = \beta_2 v_{t-1} + (1 - \beta_2) g_t^2 vt=β2vt−1+(1−β2)gt2

m t ^ = m t 1 − β 1 t , v t ^ = v t 1 − β 2 t \hat{m_t} = \frac{m_t}{1 - \beta_1^t}, \quad \hat{v_t} = \frac{v_t}{1 - \beta_2^t} mt^=1−β1tmt,vt^=1−β2tvt

θ t = θ t − 1 − α m t ^ v t ^ + ϵ \theta_t = \theta_{t-1} - \alpha \frac{\hat{m_t}}{\sqrt{\hat{v_t}} + \epsilon} θt=θt−1−αvt^+ϵmt^

其中, m t m_t mt和 v t v_t vt分别是一阶和二阶动量的估计值, α \alpha α是学习率, θ t \theta_t θt是模型参数。

- 权重衰减(Weight Decay):AdamW 引入了权重衰减机制,通过在每次更新时对参数进行额外的惩罚,公式为:

θ t = θ t − 1 − α ( m t ^ v t ^ + ϵ + λ θ t − 1 ) \theta_t = \theta_{t-1} - \alpha \left( \frac{\hat{m_t}}{\sqrt{\hat{v_t}} + \epsilon} + \lambda \theta_{t-1} \right) θt=θt−1−α(vt^+ϵmt^+λθt−1)

其中, λ \lambda λ是权重衰减系数。权重衰减有助于防止模型过度拟合,并使模型在训练过程中更加稳健。

6. 大规模并行计算中的数学问题

Llama 3 在训练过程中使用了大规模的并行计算技术,包括张量并行(Tensor Parallelism)、流水线并行(Pipeline Parallelism)和数据并行(Data Parallelism),其背后的数学原理主要体现在如何高效地分配计算任务,并减少通信开销。

- 张量并行:将大型矩阵分解为较小的子矩阵,在不同的 GPU 上并行计算。这一过程涉及到矩阵分解和张量计算的优化。

- 流水线并行:将模型分成多个部分,每个部分在不同的 GPU 上依次执行。这类似于经典的流水线计算,通过并行化不同步骤的计算,减少了整体计算时间。

- 数据并行:不同的 GPU 处理不同的训练数据,最后在同步阶段合并梯度。这一过程中涉及到梯度聚合的数学计算,以及同步通信的优化。

这些并行计算技术的有效运用,依赖于对模型参数量、数据量、计算量的精确估计和任务调度的数学模型,以最小化通信和计算瓶颈。

7. 数学任务中的表现

Llama 3 在数学推理任务(如GSM8K和MATH基准测试)中表现非常出色,这得益于其在预训练过程中专门处理了大量数学相关的数据。这部分数据通过特定的预处理和筛选,包括公式的解析和符号推理,模型在处理数学推理任务时表现出强大的符号计算能力和逻辑推理能力。

8. 矩阵分解与稀疏性优化

在深度学习模型中,尤其是像 Llama 3 这样的大型语言模型,矩阵乘法是最耗时和资源密集的操作之一。为了提高计算效率,Llama 3 在某些操作中可能采用了矩阵分解(Matrix Factorization)技术。矩阵分解将一个大型稠密矩阵分解为两个或多个较小的矩阵,降低了计算复杂度。例如,给定一个矩阵 A A A,它可以分解为两个更小的矩阵 B B B和 C C C,使得 A ≈ B × C A \approx B \times C A≈B×C。这种方法减少了乘法操作的总次数,特别是在使用大量参数的情况下。

除此之外,模型中可能也涉及稀疏性优化(Sparsity Optimization)技术,特别是在注意力机制中。稀疏注意力可以通过只计算与当前查询最相关的键值对来减少计算量,而不是计算全局的注意力权重,从而大幅降低复杂度。这种稀疏矩阵的处理通常涉及稀疏线性代数的技术,减少了矩阵运算的维度和耗时。

9. 随机性与采样策略

在 Llama 3 的预训练和微调过程中,使用了大量的随机采样(Stochastic Sampling)技术。随机性在深度学习中的应用包括数据的采样、模型参数的初始化,以及训练过程中随机梯度下降算法的使用。

- 数据采样:模型在训练时从巨大的数据集中随机采样训练样本。这种采样过程依赖于概率论中的采样方法,确保模型能够学习到数据分布中的多样性,并避免过拟合。Llama 3 的训练数据集是多语言的,并且包括了编程语言和数学推理任务,使用了特定的采样策略以确保不同类型的数据均衡输入模型。

- Dropout 正则化:Llama 3 可能在训练过程中使用了Dropout技术,这是通过随机丢弃一部分神经元来防止过拟合的正则化方法。Dropout 的数学原理也基于概率论,它通过以一定概率随机将某些神经元的输出置为零,降低了模型对某些权重的过度依赖,提高了模型的泛化能力。

10. 基于对抗的训练方法

Llama 3 在模型的后期训练中可能使用了某些对抗训练(Adversarial Training)策略,用以提高模型的鲁棒性。对抗训练的数学基础源自博弈论,通过在模型的输入中引入对抗性样本,测试模型的稳定性。这些对抗性样本是通过在输入数据上施加微小扰动生成的,它们旨在使模型在面对稍微修改过的输入时依然保持正确的预测。

对抗训练过程中的优化问题可以被形式化为一个最小-最大优化问题:

min θ max δ ∈ S L ( f θ ( x + δ ) , y ) \min_\theta \max_{\delta \in S} L(f_\theta(x + \delta), y) θminδ∈SmaxL(fθ(x+δ),y)

其中, θ \theta θ 是模型参数, δ \delta δ 是在一定范围内的扰动, L L L 是损失函数, f θ ( x ) f_\theta(x) fθ(x) 是模型的输出。这种训练方式通过提高模型对微小输入变化的敏感性,增强了其鲁棒性。

11. 长上下文序列中的记忆机制

Llama 3 引入了处理长上下文的能力,能够处理长度达到 128K 个 token 的上下文。这一技术的实现需要解决长距离依赖问题,即如何在极长的输入序列中保持有效的上下文记忆。这涉及到时间复杂度优化和内存效率优化的数学原理。

- 自回归模型的时间复杂度:在处理长序列时,传统的 Transformer 模型的时间复杂度为 O ( n 2 ) O(n^2) O(n2)(其中 n n n 是序列长度),因为每个 token 与序列中的每个其他 token 都需要计算注意力权重。Llama 3 通过分层次的自注意力机制或通过稀疏注意力机制来降低这一复杂度,减少不必要的计算。

- RoPE(旋转位置嵌入):Llama 3 的长上下文能力还与其改进的旋转位置编码(RoPE)相关。RoPE 的数学原理是通过旋转向量空间中的位置编码,解决传统位置编码方法在长序列中失效的问题。RoPE 通过调整基频的参数,使得位置编码在长序列中依然保持准确的距离信息。

12. 多任务学习中的数学原理

Llama 3 不仅仅处理语言生成任务,它还支持多任务学习,包括图像、视频、语音的处理能力。多任务学习的实现需要构建一个共享的特征表示空间,这涉及到多模态学习中的数学原理。

- 多模态嵌入空间的构建:在多模态学习中,模型需要将不同模态的数据(如图像、语音、文本)映射到同一个嵌入空间。假设输入图像的特征向量为 v img v_{\text{img}} vimg,输入文本的特征向量为 v txt v_{\text{txt}} vtxt,模型需要学习一个映射 f f f,使得 f ( v img ) ≈ f ( v txt ) f(v_{\text{img}}) \approx f(v_{\text{txt}}) f(vimg)≈f(vtxt)。这种映射通常通过对比学习(Contrastive Learning)来实现,其目标是最小化同一模态下特征的距离,同时最大化不同模态下特征的距离:

L = − log exp ( f ( v img ) ⋅ f ( v txt ) / τ ) ∑ i exp ( f ( v img ) ⋅ f ( v txt ( i ) ) / τ ) L = - \log \frac{\exp(f(v_{\text{img}}) \cdot f(v_{\text{txt}}) / \tau)}{\sum_{i} \exp(f(v_{\text{img}}) \cdot f(v_{\text{txt}}^{(i)}) / \tau)} L=−log∑iexp(f(vimg)⋅f(vtxt(i))/τ)exp(f(vimg)⋅f(vtxt)/τ)

其中, τ \tau τ是温度参数,控制分布的平滑度。通过对比学习,模型能够有效地在不同模态下保持一致的特征表示。

13. 模型校准与安全性

Llama 3 在后期训练中加入了大量的安全性校准机制,以确保模型在生产环境中的安全应用。数学上,这涉及置信度校准和异常检测。

- 置信度校准:Llama 3 在生成结果时需要评估其置信度,避免过高估计其输出的正确性。模型校准常用的数学工具包括温度缩放(Temperature Scaling),即通过引入温度参数对模型的输出概率进行重新校准,使得模型的置信度更接近于实际精度。

- 异常检测:为了保证输入输出的安全性,Llama 3 可能使用了基于统计学的异常检测方法。例如,模型可以通过检测输入数据的分布是否与训练数据分布一致来判断输入是否异常,这一过程常用Kullback-Leibler 散度(KL 散度):

D KL ( P ∣ ∣ Q ) = ∑ x P ( x ) log P ( x ) Q ( x ) D_{\text{KL}}(P || Q) = \sum_x P(x) \log \frac{P(x)}{Q(x)} DKL(P∣∣Q)=x∑P(x)logQ(x)P(x)

通过衡量输入数据分布与正常分布的差异,模型可以识别出潜在的攻击性或异常输入。

总结补充

除了前面详尽的分析之外,Llama 3 模型中的数学原理还涉及更多细微的优化和调整,包括并行计算中的通信优化、多模态学习中的表示空间构建,以及安全性校准中的统计学方法。通过这些数学工具,Llama 3 能够高效处理大规模数据,并确保其在生成任务中的准确性和鲁棒性。

![[大语言模型-论文精读] MoRAG - 基于多部分融合的检索增强型人体动作生成](https://i-blog.csdnimg.cn/direct/6cb68d3693734e1a8267887bd1e57f22.png)