这篇文是参考了这篇,然后后来自己试着搭了一下,记录的全部过程:【翻译】Ollama|如何在 Ollama 中运行 Hugging Face 中的模型_ollama 导入 huggingface-CSDN 博客

另外还参考了这篇:无所不谈,百无禁忌,Win11 本地部署无内容审查中文大语言模型 CausalLM-14B - 知乎

文章目录

- 步骤 1:下载 GGUF 格式模型

- 1 示例

- 2 如何查找 GGUF 模型

- 步骤 2:部署

- 1 安装 Visual Studio installer 的 C++ 桌面开发组件

- 2 安装 cmake

- 3 安装 CUDA(一般显卡都装了驱动,不过可能没装nvcc这些命令工具,nvcc没装就再装装)

- 4 下载llama.cpp

- 5 解压llama-b3772-bin-win-cuda-cu12.2.0-x64.zip

- 6 运行指令

- 步骤3:展示

步骤 1:下载 GGUF 格式模型

这个格式才是量化版本,不用自己编译了。

具体内存或显存的要求你们可以自己考虑,我的电脑独显 3060 6G 的 14B 的量化模型没啥问题。

1 示例

- https://huggingface.co/TheBloke/CausalLM-14B-GGUF

- https://huggingface.co/hfl/chinese-llama-2-13b-gguf/tree/main

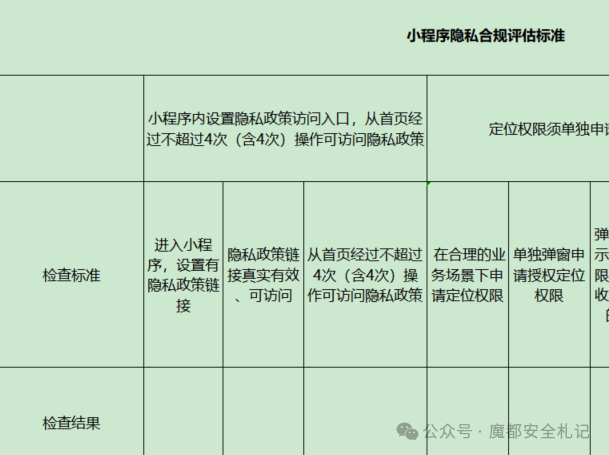

2 如何查找 GGUF 模型

- 一般情况你在链接后面加

-gguf就有量化版本了; - 找不到的话可以去 Github 的 README 里搜 GGUF 关键词,比如下图:

步骤 2:部署

1 安装 Visual Studio installer 的 C++ 桌面开发组件

Visual Studio 2022 IDE - 适用于软件开发人员的编程工具

2 安装 cmake

https://cmake.org/download/

3 安装 CUDA(一般显卡都装了驱动,不过可能没装nvcc这些命令工具,nvcc没装就再装装)

https://developer.nvidia.com/cuda-downloads

4 下载llama.cpp

https://github.com/ggerganov/llama.cpp/releases,选自己的版本,我下载的是llama-b3772-bin-win-cuda-cu12.2.0-x64.zip。

5 解压llama-b3772-bin-win-cuda-cu12.2.0-x64.zip

进入目录,在这个目录下打开命令行工具,创建一个目录models,把gguf模型放进去(你也可以选择用绝对路径,一个意思)。

6 运行指令

.\llama-cli.exe -m models/causallm_14b.Q4_0.gguf -p "You are a helpful assistant" -cnv(改成你自己的模型名字)

步骤3:展示

在命令行去运行:

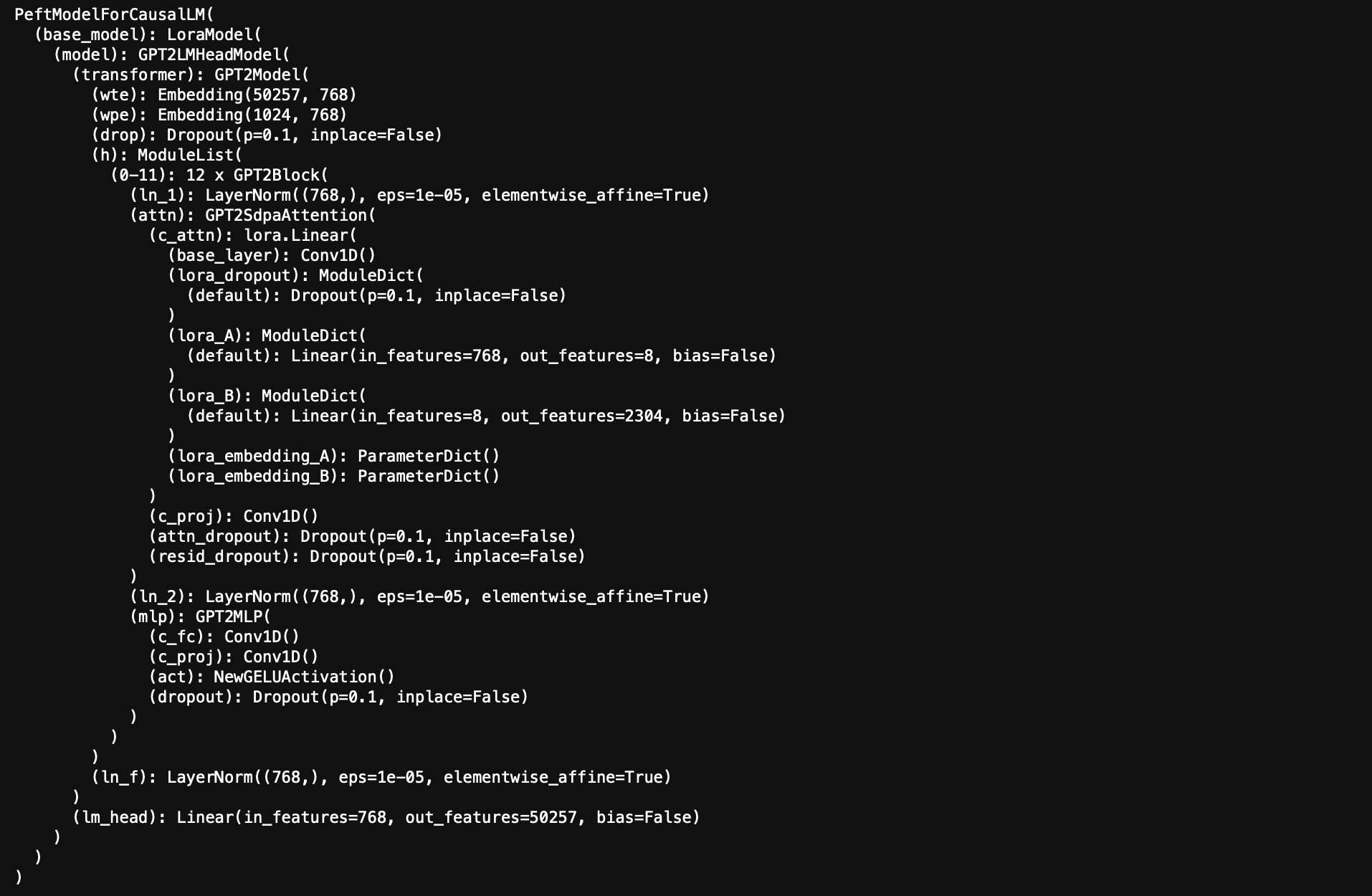

会运行得到这种东西:

运行的时候还能加上一些额外的参数,比如这样:.\llama-cli.exe -m models/causallm_14b.Q4_0.gguf -p "You are a helpful assistant" -cnv --chat-template llama2,这时指令模板就会发生变化,如下所示:

好了。

本账号所有文章均为原创,欢迎转载,请注明文章出处:https://shandianchengzi.blog.csdn.net/article/details/142438818。百度和各类采集站皆不可信,搜索请谨慎鉴别。技术类文章一般都有时效性,本人习惯不定期对自己的博文进行修正和更新,因此请访问出处以查看本文的最新版本。