系列论文研读目录

文章目录

- 系列论文研读目录

- 摘要

- 1 引言

- 2 相关工作

- 3 方法

- 3.1对比图像预训练

- 3.2 多模式对齐提示

- 3.3 多任务提示学习框架

- 4 实验

- 4.1基准设置

- 4.2实验结果

- 4.3消融研究

- 5、结论

摘要

多任务学习(Multi-Task Learning,MTL)是为了同时训练多个相互关联的任务,从而提高单个任务的性能而设计的。典型地,多任务网络结构由共享主干和特定任务解码器组成。然而,解码器的复杂度随着任务的数量而增加.为了解决这一问题,我们集成了无解码器的视觉语言模型CLIP,该模型具有鲁棒的zero-shot泛化能力。最近,参数有效的迁移学习方法伴随CLIP已被广泛地探索,以适应下游任务,其中提示调整显示了强大的潜力。然而,这些方法仅对单个模态(文本或视觉)进行微调,破坏了CLIP的模态结构。本文首先提出了一种多模态对齐提示(MmAP)算法,用于CLIP中的文本和视觉模态的对齐。在MmAP的基础上,我们开发了一个创新的多任务提示学习框架。一方面,为了最大化相似度较高的任务之间的互补性,我们采用了一种梯度驱动的任务分组方法,将任务划分为若干个互不相交的组,并为每个组分配一个组共享的MmAP。另一方面,为了保持每个任务的独特特征,我们为每个任务分配任务特定的MmAP。在两个大型多任务学习数据集上的综合实验表明,与完全微调相比,我们的方法在仅利用了约0.09%的可训练参数的情况下,获得了显著的性能改善。

1 引言

- 多任务学习(MTL)已经成为深度学习中的一种有效方法,它允许在统一的网络架构中联合训练多个相关任务,从而与单任务学习(STL)相比增强了模型性能。MTL的核心在于学习任务共享表征和任务特定表征。通过利用跨任务的共享表示和知识,MTL增强了泛化并减轻了过拟合。利用特定的表示允许MTL保留每个任务的独特特征。此外,训练多个任务的统一模型通常比训练几个单任务模型更有参数效率。因此,MTL在各个领域都引起了相当大的兴趣,包括计算机视觉(Shen et al. 2021; Ye and Xu 2023; Xin et al. 2023),自然语言处理(He et al. 2022)等。

- 在这项工作中,我们主要关注视觉多任务学习。先前的研究主要集中在多任务模型训练框架的设计上,包括基于编码器的方法(Gao et al. 2019)和基于解码器的方法(Xu,Yang,and Zhang 2023)。然而,随着视觉预训练模型(例如,ViT(Dosovitskiy et al. 2021),SwinTransformer(Liu et al. 2021)),直接微调这些模型用于下游多任务,导致性能大幅提升,并已成为多任务学习的主流方法(Liu et al. 2022)。在这种微调范式中,仍然有必要为每个任务建立一个不同的解码器,可训练参数线性增加。

- 为了解决上述问题,我们结合了预训练的视觉语言模型CLIP(拉德福等人,2021),并认为它是为视觉多任务学习量身定制的。一方面,CLIP被训练为使用网络规模的数据(例如,4亿个文本图像对),赋予它强大的zero-shot传输到视觉下游任务的能力。另一方面,CLIP的体系结构提供了明显的优势。它包括一个文本编码器和一个图像编码器,无需为每个任务建立额外的解码器结构。因此,我们选择调整CLIP来解决视觉多任务。

- 在传统的预训练微调范例之后,整个CLIP参数(150 M)将需要更新,这提出了关于计算和存储费用的挑战。最近,许多研究(Zaken,Goldberg和Ravfogel 2022; Jia et al. 2022 b; Gao et al. 2021; Zhou et al. 2022)引入了参数有效的迁移学习技术,以实现可训练参数和下游任务性能之间的最佳平衡。尽管如此,这些现有的方法主要集中在预先训练的视觉模型或语言模型,其适用于更复杂的视觉语言模型仍然不确定。此外,这些方法往往强调单任务适应,而多任务适应仍然是一个挑战。

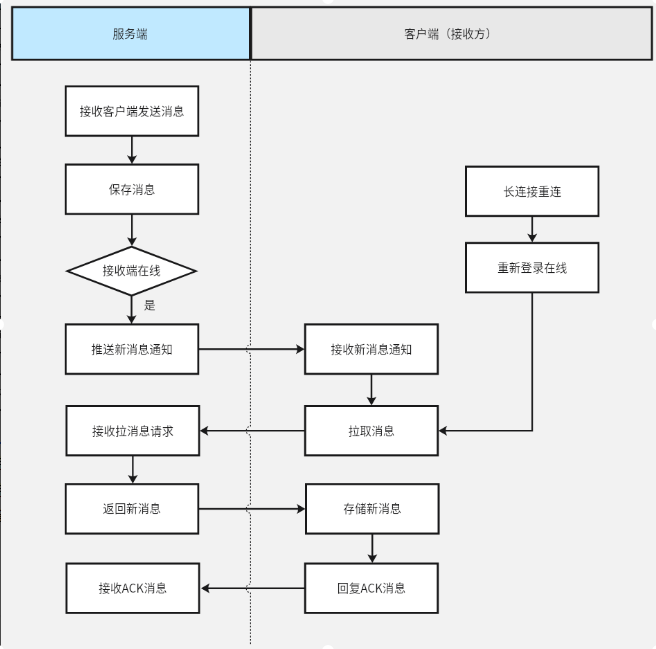

- 首先,我们首先对现有成功的参数高效迁移学习方法在应用于CLIP进行视觉多任务学习时的性能进行了彻底的检查,如图1所示。通过我们广泛的研究,我们发现提示微调方法VPT-MT(Jia et al. 2022 b),CoOp-MT(Zhou et al. 2022)和MaPLe-MT(Khattak et al. 2023)比BitFit(Zaken,Goldberg和Ravfogel 2022)和Adapter(Gao et al. 2021)更合适。这可能归因于BitFit和Adapter更新模型参数并破坏CLIP的原始结构完整性。相反,提示调优方法只修改输入嵌入(文本或图像),如图2所示。此外,我们观察到MaPLe-MT优于VPT-MT和CoOp-MT,强调了同时调整两种模式的优势。

(a)文本提示调整(Zhou et al. 2022),(B)视觉提示调整(Jia et al. 2022 B),(c)多模态提示学习(Khattak et al. 2023)和(d)我们的多模态对齐提示调整。火苗图标表示可训练参数,雪花图标表示冻结参数,[class]表示克罗内克积,[class]表示类别名称。

(a)文本提示调整(Zhou et al. 2022),(B)视觉提示调整(Jia et al. 2022 B),(c)多模态提示学习(Khattak et al. 2023)和(d)我们的多模态对齐提示调整。火苗图标表示可训练参数,雪花图标表示冻结参数,[class]表示克罗内克积,[class]表示类别名称。 - 随后,基于我们的观察结果,我们提出了一种新的针对CLIP的多模式对齐提示(MMAP),并为多任务图像识别场景定制了一个框架。我们的MMAP通过源提示生成文本提示和视觉提示,以实现两种模态的微调对齐效果。此外,我们还设计了一个基于MmAP的多任务提示调优框架。以前的MTL工作(Fifty等人2021年;斯坦德利等人,2020)证实了共同训练相似的任务会产生互补的效果,而同时训练不同的任务会产生负面的效果。因此,我们首先利用梯度相似度对任务进行分组,然后分配一个组共享的MmAP进行联合训练。此外,为了保持每个任务的独立性,我们分别为每个任务建立特定于任务的MmAP。我们在Office-Home和MiniDomainNet两个大型跨域多任务数据集上对我们的方法进行了测试。图1显示了Office-Home上的结果,说明我们提出的方法在可训练参数和性能之间实现了良好的权衡。

2 相关工作

多任务学习。 多任务学习(Multi-Task Learning,MTL)旨在通过共享知识和计算来同时学习多个任务。在计算机视觉领域有两种典型的多任务处理方法。首先是稠密场景理解多任务,对每个输入样本进行语义分割、表面法向估计、显著性检测等。当前关于多任务密集场景理解的研究主要集中在解码器结构设计上(Zhang等人,2021; Xu,Yang,and Zhang,2023; Liang等人,2023)。另一种是跨域分类多任务,输入数据由多个具有域偏移的数据集组成。由于涉及多个领域,当前的研究强调学习领域之间共享和私人的信息(Shen等人,2021; Long等人,2017)。

视觉-语言模型。基本的视觉语言模型(例如,CLIP(拉德福等人,2021)和ALIGN(Jia等人,2021))在各种视觉任务中表现出了卓越的能力。与仅通过图像监督学习的模型相比,这些V-L模型编码了丰富的多模态表示。尽管这些预训练的V-L模型学习了丰富的表示,但是有效地使它们适应下游视觉任务仍然是一个具有挑战性的问题。大量工作已证明,通过采用定制方法调整V-L模型以进行检测(Li等人,2022; Zhong等人,2022)、分割(Rao等人,2022; Xu等人,2022)和识别(Wortsman等人,2022),可改善下游视觉任务的性能。此外,HiPro(Liu等人,2023)构建了一种分层结构,以使预先训练的V-L模型适应各种下游任务。

参数有效的迁移学习。参数有效迁移学习(Parameter Efficient Transfer Learning,PETL)的目标是通过训练少量参数,使预先训练好的模型适应新的下游任务。现有的PETL方法可以分为三组:参数调整、适配器调整和提示调整。通过调整权重(Hu等人,2022)或偏差(Zaken、Goldberg和Ravfogel,2022),参数调整直接修改预训练模型的参数。适配器调优将可训练瓶颈架构插入到冻结的预训练模型中,旨在促进下游任务的学习,例如AdaptFormer(Chen等人,2022)、VL-Adapter(Sung、Cho和Bansal,2022)和CLIP-Adapter(Gao等人,2021)。通过设计一个特定的模板,快速调整将所有下游任务统一为预先训练的任务,以充分利用基础模型的能力(Jia等人,2022 a; Khattak等人,2023; Wang等人,2023)。

3 方法

在本节中,我们首先回顾视觉语言模型,重点关注CLIP。随后,我们介绍了我们提出的多模态对齐提示(MmAP)。最后,我们提出了一个统一的快速学习框架,它结合了组共享MmAP和任务特定的MmAP。

3.1对比图像预训练

图像编码器。在本研究中,我们选择ViT(Dosovitskiy等人,2021)作为图像编码器,以与视觉提示兼容(Jia等人,2022 b)。给定一幅输入图像I ∈ RH×W×3,由K个Transformer层组成的图像编码器将图像分割成M个固定大小的块,并将它们投影到块嵌入E0 ∈ RM×dv中。伴随有可学习类标记ck的补丁嵌入Ek被馈送到图像编码器的第(k + 1)层Vk+1,并且通过以下Transformer层顺序地处理:为了获得最终图像表示x,来自最后Transformer层的类标记cK经由ImageProj被投影到V-L潜在嵌入空间中:x = ImageProj(cK)。(2)

文本编码器。文本编码器采用一个K层的Transformer对输入的单词进行标记化,并将其投影到单词嵌入W 0 ∈ RN×dl中。Wk被直接馈送到文本编码器的第k +1层Lk+1:[Wk+1] = Lk+1(Wk)k = 0,1,…,K − 1。(3)最终文本表示z是通过将与结束的Transformer层LK的最后一个标记相关联的文本嵌入经由TextProj投影到V-L潜在嵌入空间中来获得的:z = TextProj(WK)。

zero-shot预测。对于zero-shot预测,在CLIP的语言分支中引入了精心设计的提示,该提示用于通过配备与下游任务相关联的每个类名(例如,“a photo of a [CLASS]”)。然后,选择具有最高余弦相似性得分的类作为给定图像的预测标签pky,即其中sim(,)表示余弦相似度的计算。τ是CLIP学习的温度系数,C是类的总数。

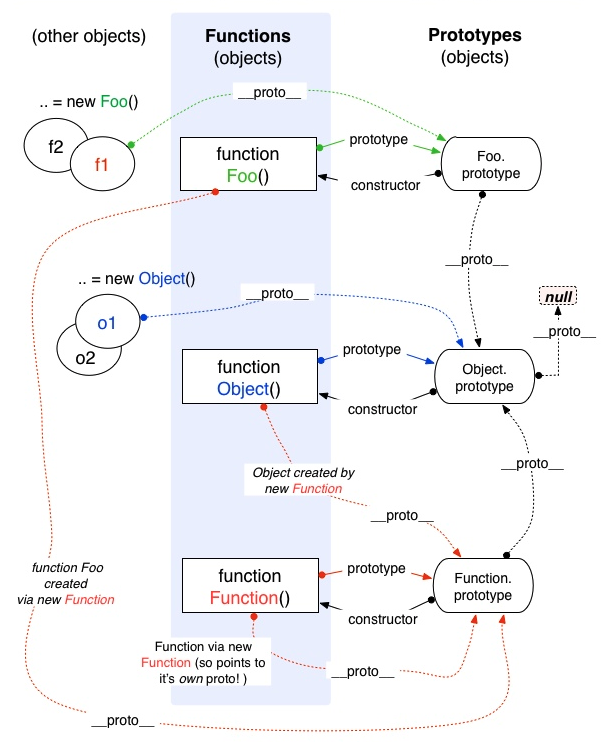

3.2 多模式对齐提示

以前的研究主要集中在设计一个单一的模态提示。例如,VPT研究了视觉提示,而CoOp则引入了可学习的文本提示。我们认为,仅仅调整一种模态会破坏CLIP的文本图像匹配,导致下游任务的次优适应。目前最流行的方法是利用文本提示通过参数较多的MLP生成视觉提示,但在视觉形态和模型效率方面存在局限性。

为了解决这些问题,我们提出了多模态对齐提示(MultimodalAlignmentPrompt,MmAP)来同时生成文本提示Pl ∈ Rb×dl和图像提示Pv ∈ Rb×dv。这里,我们将B表示为提示的长度,而dl和dv分别表示文本和图像标记的尺寸。我们首先初始化一个源提示Ps ∈ Rm×n和两个单独的缩放矩阵Ml ∈ R B m× dl n和Mv ∈ R B m×dv n。然后,我们应用Kronecker Product为文本和图像编码器生成提示,如下所示:

我们提出的MmAP具有两个显著的优点。首先,克罗内克积的使用确保了源提示Ps的信息的最大保存。这便于文本和图像提示之间的对齐。第二,可学习参数的数目从K(dl + dv)显著减少到mn + K(dl+dv)mn,其中K表示Transformer层的数目。这种参数的减少不仅使模型更有效,而且还降低了过拟合的风险。

3.3 多任务提示学习框架

在多任务学习中,相似任务的联合训练可以产生互惠互利的结果。典型地,任务相似度可以通过评估任务之间的梯度冲突来量化。有鉴于此,我们首先涉及到将类似的任务分组在一起。共享的MmAP被分配给每个组,这促进了组内任务的相互学习和增强。然而,为了保持每个任务的独特特性,我们还为每个任务分配单独的MmAP。该单独的MmAP确保充分满足每项任务的独特特征和要求。图3描述了整个多任务提示调优框架图。

任务分组。现有的MTL工作(Fifty等人,2021)已经证明,梯度余弦相似性可以量化两个任务的相似性,即:两项任务从联合训练中获益的程度。因此,我们通过计算共享参数的梯度来评估两个任务的相似性,同时保持预训练的视觉语言模型冻结,如图3a所示。具体地,给定用于所有任务的全局共享MmAP Pglb,第i个任务和第j个任务之间的相似性可以被估计为以下点积:Pglb =(i + j)–(1)其中LT表示任务T的损失。我们假设当sim(Ti,Tj)> 0时,这表明两个任务表现出相互增益效应。此外,对于鲁棒估计,我们在全局共享MmAP的训练期间对相似性的多个“快照”进行平均。在高层次上,我们同时训练所有任务,在整个训练过程中评估成对任务相似性,并识别最大化总任务间相似性的任务组。

多任务提示学习。我们在我们提出的MmAP上开发了一个统一的多任务提示学习框架,如图3b所示。给定N个下游任务{Ti}N i=1,我们首先根据梯度相似性将它们划分为几个不相交的组。为了简洁起见,我们将G表示为由以下组成的任务组:|G|任务(1 ≤| G| ≤ N)。然后,我们为CLIP构造了一个组共享的MmAP,它包含K个Transformer层,包括源提示PG = {Pk G }K k=1,缩放矩阵MGl = {Mk Gl}K k=1和MGv = {Mk Gv}K k=1,分别用于语言和视觉分支。组共享的MmAP由组G内的所有任务累积更新,从而在类似任务之间实现互补益处。此外,对于组G中的每个任务,我们构建了用于学习独特任务特征的任务特定MmAP,包括用于语言和视觉分支的源提示PT = {Pk T}K k=1、缩放矩阵MTl = {Mk Tl}K k=1和MTv = {Mk Tv}K k=1。在训练组G中的一个任务T时,我们首先在两个编码器中生成第k层的文本和图像提示,然后通过组合类标记、生成的提示和来自前一层的文本/图像标记来重建输入标记。因此,文本和图像编码器中第k层的计算可以形式化地表示为

这里的[·,·]指的是连接操作。最后,通过优化以下损失来累积地更新组共享的MmAP:L(PG,MGl,MGv)= X T∈G LT(PG,MGl,MGv),(11),并且通过以下来训练任务特定的MmAP:L(PT,MTl,MTv)= LT(PT,MTl,MTv),(12)其中LT是任务T的交叉熵损失。

4 实验

4.1基准设置

数据集。根据之前的MTL工作(Shen等人,2021; Long等人,2017),我们考虑使用Office-Home(Venkateswara等人,2017)和MiniDomainNet(Zhou等人,2021)数据集来构建我们的基准。

(1)Office-Home包含来自四个任务的图像:艺术、剪贴画、产品和真实的世界。每个任务涵盖在办公室和家庭环境下收集的65个对象类别的图像。总共大约有15,500张图片。

(2)MiniDomainNet是DomainNet的一个子集,DomainNet是一个非常具有挑战性的多任务学习数据集。MiniDomainNet拥有140,000张图片,分布在126个类别中。它包含四个不同的任务:剪贴画,绘画,素描和真实的。

基于之前的研究(Shen et al. 2021; Zhou et al. 2022),我们从Office-Home中随机选择10%(每类6个镜头)和20%(每类12个镜头)的样本,以及从MiniDomainNet中随机选择1%(每类3个镜头)和2%(每类6个镜头)的样本进行训练。

基准线。我们将我们的方法与几个调优基线进行比较,包括:· Zero-shot使用手工制作的文本提示(“[class]的照片”)模板来进行Zero-shot预测。·单任务完全微调为每个任务更新单独的预训练模型,多任务完全微调为所有任务更新共享的预训练模型。·单模态快速调谐方法,包括CoOp和VPT。CoOp-MT和VPT-MT是多任务版本,使用来自所有任务的样本训练任务共享提示。此外,最近的工作MaPLe作为我们的基线之一。我们还构建了一个多任务版本,称为MapLe-MT。·其他参数有效的调整方法,包括CLIP-Adapter(Gao等人,2021),它学习视觉或语言分支上的新特征,以及BitFit(Zaken、Goldberg和Ravfogel,2022),它调整预训练模型的偏差参数。

实施详细数据。所有实验都是在NVIDIA V100 GPU上使用PyTorch工具包进行的,其中CLIP(ViT-B/16)被选为我们的默认模型。为了确保公平的比较,我们在所有参数高效调谐方法中保持一致的超参数设置。具体而言,我们使用16/4的批量大小,并针对Office-Home/MiniDomainNet训练5个时期。我们使用了SGD优化器,学习率为0.0035。

4.2实验结果

Office-Home。结果见表1。首先,我们观察到,我们的方法在不同的数据分割(10%或20%)上与多任务完全微调相当,而仅需要0.09%(0.13M对149.62M)的可训练参数。这代表了多任务图像识别的CLIP参数高效调整的重大突破。其次,本文方法的性能始终优于其他参数有效整定方法。与提示方法(即,通过对MAPLe-MT、CoOp-MT和VPTMT的实验,我们的方法显示出了显著的改进,突出了在调整CLIP时整合视觉和文本模态的必要性,并结合了小组共享知识和任务特定知识。

关于可训练参数的数量,我们的方法仅次于CoOp-MT,在准确性和可训练参数之间实现了最佳权衡。第三,我们还发现提示方法优于CLIPAdapter和BitFit,这表明将下游数据与CLIP对齐是一种更有效的方法。

MiniDomainNet迷你域名网。结果示于表2中。我们可以从Office-Home中得出一致的结论。我们的方法表现最好,在1%分割上达到84.9%,在2%分割上达到86.1%。然而,我们观察到全微调的性能不是很令人满意,比大多数参数有效的调整方法,这是由过拟合造成的。具体而言,MiniDomainNet的任务难度与Office-Home相比显著增加,同时,训练数据的数量有限。此外,BitFit方法表现出最差的性能。该方法仅使用少量数据就能更新CLIP的少量参数,严重削弱了CLIP原有的零炮能力。CoOp-MT、VPT-MT和MaPLe-MT的效果在1%分割时只能接近零击,但当训练数据达到2%时,CoOp-MT和MaPLe-MT分别超过零击0.9%和1.1%。因此,为了探索不同训练数据量下的性能,我们设置了相关实验,如消融研究中所详述。

4.3消融研究

在本节中,我们构建了各种消融实验来进一步分析我们提出的MmAP和多任务即时学习框架。同时,我们还针对不同的下行数据量设计了相关的实验。

MmAP的有效性。为了验证我们提出的MmAP的有效性,我们建立了相关的消融实验。“如图5a所示,用于多模式提示的直接方法是联合调整文本和视觉提示。另一个简单的解决方案涉及共享文本和视觉提示。然而,由于CLIP的文本编码器(dl = 512)和图像编码器(dv = 768)的尺寸不相等,因此它们不能被直接共享。因此,我们设计了MLP提示基线作为另一种比较方案,它采用两个MLP层来生成文本和视觉提示,如5 b所示。结果如图5c所示。在办公室-家庭的四项任务中,MLP基线与联合训练基线相比表现出0.5%的改善,证明了在文本提示和视觉提示之间建立联系的有效性。另外,我们观察到MmAP与MLP基线相比实现了0.54%的改善,这表明MmAP方法在通过克罗内克产品最大化文本和视觉提示之间的信息共享方面更有效。与此同时,MmAP可训练参数相对于MLP基线显著降低(0.13M vs. 3.96M).

Office-Home和miniDomainNet数据集上的MmAP消融研究。我们建立了两个基线:(a)联合训练所述文本和视觉提示,以及(B)利用两个MLP层来生成所述文本和视觉提示。

Office-Home和miniDomainNet数据集上的MmAP消融研究。我们建立了两个基线:(a)联合训练所述文本和视觉提示,以及(B)利用两个MLP层来生成所述文本和视觉提示。

多任务提示学习框架的有效性。在我们的多任务快速学习框架中,任务特定的MmAP和小组共享的MmAP是主要的组成部分。为了验证各个模块的重要性,我们在Office-Home上进行了相关的消融实验,结果如表3所示。为了验证任务分组策略的有效性,我们将随机分组作为比较基准。实证结果阐明,在我们的框架内的每个模块起着关键作用,累积贡献的上级性能所取得的多任务提示学习框架。与随机分组相比,在10%和20%的设置下,我们的任务分组性能分别提高了0.68%和0.85%。在10%和20%的设置下,我们的任务分组比一个组中的所有任务的性能分别提高了0.39%和0.41%。从另一个角度来看,任务特异性MmAP超过了CoOp和VPT(结果见表1),进一步证明了我们的MmAP的有效性。

多任务提示学习框架的消融研究。“随机”是指随机分组任务。

多任务提示学习框架的消融研究。“随机”是指随机分组任务。

不同的下游数据大小。我们将检查训练数据大小对Office-Home(四项任务)的影响。我们选择了每个类别1/3/6/12个镜头,并将我们的MmAP与CoOp-MT、VPT-MT和MapLe-MT进行了比较。在不同的训练数据尺度下,每项任务和方法的结果如图4所示。实验结果表明,该方法在不同数据尺度上的四个任务上均优于其他所有基线,验证了该方法的强泛化性。但是,我们观察到,在艺术和真实世界任务的1次拍摄设置中,所有方法的性能都不如零拍摄。这可能是由于1次拍摄太具体,无法作为整个任务的一般表示。当提供3个或更多个镜头用于训练时,由我们的方法引入的平均性能差距是实质性的。

5、结论

在这项工作中,我们提出了多模态对齐提示(MmAP),用于使CLIP适应下游任务,从而实现了可训练参数和性能之间的最佳权衡。同时,MmAP解决了以前单一模式提示方法的问题(例如,CoOp和VPT)破坏CLIP的模态对齐。在MmAP的基础上,设计了一个多任务提示学习框架,该框架不仅可以将相似的任务集中训练,增强任务的互补性,而且保留了每个任务的独立特征。与在有限的下游数据下对两个大型多任务学习数据集进行完全微调相比,我们的方法实现了显着的性能改进,同时仅利用了10.09%的可训练参数。

![[数据集][目标检测]无人机飞鸟检测数据集VOC+YOLO格式6647张2类别](https://i-blog.csdnimg.cn/direct/fd65f0dba85840809e73bcd4dd546bbf.png)