先看下java的内存模型

监控jvm工具:visualVM 摘录一下内容:

由c++开发的jvm,它巧妙地设计了java的设计理念——即万物皆对象。并设计了这些对象应该如何存储,如何调用,并通过不断迭代设计让对象的存储和回收,执行更加合理,下图是jvm的发展历程。

也许开发者未必精通jvm,但对jvm的深入了解可以对开发,排错,调优有非常大的帮助。这里给出最基本的 jvm 入门知识,也是你监控 jvm并期待通过分析jvm来排错调优所必要的基础知识:

- 堆(Heap):

堆是用于存储对象实例的内存区域。在堆中分配的对象包括通过 new 关键字创建的对象以及数组。

所有线程共享堆,但每个对象都有一个标识它的引用。 - 栈(Stack):

栈用于存储方法的局部变量、操作数栈、方法返回地址等。每个线程都有自己的栈。

每个方法在执行时都会创建一个栈帧,栈帧包含了该方法的局部变量表、操作数栈、动态链接、方法返回地址等信息。 - 程序计数器(Program Counter):

程序计数器是每个线程私有的,用于存储当前线程执行的字节码指令的地址或索引。

在多线程环境下,程序计数器用于记录每个线程执行的位置,确保线程切换后能够恢复到正确的执行位置。 - 本地方法栈(Native Method Stack):

本地方法栈类似于栈,但用于执行本地方法(非 Java 语言编写的方法)。

本地方法栈的实现和栈类似,但用于执行本地代码。 - 元空间(Metaspace):

元空间是 JDK 8+ 版本中引入的(替代原来的方法区),使用本机内存存储类的元信息,包括类的结构信息、静态变量

、方法信息等。

查看hive日志

日志:hive-server2.out,注意不是:hiveserver2.log

2024-09-10 20:21:35,765 HiveServer2-Background-Pool: Thread-13637 ERROR Unable to create Appender of type HushableMutableRandomAccess

java.lang.OutOfMemoryError: Java heap space

Dumping heap to /var/de_log/hive/java_pid36821.hprof ...

Heap dump file created [18346979563 bytes in 27.401 secs]

Terminating due to java.lang.OutOfMemoryError: Java heap space

可以看到发生了OOM的问题OutOfMemoryError,堆heap内存溢出了。

获取hive内存溢出时候的内存快照hprof

hiveserver2日志文件夹内执行:grep OutOfMemory ./hiveserver2-gc.log*

得到如下内容:

./hiveserver2-gc.log.0:CommandLine flags: -XX:+ExitOnOutOfMemoryError -XX:+HeapDumpOnOutOfMemoryError -XX:HeapDumpPath=/xxx/hive/

参数具体意义参考:-XX:+HeapDumpOnOutOfMemoryError

根据/xxx/hive/和发生hiveserver2 terminate的时间,找到jvm导出的hprof文件,hprof文件大约有17GB。此文件就是发生OutOfMemoryError时刻的内存快照,很大也压缩不了。

ls -lh

-rw------- 1 hive hadoop 17G Sep 9 23:06 java_pid24619.hprof

使用工具分析hprof文件

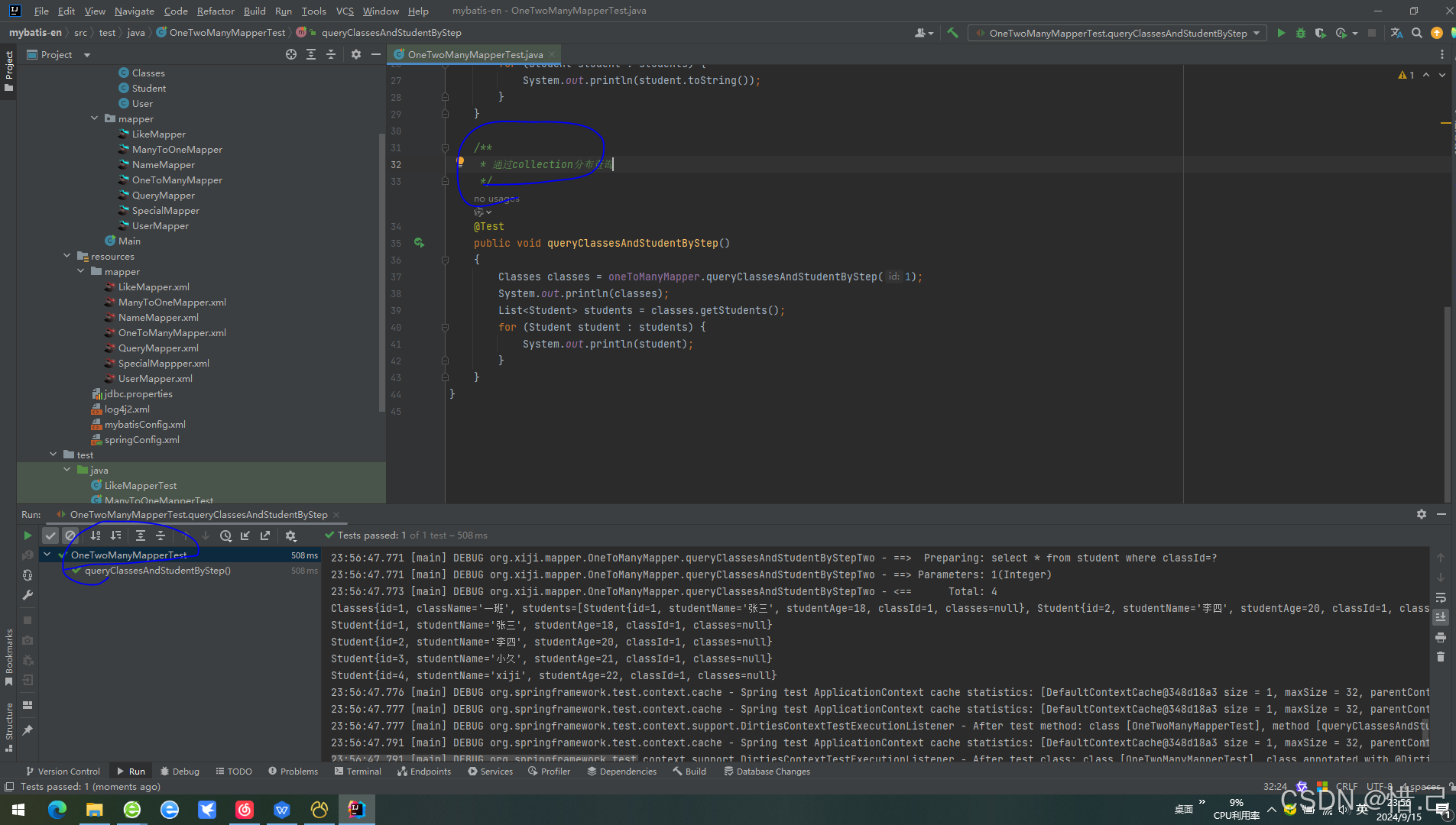

工具一VisualVM:

此工具是jdk自带的,一般在JAVA_HOME/bin/jvisualvm.exe在win下直接运行就可以了。

载入hprof文件在 就会的都如下信息:

就会的都如下信息:

基本信息:

生成的日期: Tue Sep 10 20:30:14 CST 2024

文件: D:\java_pid123345.hprof\java_pid12345.hprof

文件大小: 17,497 MB

字节总数: 18,231,897,382

类总数: 23,546

实例总数: 11,253,335

类加载器: 1,354

垃圾回收根节点: 11,647

等待结束的暂挂对象数: 0

在出现 OutOfMemoryError 异常错误时进行了堆转储

导致 OutOfMemoryError 异常错误的线程: HiveServer2-Background-Pool: Thread-12410

点击 HiveServer2-Background-Pool: Thread-12410超链接就是展示实际进程的调用栈:

"HiveServer2-Background-Pool: Thread-12410" prio=5 tid=12410 RUNNABLE

at java.lang.OutOfMemoryError.<init>(OutOfMemoryError.java:48)

at org.apache.thrift.protocol.TBinaryProtocol.readStringBody(TBinaryProtocol.java:379)

at org.apache.thrift.protocol.TBinaryProtocol.readMessageBegin(TBinaryProtocol.java:230)

at org.apache.thrift.TServiceClient.receiveBase(TServiceClient.java:77)

at org.apache.hadoop.hive.metastore.api.ThriftHiveMetastore$Client.recv_get_database(ThriftHiveMetastore.java:770)

Local Variable: org.apache.hadoop.hive.metastore.api.ThriftHiveMetastore$get_database_result#166

at org.apache.hadoop.hive.metastore.api.ThriftHiveMetastore$Client.get_database(ThriftHiveMetastore.java:757)

at org.apache.hadoop.hive.metastore.HiveMetaStoreClient.getDatabase(HiveMetaStoreClient.java:1523)

从HiveMetaStoreClient.getDatabase可以发现是hms读取database信息造成的。

工具二mat:

内存溢出怎么排查?分析思路大概都是这样的吧

官网地址:

mat工具地址

注意下载时候选择版本,mat和jdk有一定搭配关系。

(1)可以在overview  下,点击

下,点击Leak Suspects即可执行可疑分析。

在Problem Suspect项目下是分析的可疑项,

The thread org.apache.hive.service.server.ThreadWithGarbageCleanup @ 0x2d79ff8d8 HiveServer2-Background-Pool: Thread-13828 keeps local variables with total size 1,936,085,120 (10.77%) bytes.

The memory is accumulated in one instance of "byte[]" loaded by "<system class loader>".

The stacktrace of this Thread is available. See stacktrace.

Keywords

byte[]

Details »

可以看到是org.apache.hive.service.server.ThreadWithGarbageCleanup @ 0x2d79ff8d8 这个进程出现问题了。

(2)查看Histogram 列表项目:

列表项目:

Class Name| Objects | Shallow Heap | Retained Heap

---------------------------------------------------------

byte[] | 130,780 | 17,442,187,032 | >= 17,442,187,032

---------------------------------------------------------

可以根据Retained Heap或者Shallow Heap看到排名第一的是byte[]大约有,17,442,187,032/1024/1024/1024=16.24GB。 17442187032/18346979563=95%,byte[]占到线程内存的比例很高。

(3)查看thread overview  根据thread名称找到以

根据thread名称找到以0x2d79ff8d8结尾的thread。

先看最上边的内容,这和java日志调用栈展示的顺序是一致的,最后执行的在最上展示,可以看到java.io.BufferedInputStream.read读取进本地1,935,998,992/1024/1024/1024=1.8GB内容。

Object / Stack Frame |Name| Shallow Heap | Retained Heap |Context Class Loader|Is Daemon

----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

at java.io.BufferedInputStream.read([BII)I (BufferedInputStream.java:336) | | | | |

|- <local> java.io.BufferedInputStream @ 0x2c3ebe9b0 Busy Monitor | | 40 | 40 | |

|- <local> byte[1935998976] @ 0x697000000 ...................................................................................................................................................................................................................................................................| | 1,935,998,992 | 1,935,998,992 | |

'- Total: 2 entries | | | | |

----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

再看更远的内容,可见ThriftHiveMetastore$Client.recv_get_database()可以知道读取此内容是由于hive metastore尝试获取database信息引发的。如果是自己写的程序,再往下找一般就能找到是自己的那个类的哪行代码触发的了。

Object / Stack Frame |Name | Shallow Heap | Retained Heap |Context Class Loader |Is Daemon

----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

org.apache.hive.service.server.ThreadWithGarbageCleanup @ 0x2d79ff8d8 |HiveServer2-Background-Pool: Thread-13828| 128 | 1,936,085,120 |org.apache.hadoop.hive.ql.exec.UDFClassLoader @ 0x2d397cbc0|false

|- at java.io.BufferedInputStream.read([BII)I (BufferedInputStream.java:336) | | | | |

|- at org.apache.thrift.transport.TIOStreamTransport.read([BII)I (TIOStreamTransport.java:127) | | | | |

|- at org.apache.thrift.transport.TTransport.readAll([BII)I (TTransport.java:86) | | | | |

|- at org.apache.thrift.transport.TSaslTransport.readFrame()V (TSaslTransport.java:458) | | | | |

|- at org.apache.thrift.transport.TSaslTransport.read([BII)I (TSaslTransport.java:433) | | | | |

|- at org.apache.thrift.transport.TSaslClientTransport.read([BII)I (TSaslClientTransport.java:37) | | | | |

|- at org.apache.thrift.transport.TTransport.readAll([BII)I (TTransport.java:86) | | | | |

|- at org.apache.hadoop.hive.thrift.TFilterTransport.readAll([BII)I (TFilterTransport.java:62) | | | | |

|- at org.apache.thrift.protocol.TBinaryProtocol.readAll([BII)I (TBinaryProtocol.java:429) | | | | |

|- at org.apache.thrift.protocol.TBinaryProtocol.readI32()I (TBinaryProtocol.java:318) | | | | |

|- at org.apache.thrift.protocol.TBinaryProtocol.readMessageBegin()Lorg/apache/thrift/protocol/TMessage; (TBinaryProtocol.java:219) | | | | |

|- at org.apache.thrift.TServiceClient.receiveBase(Lorg/apache/thrift/TBase;Ljava/lang/String;)V (TServiceClient.java:77) | | | | |

|- at org.apache.hadoop.hive.metastore.api.ThriftHiveMetastore$Client.recv_get_database()Lorg/apache/hadoop/hive/metastore/api/Database; (ThriftHiveMetastore.java:770)| | | | |

----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

问题根因

程序发生oom的问题找到了,自己hive插件程序(随hiveserver2的sql任务启动)尝试通过hms读取database信息,但这个信息非常大,每个hive sql任务都会触发自己hive插件从而造成多SQL同时执行的时候内存急剧膨胀,发生oom问题。