当电信网络用上大模型,会带来怎样的体验?

过去,网络出现问题时,运维人员需要依赖经验反复排查,找到“病根”后再“对症下药”。但在大模型的加持下,问题的解决方式发生了颠覆性的改变。

如今,当网络出现问题,大模型可以自动找出“病根”,并将判断结果呈现给运维人员。如果结果与运维人员的诊断一致,那么就可以迅速解决问题。

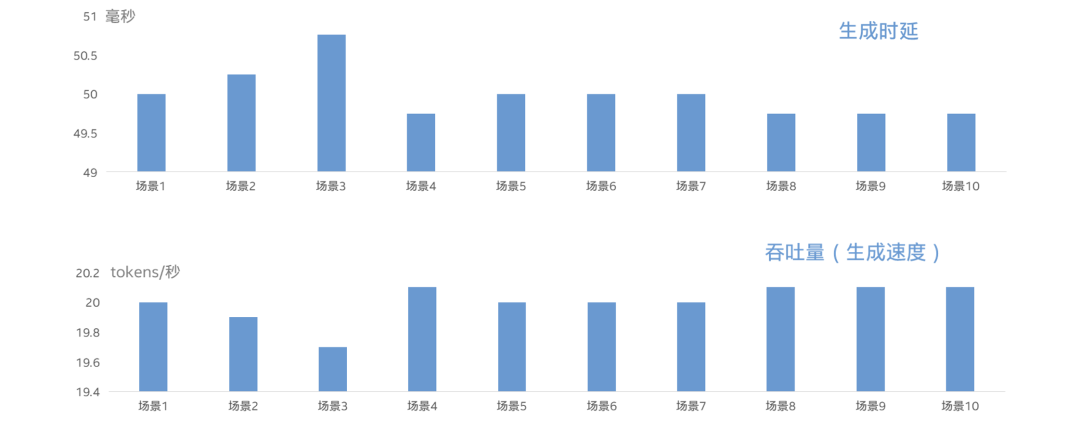

即便诊断有所偏差或描述不够详细,运维人员也只需提出问题,大模型会像一位领域专家一样,利用其丰富的知识快速提供详细解答。业界认为,文本生成延时小于100毫秒是较为舒适的阈值,而这个大模型的表现更佳:首字符延时不到1秒,生成延时仅约50毫秒。面对再复杂的问题,运维人员仿佛有了一位“高人”在旁指导。

值得一提的是,这个网络大模型不仅是一个现象级产品,它已经投入实战。据悉,某电信运营商已在全国31个省份推广应用,每日调用量高达10万次!在刚刚落幕的第二届“华彩杯”算力大赛·智能计算专题赛中,该模型还斩获了一等奖,得到了官方认证。

此外,白皮书《中国电信携英特尔积极探索基于至强® CPU 平台的网络大模型推理算力方案》在中国通信标准化协会CCSA TC610和欧洲电信标准化协会ENI的云网运营自智与网络大模型技术研讨会上正式发布。接下来,我们将深入了解这个网络大模型的神奇之处。

当大模型“上岗”电信网络

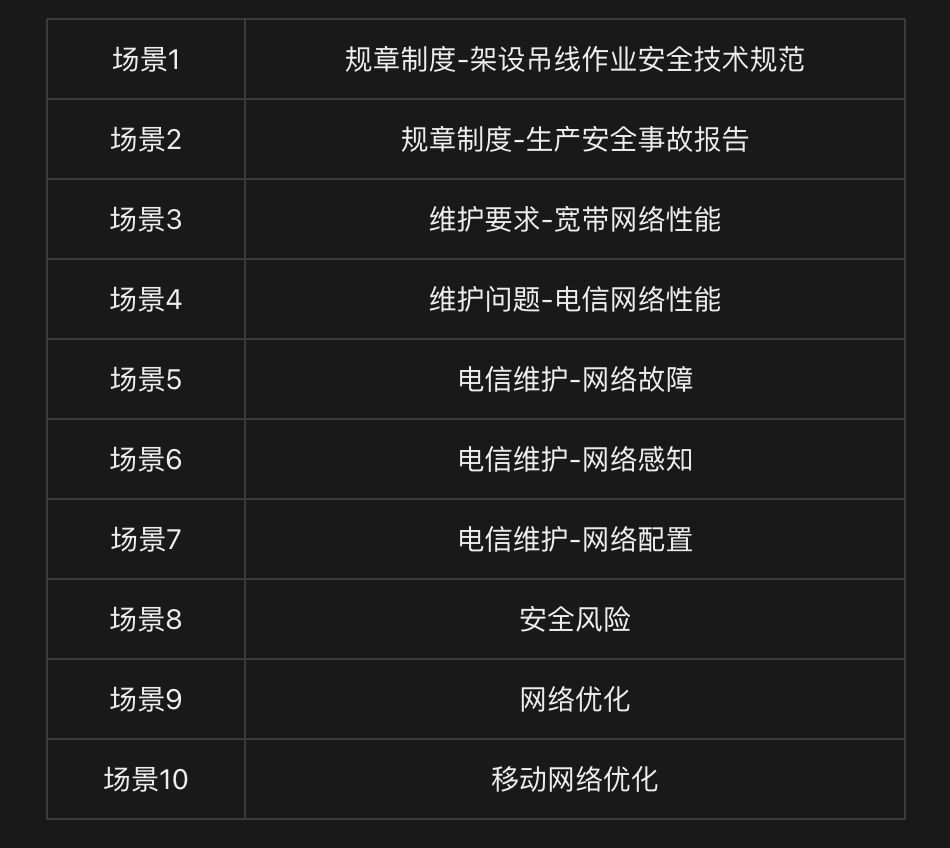

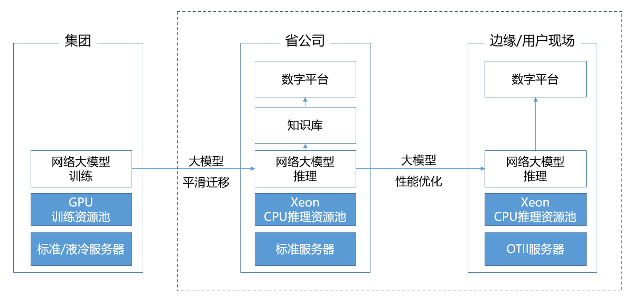

目前,该电信运营商的各级运维人员都已接入网络大模型。运维方式也发生了实质性改变:专业知识问答、信息筛选、信息总结等工作,都可以交给大模型处理。

不仅如此,大模型在网络规划方面也发挥着重要作用,其推理结果涵盖网络建设、维护、优化和运营决策等场景。基层运维人员可以通过这些结果,实现精准的规则理解与分析,自动核查规则。同时,网络大模型提供的专业知识,也能帮助电信行业进行方案分析与生成。

那么,这与市面上的其他大模型问答产品有何区别?关键在于它的高度垂直性。作为行业“专家”,网络大模型能够深入理解运维人员的需求,生成更精准、个性化的答案。

应对边缘端需求,速度是关键

电信运维场景多处于边缘端,对数据的即时响应速度要求很高。若大模型生成答案需要几分钟,那么对于运营商的网络故障修复来说,将变得拖沓无效。

为此,该电信运营商采用了符合OTII标准的边缘服务器。这类服务器对部署环境要求高,有时甚至需在恶劣环境中运行。这意味着,边缘服务器必须在功耗、体积、耐用性等方面满足特定要求,能够在极端条件下保持正常运行。该运营商采用的OTII服务器可以在55℃以下高温工作,支持IP65,具备EMC ClassB设计和9级地震烈度,且机身小巧,适应挂墙安装等多种需求。

边缘服务器的应用保障了数据的即时交互与响应速度,使首字符延时不到1秒,生成延时约50毫秒,满足了大模型推理的需求。至今,网络大模型已覆盖网络“规、建、维、优、营”全生命周期,围绕知识问答、辅助助手、智能体三个维度,打造了12个AI助手。

网络大模型的性能表现

据悉,该网络大模型在日常应用中,问答准确率达到85%,方案生成可用率90%,故障处置效率提升30%,高危指令稽核效率提升50%。由此可见,网络大模型已成为合格且可靠的AI助手。

CPU的选择:推理的“马达”

在网络大模型中,模型推理是关键环节,直接决定了故障定位和方案生成的速度与准确性。这正是CPU的“主场”。电信行业历来有大量的CPU存量,因此无需引入全新架构,继续使用成熟的CPU方案有多重优势:

-

降低成本:该电信运营商作为全球规模最大的通信运营商之一,部署了数百万台X86服务器。这些服务器仍在使用周期内,可以通过软件升级快速实现大模型的部署与应用,降低前期投入。

-

确保稳定性:电信业务覆盖广泛,连续性要求极高。X86平台的英特尔CPU架构经过几十年的验证,具备高度的安全性和稳定性,符合电信网络对系统可靠性的需求。

-

降低学习成本:作为传统ICT企业,该运营商拥有庞大的IT技术团队,他们对英特尔CPU的微架构、指令集、调优工具等有深入了解。继续使用CPU部署大模型,无需额外学习和培训,降低了技术应用门槛。

第五代英特尔® 至强® CPU的应用

在具体选型中,“网络”大模型方案使用第五代英特尔® 至强® 可扩展处理器作为算力核心,来应对高强度、高并发的推理需求。该处理器拥有更多核心、更强单核性能和更大三级缓存,尤其是LLC容量的提升,使大多数模型参数直接驻留其中,显著提升推理速度。

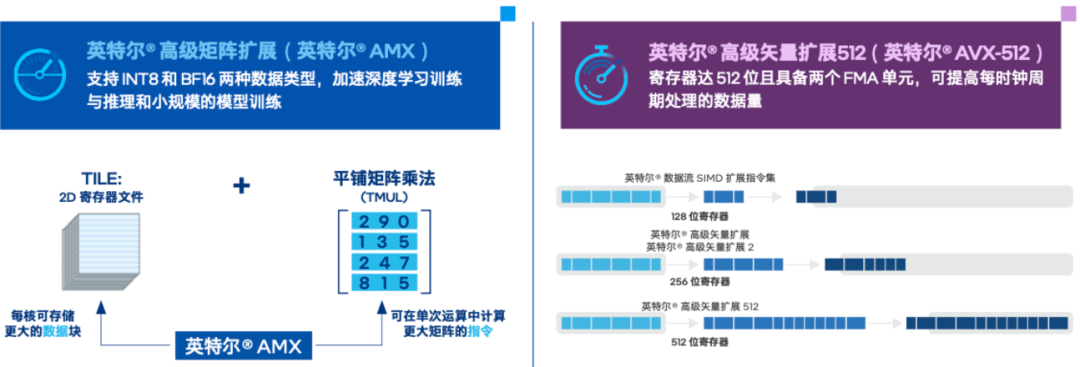

第五代至强® 还内置了专用AI加速引擎,如英特尔® AMX(高级矩阵扩展),通过创新的矩阵乘法方式提升运算效率,支持INT8、BF16等低精度数据类型,提高指令执行效率。

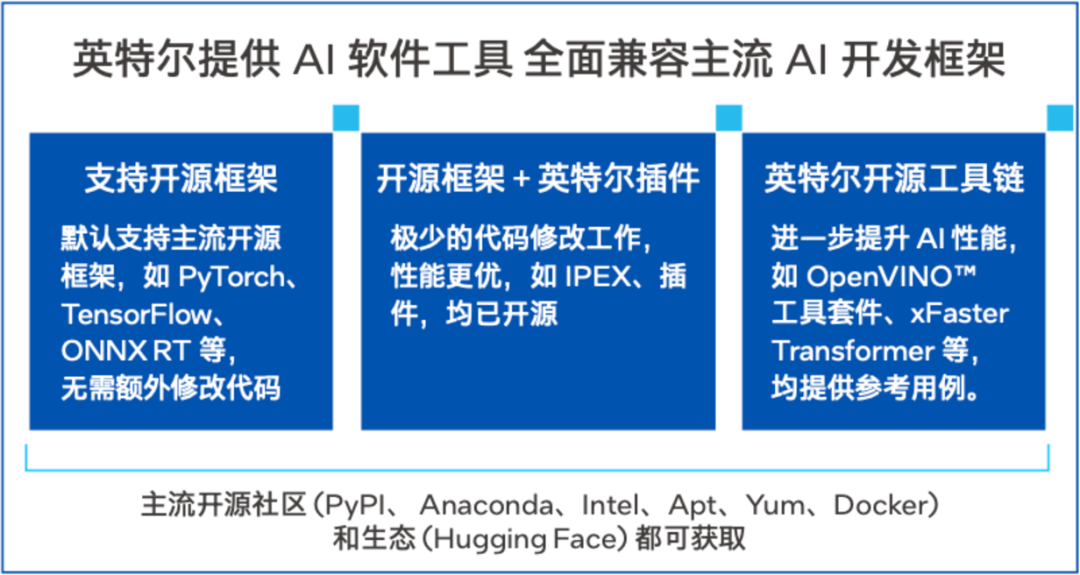

软件工具和优化

方案还引入了一系列英特尔AI工具,如xFastTransformer(xFT)优化框架,支持多种数据类型和主流大模型,实现从GPU到CPU的无缝迁移。第五代至强® 的能效优势也显著降低了运营成本,能耗较上一代提升高达34%。

边缘服务器的高要求

网络大模型需要部署在生产一线,有时甚至在极端环境下运行,对服务器要求极高。该运营商选用了符合OTII标准的边缘服务器,满足电信边缘场景对开放性、可扩展性的要求,在恶劣环境中保持稳定运行。

CPU在AI推理中的潜力

这次实践表明,选择CPU进行网络大模型推理部署,经过大型企业验证,不仅满足时延、吞吐、功耗等业务需求,推理成本也大幅下降。该方案在2024华彩杯中取得佳绩,为大模型应用树立了标杆。

未来,大模型将深入更多行业,需要在性能、功耗、成本、易用性等方面实现平衡。CPU在AI推理加速上仍然大有可为。

国内直接使用ChatGPT4o:

谷歌浏览器直接使用:https://www.nezhasoft.cn

-

无需魔法,同时支持手机、电脑

-

个人独享

-

ChatGPT4o mini永久免费

-

支持Copilot、DALLE AI绘画、上传文件等

长按识别下方二维码,备注:南阳,发给你

![[C语言]第九节 函数一基础知识到高级技巧的全景探索](https://i-blog.csdnimg.cn/direct/71d6f3b1f8304714b7d0288680449947.png)