ollama语言大模型部署使用

- 前言

- 一、下载安装maxkb

- 1、下载解压赋权

- 2、安装

- 二、安装ollama

- docker运行

- 三、无需获取api_key

- maxkb安装ollama模型

- 对,就是这,你选好基础模型后,只需要给他地址,添加完成后自行调用ollama安装你选择好的模型

- 添加应用,保存并发布,返回应用

- 应用信息复制访问

- 相当有趣的功能:嵌入第三方

前言

先说下为什么选择maxkb对接ollama

1、个人观点用着舒服,maxkb,ollama docker部署完成后,在maxkb上部署应用模型只需要选择ai模型,ollama会自行安装

2、一键话部署,方便开箱即用,提供嵌入第三方

3、有官方文档支持。

4、支持多模型,支持直接上传文档 / 自动爬取在线文档,支持文本自动拆分、向量化和 RAG(检索增强生成),智能问答交互体验好。

5、灵活编排

##1panel也支持maxkb的部署,目前应该是最快的,但是我没选。。。。选了个离线包单独部署,嫌麻烦的可以直接来个企业版,有人帮你搞。

- maxkb官方使用手册

- maxkb官方演示视频

- maxkb官方论坛求助

一、下载安装maxkb

版本下载地址

1、下载解压赋权

##上传本地服务器解压、切换目录后授权

[root@ubuntu maxkb-v1.4.1-offline]# chmod +x ./*.sh

[root@ubuntu maxkb-v1.4.1-offline]# ll

total 40

drwxrwxr-x. 4 root root 32 May 5 2023 docker

drwxr-xr-x. 2 root root 33 Aug 8 14:24 images

-rw-r--r--. 1 root root 442 Aug 8 14:22 install.conf

-rw-r--r--. 1 root root 9350 Aug 16 16:44 install.log

-rwxr-xr-x. 1 root root 6734 Aug 8 14:22 install.sh

-rw-r--r--. 1 root root 7030 Aug 16 16:39 kbctl

drwxr-xr-x. 4 root root 93 Aug 8 14:28 maxkb

-rw-r--r--. 1 root root 11 Aug 8 14:22 README.md

-rwxr-xr-x. 1 root root 984 Aug 8 14:22 uninstall.sh

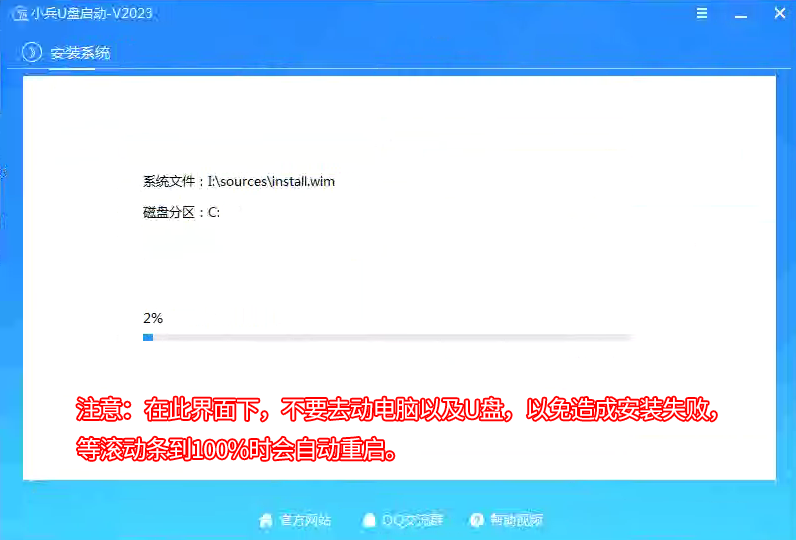

2、安装

- 飞致云的所有服务安装都会帮你初始化docker环境,有个系统直接安装就行。

##1、直接运行install安装

root@ubuntu:/u01/maxkb-v1.4.1-offline# ./install.sh

##2、docker部署,需要代理下载镜像,有丢丢大,2G左右

docker run -d --name=maxkb -p 8080:8080 -v /u01/maxkb:/var/lib/postgresql/data cr2.fit2cloud.com/1panel/maxkb

# 用户名: admin

# 密码: MaxKB@123..

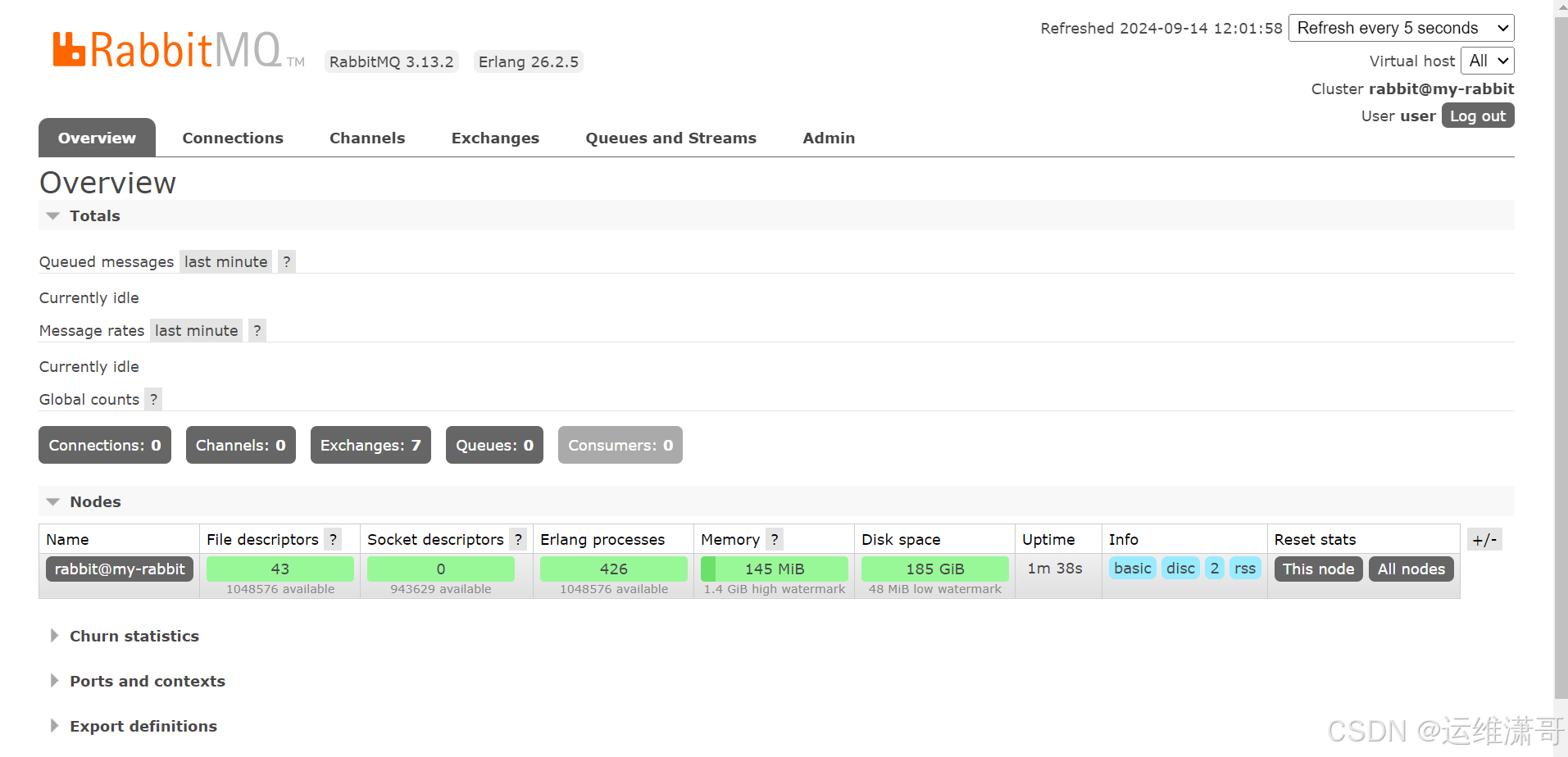

二、安装ollama

docker运行

大佬文章

##docker安装

dockert pull ollama/ollama

##到这步就可以了。然后转maxkb web界面选择ollama ai模型,他会帮你安装

docker run -d -v /u01/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

##进入容器并运行大模型

docker exec -it ollama /bin/bash

##下载并运行大模型

ollama run llama3.1:70b

##列出所有模型

ollama list

##单独下载大模型

ollama pull llama3.1:70b

具体模型

三、无需获取api_key

maxkb安装ollama模型

对,就是这,你选好基础模型后,只需要给他地址,添加完成后自行调用ollama安装你选择好的模型

添加应用,保存并发布,返回应用

应用信息复制访问

相当有趣的功能:嵌入第三方