随着LLM等技术的快速发展,进一步的抽象和泛化问题亦被看作是未来AI甚至AGI发展的关键。

然而鉴于当前不论是LLM下的自回归AR条件预测Gen方法还是CV领域的diffusion扩散Gen方法,甚至于传统DNN的无监督学习模式,在所涉及的更多通用或领域场景下的数据、模型与训练过程中,我们仍困惑以致无法定向掌握于对模型的泛化性以及其所延展出的抽象推理能力背后的机制或原理,并局限于探索进一步完备的学习范式和开发出更强大的模型。

最近无意间翻到一篇来自牛津大学的关于探索AI跨领域泛化性迁移的研究:

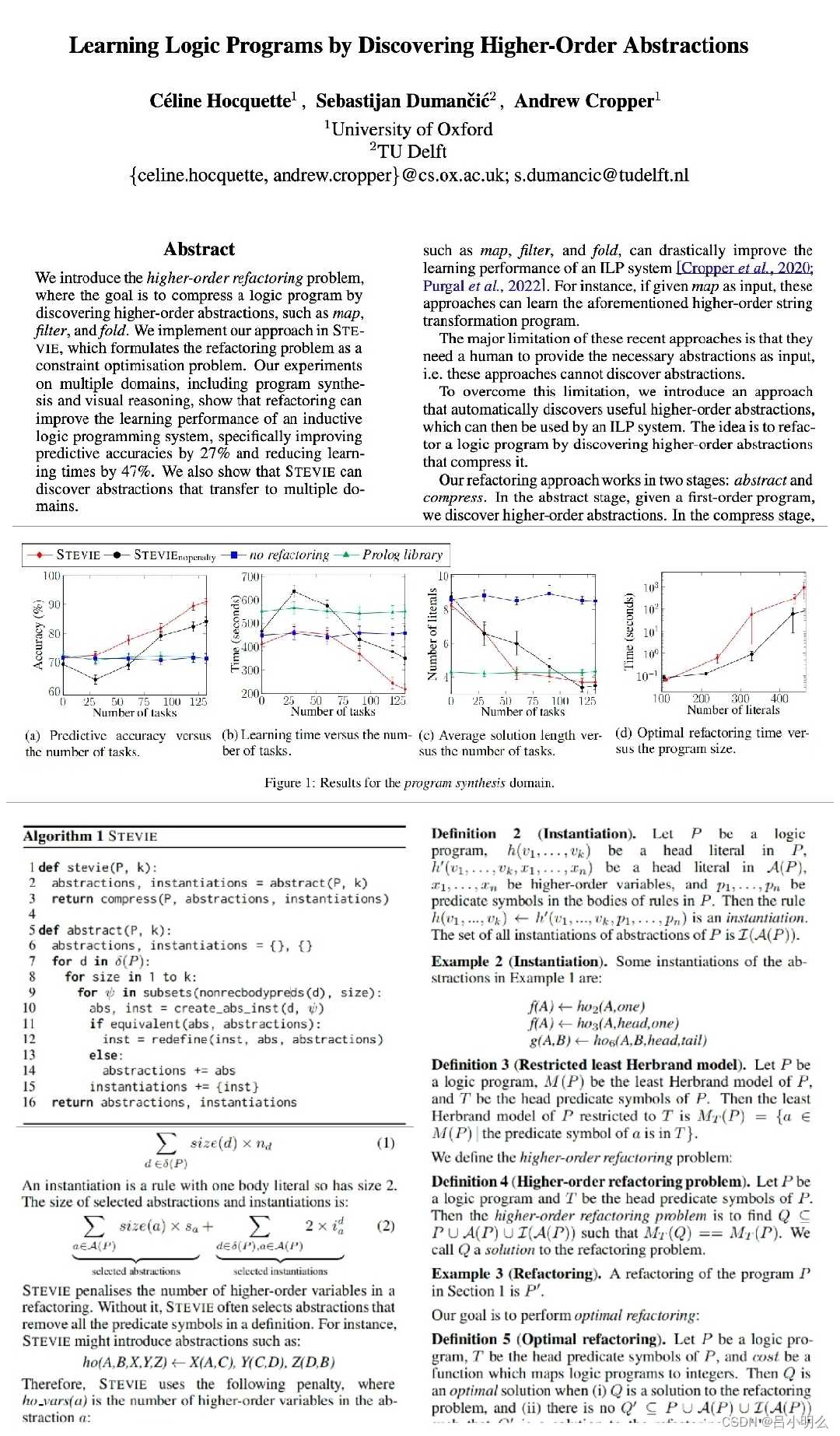

为了解决当前这一局限性,文中在IPL(Inductive Logic Programming)形式化系统中尝试了一种新方法,该方法被训练为自动发现高阶抽象概念以提高机器学习算法的泛化学习性能,如在程序合成领域自助发现抽象map、filter和fold,并在国际象棋领域使用它们。

文中基于近期在ILP中的其它研究基础和局限 - 使用用户所提供的高阶抽象概念,如map、filter和fold,虽可大幅提高ILP系统的性能,但其主要限制是它们仍需要人类提供必要的抽象作为输入,即无法自动探索挖掘潜在的抽象内涵。

为了克服这个限制,引入了一种自动发现有用高阶抽象概念的方法,通过发现压缩高阶抽象来重构逻辑程序,这些抽象概念经迁移可以被ILP系统使用。

重构的方法分为两个阶段,抽象和压缩:

在抽象阶段,给定一个一阶程序,以发现高阶抽象;

在压缩阶段,探索一组可以压缩一阶程序的抽象子集;

总结一下其中的创新思路:

i. 发现高阶抽象以重构逻辑程序的想法;

ii. 将这个重构问题编码为COP;

III. 展示发现的抽象在不同领域之间的转移;

此外,由于这个想法连接了 AI 的许多领域,包括机器学习、程序合成和约束优化,甚至文中开头我们所提及的当下LLM快速发展所带来的一系列泛化性及迁移问题。

甚至于,我在前几期笔记中与大家分享与阐释的有关LLM范式在与RL范式融合的过程中所遇到的诸多挑战,如:

① 如何有效在跨任务领域(形式化&真实世界)间构建有效鉴别和迁移泛化能力的训练范式?

② 上述跨领域泛化能力迁移是可行且完备的吗?

③ 以及在构建训练任务、设计目标函数与反馈机制时如何考量?

希望这项研究能为深入一线研究AI以及对尝试对模型泛化机理和复杂推理有待深入研究的研究者带来一些帮助。