版权声明

- 本文原创作者:谷哥的小弟

- 作者博客地址:http://blog.csdn.net/lfdfhl

1. 强化学习概述

1.1 定义与核心概念

强化学习是一种目标导向的机器学习方法,它使智能体能够在环境中通过试错学习最优行为策略。这种学习过程涉及到智能体与环境之间的交互,智能体根据当前状态选择动作,并从环境中获得奖励或惩罚,以此来调整自己的行为。

- 状态(State):智能体所处的环境状态,是决策的依据。

- 动作(Action):智能体在给定状态下所采取的行动。

- 奖励(Reward):智能体完成动作后从环境中获得的反馈,用于评估动作的好坏。

- 策略(Policy):从状态到动作的映射,表示智能体在特定状态下应采取的动作。

- 值函数(Value Function):预测采取某个策略后获得的累积奖励。

- 模型(Model):智能体对环境的理解,能够预测环境如何根据状态和动作变化。

1.2 强化学习与传统机器学习的区别

强化学习与传统的监督学习或无监督学习有显著的不同点:

- 学习方式:强化学习侧重于通过与环境的交互来学习行为策略,而传统机器学习通常依赖于大量的标记数据进行模式识别或分类。

- 目标导向:强化学习的目标是最大化长期累积奖励,而传统机器学习可能更侧重于预测准确性或最小化误差。

- 延迟反馈:强化学习中的奖励可能是延迟的,需要智能体理解长期行为的后果;传统机器学习通常在每次迭代后立即获得反馈。

- 探索与利用:强化学习需要平衡探索新策略与利用已知信息的矛盾,而传统机器学习通常不需要考虑这一问题。

- 动态环境:强化学习适用于动态变化的环境,智能体需要不断适应环境变化;传统机器学习可能在环境变化时需要重新训练数据集。

强化学习由于其独特的学习机制,在需要复杂决策和长期规划的场景中显示出巨大的潜力,如自动驾驶、游戏AI、机器人控制等领域。

2. 强化学习基本原理

2.1 智能体与环境的交互模型

强化学习的核心是智能体(Agent)与环境(Environment)之间的交互。智能体在环境中通过执行动作(Action)来改变环境状态,并从环境中接收反馈,即奖励(Reward)。这个过程可以被描述为一个循环:

- 观察:智能体观察当前环境的状态。

- 决策:基于观察到的状态,智能体选择一个动作。

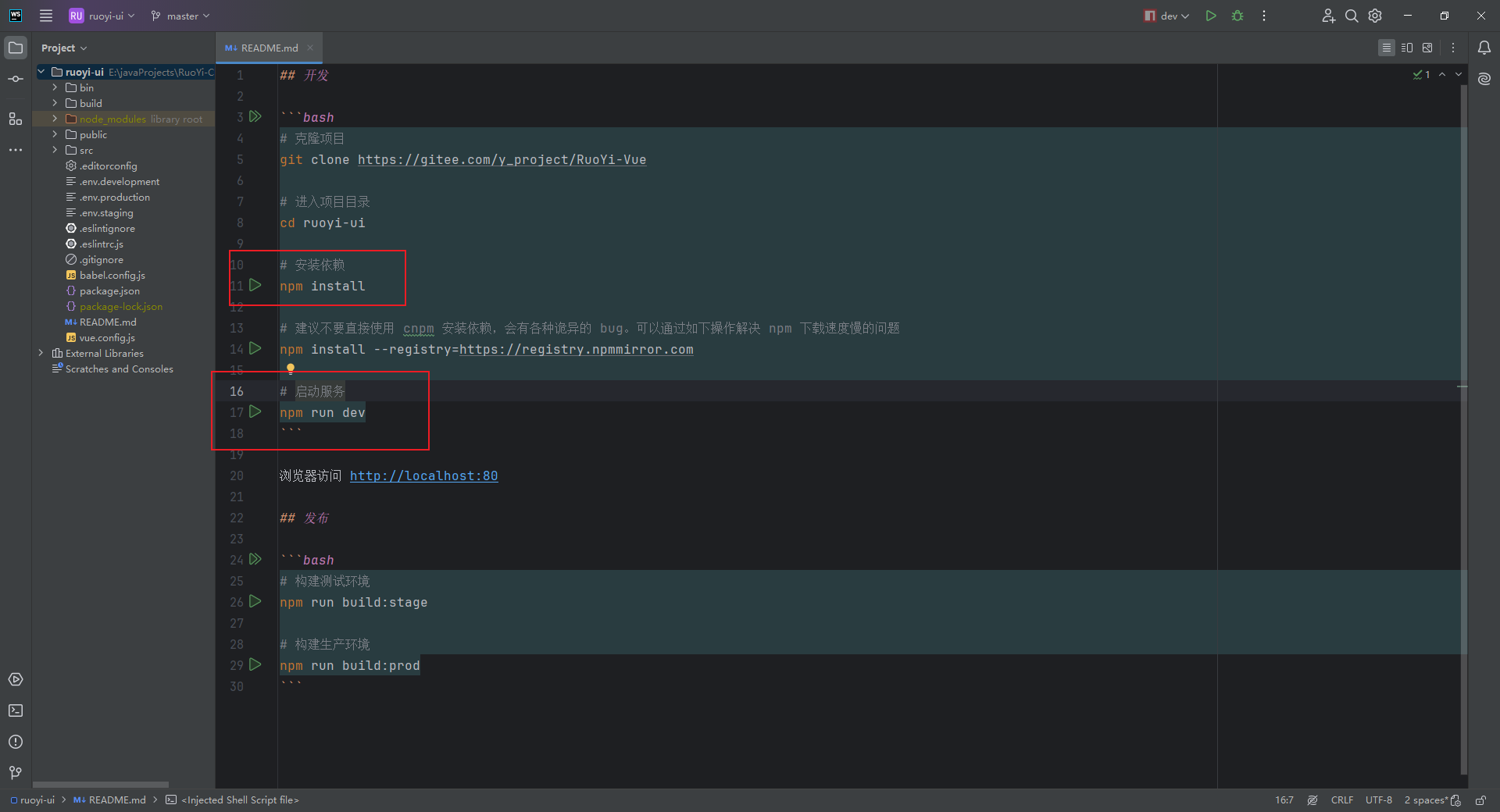

- 执行

![[C高手编程] static与extern: 作用域、可见性与存储类全面解析](https://i-blog.csdnimg.cn/direct/79539f9f2f294f7f8e8dbc0a96c6dc24.png#pic_center)