一、多云架构与大模型训练的融合

(一)多云架构的优势与挑战

多云架构为大模型训练带来了诸多优势。首先,资源灵活性显著提高,不同的云平台可以提供不同类型的计算资源和存储服务,满足大模型训练在不同阶段的需求。例如,某些云平台可能在 GPU 计算资源上具有优势,而另一些则在存储成本或性能上表现出色,企业可以根据实际情况进行选择和组合。其次,扩展性得以增强,当大模型的规模不断扩大时,单一云平台可能无法满足资源需求,而多云架构可以轻松实现资源的横向扩展。

然而,多云架构也面临着一些技术挑战。其中之一是数据管理的复杂性,不同云平台的数据存储格式和访问方式可能存在差异,需要进行统一的数据管理和协调。此外,网络连接的稳定性也是一个关键问题,跨云的数据传输可能会受到网络延迟和带宽限制的影响,影响大模型训练的效率。

(二)大模型训练对存储的需求

大模型训练在数据读写、性能、成本等方面对存储有着特殊要求。在数据读写方面,大模型训练需要频繁地读取大量的训练数据,并将中间结果和最终模型保存到存储中,因此对存储的读写带宽和 IOPS 要求较高。例如,GPT-3 模型的训练数据量从 GPT 的 5GB 增长到了 570GB,这要求存储系统必须具备足够的容量来存储和管理这些大规模数据集。

在性能方面,大模型训练对存储的响应时间要求较低延迟,以确保训练过程的高效进行。同时,存储系统需要支持高并发的数据访问,以满足多个计算节点同时进行训练的需求。

在成本方面,大模型训练通常需要大量的存储资源,因此存储成本成为一个重要的考虑因素。企业需要在保证性能的前提下,选择成本效益高的存储解决方案,例如对象存储等。据介绍,归档数据通常不需要频繁访问,因此对象存储是一种适合大容量、低成本归档的解决方案。

二、JuiceFS 在多云架构中的应用

(一)JuiceFS 的特性与优势

JuiceFS 具有诸多显著的功能特点和优势,为多云架构下的大模型训练存储稳定性提供了有力保障。首先,它对 POSIX 协议的支持至关重要。在模型训练过程中,尤其是使用笔记本进行新模型探索时,常常需要对大文件进行读写操作,如读取样本数据和写入 checkpoint。此时,各种开源训练引擎或框架通常直接从文件系统读写数据,而 JuiceFS 支持 POSIX 协议,使得程序可以通过标准 Linux IO 接口进行文件操作。这不仅保证了所有容器中文件内容的一致性,即使在弱一致性条件下也能满足随机写的需求,对于大模型训练的应用场景至关重要。

JuiceFS 的可观测性也非常强。社区版已包括若干关键的全局统计指标,如吞吐量、I/O 操作和延迟等。企业版提供了更细致的监控指标,能够对每个缓存服务和客户端的性能指标进行详细跟踪,这对于故障排除和性能监控尤其有价值。例如,知乎在使用 JuiceFS 时,通过其丰富的内部指标监控看板,能够便捷地查看系统性能,及时发现并解决问题。

此外,JuiceFS 还具有良好的扩展性。对于大型模型未来规模的扩大或其他潜在变化,JuiceFS 能够轻松应对。它支持多种对象存储,无论是公共云服务还是自托管解决方案,如 Ceph 和 MinIO 等,都可以满足不同规模的存储需求。同时,JuiceFS 的元数据引擎支持多种常见的数据库,包括 Redis、TiKV 和 MySQL 等,用户可以根据自己的需求进行选择,进一步提高了系统的灵活性和可扩展性。

(二)部署方式与架构设计

在多云环境下,JuiceFS 的部署方式和存储架构设计具有独特的优势。JuiceFS 展现出了领先的云原生部署优势,在选型时,其实现相当不错。目前,知乎管理四个不同的云环境,每个都有自己的 Kubernetes 集群。知乎的数据分为两部分:一部分存储在 HDFS 中;另一部分则由 JuiceFS 的元数据驱动和 S3 共同构成 JuiceFS 集群。不同的集群能够通过网络访问 JuiceFS 和 HDFS。为了优化访问速度,知乎将 JuiceFS 和 HDFS 部署在同一云环境中,实现内网访问,而其他云环境则通过专线访问。

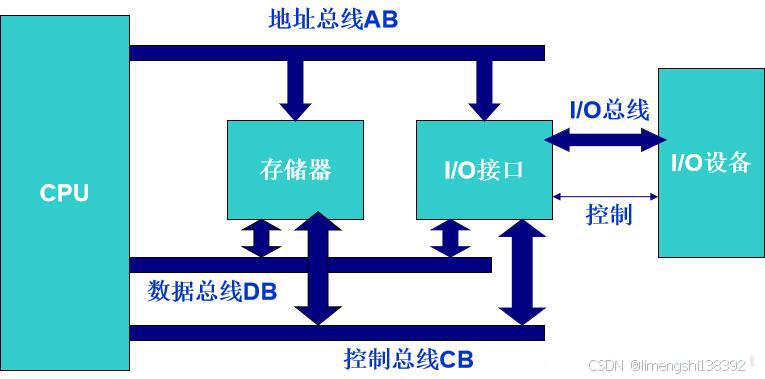

JuiceFS 的架构分为客户端、数据存储和元数据三部分。数据访问支持多种接口,包括 POSIX、HDFS API、S3 API,还有 Kubernetes CSI,以满足不同的应用场景。在数据存储方面,JuiceFS 支持几十种对象存储,这使得在多云环境下,用户可以根据不同云平台的特点选择合适的存储方式。元数据引擎支持多种常见的数据库,为用户提供了更多的选择和灵活性。企业版的 JuiceFS 包括一个自研的分布式元数据引擎,并支持分布式缓存,而社区版只支持本地缓存。这种架构设计使得 JuiceFS 能够在多云环境下高效地管理和存储数据,为大模型训练提供稳定可靠的存储支持。

三、提升存储稳定性的策略与措施

(一)技术层面的优化

在技术层面,数据预读是提升存储稳定性的重要手段之一。例如,在数据训练时,将数据从存储加载到 GPU 进行计算的过程中,可以采用预读机制,提前将可能用到的数据加载到缓存中,减少数据读取的延迟。特别是在 Batch Size 较小时,会产生大量小的 I/O 操作,预读机制可以有效地提高数据读取的效率。在多模态大模型中,由于存在许多图文对形式的小文件,会出现大量小文件访问带来的大量元数据操作,通过合理的数据预读策略,可以降低元数据操作的压力,提高存储系统的稳定性。

协议选择也是关键。尽管当前许多训练任务都使用对象存储,但在训练阶段,实际上还是通过文件接口进行访问。只有文件接口能够提供高性能,并且具有最佳的兼容性。例如,POSIX 和 GDS 协议在大模型训练中就具有重要作用。同时,许多客户开始尝试使用 GPU Direct 技术来加速性能,通过优化数据从 CPU 内存拷贝到 GPU 内存的过程,减少性能问题的出现。

缓存管理同样不可忽视。JuiceFS 的企业版提供了更细致的监控指标,能够对每个缓存服务和客户端的性能指标进行详细跟踪。合理设置缓存大小和缓存策略,可以提高数据的访问速度,降低对存储系统的压力,从而提升存储稳定性。

(二)管理层面的策略

在管理层面,权限和配额管理是保障存储稳定性的重要策略。作为一个支持多租户的文件系统,JuiceFS 能够有效地进行权限和配额管理。通过实现配额管理,可以避免某个用户或任务占用过多的存储资源,保证系统的公平性和稳定性。同时,权限管理可以确保数据的安全性,防止未经授权的访问和修改。

数据全生命周期管理也是提升存储稳定性的重要策略。随着数据的不断增加,涵盖了模型数据、数据集以及原始数据,数据治理问题日益显现。在存储方面,我们期望实现全生命周期的数据管理,最好是基于时间维度的方式。随着数据访问热度的降低,自动将冷数据转移到低成本的存储介质上,但同时保证当需要访问时,数据能够随时可见。例如,华为推出的蓝光存储,使用寿命更长,TCO 降低 70%,可以作为冷数据存储的一种选择。

(三)合作与创新

行业合作和技术创新在提升存储稳定性方面具有重要意义。知乎与面壁智能公司展开深度合作,共同开发大型语言模型,这种合作模式可以充分发挥双方的优势,提高大模型训练的效率和稳定性。同时,存储厂商和大模型厂商之间的合作也至关重要。例如,焱融科技推出了多云存储解决方案,基于统一的数据湖底座,通过数据编排将数据按需加载到数据中心,并异步将新增的模型数据推到数据湖。这种合作可以实现数据的高效管理和流转,提升存储稳定性。

技术创新也是提升存储稳定性的关键。随着大模型训练的需求不断增加,新的存储技术和解决方案不断涌现。例如,JuiceFS 在多云架构下的应用,为大模型训练提供了稳定可靠的存储支持。同时,华为发布的存储创新方案,构建多云时代可靠存储底座,也为提升存储稳定性提供了新的思路和方法。

四、未来展望

随着技术的不断发展,多云架构下大模型训练存储稳定性将呈现出以下几个发展趋势。

(一)技术融合与创新

存储技术将与人工智能、大数据等领域进一步融合。例如,利用人工智能算法进行存储资源的动态分配和优化,根据大模型训练的实际需求自动调整存储策略,提高存储资源的利用率和稳定性。同时,大数据分析技术将被广泛应用于存储性能监控和故障预测,提前发现潜在问题并采取相应措施,降低存储故障对大模型训练的影响。

(二)标准化与开放性

未来,多云架构下的存储标准将逐渐趋于统一,不同云平台之间的存储接口和数据格式将更加标准化,便于数据的迁移和共享。同时,存储系统将更加开放,支持更多的第三方工具和插件,为用户提供更加灵活多样的存储解决方案。例如,开放的 API 接口可以让用户方便地集成自己的监控工具和数据分析软件,进一步提升存储稳定性的管理水平。

(三)安全与隐私保护

随着大模型训练数据的价值不断提高,存储安全和隐私保护将成为未来发展的重点。存储厂商将不断加强存储系统的安全防护能力,采用加密技术、访问控制等手段确保数据的安全性。同时,隐私保护法规的不断完善也将促使存储厂商在数据存储和处理过程中更加注重用户隐私的保护,为大模型训练提供安全可靠的存储环境。

(四)性能持续提升

存储性能将持续提升,以满足大模型训练不断增长的需求。随着存储介质技术的不断进步,如新型闪存技术的应用,存储系统的读写速度和响应时间将进一步缩短。同时,分布式存储技术的不断发展将使得存储系统能够更好地应对大规模数据存储和高并发访问的挑战,为大模型训练提供更加稳定高效的存储支持。

总之,多云架构下大模型训练存储稳定性的未来发展充满机遇和挑战。通过技术融合与创新、标准化与开放性、安全与隐私保护以及性能持续提升等方面的努力,我们有信心为大模型训练提供更加稳定可靠的存储环境,推动人工智能技术的不断发展。