回归预测|基于粒子群优化核极限学习机PSO-KELM结合Adaboost集成的数据预测Matlab程序 多特征输入单输出

文章目录

- 一、基本原理

- 1. 数据预处理

- 2. PSO优化(粒子群优化)

- 3. KELM训练(核极限学习机)

- 4. AdaBoost集成

- 5. 模型评估和优化

- 6. 预测

- 总结

- 二、实验结果

- 三、核心代码

- 四、代码获取

- 五、总结

回归预测|基于粒子群优化核极限学习机PSO-KELM结合Adaboost集成的数据预测Matlab程序 多特征输入单输出

一、基本原理

PSO-KELM-Adaboost回归预测是一种将粒子群优化(PSO)、核极限学习机(KELM)和自适应提升(AdaBoost)结合在一起的回归方法。下面是详细的原理和流程:

1. 数据预处理

- 数据清洗:去除缺失值和异常值。

- 数据归一化:将数据标准化,以便模型训练更加稳定。

2. PSO优化(粒子群优化)

- 初始化粒子群:定义粒子的位置和速度,位置表示KELM模型的超参数(如核函数参数、正则化参数),速度决定粒子的移动。

- 定义适应度函数:通常选择均方误差(MSE)作为适应度函数,评价KELM模型在特定超参数下的性能。

- 更新粒子位置:

- 速度更新:根据粒子的历史最佳位置和群体最佳位置更新速度。

- 位置更新:根据更新后的速度调整粒子的位置。

- 迭代优化:不断迭代更新粒子位置,直到找到最优的超参数组合。

3. KELM训练(核极限学习机)

- 定义KELM模型:

- 选择核函数:常用的核函数包括径向基函数(RBF)、多项式核等。

- 设定超参数:包括核函数参数和正则化参数,这些参数由PSO优化得到。

- 训练KELM模型:

- 计算隐层权重:使用随机生成的权重和固定的激活函数计算隐层输出。

- 优化输出权重:通过最小化回归误差来求解输出层权重。

4. AdaBoost集成

- 训练基础KELM回归模型:

- 初始化权重:为每个训练样本分配初始权重。

- 训练KELM:使用当前样本权重训练KELM模型。

- 计算模型误差:评估模型在训练集上的性能,计算加权误差。

- 更新样本权重:根据误差调整样本权重,使得下一轮训练更加关注被误分类的样本。

- 构建强回归模型:

- 迭代训练:重复训练多个KELM模型,每次使用更新的样本权重。

- 组合模型:将多个基础KELM回归模型结合起来,形成最终的强回归模型。

5. 模型评估和优化

- 交叉验证:使用交叉验证技术评估集成模型的性能,确保模型的泛化能力。

- 调整超参数:根据交叉验证的结果,进一步优化PSO、KELM和AdaBoost的参数。

6. 预测

- 特征提取:使用训练好的KELM模型对新数据进行预测。

- 应用AdaBoost模型:将多个KELM回归模型的预测结果加权组合,得到最终预测结果。

总结

PSO-KELM-Adaboost回归预测方法通过结合粒子群优化、核极限学习机和自适应提升技术,提供了一种强大的回归预测工具。PSO用于优化KELM模型的超参数,KELM用于建模回归关系,而AdaBoost则通过集成多个KELM模型来提高预测的准确性和鲁棒性。每一步都为提升模型的性能和泛化能力做出贡献。

二、实验结果

PSO-KELM-Adaboost回归预测

三、核心代码

%% 读取数据

res = xlsread('数据集.xlsx');

rng(0,'twister'); % 随机种子

%% 数据分析

num_size = 0.8; % 训练集占数据集比例

outdim = 1; % 最后一列为输出

num_samples = size(res, 1); % 样本个数

res = res(randperm(num_samples), :); % 打乱数据集(不希望打乱时,注释该行)

num_train_s = round(num_size * num_samples); % 训练集样本个数

f_ = size(res, 2) - outdim; % 输入特征维度

%% 划分训练集和测试集

P_train = res(1: num_train_s, 1: f_)';

T_train = res(1: num_train_s, f_ + 1: end)';

M = size(P_train, 2);

P_test = res(num_train_s + 1: end, 1: f_)';

T_test = res(num_train_s + 1: end, f_ + 1: end)';

N = size(P_test, 2);

%% 数据归一化

[p_train, ps_input] = mapminmax(P_train, 0, 1);

p_test = mapminmax('apply', P_test, ps_input);

[t_train, ps_output] = mapminmax(T_train, 0, 1);

t_test = mapminmax('apply', T_test, ps_output);

%% 参数设置

fun = @getObjValue; % 目标函数

dim = 2; % 优化参数个数 正则化系数 C 和 RBF核函数参数宽度

lb = [0.1, 1]; % 优化参数目标下限

ub = [50, 50]; % 优化参数目标上限

pop = 10; % 种群数量

Max_iteration = 30; % 最大迭代次数

%% KELM核函数设置

Kernel_type = 'rbf';

四、代码获取

五、总结

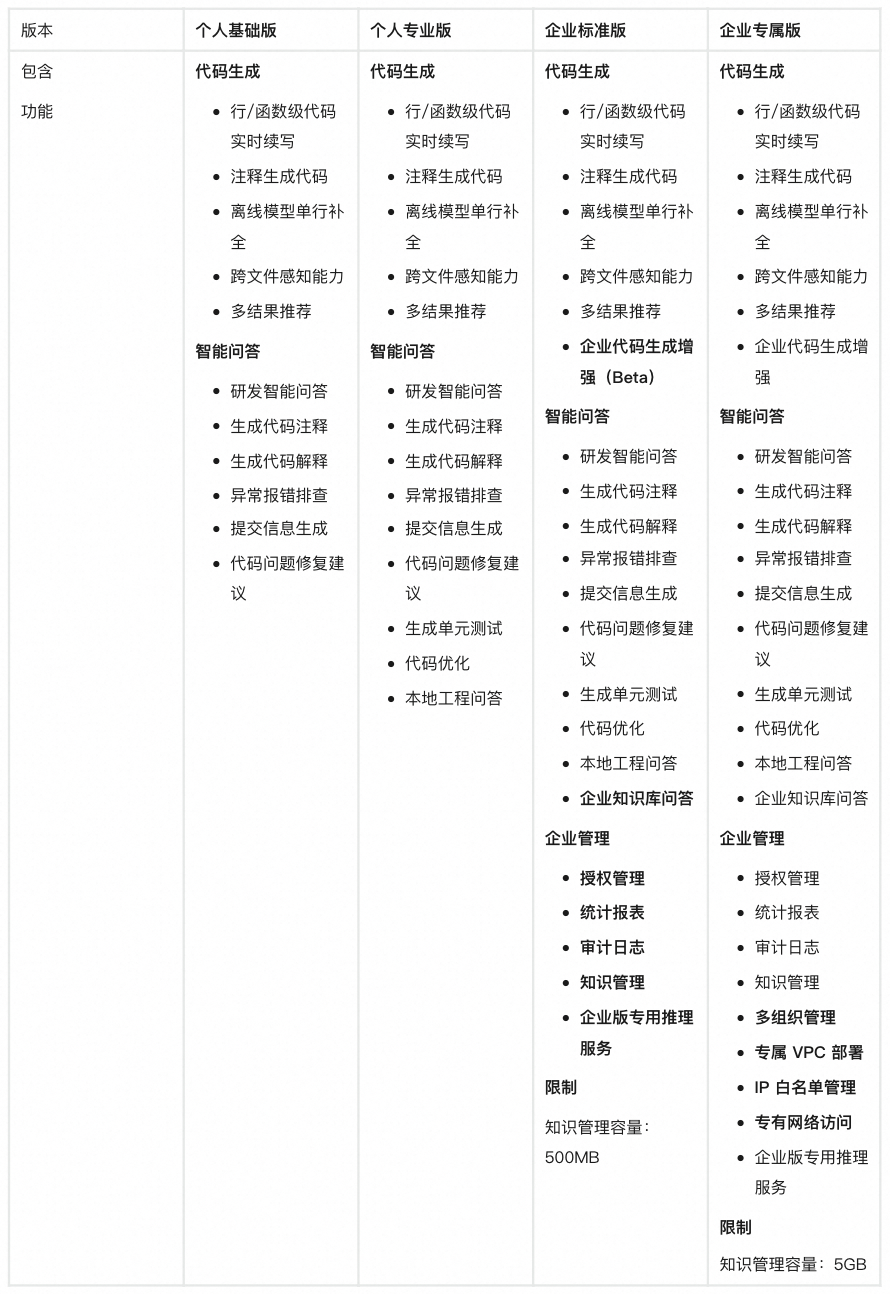

包括但不限于

优化BP神经网络,深度神经网络DNN,极限学习机ELM,鲁棒极限学习机RELM,核极限学习机KELM,混合核极限学习机HKELM,支持向量机SVR,相关向量机RVM,最小二乘回归PLS,最小二乘支持向量机LSSVM,LightGBM,Xgboost,RBF径向基神经网络,概率神经网络PNN,GRNN,Elman,随机森林RF,卷积神经网络CNN,长短期记忆网络LSTM,BiLSTM,GRU,BiGRU,TCN,BiTCN,CNN-LSTM,TCN-LSTM,BiTCN-BiGRU,LSTM–Attention,VMD–LSTM,PCA–BP等等

用于数据的分类,时序,回归预测。

多特征输入,单输出,多输出