【通俗理解】小数据学习中的“特征提取+推理”模型

关键词提炼

#小数据学习 #特征提取 #推理模型 #机器学习 #数据效率

第一节:小数据学习与“特征提取+推理”模型概述

1.1 小数据学习的挑战

在小数据场景下,模型训练面临数据稀缺的挑战,难以捕捉到足够的特征来支持泛化能力。因此,如何高效地从有限数据中提取关键特征并进行推理,成为AI崛起的关键。

1.2 “特征提取+推理”模型的优势

“特征提取+推理”模型通过两个关键步骤解决了小数据学习的难题:

首先,通过特征提取从有限数据中挖掘出最具代表性的特征;

其次,利用这些特征进行高效的推理,从而在少量数据上实现良好的性能。

1.3 相似概念比对

- 传统机器学习:依赖大量标注数据进行特征工程和模型训练。

- “特征提取+推理”模型:在小数据场景下,通过高效的特征提取和推理机制,实现对少量数据的充分利用。

第二节:核心概念与公式解释

2.1 特征提取

特征提取是从原始数据中自动学习出最具代表性的特征表示的过程。这一过程可以通过深度学习模型(如卷积神经网络CNN、循环神经网络RNN等)实现。

特征提取的公式化表达

虽然特征提取过程通常不直接对应一个具体的数学公式,但我们可以将其理解为通过模型参数 θ \theta θ将输入数据 X X X映射到特征空间 F F F的过程:

F = FeatureExtraction ( X , θ ) F = \text{FeatureExtraction}(X, \theta) F=FeatureExtraction(X,θ)

- X X X:输入数据

- θ \theta θ:模型参数

- F F F:提取的特征

2.2 推理

推理是利用提取的特征进行预测或决策的过程。在小数据学习中,推理模型需要能够在少量特征的支持下做出准确的预测。

推理的公式化表达

推理过程可以简单表示为使用提取的特征 F F F和推理模型参数 ϕ \phi ϕ进行预测的过程:

Y ^ = Inference ( F , ϕ ) \hat{Y} = \text{Inference}(F, \phi) Y^=Inference(F,ϕ)

- F F F:提取的特征

- ϕ \phi ϕ:推理模型参数

- Y ^ \hat{Y} Y^:预测结果

2.3 综合模型

将特征提取和推理结合,形成完整的“特征提取+推理”模型:

Y ^ = Inference ( FeatureExtraction ( X , θ ) , ϕ ) \hat{Y} = \text{Inference}(\text{FeatureExtraction}(X, \theta), \phi) Y^=Inference(FeatureExtraction(X,θ),ϕ)

第三节:公式探索与推演运算

虽然“特征提取+推理”模型的具体形式依赖于所使用的具体算法(如神经网络的结构、参数等),但我们可以从一般意义上探讨其背后的数学原理和优化方法。

3.1 优化目标

在小数据学习中,优化目标通常是最小化在有限数据上的经验风险,同时尽可能保持模型的泛化能力。这可以通过正则化等技术实现。

优化公式

假设损失函数为 L ( Y ^ , Y ) L(\hat{Y}, Y) L(Y^,Y)(其中 Y ^ \hat{Y} Y^为预测值, Y Y Y为真实值),则优化目标可以表示为:

min θ , ϕ 1 N ∑ i = 1 N L ( Inference ( FeatureExtraction ( X i , θ ) , ϕ ) , Y i ) + λ R ( θ , ϕ ) \min_{\theta, \phi} \frac{1}{N} \sum_{i=1}^{N} L(\text{Inference}(\text{FeatureExtraction}(X_i, \theta), \phi), Y_i) + \lambda R(\theta, \phi) θ,ϕminN1i=1∑NL(Inference(FeatureExtraction(Xi,θ),ϕ),Yi)+λR(θ,ϕ)

- N N N:数据量

- X i , Y i X_i, Y_i Xi,Yi:第 i i i个样本及其标签

- λ \lambda λ:正则化系数

- R ( θ , ϕ ) R(\theta, \phi) R(θ,ϕ):正则化项

3.2 特征提取与推理的交互

特征提取和推理是相互依赖的: 更好的特征提取有助于推理模型做出更准确的预测,而更准确的推理结果也可以反过来指导特征提取过程。

这种交互作用可以通过端到端的训练来优化。

第四节:相似公式比对

4.1 与深度学习模型的对比

深度学习模型通常也包含特征提取和推理两个阶段,但“特征提取+推理”模型在小数据场景下更加关注如何从有限数据中高效提取特征。

| 公式/模型 | 共同点 | 不同点 |

|---|---|---|

| 深度学习模型 | 都包含特征提取和推理阶段 | 深度学习模型通常依赖大量数据进行训练;“特征提取+推理”模型更注重在小数据场景下的特征提取效率 |

4.2 与迁移学习的对比

迁移学习也涉及在少量数据上进行模型训练,但它通常通过从相关领域迁移知识来辅助小数据学习。

| 公式/模型 | 共同点 | 不同点 |

|---|---|---|

| 迁移学习 | 都试图在少量数据上训练模型 | 迁移学习侧重于通过迁移相关领域的知识来辅助训练;“特征提取+推理”模型更关注于在少量数据中高效提取和利用特征 |

第五节:核心代码与可视化(假设示例)

由于“特征提取+推理”模型的具体实现依赖于所使用的算法和数据集,这里仅提供一个假设性的核心代码框架和可视化思路。

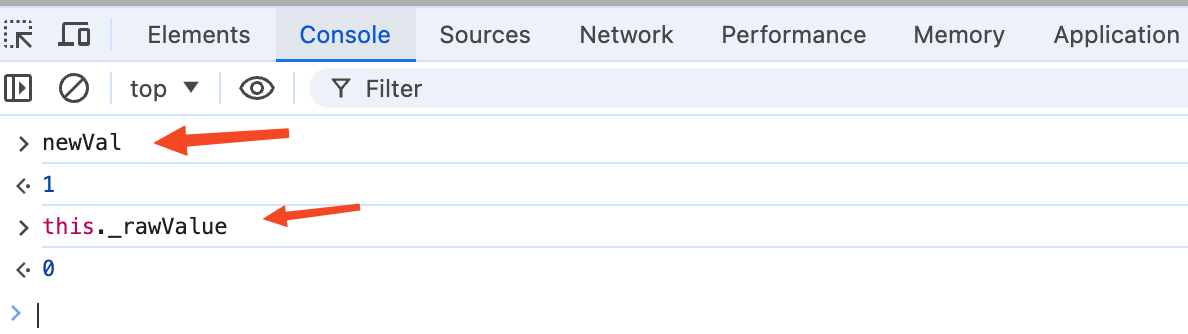

假设性核心代码框架(Python伪代码)

# 假设有一个预训练的特征提取模型和一个推理模型

# 这里仅展示伪代码逻辑

# 特征提取模型

feature_extractor = FeatureExtractor(pretrained=True)

# 推理模型

inference_model = InferenceModel()

# 加载数据

X_train, y_train = load_data(train_dataset)

# 特征提取

X_train_features = feature_extractor(X_train)

# 训练推理模型

inference_model.train(X_train_features, y_train)

# 推理

X_test, _ = load_data(test_dataset)

X_test_features = feature_extractor(X_test)

predictions = inference_model.predict(X_test_features)

# 可视化部分(省略具体实现,仅描述思路)

# 可以绘制特征分布图、预测结果与实际值的对比图等

注意:上述代码仅为示例性伪代码,实际实现时需要根据具体算法和数据集进行调整。

![[001-07-001].第1节:Redis中的BigKey使用分析](https://i-blog.csdnimg.cn/direct/bd90f1729d0046c5a466984cfb45e1db.png)