一、介绍

MuseTalk 是由腾讯团队开发的先进技术,它是一个实时的音频驱动唇部同步模型。该模型能够根据输入的音频信号,自动调整数字人物的面部图像,使其唇形与音频内容高度同步。

二、特点

- 多语言支持:该模型支持多种语言,包括中文、英文和日文,能够服务于不同语言的用户群体。

- 逼真的同步效果 :MuseTalk 生成的唇部动作与音频内容高度同步。

- 出色的生成能力 :MuseTalk 在口型生成方面表现出色,尤其擅长真人视频生成。这种高度逼真的口型同步效果提升了视频的真实感和观看体验。

三、模型构建过程

1. 更新基础软件包:

apt-get update

apt-get upgrade

apt-get install -y wget unzip lsof net-tools openssh-server git git-lfs gcc cmake build-essential

apt-get install -y libsndfile1 espeak-ng ffmpeg libasound-dev libportaudio2 libsqlite3-dev

2. 安装 GPU 依赖:CUDA

- 下载 CUDA Toolkit 的密钥环

- 使用

wget工具从 NVIDIA 官方下载 CUDA Toolkit 的 GPG 密钥环。这个密钥环用于在安装过程中验证 CUDA 包的签名。

- 使用

- 安装 CUDA Toolkit 的密钥环

- 使用

dpkg工具安装下载的密钥环.deb文件。这确保了系统可以验证 CUDA 包的真实性。

- 使用

- 更新本地包索引

- 使用

apt-get update命令更新本地的软件包索引,确保安装时使用的是最新的包信息。

- 使用

- 安装 CUDA Toolkit

- 使用

apt-get install命令安装 CUDA Toolkit 12.1。-y选项自动接受所有提示,无需手动确认。

以下是具体的命令:

- 使用

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-keyring_1.0-1_all.deb

dpkg -i cuda-keyring_1.0-1_all.deb

apt-key del 7fa2af80

apt-get update

apt-get -y install cuda-toolkit-12-1

- 配置系统环境

export PATH=/usr/local/cuda/bin:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH

source ~/.bashrc

3. 安装 Miniconda:

- 下载 Miniconda 安装脚本 :

- 使用

wget命令从 Anaconda 的官方仓库下载 Miniconda 的安装脚本。Miniconda 是一个更小的 Anaconda 发行版,包含了 Anaconda 的核心组件,用于安装和管理 Python 包。

- 使用

- 运行 Miniconda 安装脚本 :

- 使用

bash命令运行下载的 Miniconda 安装脚本。这将启动 Miniconda 的安装过程。

- 使用

# 下载 Miniconda 安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-py310_22.11.1-1-Linux-x86_64.sh

# 运行 Miniconda 安装脚本

bash Miniconda3-py310_22.11.1-1-Linux-x86_64.sh

# 初次安装需要激活base环境

conda init bash

source ~/.bashrc

- 注意事项:

- 请确保您的系统是 Linux x86_64 架构,因为下载的 Miniconda 版本是为该架构设计的。

- 在运行安装脚本之前,您可能需要使用

chmod +x Miniconda3-py310_22.11.1-1-Linux-x86_64.sh命令给予脚本执行权限。 - 安装过程中,您将被提示是否同意许可协议,以及是否将 Miniconda 初始化。通常选择 "yes" 以完成安装和初始化。

- 安装完成后,您可以使用

conda命令来管理 Python 环境和包。

如果链接无法访问或解析失败,可能是因为网络问题或链接本身的问题。请检查网络连接,并确保链接是最新的和有效的。如果问题依旧,请访问 Anaconda 的官方网站获取最新的下载链接。

4. 从 github 仓库克隆项目:

- 克隆存储库:

git clone https://gitee.com/empty-snow/MuseTalk.git --depth 1- 这个命令使用

git clone从指定的 GitHub 地址克隆 "Linly-Talker" 项目。--depth 1参数告诉 Git 只下载最新的历史记录,这减少了需要下载的数据量,使得克隆过程更快。如果没有--depth参数,默认情况下 Git 会克隆整个项目的所有提交历史。

- 切换目录:

cd MuseTalk- 这个命令使用

cd(change directory)命令切换当前工作目录到刚才克隆的 "MuseTalk" 目录中。这意味着接下来执行的所有命令都是在该项目目录下执行。

# 克隆 MuseTalk 项目,只包含最新的提交历史

git clone https://gitee.com/empty-snow/MuseTalk.git --depth 1

# 切换到克隆的项目目录中

cd MuseTalk

请注意,如果 https://github.com/Kedreamix/Linly-Talker.git这个链接不存在或者无效,git clone 命令将不会成功克隆项目,并且会报错。确保链接是有效的,并且您有足够的权限访问该存储库。

5. 创建虚拟环境:

# 升级 pip

python -m pip install --upgrade pip

# 更换 pypi 源加速库的安装

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

# 创建一个名为 musetalk 的新虚拟环境,并指定 Python 版本为 3.10.8

conda create -n musetalk python=3.10.8

# 激活新创建的虚拟环境

conda activate musetalk

6. 下载预训练模型:

-

切换目录 :

cd /MuseTalk- 这个命令用于切换当前工作目录到

/MuseTalk。这通常是一个项目的根目录,其中包含了项目的所有文件和子目录。

-

下载权重 :

-

weights

-

sd-vae-ft-mse

-

whisper

-

dwpose

-

face-parse-bisent

-

resnet18

进入以上链接,按照下面的要求进行模型下载和保存:

./models/

├── musetalk

│ └── musetalk.json

│ └── pytorch_model.bin

├── dwpose

│ └── dw-ll_ucoco_384.pth

├── face-parse-bisent

│ ├── 79999_iter.pth

│ └── resnet18-5c106cde.pth

├── sd-vae-ft-mse

│ ├── config.json

│ └── diffusion_pytorch_model.bin

└── whisper

└── tiny.pt

7. 安装模型依赖库:

- 切换到项目目录

# 切换到项目工作目录

cd /MuseTalk

- 安装 FFmpeg

# 在base环境中安装特定版本的FFmpeg

conda install ffmpeg==4.2.2

- 安装 WebUI 依赖

# 安装WebUI界面所需的Python依赖库

pip install -r requirements.txt

- 安装 TensorBoard nightly 版本

# 安装TensorBoard的nightly版本,使用阿里云的PyPI镜像源

pip install tb-nightly -i https://mirrors.aliyun.com/pypi/simple

- 安装 OpenMIM

# 安装OpenMIM,一个用于管理模型和依赖的工具

pip install --no-cache-dir -U openmim

- 安装 MMEngine

# 安装MMEngine,一个通用的深度学习训练框架

mim install mmengine

- 安装 MMCV

# 安装MMCV(MegEngine Model Center Vision),至少2.0.1版本

mim install "mmcv>=2.0.1"

- 安装 MMDetection

# 安装MMDetection,至少3.1.0版本的目标检测框架

mim install "mmdet>=3.1.0"

- 安装 MMPose

# 安装MMPose,至少1.1.0版本的人体姿态估计框架

mim install "mmpose>=1.1.0"

8. 运行项目:

cd /MuseTalk

python app.py

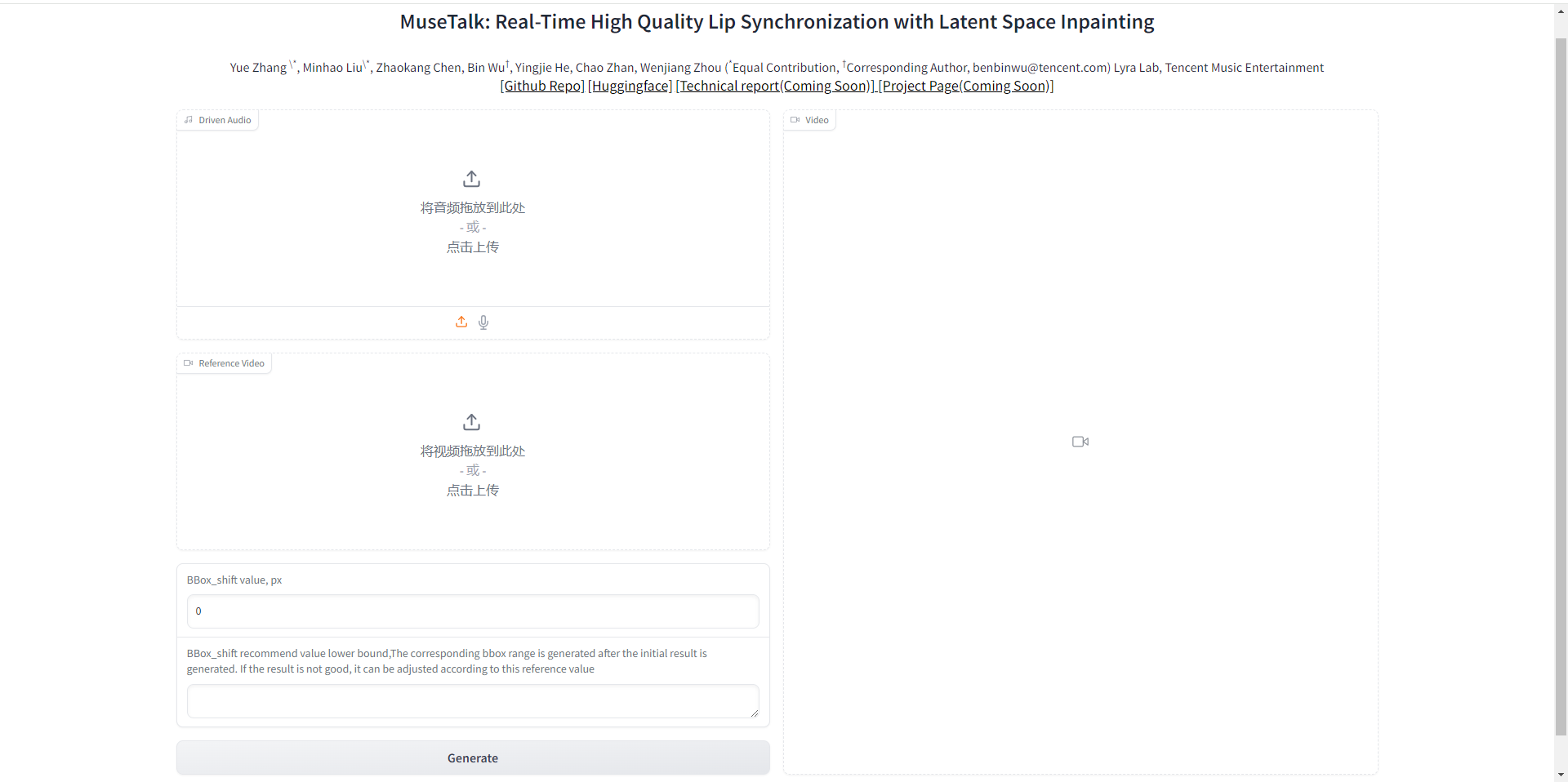

四、网页演示

![【自然语言处理】调用NLTK数据失败‘wordnet‘和‘punkt‘不存在[Errno 11004]问题解决](https://i-blog.csdnimg.cn/direct/50c458e5f4284d668eb1e5fbbce9be13.png)