注意力机制已经成为深度学习模型,尤其是卷积神经网络(CNN)中不可或缺的组成部分。通过使模型能够选择性地关注输入数据中最相关的部分,注意力机制显著提升了CNN在图像分类、目标检测和语义分割等复杂任务中的性能。本文将全面介绍CNN中的注意力机制,从基本概念到实际实现,为读者提供深入的理解和实践指导。

CNN中注意力机制的定义

注意力机制在CNN中的应用受到了人类视觉系统的启发。在人类视觉系统中,大脑能够选择性地关注视野中的特定区域,同时抑制其他不太相关的信息。类似地,CNN中的注意力机制允许模型在处理图像时,优先考虑某些特征或区域,从而提高模型提取关键信息和做出准确预测的能力。

例如在人脸识别任务中,模型可以学会主要关注面部区域,因为这里包含了比背景或衣着更具辨识度的特征。这种选择性注意力确保了模型能够更有效地利用图像中最相关的信息,从而提高整体性能。

传统的CNN在处理图像时,往往对图像的所有部分赋予相同的重要性。这种方法在处理复杂场景或需要细粒度识别的任务时可能会导致次优性能。引入注意力机制旨在解决以下挑战:

- 选择性聚焦:图像的不同部分对特定任务的贡献程度不同。注意力机制使模型能够集中于最相关的部分,提高特征提取的质量。

- 处理复杂和噪声数据:现实世界的图像通常包含噪声或无关信息。注意力机制有助于模型过滤这些干扰,专注于关键区域,提高模型的鲁棒性。

- 捕捉长距离依赖关系:CNN通过卷积操作主要捕捉局部特征。注意力机制使模型能够捕捉长距离依赖关系,这对于理解图像的全局上下文至关重要。

- 提高可解释性:注意力机制通过突出显示模型决策过程中最有影响的图像区域,增强了模型的可解释性。

CNN中注意力机制的类型

CNN中的注意力机制可以根据其关注的维度进行分类:

- 通道注意力:关注不同特征通道的重要性,如Squeeze-and-Excitation (SE)模块。

- 空间注意力:关注图像不同空间区域的重要性,如Gather-Excite Network (GENet)和Point-wise Spatial Attention Network (PSANet)。

- 混合注意力:结合多种注意力机制,如同时使用空间和通道注意力的卷积块注意力模块(CBAM)。

注意力机制在CNN中的工作原理

注意力机制在CNN中的工作过程通常包括以下步骤:

- 特征提取:CNN首先从输入图像中提取特征图。

- 注意力计算:基于提取的特征图计算注意力权重,确定不同特征或区域的重要性。

- 特征重校准:将计算得到的注意力权重应用于原始特征图,增强重要特征,抑制次要特征。

- 后续处理:重校准后的特征用于进行分类、检测或其他下游任务。

注意力机制的PyTorch实现

下面我们将介绍几种常用注意力机制的PyTorch实现,包括SE模块、ECA模块、PSANet和CBAM。

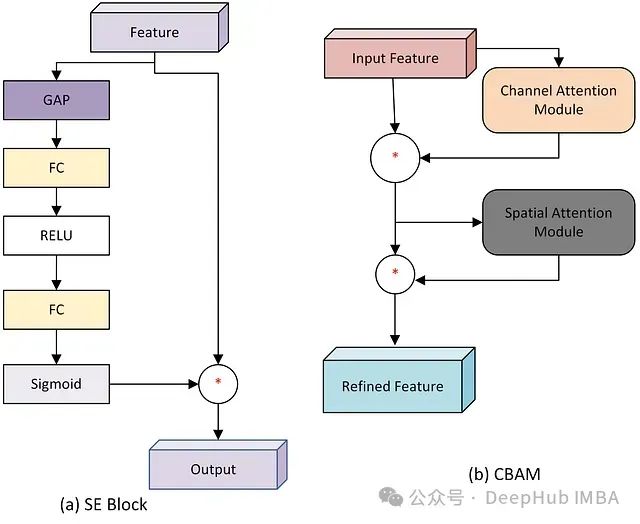

1、Squeeze-and-Excitation (SE) 模块

SE模块通过建模通道间的相互依赖关系引入了通道级注意力。它首先对空间信息进行"挤压",然后基于这个信息"激励"各个通道。

SE模块的工作流程如下:

- 全局平均池化(GAP):将每个特征图压缩为一个标量值。

- 全连接层:通过两个全连接层处理压缩后的特征,第一个层降低维度,第二个层恢复原始维度。

- 激活函数:使用ReLU和Sigmoid激活函数引入非线性。

- 重新校准:使用得到的通道权重对原始特征图进行加权。

SE模块的PyTorch实现如下:

importtorch

fromtorchimportnn

classSEAttention(nn.Module):

def__init__(self, channel, reduction=16):

super().__init__()

self.avg_pool=nn.AdaptiveAvgPool2d(1)

self.fc=nn.Sequential(

nn.Linear(channel, channel//reduction, bias=False),

nn.ReLU(inplace=True),

nn.Linear(channel//reduction, channel, bias=False),

nn.Sigmoid()

)

defforward(self, x):

b, c, _, _=x.size()

y=self.avg_pool(x).view(b, c)

y=self.fc(y).view(b, c, 1, 1)

returnx*y.expand_as(x)

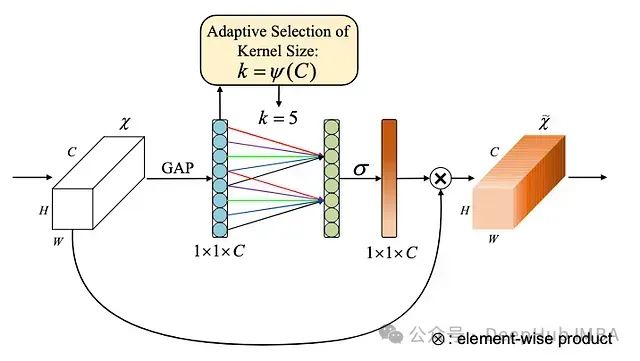

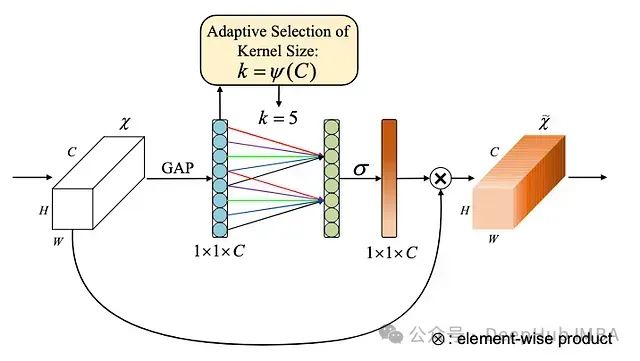

2、ECA-Net (Efficient Channel Attention)

ECA模块提供了一种更高效的通道注意力机制,它使用一维卷积替代了SE模块中的全连接层,大大减少了计算量。

ECA模块的主要特点包括:

- 自适应kernel size:根据通道数自动选择一维卷积的kernel size。

- 无降维操作:直接在原始通道上进行操作,避免了信息损失。

- 局部跨通道交互:通过一维卷积捕捉局部通道间的依赖关系。

ECA模块的PyTorch实现如下:

importtorch

fromtorchimportnn

classECAAttention(nn.Module):

def__init__(self, channel, k_size=3):

super().__init__()

self.avg_pool=nn.AdaptiveAvgPool2d(1)

self.conv=nn.Conv1d(1, 1, kernel_size=k_size, padding=(k_size-1) //2, bias=False)

self.sigmoid=nn.Sigmoid()

defforward(self, x):

y=self.avg_pool(x)

y=self.conv(y.squeeze(-1).transpose(-1, -2)).transpose(-1, -2).unsqueeze(-1)

y=self.sigmoid(y)

returnx*y.expand_as(x)

3、PSANet (Point-wise Spatial Attention Network)

PSANet强调了空间注意力的重要性,它为特征图中的每个位置计算一个注意力图,考虑了该位置与所有其他位置的关系。

PSANet的主要组成部分包括:

- 特征降维:减少通道数以提高效率。

- 收集和分配注意力:分别计算每个点从其他点收集信息和向其他点分配信息的权重。

- 特征融合:将原始特征与注意力加权后的特征融合。

以下是PSANet的简化PyTorch实现:

importtorch

fromtorchimportnn

importtorch.nn.functionalasF

classPSAModule(nn.Module):

def__init__(self, in_channels, out_channels):

super().__init__()

self.conv_reduce=nn.Conv2d(in_channels, out_channels, 1)

self.collect=nn.Conv2d(out_channels, out_channels, 1)

self.distribute=nn.Conv2d(out_channels, out_channels, 1)

defforward(self, x):

x=self.conv_reduce(x)

b, c, h, w=x.size()

# Collect

x_collect=self.collect(x).view(b, c, -1)

x_collect=F.softmax(x_collect, dim=-1)

# Distribute

x_distribute=self.distribute(x).view(b, c, -1)

x_distribute=F.softmax(x_distribute, dim=1)

# Attention

x_att=torch.bmm(x_collect, x_distribute.permute(0, 2, 1)).view(b, c, h, w)

returnx+x_att

4、CBAM (Convolutional Block Attention Module)

CBAM结合了通道注意力和空间注意力,分别关注"什么"特征重要和"哪里"重要。

CBAM的主要步骤包括:

- 通道注意力:使用全局平均池化和最大池化,通过多层感知器生成通道权重。

- 空间注意力:使用通道池化和卷积操作生成空间注意力图。

- 序列应用:先应用通道注意力,再应用空间注意力。

CBAM的PyTorch实现如下:

importtorch

importtorch.nnasnn

importtorch.nn.functionalasF

classChannelAttention(nn.Module):

def__init__(self, in_planes, ratio=16):

super().__init__()

self.avg_pool=nn.AdaptiveAvgPool2d(1)

self.max_pool=nn.AdaptiveMaxPool2d(1)

self.fc1=nn.Conv2d(in_planes, in_planes//ratio, 1, bias=False)

self.relu1=nn.ReLU()

self.fc2=nn.Conv2d(in_planes//ratio, in_planes, 1, bias=False)

self.sigmoid=nn.Sigmoid()

defforward(self, x):

avg_out=self.fc2(self.relu1(self.fc1(self.avg_pool(x))))

max_out=self.fc2(self.relu1(self.fc1(self.max_pool(x))))

out=avg_out+max_out

returnself.sigmoid(out)

classSpatialAttention(nn.Module):

def__init__(self, kernel_size=7):

super().__init__()

self.conv1=nn.Conv2d(2, 1, kernel_size, padding=kernel_size//2, bias=False)

self.sigmoid=nn.Sigmoid()

defforward(self, x):

avg_out=torch.mean(x, dim=1, keepdim=True)

max_out, _=torch.max(x, dim=1, keepdim=True)

x=torch.cat([avg_out, max_out], dim=1)

x=self.conv1(x)

returnself.sigmoid(x)

classCBAM(nn.Module):

def__init__(self, in_planes, ratio=16, kernel_size=7):

super().__init__()

self.ca=ChannelAttention(in_planes, ratio)

self.sa=SpatialAttention(kernel_size)

defforward(self, x):

x=x*self.ca(x)

x=x*self.sa(x)

returnx

注意力机制在CNN中的实际应用

注意力机制在多个计算机视觉任务中展现出了显著的效果:

- 图像分类:注意力机制帮助模型聚焦于图像中最具判别性的区域,提高分类准确率,尤其是在处理复杂场景和细粒度分类任务时。

- 目标检测:通过强调重要区域并抑制背景信息,注意力机制提高了模型定位和识别目标的能力。

- 语义分割:注意力机制有助于精确划分对象边界,提高分割的精度,特别是在处理复杂的多类别分割任务时。

- 医学图像分析:在医学影像领域,注意力机制可以帮助模型关注潜在的病变区域,同时减少对正常组织的干扰,提高诊断的准确性和可靠性。

尽管注意力机制在多个方面显著提升了CNN的性能,但仍然存在一些挑战:

- 计算开销:某些注意力机制可能引入额外的计算复杂度,这在实时应用或资源受限的环境中可能成为瓶颈。

- 模型复杂性:引入注意力机制可能增加模型的复杂性,使得模型的训练和优化变得更加困难。

- 过拟合风险:复杂的注意力机制可能增加模型过拟合的风险,特别是在训练数据有限的情况下。

- 泛化能力:设计能够在不同任务和数据集之间良好泛化的注意力机制仍然是一个开放的研究问题。

总结

注意力机制已成为深度学习中不可或缺的工具,特别是对于CNN。通过允许模型关注输入的最相关部分,这些机制显著提高了CNN在广泛任务中的性能。

随着深度学习的不断发展,注意力机制无疑将在开发更准确、高效和可解释的模型中发挥关键作用。无论你正在从事图像分类、目标检测还是任何其他与视觉相关的任务,将注意力机制适应到CNN架构中都是推动模型性能边界的强大方法。

https://avoid.overfit.cn/post/fe4dc05e03a043cfb7acd2968735febc