茴香豆 是由书生·浦语团队开发的一款开源、专门针对国内企业级使用场景设计并优化的知识问答工具。

茴香豆特点:

三阶段 Pipeline (前处理、拒答、响应),提高相应准确率和安全性

打通微信和飞书群聊天,适合国内知识问答场景

支持各种硬件配置安装,安装部署限制条件少

适配性强,兼容多个 LLM 和 API

傻瓜操作,安装和配置方便

即开即用!https://github.com/InternLM/Tutorial/blob/camp3/docs/L2/Huixiangdou/readme.md

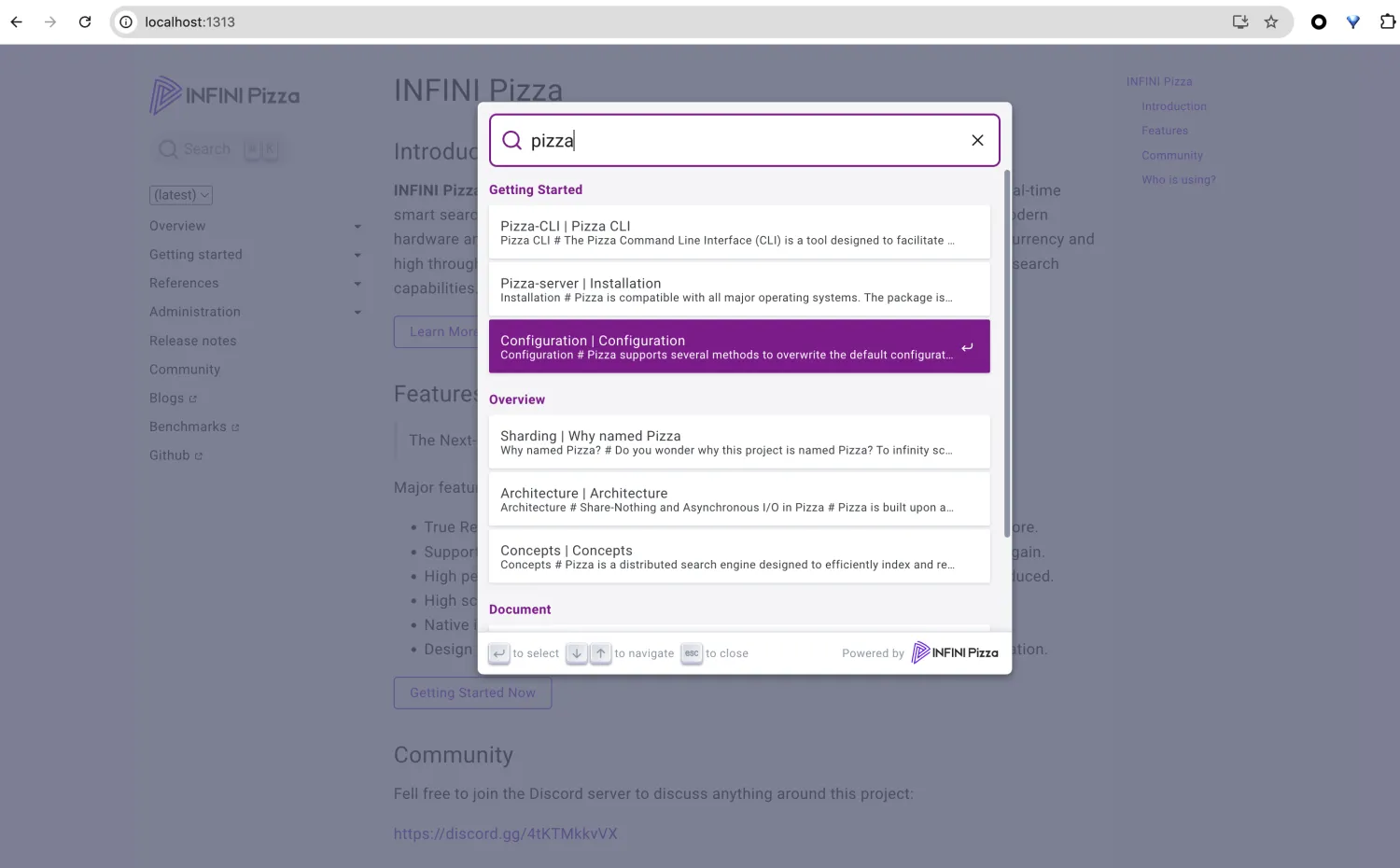

部署在Intern studio上面的茴香豆:

知识库创建成功后会有一系列小测试,检验问题拒答和响应效果,如图所示,关于“mmpose 安装”的问题,测试结果可以很好的反馈相应答案和对应的参考文件,但关于“std::vector 使用”的问题,因为属于 C++ 范畴,不再在知识库范围内,测试结果显示拒答,说明我们的知识助手工作正常。

配置中可见,在运行过一次特征提取后,茴香豆的阈值从 -1.0 更新到了 0.33。 配置文件中的 work_dir 参数指定了特征提取后向量知识库存放的位置。如果有多个知识库快速切换的需求,可以通过更改该参数实现。

基于Gradio做交互,这一版代码似乎不能做图片交互,我试试新的~

多模态茴香豆:最新的茴香豆支持了多模态的图文检索,启用该功能后,茴香豆可以解析上传的图片内容,并根据图片内容和文字提示词进行检索回答。

多模态似乎并没有准确识别:

MIndsearch解答正确

![【c++】cout打印char * 或者char[]的细节详解](https://i-blog.csdnimg.cn/direct/6b9580d7dbd74bf6963356efa5b4ad29.png)