检索比对类应用

1 认识“检索比对”

1.检索和比对的区别

检索和比对是信息处理和数据分析中常见的两种操作,虽然二者在一定程度上都有涉及到信息的提取和分析,但其侧重点和应用场景有所不同。检索主要关注从大规模数据集中定位相关信息,而比对则关注对特定数据对象进行详细比较和相似度分析。二者在信息处理中的角色各有侧重,检索适合于快速找到可能的候选项,而比对则用于精确地判断候选项之间的匹配度。

1. 检索(Retrieval)

- 定义:检索是从大规模数据集中查找和提取符合某些条件或关键词的信息。它的主要目标是找到满足用户查询条件的相关信息或文档。

- 应用场景:常用于数据库查询、信息搜索、文本搜索引擎等场合。例如,用户在搜索引擎中输入关键词,系统会根据关键词在数据库或文档集中进行搜索,并返回相关结果。

- 特点:

- 侧重于从大量数据中定位或提取相关数据。

- 结果通常是一个集合,包含了所有符合条件的条目。

- 检索的关键在于匹配程度和相关性排序。

2. 比对(Comparison)

- 定义:比对是对两个或多个数据对象(如文本、图像、指纹等)进行逐一比较,以确定它们之间的相似度或差异性。比对的目的是评估对象之间的匹配度或区别。

- 应用场景:常用于生物识别(如指纹比对、面部识别)、版本控制、模式识别等场合。例如,在指纹识别中,比对会将采集的指纹与数据库中的样本逐一比对,找出最匹配的结果。

- 特点:

- 侧重于对特定对象进行精确的相似度分析或匹配。

- 结果通常是相似度评分、差异列表或匹配与否的判断。

- 比对的关键在于准确性和匹配算法的性能。

2. 如何衡量“相等”和“相似”?

2 检索比对的前提:特征相似度

1. 特征编码算法的作用

特征编码算法在机器学习和数据分析中起着至关重要的作用。其主要功能是将原始数据转换为机器学习模型可以理解和处理的特征表示形式。以下是特征编码算法的几个主要作用:

1. 数据表示转换

- 作用:特征编码算法的主要作用是将复杂的、非数值型的数据(如类别数据、文本数据、图像数据等)转换为适合模型处理的数值型或向量型表示。不同的算法可以针对不同类型的数据生成适合的特征表示。

- 示例:对于类别数据,可以使用独热编码(One-Hot Encoding);对于文本数据,可以使用词嵌入(Word Embedding)或TF-IDF等方法。

2. 维度压缩

- 作用:在高维数据中,特征编码算法可以通过降维技术将高维数据压缩到更低的维度,减少冗余特征,保留重要的信息。这有助于减少模型的复杂性,降低计算开销,并减少过拟合风险。

- 示例:常用的降维算法包括主成分分析(PCA)、线性判别分析(LDA)等。

3. 特征标准化与归一化

- 作用:特征编码算法还可以对数据进行标准化或归一化处理,使数据符合某些特定的分布要求。这对于一些基于距离的算法(如KNN、SVM)尤为重要,因为这些算法对特征值的尺度非常敏感。

- 示例:常用的标准化方法包括Z-score标准化、Min-Max归一化等。

4. 增强模型的可解释性

- 作用:通过特征编码,可以将原始数据中的隐含信息显性化,或将特征转换为更具解释力的形式,从而增强模型的可解释性。这在需要解释模型决策的应用场景中特别重要。

- 示例:将时间戳数据编码为季节性特征、时间段特征,能使模型更好地捕捉时间相关的模式。

5. 处理缺失值和噪声

- 作用:特征编码算法还可以用于处理缺失值或噪声数据。通过适当的编码方法,缺失值可以被处理为合理的特征值,而不是简单地忽略或删除。

- 示例:将缺失值编码为单独的一类,或使用插值方法填补缺失值。

6. 适应特定的算法需求

- 作用:不同的机器学习算法对输入特征有不同的要求。特征编码算法可以根据特定算法的需求对原始数据进行预处理,从而提高模型的性能。

- 示例:决策树算法不需要对数据进行标准化处理,而线性回归等算法则需要对数据进行线性转换。

2. 衡量(计算)特征相似度的方式

衡量特征相似度的方法多种多样,选择合适的相似度计算方式取决于数据的类型和应用场景。欧氏距离、余弦相似度、杰卡德系数等都是常见的选择,而在特定场景下,如时间序列或二进制数据的比较,动态时间规整和汉明距离则更为适用

在机器学习和数据分析中,计算特征相似度是评估两个数据点之间关系的关键步骤。不同的相似度计算方式适用于不同的数据类型和应用场景。以下是几种常见的特征相似度计算方式:

1. 欧氏距离(Euclidean Distance)

- 定义:欧氏距离是最常用的相似度度量方式之一,计算两个点在多维空间中的直线距离。对于两个向量

x

\mathbf{x}

x 和

y

\mathbf{y}

y,其欧氏距离为:

d ( x , y ) = ∑ i = 1 n ( x i − y i ) 2 d(\mathbf{x}, \mathbf{y}) = \sqrt{\sum_{i=1}^{n} (x_i - y_i)^2} d(x,y)=∑i=1n(xi−yi)2 - 应用场景:适用于连续型数据的距离计算,如图像特征向量之间的相似性。

2. 余弦相似度(Cosine Similarity)

- 定义:余弦相似度通过计算两个向量之间的夹角余弦值来衡量它们的相似度。其公式为:

cosine similarity = x ⋅ y ∥ x ∥ ∥ y ∥ \text{cosine similarity} = \frac{\mathbf{x} \cdot \mathbf{y}}{\|\mathbf{x}\| \|\mathbf{y}\|} cosine similarity=∥x∥∥y∥x⋅y - 应用场景:适用于文本数据的向量化表示,如TF-IDF向量之间的相似性评估。

3. 曼哈顿距离(Manhattan Distance)

- 定义:曼哈顿距离计算的是两个点在标准坐标系下沿轴线移动的距离。

- 其公式为:

d ( x , y ) = ∑ i = 1 n ∣ x i − y i ∣ d(\mathbf{x}, \mathbf{y}) = \sum_{i=1}^{n} |x_i - y_i| d(x,y)=∑i=1n∣xi−yi∣ - 应用场景:适用于离散网格或棋盘距离场景下的相似度计算。

4. 杰卡德相似系数(Jaccard Similarity)

- 定义:杰卡德相似系数用于衡量两个集合的交集与并集的比值。公式为:

J ( A , B ) = ∣ A ∩ B ∣ ∣ A ∪ B ∣ J(A, B) = \frac{|A \cap B|}{|A \cup B|} J(A,B)=∣A∪B∣∣A∩B∣ - 应用场景:适用于集合或二进制数据的相似性度量,如用户偏好或标签的相似性分析。

5. 汉明距离(Hamming Distance)

- 定义:汉明距离用于计算两个等长二进制向量之间的不同位数。其定义为两个字符串之间的汉明距离:

d ( x , y ) = ∑ i = 1 n I ( x i ≠ y i ) d(\mathbf{x}, \mathbf{y}) = \sum_{i=1}^{n} I(x_i \neq y_i) d(x,y)=∑i=1nI(xi=yi) - 应用场景:适用于比较二进制编码的相似度,如基因序列或错误检测编码。

6. 皮尔逊相关系数(Pearson Correlation Coefficient)

- 定义:皮尔逊相关系数衡量两个变量之间的线性相关性,其值介于 -1 和 1 之间。公式为:

r = ∑ i = 1 n ( x i − x ˉ ) ( y i − y ˉ ) ∑ i = 1 n ( x i − x ˉ ) 2 ∑ i = 1 n ( y i − y ˉ ) 2 r = \frac{\sum_{i=1}^{n} (x_i - \bar{x})(y_i - \bar{y})}{\sqrt{\sum_{i=1}^{n} (x_i - \bar{x})^2} \sqrt{\sum_{i=1}^{n} (y_i - \bar{y})^2}} r=∑i=1n(xi−xˉ)2∑i=1n(yi−yˉ)2∑i=1n(xi−xˉ)(yi−yˉ) - 应用场景:适用于衡量两个变量之间的相关性,常用于统计分析和回归分析。

7. 动态时间规整(Dynamic Time Warping, DTW)

- 定义:DTW 是用于计算时间序列数据之间的相似度的算法,它允许在时间轴上对齐两个序列,从而找到最小的距离。

- 应用场景:适用于时间序列数据的相似度计算,如语音识别、手写体识别等。

3. 应用

- 车辆检索

- 人脸检索

- 图像对比

3 检索比对之人脸识别

1. 人脸识别流程

4 检索比对之以图搜车

5 检索比对之条件(属性)搜索

6 向量数据库

1. 传统数据库和向量数据库的差异

传统数据库和向量数据库在设计理念、数据结构、查询方式、应用场景等方面存在显著差异。传统数据库和向量数据库分别针对结构化和非结构化数据的不同需求而设计。传统数据库擅长处理高度结构化的数据和复杂的事务性查询,而向量数据库则专注于处理高维向量数据的相似性搜索,在机器学习和大数据分析等领域表现优异。随着大数据和人工智能的发展,向量数据库在特定领域的应用正变得越来越重要。以下是两者的主要区别:

1. 数据存储形式

- 传统数据库:传统数据库通常以结构化数据的形式存储数据,采用表格的行和列来表示不同的数据类型。常见的数据库类型包括关系型数据库(如MySQL、PostgreSQL)和NoSQL数据库(如MongoDB、Cassandra)。

- 向量数据库:向量数据库专门用于存储和管理高维向量数据。向量可以表示文本、图像、音频等非结构化数据经过特征提取后的数值表示。典型的向量数据库包括Milvus、Pinecone等。

2. 查询方式

- 传统数据库:基于SQL或类SQL语言进行查询,支持丰富的查询操作,如条件查询、聚合、连接等。查询主要基于字段的值匹配或范围检索。

- 向量数据库:支持基于向量相似度的查询,常用的相似度度量包括欧氏距离、余弦相似度、内积等。向量数据库通常采用ANN(Approximate Nearest Neighbor)算法来高效地进行近似最近邻查询。

3. 数据结构

- 传统数据库:数据结构是高度结构化的,适用于关系模型或文档模型,数据间的关系通过外键、索引等方式建立和维护。

- 向量数据库:数据结构以高维向量为核心,主要用于存储、检索和比较向量。向量数据通常没有固定的结构,且维度较高(可能达到数百甚至上千维)。

4. 应用场景

- 传统数据库:适用于事务处理、数据管理、财务系统、客户关系管理等需要高度结构化数据和复杂查询的场景。

- 向量数据库:广泛应用于机器学习、推荐系统、计算机视觉、自然语言处理等领域,用于处理文本、图像、音频等非结构化数据的相似性检索和特征比对。

5. 扩展性与性能

- 传统数据库:设计之初注重数据一致性(ACID特性)和事务处理的效率,针对大规模数据的查询可能会面临性能瓶颈,特别是高维数据的相似性查询。

- 向量数据库:专门优化了高维数据的存储与查询,通常通过分布式架构和索引机制(如HNSW、IVF)来处理海量向量数据,确保快速检索。

6. 索引机制

- 传统数据库:主要使用B树、哈希表等索引结构来加速查询操作,这些索引适用于精确匹配和范围查询。

- 向量数据库:使用特殊的索引结构(如KD树、LSH、HNSW)来加速高维向量的最近邻搜索,侧重于近似相似度计算而非精确匹配。

7. 数据一致性

-

传统数据库:强调强一致性,支持事务的ACID特性,确保数据的一致性和完整性。

-

向量数据库:更多地关注查询性能和响应速度,在某些场景下可能采用弱一致性模型以换取查询的高效性。

7 特征降维

1. 特征降维的作用

特征降维在数据分析和机器学习中具有多重重要作用,包括减少计算复杂度、防止过拟合、提高模型可解释性、消除冗余、改善可视化以及降噪。这些作用能够帮助开发者构建更加高效、准确和易于理解的模型,在实践中广泛应用于各类数据分析任务。以下是特征降维的主要作用:

1. 减少计算复杂度

- 作用:高维数据的计算复杂度较高,特征降维可以通过减少特征的数量来降低计算资源的消耗。这对模型的训练速度和推理效率都有显著的提升作用。

- 应用:如在大规模图像处理或基因数据分析中,降维后可以大幅度减少模型训练时间。

2. 防止过拟合

- 作用:高维数据容易导致模型的过拟合,因为模型可能会学习到数据中的噪声。降维通过保留主要特征而去除冗余或噪声特征,降低了模型的复杂性,从而减小过拟合的风险。

- 应用:在小样本数据集上训练的模型,降维可以帮助提高模型的泛化能力。

3. 提高模型的可解释性

- 作用:高维数据常常难以解释。通过降维,特征的数量减少,模型变得更加简单,结果也更加易于理解和解释。

- 应用:在金融数据分析中,通过降维可以提取出关键的市场指标,从而帮助理解市场走势。

4. 消除特征冗余

- 作用:在高维数据中,许多特征可能是冗余的或高度相关的。降维能够消除这些冗余特征,从而简化数据结构,保留对结果有实质性影响的主要特征。

- 应用:在文本分析中,许多词汇可能具有相似的意义,通过降维可以合并这些特征,简化数据处理。

5. 改善数据可视化

- 作用:高维数据难以在二维或三维空间中可视化。降维技术可以将高维数据映射到低维空间,从而实现有效的可视化,帮助分析数据分布和结构。

- 应用:使用PCA(主成分分析)将数据降至2D或3D,以便更好地可视化聚类结果或分类边界。

6. 降噪

- 作用:数据中可能存在噪声,特征降维通过去除那些对结果影响不大、但含有噪声的特征,能够提高数据的质量,从而改善模型的性能。

- 应用:在图像处理或信号处理任务中,通过降维技术可以滤除噪声,提高数据的信噪比。

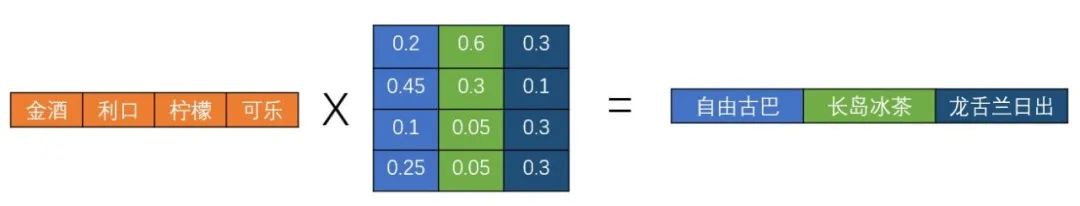

2. 直观理解特征之间的关系(相似性)

参考

https://www.bilibili.com/cheese/play/ss10426?query_from=0&search_id=5162458312674377813&search_query=周见智&csource=common_hpsearch_null_null&spm_id_from=333.337.search-card.all.click