在前面章节中介绍了如何使用LLama_Factory微调大模型,并将微调后的模型文件合并导出,本节我们我们看下如何使用ollama进行调用。

1、llama.cpp

LLama_Factory训练好的模型,ollama不能直接使用,需要转换一下格式,我们按照ollama官网的提示使用llama.cpp来进行实现。

1.1 安装llama.cpp

下载 llama.cpp

git clone https://github.com/ggerganov/llama.cpp.git

cd llama.cpp

# 安裝 Python 相依套件

pip install -r requirements.txt

1.2 格式转换

python convert_hf_to_gguf.py /root/LLaMA-Factory-main/Qwen2-0.5B-Chat_all \

> --outfile /root/LLaMA-Factory-main/Qwen2-0.5B-Chat_all/Qwen2-0.5B-Chat_829.gguf

- /root/LLaMA-Factory-main/Qwen2-0.5B-Chat_all :微调后合并的模型文件路径

- /root/LLaMA-Factory-main/Qwen2-0.5B-Chat_all/Qwen2-0.5B-Chat_829.gguf :转换后的文件路径和名称

速度很快

2、ollama启动模型

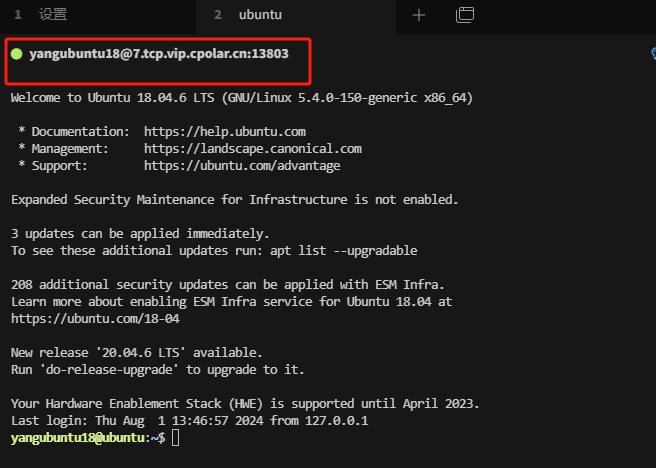

2.1 Linux安装ollama

curl -fsSL https://ollama.com/install.sh | sh

如果服务器网络不好无法下载,可以先下载到本地再上传

下载地址:https://ollama.com/download/ollama-linux-amd64.tgz

解压安装:sudo tar -xzf ollama-linux-amd64.tgz -C /usr/local/

2.2 加载模型

要导入 GGUF 模型到 Ollama 中,您需要创建一个名为 ModelFile 的文件,并在其中包含指定的内容。以下是如何创建这个文件的步骤:

-

选择创建文件的目录

需要确定把ollama相关的配置文件放在那个目录,比如在主目录中创建一个专用目录来存放模型文件:mkdir -p ~/ollama_models/my_model cd ~/ollama_models/my_model -

创建

ModelFile文件

在进入目标目录后,使用以下命令创建一个名为ModelFile的文件:touch ModelFile -

编辑

ModelFile文件接下来,使用您熟悉的文本编辑器(如

nano、vi或vim)打开并编辑ModelFile文件。例如,使用nano编辑:nano ModelFile在文件中输入以下内容,将

/path/to/file.gguf替换为 GGUF 文件的实际路径:FROM /path/to/file.gguf例如,我的 GGUF 文件位于

FROM /root/LLaMA-Factory-main/Qwen2-0.5B-Chat_all/Qwen2-0.5B-Chat_829.gguf,则内容应为:FROM /root/LLaMA-Factory-main/Qwen2-0.5B-Chat_all/Qwen2-0.5B-Chat_829.gguf -

保存并关闭文件

在编辑完成后,保存文件并退出编辑器:

- 在

nano中,按Ctrl + O保存,按Enter确认保存路径,然后按Ctrl + X退出编辑器。 - 在

vi或vim中,按Esc键,然后输入:wq保存并退出。

- 在

-

使用 Ollama 导入模型

完成

ModelFile文件的创建后,使用 Ollama 的命令来导入该模型:ollama create my-model -f /root/ollama_models/my_model/ModelFile在上述命令中,

my-model为模型选择的名称。

-

查看创建的模型

-

运行模型