1. BaseInfo

| Title | CAS-ViT: Convolutional Additive Self-attention Vision Transformers for Efficient Mobile Applications |

| Adress | https://arxiv.org/pdf/2408.03703 |

| Journal/Time | 202408 |

| Author | 清华 |

| Code | https://github.com/Tianfang-Zhang/CAS-ViT |

| Read | 20240829 |

| Table | VisonTransformer |

2. Creative Q&A

- ViT 矩阵运算计算量大 -> CAS-ViT: Convolutional Additive Self-attention Vision Transformers 平衡效率和结果,轻量化的 backbone

是 ViT 的进一步改版,可以应用在 image classfication、object detection 、 instance segmentation 、 semantic segmentation

主要的创新在注意力模块。

3. Concrete

3.1. Model

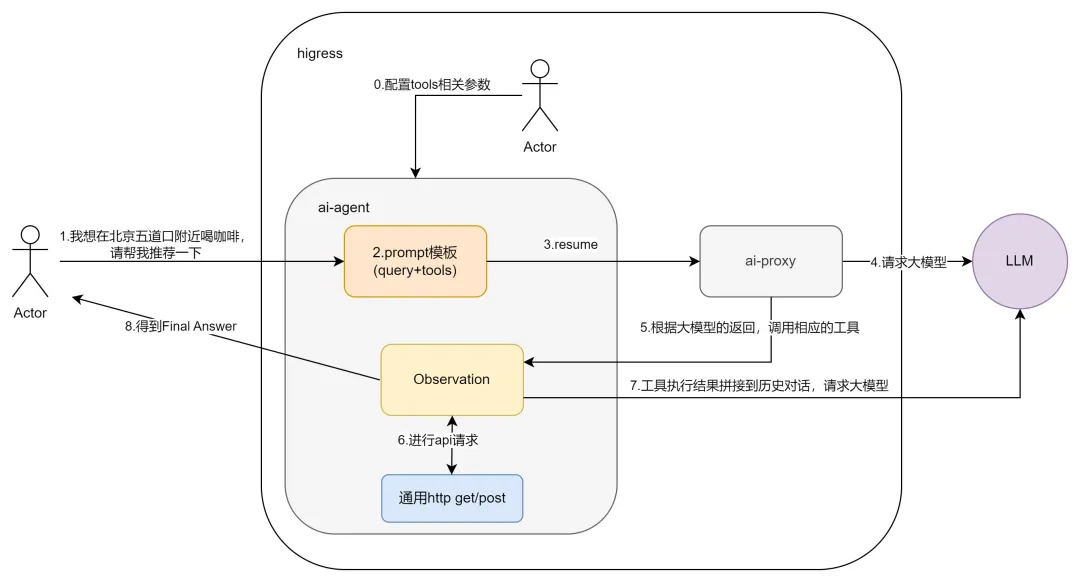

a 是经典多头注意力

b 是 MobileViTv2 ,将最后的 NxN 矩阵变为了 1xC 的向量

c 是 SwiftFormer,去掉 V

d 是本文提出的卷积加和注意力,对空间和通道做了融合。

以分类为例。

下采样 4、8、16、32。

主要有 3 个部分,Integration subnet(借鉴 SwiftFormer 由 ReLU 激活的 3 个卷积层 ), CATM and MLP.

CATM 中的 空间和通道提取特征部分

SpatialOperation 只处理一个通道,为输入特征图的每个位置赋予了不同的权重

ChannelOperation, 它为输入特征图的每个通道赋予了不同的权重

3.1.1. Input

图片

3.1.2. Backbone

| Model | Paras(M) |

|---|---|

| CAS-ViT-XS | 3.20 |

| CAS-ViT-S | 5.76 |

| CAS-ViT-M | 12.42 |

| CAS-ViT-T | 21.76 |

3.2. Training

3.2.1. Resource

16 V100 GPUs

3.2.2 Dataset

- ImageNet-1K

- ADE20K

- COCO val2017

几个经典数据集

3.3. Eval

- ImageNet-1K Classification

- Semantic segmentation result on ADE20K

- Object detection and instance segmentation performance on COCO val2017

3.4. Ablation

- CATM 的有效性

- 空间和通道注意力的有效性

- Q 和 K 的不同

4. Reference

- CNN-ViT 混合 [1] HATAMIZADEH A, HEINRICH G, YIN H, et al. FasterViT: Fast Vision Transformers with Hierarchical Attention[J]. 2023.

- PVTv2 [2] WANG W, XIE E, LI X, et al. PVT v2: Improved baselines with Pyramid Vision Transformer[J/OL]. Computational Visual Media, 2022: 415-424. http://dx.doi.org/10.1007/s41095-022-0274-8. DOI:10.1007/s41095-022-0274-8.

- FLatten Transformer: Vision Transformer using Focused Linear Attention 关注线性注意力模块 Focused Linear Attention

- EdgeViTs: Competing Light-weight CNNs on Mobile Devices with Vision Transformers

- EfficientViT: Memory Efficient Vision Transformer with Cascaded Group Attention

- SwiftFormer: Efficient Additive Attention for Transformer-based Real-time Mobile Vision Applications

- EdgeViTs: Competing Light-weight CNNs on Mobile Devices with Vision Transformers

5. Additional

代码挺简单的,主要看 CAS-ViT/classification/model/rcvit.py

实验部分的实验设置写的也挺详细。因为重点不在这就略过不写了。

Limitation 收敛速度快但可能模型越大或者数据集越大效果就不太好了。

结构确实简,参数量很小,试一下效果。