本文背景

为什么我的AI不听话?

为什么我用AI写知乎文、视频文案、豆瓣影评、工作日报、论文、商业策划案、标书、代码都一直得不到想要的效果?

为什么我的AI生成的都是没有价值的口水文?

大象经过大量的AI实战经验,给出了这些问题的终极解决方案:【抓住垂类特征+炼制prompt模版】,万物皆可AI。一次炼制,长期收益。

本系列教程将给大家讲透炼制模板的前因后果,并保姆级奉上3类提示词模板炼制的方法套路。

提示词模板=开发提示词+提取变量

有的小伙伴说了,1+1=2我还不会呢,你一上来就开始教我推导出自己的数学公式的玩法了?

别急,我们前半部分内容,就给大家恶补AI技巧合集,那一切复杂的应用,拆解开来,底层都是这些小知识点的排列组合和应用。所以,基础玩法不难,但非常重要。

同时,你将掌握AI底层认知:用好AI的底层逻辑。底层逻辑搞不清,走的永远是弯路。

这次重新整理课程将会非常干,绝对是市面收费599的课程还看不到的内容,这次只是第一期,后面还有11期也会陆续发出,赶紧三连关注,坐稳发车。

向 chatgpt 提问的策略

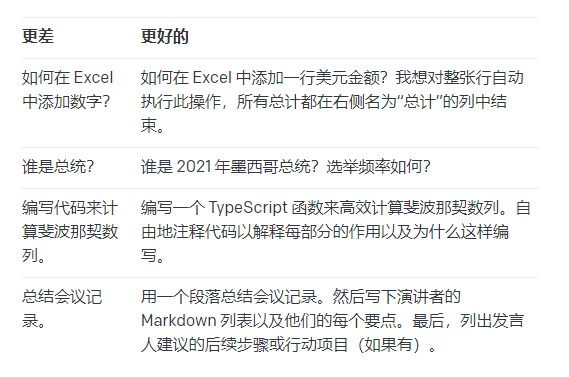

语义清晰明确

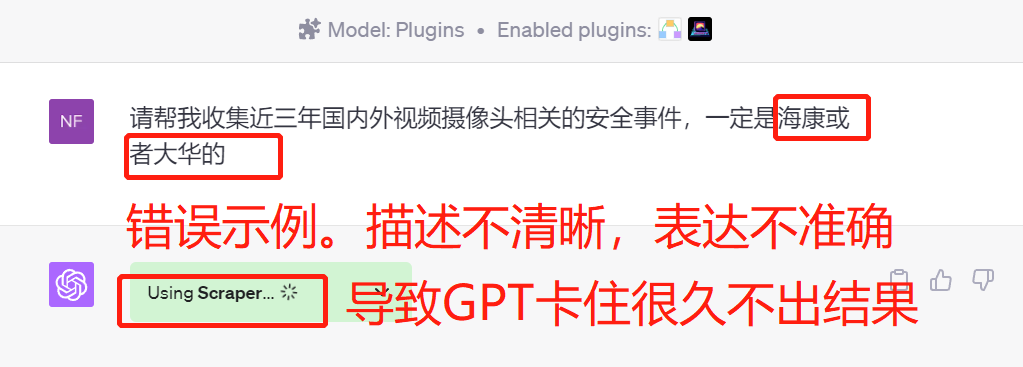

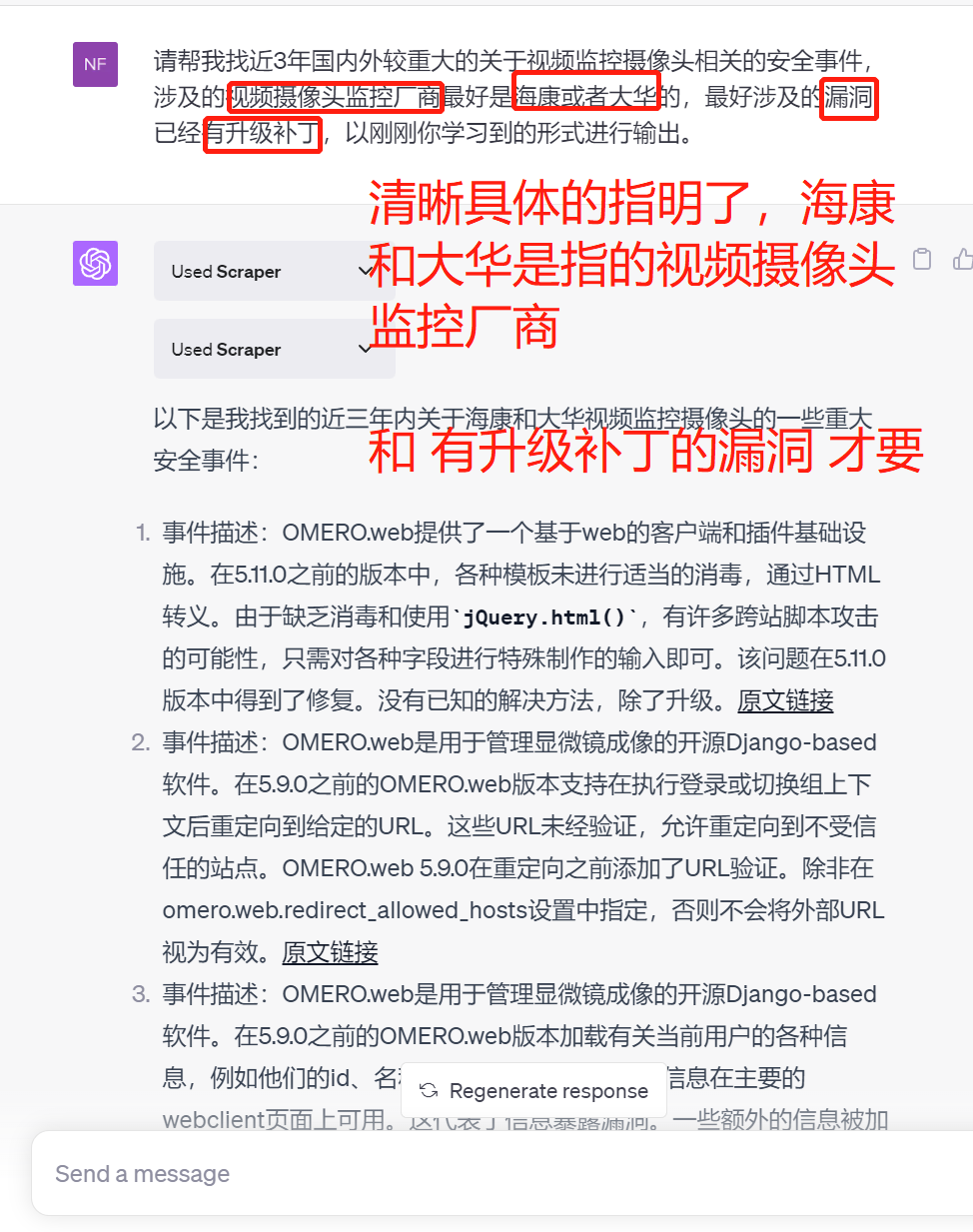

保证提问清晰,没歧义。像人类说的有些“行话”,AI 不太懂,要跟它说清楚,“模型越少猜你要啥,你得到想要的可能性越大”。

错误示例

正确示例

不要有多余的废话

多余话会让 GPT 弄不清你的核心问题,它就跟小孩似的,你说多了,它注意力就跑了。

要注意,长的输入文本和回答可能影响 GPT 响应时间和生成质量。想有好结果,问题得简洁,别太长。

错误示例

“您好,我希望能够得到关于历史上著名的物理学家艾萨克·牛顿的一些信息。我想知道他的生平经历,包括他的早年生活、教育背景、科学成就以及他对物理学和数学的贡献。如果可能的话,我还希望了解他对自然哲学的观点以及他的思想对现代物理学的影响。请尽可能详细地回答这些问题,谢谢”

正确示例

“请提供关于艾萨克·牛顿的简要生平、科学成就以及对现代物理学的影响”

描述更加具体

在简洁的基础上,可以让指令更具体,更好表达需求。

AI 学的知识多。你问题太泛,它就从众多知识里找大众答案。你问题具体,AI 就能找到你要的那个具体答案。

“GPT 越少猜你要啥,你得到心里想要的结果的可能性越大”。

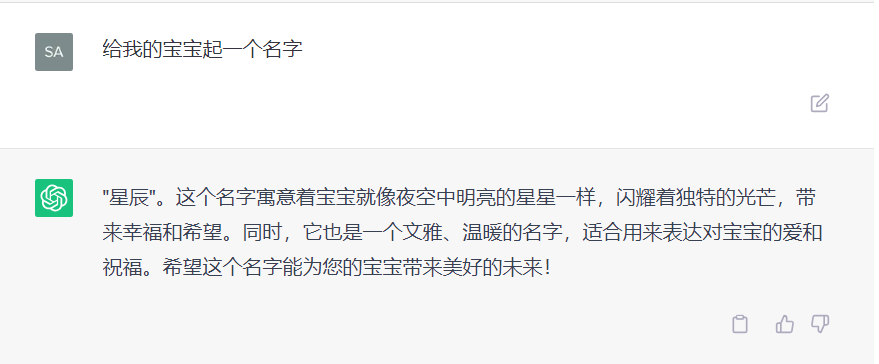

优化前

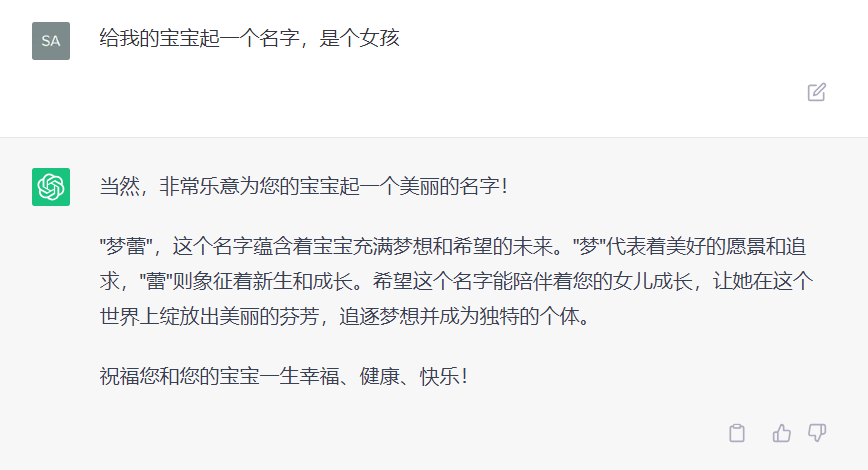

但是,我家宝宝是女孩,星辰更像男孩名字。这时,你可以更具体地让 GPT 回答,答案会更准更合适。

优化后

这个答案更符合需求啦

官方案例

任务拆解法

使用场景

任务复杂,一步搞不定,就得拆成几步。

这用的是链式思考 CoT(Chain Of Thought),就是一步接一步,一点点思考 Think-Step-By-Step,逐步解决,更清楚。

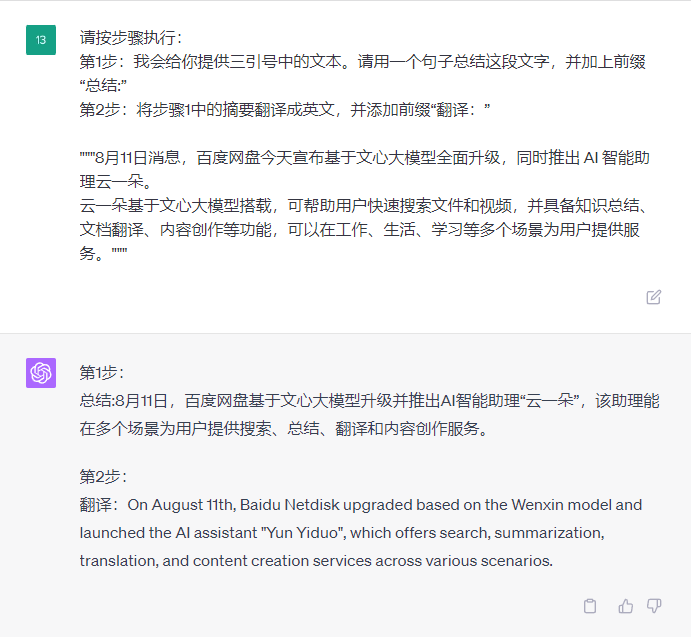

情况 1:拆成多个步骤,还是一个提示词。

不太复杂的任务,可以在一个提示词里给明确的多个步骤,让 GPT 按步骤做。只要对话一次。

情况 2:拆成多个小任务,每个任务是一个单独的提示词。

一句提示词说不清所有步骤的更复杂任务。要把大任务拆成多个小任务,每个小任务用一个提示词搞定。小任务还复杂,就接着拆。

很典型的情况,AI 一次只能输出 1000 字左右,你想让它一次写 5000 字,不可能,就得拆成多次(多个小任务),一个个输出。

案例

情况 1,稍复杂任务,拆成多个步骤执行。

请按步骤执行: 第 1 步:我会给你提供三引号中的文本。请用一个句子总结这段文字,并加上前缀“总结:” 第 2 步:将步骤 1 中的摘要翻译成英文,并添加前缀“翻译:”

"""8 月 11 日消息,百度网盘今天宣布基于文心大模型全面升级,同时推出 AI 智能助理云一朵。 云一朵基于文心大模型搭载,可帮助用户快速搜索文件和视频,并具备知识总结、文档翻译、内容创作等功能,可以在工作、生活、学习等多个场景为用户提供服务。"""

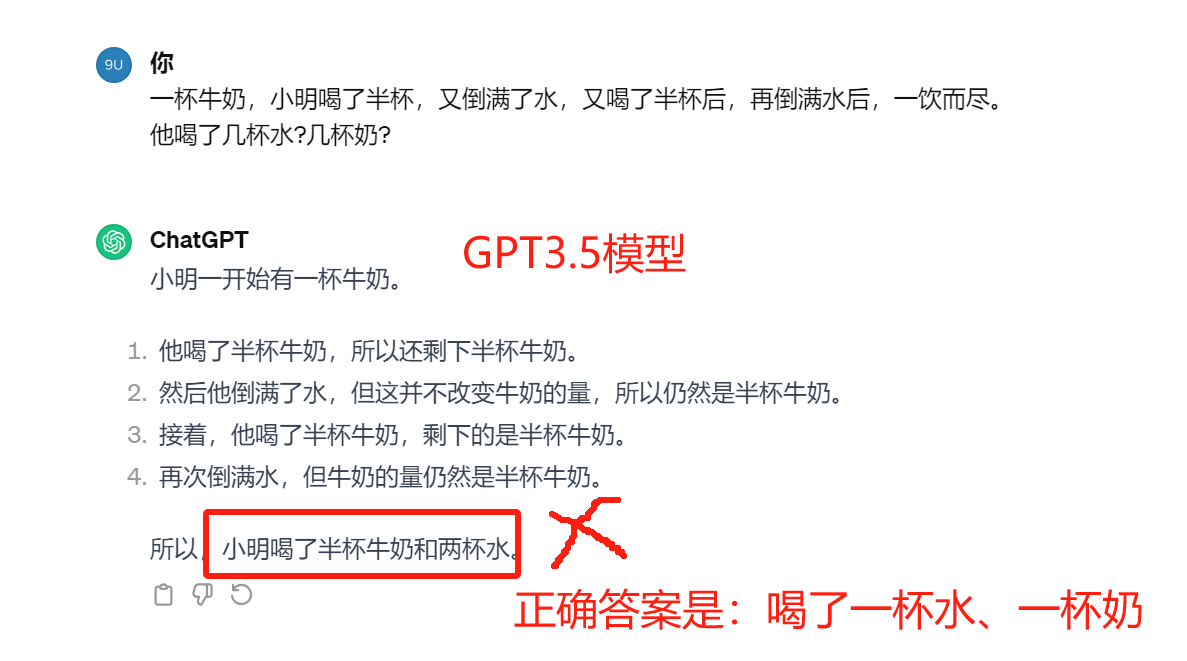

情况 2,复杂任务,拆成多个小任务逐一执行。

还记得用【一杯水问题】判断 AI 模型是 GPT3.5 还是 GPT4 模型的事吗?

GPT4 能完美直接给答案,它更智能,而 GPT3.5 智能度弱,直接给的答案错。

为啥 GPT3.5 计算错?因为整个计算流程对它的语言分析计算能力来说太复杂。学会任务拆解技巧后,咱就来拆任务,让 GPT3.5 一步步算。

原本的提示词:

一杯牛奶,小明喝了半杯,又倒满了水,又喝了半杯后,再倒满水后,一饮而尽。

他喝了几杯水?几杯奶?

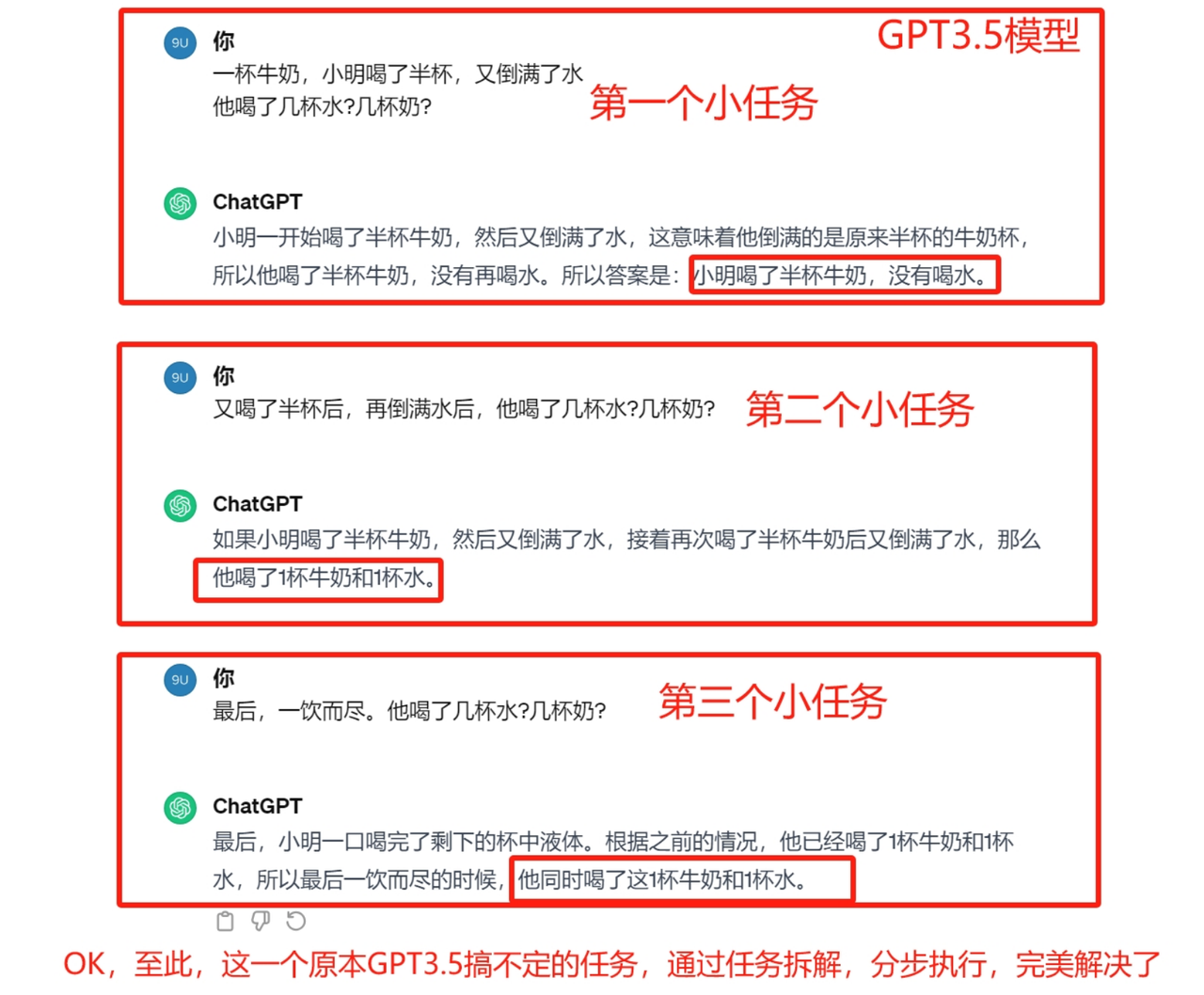

任务拆解后的提示词:

一杯牛奶,小明喝了半杯,又倒满了水(没喝),

他喝了几杯水?几杯奶?

又喝了半杯后,再倒满水后(没喝),

他喝了几杯水?几杯奶?

最后,一饮而尽。

他喝了几杯水?几杯奶?

优化后提示词:

【任务】

请按【步骤】依次执行

【步骤】

1.一杯牛奶,小明喝了半杯,又倒满了水,他喝了几杯水?几杯奶?

2.又喝了半杯后,再倒满水后,他喝了几杯水?几杯奶?

3.最后,一饮而尽。他喝了几杯水?几杯奶?

要是你的需求更复杂,比如写一篇高质量的深度原创文章,要投稿或发在公众号、知乎平台上。那就把这大任务拆成多个不复杂的小任务:爆款标题咋写、文章素材咋采集、文章框架咋搭、爆点埋在哪、开头咋留人、结尾咋吸引关注、要不要给其他文章埋伏笔做引流等等。再把一个个小任务交给 GPT 完成

深度原创文章重点是你心里有想法跟读者说,但写作能力一般,抓不住读者兴趣点,AI 当辅助工具,帮忙搜集素材、润色内容、部分创作、提供灵感思路等。这案例得单独一篇教程才能讲透,每步都得精心设计任务。这大家知道大任务拆小任务的思路就行。

让 GPT 思考过程对我保密

使用场景

当把大任务拆解给 GPT 并想让特定步骤对你不可见时,这个方法得会。

案例

过程不保密的提示词:

1.先根据问题想解决方案 2.比较你的和学生的方案,评估学生的对错 3.学生错了,确定不泄露答案能给啥提示 4.学生错了,给上步提示,写“提示:”

问题:盒子里 4 红 6 蓝球,取 2 个无放回,一红一蓝概率多少? 学生方案:(4/10)*(6/9)=24/90=4/15

现在想 1 - 3 步 GPT 内部思考,对我保密。学生错了,GPT 给提示,别给答案。

中间步骤保密的提示词:

1.想方案,保密,别说话 2.比较方案并评估,保密,别说话 3.确定提示,保密,别说话 4.学生错了,给提示,写“提示:”

问题和学生方案同上。

完美!

提供正向示例

使用场景

不会组织语言表达时,给 GPT 示例让它模仿,要优质正向的。

请以一致风格回答。 示例: """ 请用优美文字教我啥是耐心:最伟大交响乐从一个音符开始;最复杂挂毯从一根线开始;河流从温和泉水冲出深谷 """ 请用优美文字,教我啥是海洋

案例

看,GPT 完美模仿了示例~

可以给反向示例,但效果没正向好,不建议,感兴趣可试试。

投喂素材

使用场景

有素材想快速提问或写作,就给 GPT。素材精准效果好。

素材内容占比影响输出,想改变就改占比。

案例

用三引号文本回答问题,找不到答案写“我找不到答案”。 【素材】: """ 最近,AI 初创公司 Runway 宣布产品开放,能生成视频但画质等被吐槽,网友探索出新玩法。 """ 【素材】: """ 推特博主“Max”视频获高播放,用多种工具制作,内容是 2095 年空间站的事。 """ 问题:AI 生成视频咋操作

对于普通人,缩短投喂字数就行,比如把大文本拆段让 GPT 缩短再组合。

为啥只投喂简介?有人问海盐,现在从原理解答。

我们说过 AI 生成内容是下一字更大概率出现。喂万字小说让总结,还是口水文。为啥?

因为高质量推荐文重要的不是读完小说,而是用写作手法展现个性想法。看简介或文评知道写啥,就能教 AI 生成个性化点子(读后感教程里海盐用过),写出高质量推荐文。

所以大多情况,让 AI 知道简介,教写作手法就能出优质内容。喂 10000 字原著,按原理会有很多冗长内容,不是优质推荐文。

指定输出的字数

使用场景

对 GPT 输出字数有要求,直接告诉它。

案例

用 20 个字总结三引号里的文本。 """8 月 8 日消息……"""

20 多个字,还行。

指定输出的要点个数

使用场景

明确告诉 GPT 要生成几个要点。

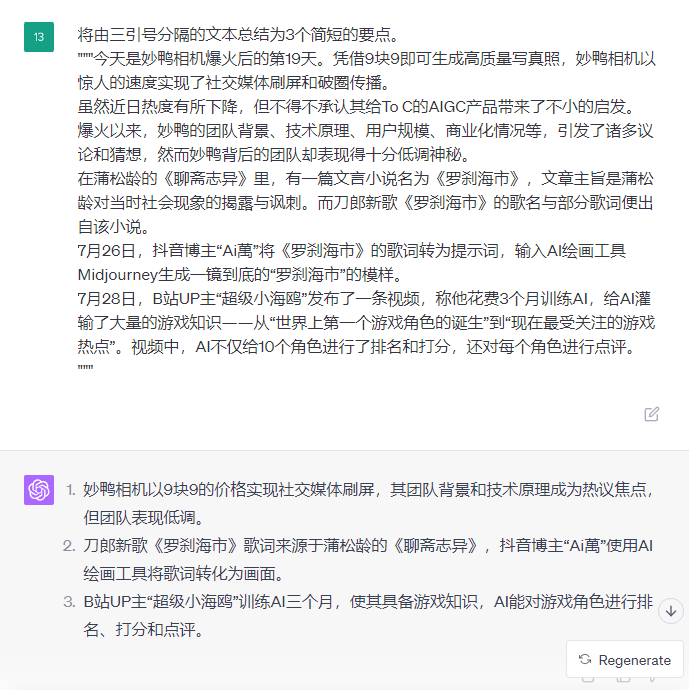

案例

把三引号里的文本总结为 3 个要点。 今天是妙鸭相机爆火后的第 19 天 妙鸭相机凭借 9 块 9 就能生成高质量写真照,迅速在社交媒体上刷屏并破圈传播。虽说近日热度有所下降,但它确实给 To C 的 AIGC 产品带来不少启发。

爆火以来,妙鸭的团队背景、技术原理、用户规模、商业化情况等引发诸多议论和猜想,但其团队却相当低调神秘。

在蒲松龄的《聊斋志异》中,有篇文言小说叫《罗刹海市》,主旨是对当时社会现象的揭露与讽刺。刀郎新歌《罗刹海市》的歌名与部分歌词就源于此小说。

7 月 26 日,抖音博主“Ai 萬”把《罗刹海市》的歌词作为提示词,输入 AI 绘画工具 Midjourney,生成了一镜到底的“罗刹海市”画面。

7 月 28 日,B站 UP 主“超级小海鸥”发了个视频,说他花 3 个月训练 AI,给 AI 灌输大量游戏知识,从“世界上第一个游戏角色的诞生”到“现在最受关注的游戏热点”。视频里,AI 不仅给 10 个角色排名打分,还逐个点评。

我们不爱看长篇新闻的浮躁毛病有救啦!

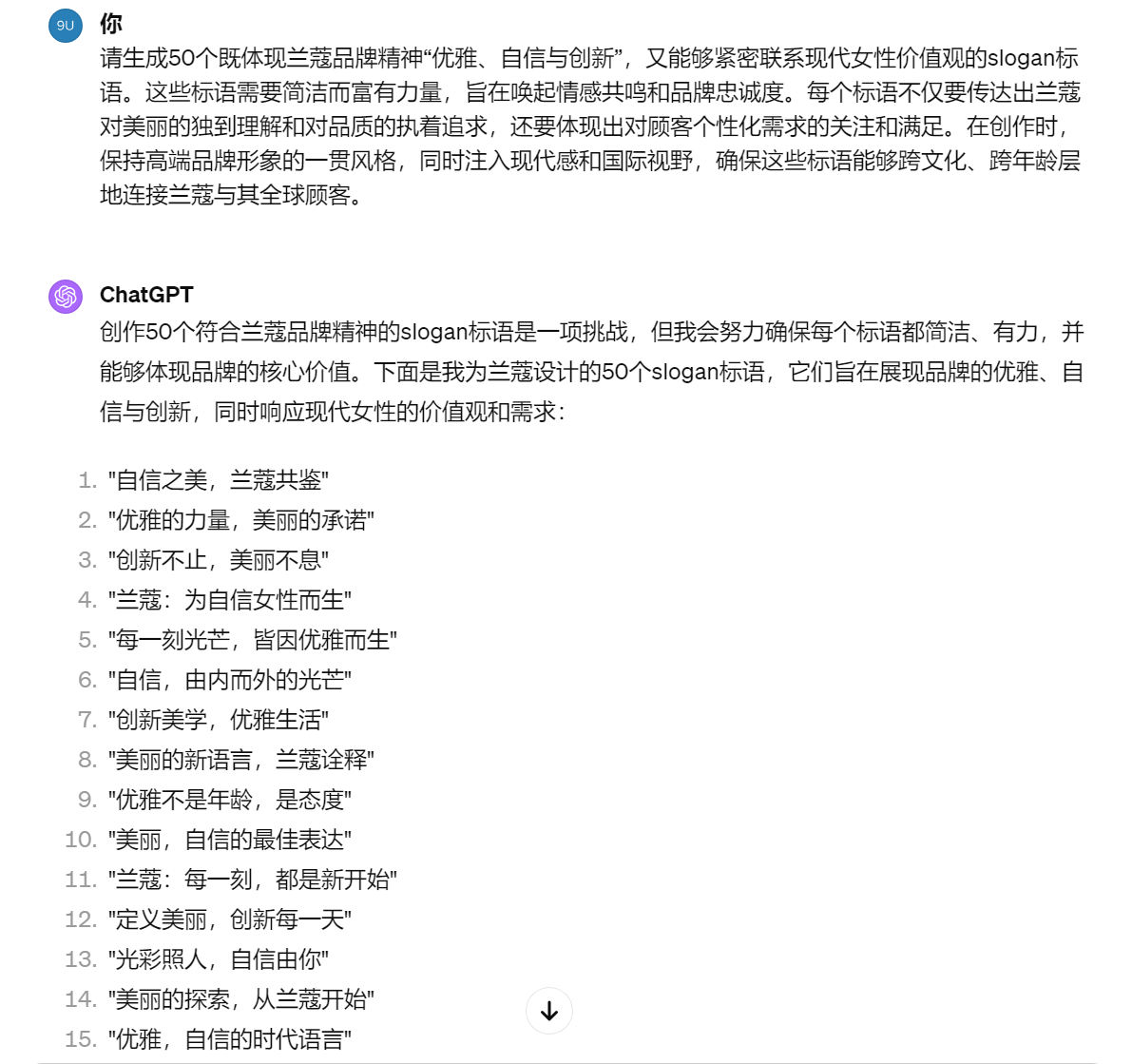

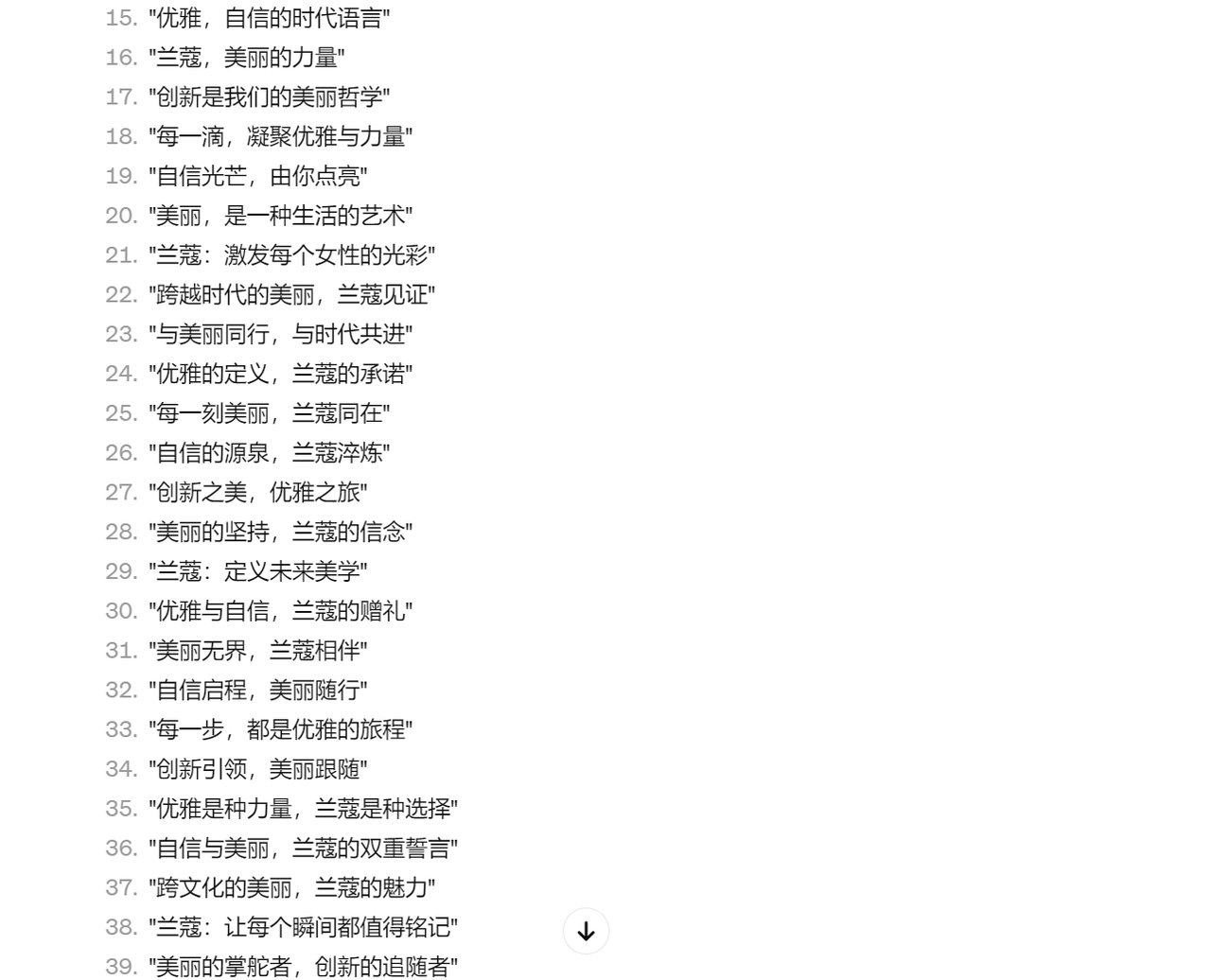

指定产出物的数量

使用场景

当 AI 产出的内容字数少,可以一次生成多个,咱能挑个最喜欢的。这样能避免一次出一个,不合适还得重新来,批量生成更高效。

案例

请扮演 ChatGPT 专属提示词生成器,运用角色扮演法和优质特征投喂法(比如:1. 得符合品牌调性,2. 高端简洁)。写个提示词,作用是生成 10 个兰蔻品牌的 slogan 标语

请生成 10 个既体现兰蔻品牌精神“优雅、自信与创新”,又能紧密联系现代女性价值观的 slogan 标语。这些标语要简洁有力,能唤起情感共鸣和品牌忠诚度。每个标语既要传达兰蔻对美的独特理解和对品质的执着追求,也要体现对顾客个性化需求的关注和满足。创作时,保持高端品牌形象的一贯风格,同时注入现代感和国际视野,确保这些标语能跨文化、跨年龄层连接兰蔻和全球顾客。

这 10 个里,总有您喜欢的。要是还没有,一次批量出 30 个、50 个。

先让 GPT 作答

这是 openai 的建议策略,原名是“给 ChatGPT 时间思考”。思考啥?其实就是先让 GPT 给出一份答案。所以,海盐起了个更直观的名儿“先让 GPT 作答”

使用场景

您有没有过这种经历,您和张三比赛解数学题,看谁答案对。要是您事先参考了张三的推理思路,您的思维有时就被限制住了,跟着张三的思路走,哪怕张三中间有错,有坑,您也不容易发现,还觉得他挺对。

但要是您自己做,没看别人的思路,您的整个推理过程会更严谨,大概率全对。

同理,您让 GPT 去判断张三的答案对错时,GPT 也会像人一样,有这问题,容易被张三错误的思路带偏,觉得张三说得好对。敲黑板,这种假象,也叫 AI 幻觉。

所以,在 AI 的世界里,解决 AI 幻觉最好的办法,和人一样,您先让 GPT 给出一个答案,然后再让它去对比张三的方案,判断张三的答案对不对。

另外,如果您单纯问 AI 问题,现阶段的 AI,还没法自己验证生成结果的准确度,偶尔会产生 AI 幻觉。要是您需要 100%正确的答案,就人工去搜索引擎、论文、书籍等传统媒介简单找找答案,查证一下就行。

错误案例

GPT:天啊,我好像产生幻觉啦!

正确案例

先给出自己的问题解决方案。然后把您的解决方案和张三的解决方案对比,评估张三的方案对不对。在您自己完成问题前,别决定张三的方案对不对。

问题陈述:我正在建造一个太阳能发电装置,我需要帮忙解决财务问题。- 土地成本为 100 美元/平方英尺 - 我能以 250 美元/平方英尺的价格买太阳能电池板 - 我协商了一份维护合同,每年要花我 10 万美元,另外第一年运营还要额外花 10 美元/平方英尺作为平方英尺数的函数

张三的解决方案:设 x 为装置的尺寸(以平方英尺为单位)。1. 土地成本:100x 2. 太阳能电池板成本:250x 3. 维护成本:100,000 + 100x 总成本:100x + 250x + 100,000 + 100x = 450x + 100,000

GPT:张三,你可骗不了我啦!

二次确认

使用场景

对话完,问问模型之前的过程里有没有遗漏啥内容。

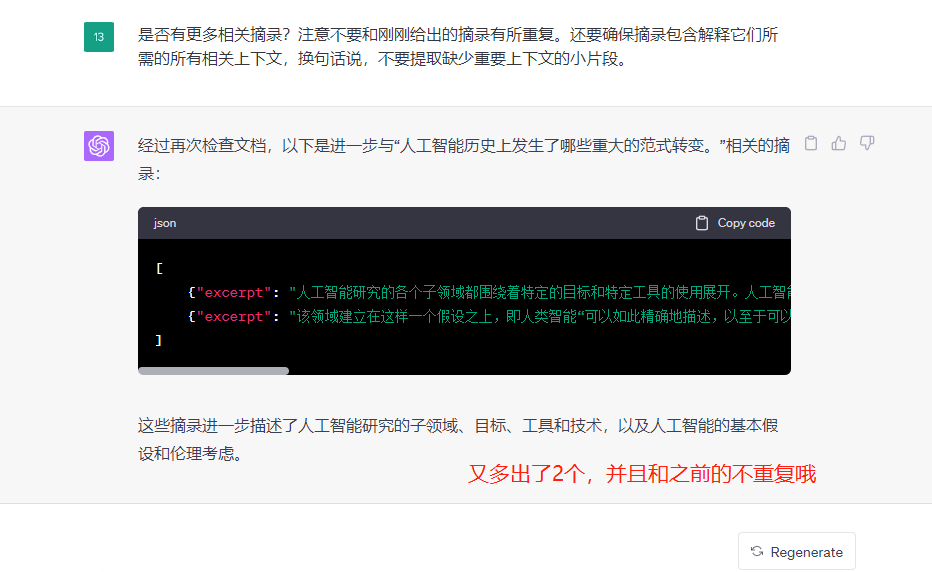

假设我们正用 GPT 从一个文本里提取摘录。列完一个摘录后,GPT 得确定是接着写另一个摘录还是停下。要是源文档很大,GPT 通常没读完就停,没法列出所有摘录。这种情况,用二次确认,提示 GPT 找找之前错过的摘录,一般能有更好的效果。

案例

我给您一份用三引号分隔的文档。您的任务是挑出和下面问题相关的摘录:“人工智能历史上发生了哪些重大的范式转变。”,还得保证摘录有解释它们需要的所有相关上下文,换句话说,别提取缺重要上下文的小片段。用 JSON 格式输出,像这样: [{"excerpt": "..."},... {"excerpt": "..."}]

"""

人工智能作为一门学术学科成立于 1956 年,在此后的几年里,它经历了几次乐观的浪潮,[4][5]之后是失望和资金损失(被称为“人工智能冬天”),[6][7]之后是新的方法、成功和新的资金。[5] [8]人工智能研究尝试并放弃了许多不同的方法,包括模拟大脑、建模人类解决问题、形式逻辑、大型知识数据库和模仿动物行为。在 21 世纪的头几十年里,高度数学和统计的机器学习占据了该领域的主导地位,事实证明,这项技术非常成功,帮助解决了整个行业和学术界的许多具有挑战性的问题。[8] [9]

人工智能研究的各个子领域都围绕着特定的目标和特定工具的使用展开。人工智能研究的传统目标包括推理、知识表示、规划、学习、自然语言处理、感知以及移动和操纵物体的能力。[a] 一般智力(解决任意问题的能力)是该领域的长期目标之一。[10] 为了解决这些问题,人工智能研究人员调整并整合了一系列解决问题的技术,包括搜索和数学优化、形式逻辑、人工神经网络以及基于统计学、概率论和经济学的方法。人工智能还借鉴了计算机科学、心理学、语言学、哲学和许多其他领域。

该领域建立在这样一个假设之上,即人类智能“可以如此精确地描述,以至于可以制造一台机器来模拟它”。[b] 这引发了关于创造具有类人智能的人造人的思想和伦理后果的哲学争论;自古以来,神话、小说和哲学都曾探讨过这些问题。[12] 此后,计算机科学家和哲学家提出,如果人工智能的理性能力不能朝着有益的目标发展,它可能会成为人类生存的风险。[c] 人工智能一词也因夸大人工智能的真实技术能力而受到批评。[13] [14][15]

历史

主要文章:人工智能的历史和人工智能的时间线

克里特岛的银色迪德拉克马,描绘了具有人工智能的古代神话机器人塔洛斯

人工智能在古代作为讲故事的工具出现[16],在小说中很常见,比如玛丽·雪莱的《弗兰肯斯坦》或卡雷尔·恰佩克的《R.U.R.[17]这些人物及其命运引发了许多与人工智能伦理中现在讨论的问题相同的问题。[18]

对机械或“形式”推理的研究始于古代的哲学家和数学家。对数理逻辑的研究直接导致了艾伦·图灵的计算理论,该理论认为,机器通过打乱“0”和“1”这样简单的符号,可以模拟任何可以想象的数学推导行为。这种数字计算机可以模拟任何形式推理过程的见解被称为丘奇-图灵论文。[19] 这一发现,加上神经生物学、信息论和控制论的同时发现,促使研究人员考虑构建电子大脑的可能性。[20] 现在被普遍认为是人工智能的第一件作品是 McCullouch 和 Pitts 1943 年为图灵完成的“人工神经元”的正式设计。[21]

到 20 世纪 50 年代,出现了两种关于如何实现机器智能的愿景。一种被称为符号 AI 或 GOFAI 的愿景是使用计算机来创建世界的符号表示和可以对世界进行推理的系统。支持者包括艾伦·纽厄尔、赫伯特·A·西蒙和马文·明斯基。与这种方法密切相关的是“启发式搜索”方法,它将智能比作探索可能性空间的问题

"""

因为输入的文案太长,GPT 很可能没读到结尾就停了,或者就算读完了,因为字数太多,中间有些也会漏掉没提取。

咱想效果更好,可以二次确认。

有没有更多相关摘录?注意别和刚给的重复。还得保证摘录有解释它们需要的所有相关上下文,换句话说,别提取缺重要上下文的小片段。

AI 还没法万分严谨地准确摘录所有点不遗漏,要是您不是做高精度学术研究,用 AI 就够了。

本文由 mdnice 多平台发布

![[VG] TransVG++](https://i-blog.csdnimg.cn/direct/6d0181d4703342c7823030a7cc87986c.png)