发表时间:(CoRL 2020)

论文链接:https://readpaper.com/pdf-annotate/note?pdfId=4546337571360890881¬eId=2424798489658874880

作者单位:Carnegie Mellon University, USA

Motivation:人类能够通过推断他们的意图并使用过去的经验来实现相同的最终目标来无缝地模仿他人。换句话说,我们可以从原始视频中解析复杂的语义知识,并有效地将其转换为具体的运动控制。是否有可能给机器人提供同样的能力?

解决方法:先前关于机器人模仿学习的研究已经创建了可以从专家人类操作员那里获得不同技能的agent。然而,在测试期间扩展这些技术以使用单个正例仍然是一个开放的挑战。本文研究了允许机器人使用过去的经验部分弥合这些领域差距的技术(如何使用过去的经验文章没有说,应该是通过对上下文帧的学习?)。训练神经网络来模拟给定来自另一个agent的上下文视频的ground truth机器人动作,并且在测试时提示新视频时必须泛化到看不见的任务实例。 我们的策略表示必须是上下文感知和动态感知的,以便执行这些任务。

实现方式:但是一个人如何代表目标/意图以及如何将这种上下文信息合并到策略函数本身中?

先前工作中有三个主要方法:

第一种方法是通过生成目标图像将目标/意图表示为像素,然后在给定当前观察和推断目标的情况下推断动作[6,7]。虽然这种方法直观且可解释,但很难生成像素,其方式尊重图像中的结构差异。 第二种方法是将视觉模仿建模为ont-shot学习问题[8],可以用元学习算法来解决。在这里,机器人被赋予一个例子,以视频或演示的形式(例如视频 + 控制遥测),并且必须利用这些信息来执行相同任务的新实例。该演示用于更新策略函数的参数,并在机器人上执行更新后的策略。域间隙可以通过学习的自适应loss函数[10]来解决。虽然one-shot formalism非常有用,但从单个示例中估计策略参数可能是一个极其困难的问题,并且容易出现过度拟合。 在本文中,我们探索了第三种选择:one-shot学习的任务驱动特征。我们从目标agent和来自“教师”代理的演示帧处理观察结果,以提取上下文条件状态表示。

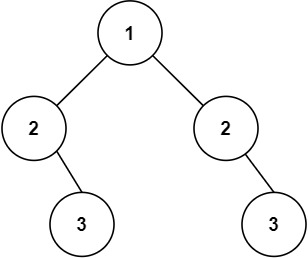

在本文中,我们提出使用Transformer(或非局部自注意力模块 )来提取关系特征(提取教师演示和traget agent的空间特征之间的关系),这些特征充当策略函数的输入状态向量。我们的transformers将来自教师演示和目标agent的空间 ResNet 特征作为输入。这允许策略通过使用上下文帧只关注重要的特定于任务的细节,自动将其特征适应手头的任务。例如,在图 1 中,机器人可以使用人类上下文帧只关注红色块位置等相关细节,并完全忽略桌子腿等分散注意力的元素(通过教师演示与traget agent之间的特征(经过resnet18提取)之间的自注意力)。(这也是本文使用Transformer的优势)

然而,transformer 特征在测试期间很容易最终错误地加权重要细节。我们建议通过使用无监督逆动力学损失进一步监督状态表示学习来解决这个问题。这种损失限制了学习问题并确保最终表示可以对底层动态以及特定于任务的细节进行建模。(无监督逆动力学损失为什么能做到作者说的这一点尚不明确)

模型结构:主要创新两点:Transformers architecture+ a self-supervised inverse modelling objective

损失:通过行为克隆损失、逆建模损失和监督机器人在图像中未来像素位置的可选点损失进行端到端训练。

输入:在注意力模块之前,来自上下文视频和当前状态的单个图像都通过 ResNet-18 架构传递。

输出:the final output f (x) =batchnorm(x + dropout(O)), with final size [512, T, H, W ]. In order to appropriately apply this to behavior cloning (where ot+1 is not known during test time), we make this operation causal by appropriately padding the 3D convolution operators and masking the attention.

实验:in simulation using multi-agent MuJoCo environments.(没有 real word)

Our method is the only one which can reliably perform new task instances.

结论:two technical contributions :Applying the Transformers architecture to one-shot imitation tasks and a self-supervised inverse modelling objective.

这里的主要结论是,在网络设计和损失函数方面注入正确的偏差——可以帮助策略在测试期间表现更好。我们相信 Transformer 的注意力机制通过允许任务条件表示来提供这种偏差,而逆模型强制policy保留在测试期间稳健控制所需的信息。