I算力资源池建设正当时

随着深度学习和计算机视觉领域的快速发展,各行各业对于AI算力资源的需求也在快速增长。AI算力池化不仅有助于提高资源的利用率,还可以提高工作效率、减少管理成本。今天就我们一起探讨如何组织和管理AI算力资源池、实现算力资源的合理分配和使用。

AI算力资源池的组织和管理目标

1、最大化资源利用率

灵活按需分配AI算力资源,最大化提升资源利用率,让所有可用AI算力资源都能被充分使用。

2、合理安排AI任务

优先为高级别(紧急重要)的AI任务分配GPU资源,确保优先处理紧急重要的任务;而低优先级的任务,能够在高优先级任务完成后自动运行,让资源分配、管理更科学。

3、资源集中管理

将分散的AI算力资源整合到统一的资源池中,通过集中监控和管理,让管理员能够随时了解到AI算力资源池的运行情况;当AI算力资源池出现告警或故障时,管理员能够及时发现,避免故障扩散。

4、支持多用户

支持多用户,以便不同的用户可以同时使用AI算力资源,而不会互相干扰;每个用户的AI任务能够通过资源隔离实现任务隔离,确保AI任务安全、稳定地运行。

5、兼容多种异构云平台

兼容多元异构的云平台,提高AI算力资源池的灵活性和可扩展性。当企业需要扩展资源池的规模时,可以轻松地通过添加新节点来实现。

OrionX AI算力资源池化解决方案

趋动科技的OrionX AI算力资源池化解决方案帮助客户构建数据中心级AI算力资源池,使用户应用无需修改就能透明地共享和使用数据中心内任何服务器之上的AI算力,不但能够帮助用户提高资源利用率,而且可以极大便利用户应用的部署。

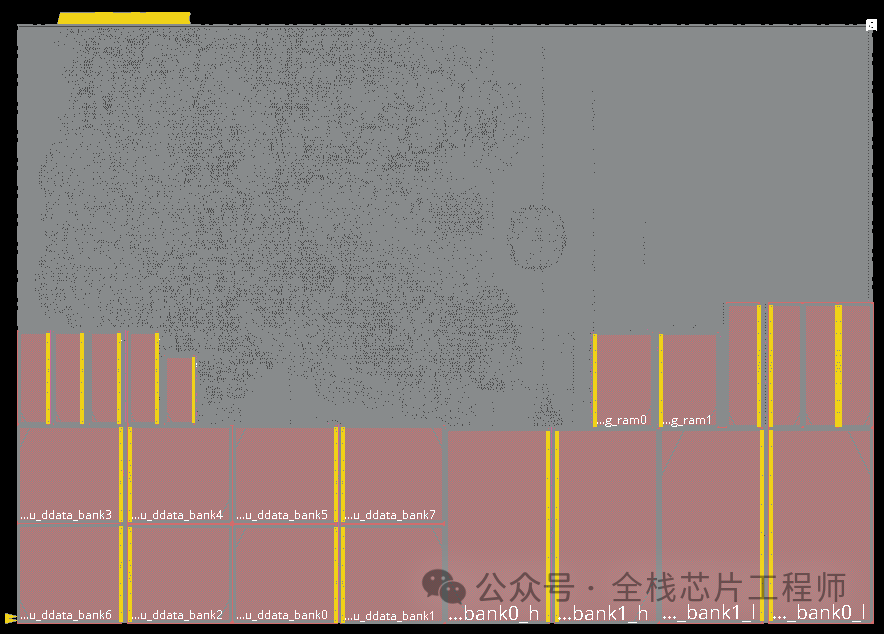

OrionX架构图

OrionX通过软件定义AI算力,颠覆了原有的AI应用直接调用物理硬件的架构,增加软件层,将AI应用与物理硬件 解耦合。AI应用调用逻辑的OrionX vGPU,再由 OrionX将OrionX vGPU需求匹配到具体的物理硬件。OrionX架构实现了AI算力资源池化,让用户高效、智能、灵活地使用 AI算力资源,达到了降本增效的目的。

OrionX功能介绍:

隔空取物

用户可以在一台没有GPU 的服务器上运行 AI应用,通过网络使用其他服务器上的远程算力资源。OrionX的隔空取物功能通过AI任务和AI算力资源解耦,能让AI任务更加快速上线,实现AI算力资源远程监控和管理等。

随需应变

基于OrionX的AI算力资源池,用户能够实现资源动态申请和释放、资源的切分,以及重要的AI任务能够按照优先级别进行排队等功能,以便满足不同任务优先级别的AI算力资源使用需求,最大限度提升AI算力资源利用率。

化零为整

用户可以将多台物理服务器上的算力资源聚合提供给单个虚拟机或容器使用;用户AI应用程序代码不需要修改,即可通过“隔空取物”方式,从多个远端服务器获取算力资源,以便快速地从算力资源池内找到可用资源,从而提高资源利用率。

化整为零

允许用户通过多个虚拟机或容器共享一块物理算力卡。多个虚拟机和容器都能根据需要从单个物理算力卡中分配和使用资源,并保证每个AI任务之间相互隔离。这种共享技术能有效减少因AI算力资源利用不充分导致的资源浪费,并能提高AI推理任务的效率和效果。

OrionX通过构建AI算力资源池,让企业内的AI用户共享数据中心内所有服务器上的AI算力。AI开发人员不必再关心底层资源状况,专注于更有价值的业务层面,让应用开发变得更加便捷。OrionX有如下优势:

1、提高利用率

OrionX支持切片任意大小的OrionX vGPU,从而允许多AI负载并行运行,提高 GPU综合利用率多达 3-10 倍,1 张卡相当于N 张卡的效果,真正做到昂贵算力平民化。

2、 高性能

相比于物理GPU,OrionX本地OrionX vGPU性能损耗几乎为零,远程OrionX vGPU性能损耗小于 2%。且OrionX vGPU间资源隔离,并行用户无资源互扰。

3、轻松弹性扩展

OrionX支持从单台到整个数据中心范围内的服务器纳管,全分布式部署,通过 RDMA(IB/RoCE)或 TCP/IP 网络连接各个节点,轻松实现AI算力资源池的弹性扩展。

4、灵活调度

OrionX支持CPU与AI算力资源解耦合,两种服务器可分开购买、按需升级、灵活调度,有助于最大化发挥数据中心基础设施价值。

5、全局管理

OrionX提供资源管理调度策略以及资源池全局性能监控,为运维人员提供直观的资源利用率等信息。

6、对AI开发人员友好

OrionX一键解决AI开发人员面临的训练模型中 AI算力/CPU 配比和多机多卡模型拆分问题,为算法工程师节省大量宝贵时间。

7、支持异构算力

OrionX支持异构算力的统一纳管,尤其是国产算力。通过这个能力,OrionX协助国产芯片建立软件生态,用户也可实现更加灵活和高效地管理和分配资源,从而满足不同用户的使用场景和需要。

总结

综上,一个被合理组织规划的AI算力资源池能够最大化提升资源的利用率,使每一个工作负载能够按照需求得到刚好的算力资源,在保证任务顺利完成的同时支持更多应用。

同时,能否兼容多种异构的云平台,包括 KVM、VMware、容器、K8S 等,也是AI算力资源池的建设重点。因为这决定着用户能否在不同的平台中获得更好的可移植性、灵活性和适用性。