目录

- 为什么高性能数据仓库模型如此重要?

- 设计高性能数据仓库模型的核心原则

- 案例研究:电子商务数据仓库设计

- 步骤1: 需求分析

- 步骤2: 选择适当的模型

- 步骤3: 定义事实表和维度表

- 步骤4: 设计星型模式

- 实施星型模式:步骤和最佳实践

- 优化查询性能的关键技术

- 数据仓库模型的演进和维护

- 常见陷阱和如何避免

- 总结与展望

想象一下,你正在为一家快速增长的电子商务公司工作。每天,你的平台产生数百万条交易记录、用户行为数据和库存信息。你的任务是设计一个能够处理这海量数据的数据仓库,不仅要能快速响应复杂的分析查询,还要为未来几年的业务增长做好准备。听起来像是一个令人兴奋又充满挑战的任务,对吧?

在这篇文章中,我们将深入探讨如何设计一个高性能的数据仓库模型,这不仅是一项技术,更是一门艺术。我们将通过一个实际的案例,逐步解析设计过程中的关键决策和技巧,帮助你掌握打造高效数据仓库的核心要素。

为什么高性能数据仓库模型如此重要?

在当今数据驱动的商业环境中,一个高性能的数据仓库模型可以成为企业的制胜法宝。它不仅能够提供快速、准确的分析结果,还能够支持复杂的数据挖掘和机器学习任务。然而,设计这样一个模型并非易事。它需要我们在数据结构、查询效率和可扩展性之间找到完美的平衡点。

让我们来看看一个高性能数据仓库模型能够带来的具体好处:

-

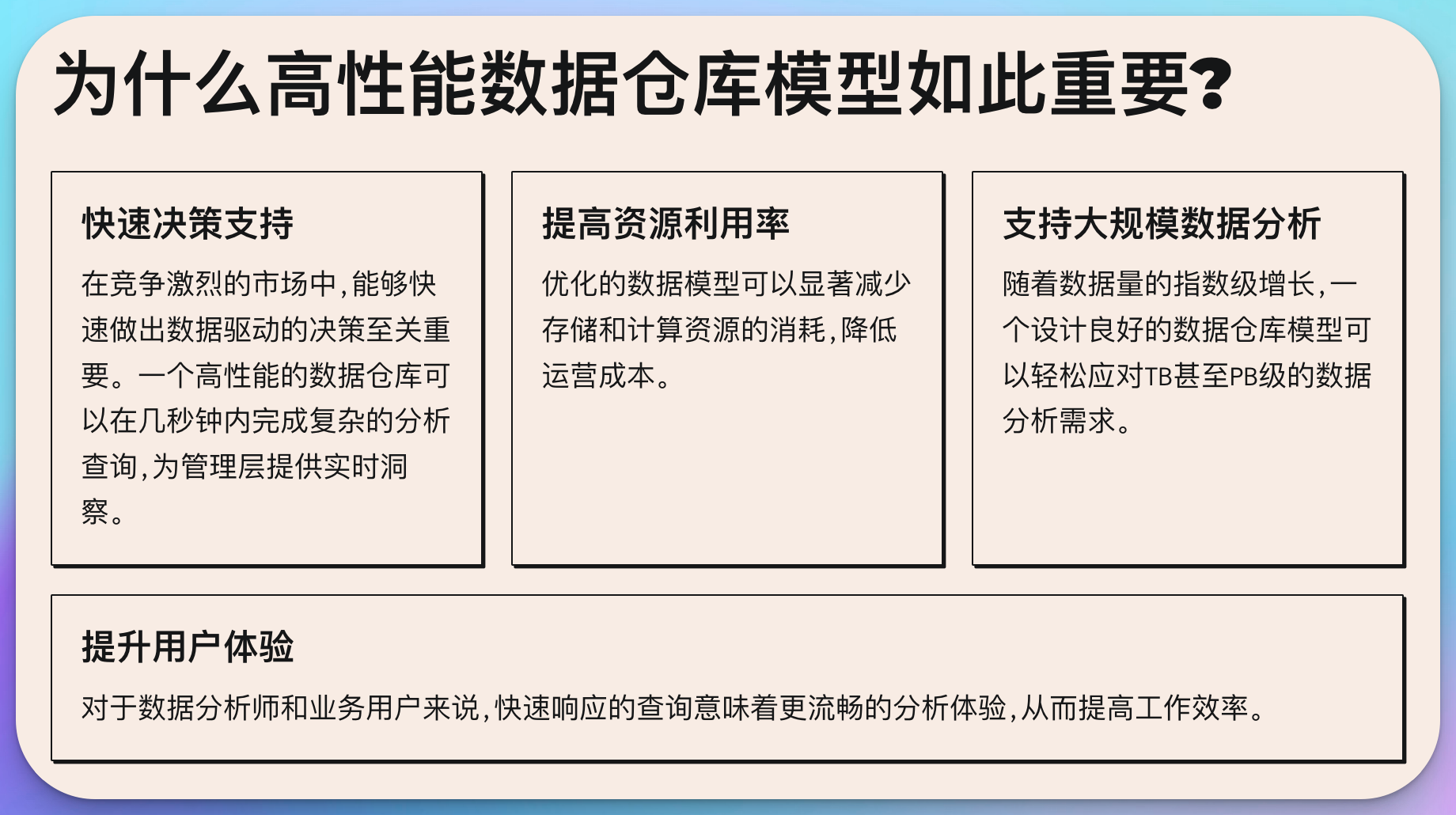

快速决策支持: 在竞争激烈的市场中,能够快速做出数据驱动的决策至关重要。一个高性能的数据仓库可以在几秒钟内完成复杂的分析查询,为管理层提供实时洞察。

-

提高资源利用率: 优化的数据模型可以显著减少存储和计算资源的消耗,降低运营成本。

-

支持大规模数据分析: 随着数据量的指数级增长,一个设计良好的数据仓库模型可以轻松应对TB甚至PB级的数据分析需求。

-

提升用户体验: 对于数据分析师和业务用户来说,快速响应的查询意味着更流畅的分析体验,从而提高工作效率。

-

增强数据质量和一致性: 一个结构清晰、设计合理的数据模型可以减少数据冗余,提高数据质量,确保分析结果的一致性和可靠性。

设计高性能数据仓库模型的核心原则

在开始设计之前,我们需要明确一些核心原则,这些原则将指导我们做出正确的设计决策:

-

业务需求驱动: 数据仓库的设计应该以业务需求为导向。在开始建模之前,要充分了解各个部门的分析需求、常见的查询模式以及未来的业务发展方向。

-

可扩展性: 设计时要考虑到未来的数据增长和新的分析需求。模型应该能够轻松地扩展以适应新的数据源和维度。

-

查询性能优化: 数据模型应该针对最常见和最重要的查询进行优化。这可能涉及到预聚合、适当的索引策略和分区设计。

-

数据一致性: 确保跨不同维度和事实表的数据保持一致性,避免数据孤岛和不一致的分析结果。

-

简洁性: 尽管数据仓库可能非常复杂,但模型本身应该尽可能简单明了。这不仅有助于维护,也能提高查询效率。

-

灵活性: 模型应该能够适应不断变化的业务需求,允许快速添加新的维度或度量而不需要大规模重构。

-

历史数据处理: 设计时要考虑如何有效地存储和查询历史数据,以支持趋势分析和比较。

-

安全性和合规性: 模型设计应该考虑数据访问控制和审计需求,确保敏感数据得到适当保护。

接下来,我们将通过一个具体的案例,看看如何将这些原则应用到实际的数据仓库设计中。

案例研究:电子商务数据仓库设计

让我们假设我们正在为一家名为"TechMart"的大型电子商务公司设计数据仓库。该公司每天处理数十万笔订单,有数百万活跃用户,并且产品目录包含上百万种商品。我们的目标是设计一个能够支持复杂分析查询,同时保持高性能的数据仓库模型。

步骤1: 需求分析

首先,我们需要了解TechMart的主要分析需求:

- 销售分析: 按时间、地区、产品类别等维度分析销售趋势。

- 客户行为分析: 了解客户购买模式、转化率和客户生命周期价值。

- 库存管理: 分析库存周转率、预测需求。

- 营销效果分析: 评估不同营销渠道和活动的ROI。

- 供应链优化: 分析供应商表现、配送效率等。

步骤2: 选择适当的模型

考虑到需求的复杂性和数据量,我们决定采用星型模式(Star Schema)作为我们的基本模型。星型模式以其简洁的结构和优秀的查询性能而闻名,非常适合OLAP(联机分析处理)类型的查询。

步骤3: 定义事实表和维度表

基于需求分析,我们可以确定以下核心事实表和维度表:

事实表:

- 销售事实表(Sales_Fact)

- 客户行为事实表(Customer_Behavior_Fact)

- 库存事实表(Inventory_Fact)

维度表:

- 时间维度(Time_Dim)

- 产品维度(Product_Dim)

- 客户维度(Customer_Dim)

- 地理维度(Geography_Dim)

- 供应商维度(Supplier_Dim)

- 营销活动维度(Campaign_Dim)

步骤4: 设计星型模式

让我们详细设计销售分析的星型模式,以此为例说明设计过程:

-- 销售事实表

CREATE TABLE Sales_Fact (

sale_id BIGINT PRIMARY KEY,

order_date_key INT,

customer_key INT,

product_key INT,

geography_key INT,

campaign_key INT,

quantity INT,

unit_price DECIMAL(10,2),

total_amount DECIMAL(10,2),

discount_amount DECIMAL(10,2),

net_amount DECIMAL(10,2)

);

-- 时间维度表

CREATE TABLE Time_Dim (

date_key INT PRIMARY KEY,

full_date DATE,

year INT,

quarter INT,

month INT,

week INT,

day INT,

is_weekend BOOLEAN,

is_holiday BOOLEAN

);

-- 产品维度表

CREATE TABLE Product_Dim (

product_key INT PRIMARY KEY,

product_id VARCHAR(50),

product_name VARCHAR(100),

category VARCHAR(50),

subcategory VARCHAR(50),

brand VARCHAR(50),

supplier_key INT,

unit_cost DECIMAL(10,2)

);

-- 客户维度表

CREATE TABLE Customer_Dim (

customer_key INT PRIMARY KEY,

customer_id VARCHAR(50),

first_name VARCHAR(50),

last_name VARCHAR(50),

email VARCHAR(100),

phone VARCHAR(20),

registration_date DATE,

customer_segment VARCHAR(20)

);

-- 地理维度表

CREATE TABLE Geography_Dim (

geography_key INT PRIMARY KEY,

city VARCHAR(50),

state VARCHAR(50),

country VARCHAR(50),

region VARCHAR(50),

latitude DECIMAL(9,6),

longitude DECIMAL(9,6)

);

-- 营销活动维度表

CREATE TABLE Campaign_Dim (

campaign_key INT PRIMARY KEY,

campaign_id VARCHAR(50),

campaign_name VARCHAR(100),

campaign_type VARCHAR(50),

start_date DATE,

end_date DATE,

channel VARCHAR(50),

budget DECIMAL(10,2)

);

这个设计有以下几个特点:

-

粒度: 销售事实表的粒度设置在单个订单项级别,这样可以支持非常细粒度的分析。

-

维度设计: 每个维度表都包含丰富的属性,以支持多角度的分析。例如,地理维度不仅包含基本的地理信息,还包含了经纬度,可用于地理空间分析。

-

性能考虑: 使用整数类型的代理键(surrogate key)作为主键和外键,这可以提高JOIN操作的性能。

-

历史跟踪: 时间维度的设计允许灵活的时间序列分析,包括季节性分析和假日效应分析。

-

扩展性: 这个设计允许轻松添加新的维度或修改现有维度,而不会影响核心的事实表结构。

实施星型模式:步骤和最佳实践

设计好模型后,下一步是实施。以下是一些关键步骤和最佳实践:

-

数据抽取和转换:

设计ETL(抽取、转换、加载)流程,将源系统的数据转换为符合星型模式的格式。这通常涉及数据清洗、转换和标准化。import pandas as pd from sqlalchemy import create_engine # 连接到源数据库和目标数据仓库 source_engine = create_engine('postgresql://user:password@source_host/source_db') dw_engine = create_engine('postgresql://user:password@dw_host/data_warehouse') # 抽取源数据 orders_df = pd.read_sql("SELECT * FROM orders", source_engine) products_df = pd.read_sql("SELECT * FROM products", source_engine) # 转换数据 sales_fact_df = orders_df.merge(products_df, on='product_id') sales_fact_df['order_date_key'] = pd.to_datetime(sales_fact_df['order_date']).dt.strftime('%Y%m%d').astype(int) sales_fact_df['total_amount'] = sales_fact_df['quantity'] * sales_fact_df['unit_price'] # 加载数据到数据仓库 sales_fact_df.to_sql('Sales_Fact', dw_engine, if_exists='append', index=False) -

增量加载策略:

对于大型数据集,实施增量加载策略至关重要。这可以通过跟踪最后加载的时间戳或使用变更数据捕获(CDC)技术来实现。def incremental_load(last_load_time): query = f""" SELECT * FROM orders WHERE order_date > '{last_load_time}' """ new_orders_df = pd.read_sql(query, source_engine) # 处理新订单数据 # ... # 更新最后加载时间 update_last_load_time(datetime.now()) # 定期运行增量加载 schedule.every(1).hour.do(incremental_load, last_load_time=get_last_load_time()) -

数据质量检查:

实施数据质量检查,确保加载到数据仓库的数据是准确和一致的。def data_quality_check(df, table_name): # 检查空值 null_counts = df.isnull().sum() if null_counts.any(): log_error(f"发现空值在 {table_name}: {null_counts}") # 检查唯一性约束 if df['sale_id'].nunique() != len(df):log_error(f"{table_name} 中的 sale_id 不是唯一的") # 检查数值范围 if (df['quantity'] <= 0).any(): log_error(f"{table_name} 中存在非正数量") # 检查日期有效性 if (df['order_date'] > datetime.now()).any(): log_error(f"{table_name} 中存在未来日期") # 在数据加载前进行检查 data_quality_check(sales_fact_df, 'Sales_Fact') -

分区策略:

对大型表实施分区可以显著提高查询性能。常见的分区策略包括按日期分区或按地理位置分区。-- 按日期范围分区的sales_fact表 CREATE TABLE sales_fact ( sale_id BIGINT, order_date DATE, -- 其他列... ) PARTITION BY RANGE (order_date); CREATE TABLE sales_fact_2023 PARTITION OF sales_fact FOR VALUES FROM ('2023-01-01') TO ('2024-01-01'); CREATE TABLE sales_fact_2024 PARTITION OF sales_fact FOR VALUES FROM ('2024-01-01') TO ('2025-01-01'); -

索引优化:

根据常见查询模式创建适当的索引。对于星型模式,通常在维度表的主键和事实表的外键上创建索引。-- 在sales_fact表的外键上创建索引 CREATE INDEX idx_sales_fact_date ON sales_fact(order_date_key); CREATE INDEX idx_sales_fact_product ON sales_fact(product_key); CREATE INDEX idx_sales_fact_customer ON sales_fact(customer_key); -- 在维度表的主键上创建索引(如果DBMS没有自动创建) CREATE INDEX idx_time_dim_pk ON time_dim(date_key); CREATE INDEX idx_product_dim_pk ON product_dim(product_key); CREATE INDEX idx_customer_dim_pk ON customer_dim(customer_key); -

数据压缩:

对于大型数据仓库,使用适当的数据压缩技术可以减少存储需求并提高I/O性能。-- 在PostgreSQL中使用ZSTD压缩 ALTER TABLE sales_fact SET (compression=zstd); -

物化视图:

对于频繁执行的复杂聚合查询,可以创建物化视图来提高性能。CREATE MATERIALIZED VIEW monthly_sales AS SELECT t.year, t.month, p.category, SUM(s.total_amount) as total_sales FROM sales_fact s JOIN time_dim t ON s.order_date_key = t.date_key JOIN product_dim p ON s.product_key = p.product_key GROUP BY t.year, t.month, p.category; -- 创建索引以加快查询速度 CREATE INDEX idx_monthly_sales ON monthly_sales(year, month, category); -- 定期刷新物化视图 REFRESH MATERIALIZED VIEW monthly_sales;

优化查询性能的关键技术

设计好数据模型后,优化查询性能是确保数据仓库高效运行的关键。以下是一些重要的优化技术:

-

查询重写:

分析和重写复杂查询,以提高效率。这可能涉及重构子查询、优化JOIN顺序等。-- 优化前 SELECT c.customer_name, SUM(s.total_amount) FROM sales_fact s JOIN customer_dim c ON s.customer_key = c.customer_key WHERE s.order_date_key IN ( SELECT date_key FROM time_dim WHERE year = 2023 AND month = 12 ) GROUP BY c.customer_name; -- 优化后 SELECT c.customer_name, SUM(s.total_amount) FROM sales_fact s JOIN customer_dim c ON s.customer_key = c.customer_key JOIN time_dim t ON s.order_date_key = t.date_key WHERE t.year = 2023 AND t.month = 12 GROUP BY c.customer_name;

-

分区裁剪:

确保查询利用了表分区,只扫描必要的分区。-- 利用分区裁剪的查询 SELECT SUM(total_amount) FROM sales_fact WHERE order_date BETWEEN '2023-01-01' AND '2023-12-31'; -

并行查询执行:

配置数据库以利用并行处理能力,特别是对于大型聚合查询。-- 在PostgreSQL中设置并行查询 SET max_parallel_workers_per_gather = 4; -

结果集缓存:

对于频繁执行的查询,可以使用查询结果缓存。import redis import json redis_client = redis.Redis(host='localhost', port=6379, db=0) def cached_query(query, cache_key, expire_time=3600): # 尝试从缓存获取结果 cached_result = redis_client.get(cache_key) if cached_result: return json.loads(cached_result) # 如果缓存miss,执行查询 result = execute_query(query) # 将结果存入缓存 redis_client.setex(cache_key, expire_time, json.dumps(result)) return result # 使用缓存查询 monthly_sales = cached_query( "SELECT * FROM monthly_sales WHERE year = 2023", "monthly_sales_2023", 3600 # 缓存1小时 ) -

列式存储:

对于需要扫描大量行但只涉及少数列的分析查询,使用列式存储可以显著提高性能。-- 在PostgreSQL中创建列式表(使用cstore_fdw扩展) CREATE FOREIGN TABLE sales_fact_columnar ( sale_id BIGINT, order_date_key INTEGER, -- 其他列... ) SERVER cstore_server; -

预聚合:

对于常见的聚合查询,可以预先计算并存储结果。CREATE TABLE daily_sales_summary AS SELECT order_date_key, SUM(total_amount) as daily_total, COUNT(DISTINCT customer_key) as unique_customers FROM sales_fact GROUP BY order_date_key; -- 创建索引以加快查询 CREATE INDEX idx_daily_sales_summary ON daily_sales_summary(order_date_key); -

查询计划分析:

定期分析slow query log,并使用EXPLAIN命令优化性能差的查询。EXPLAIN ANALYZE SELECT p.category, SUM(s.total_amount) FROM sales_fact s JOIN product_dim p ON s.product_key = p.product_key WHERE s.order_date_key BETWEEN 20230101 AND 20231231 GROUP BY p.category;

数据仓库模型的演进和维护

设计和实施高性能数据仓库模型只是第一步。随着业务的发展和需求的变化,数据仓库模型也需要不断演进和维护。以下是一些关键策略:

-

版本控制:

使用版本控制系统(如Git)来管理数据模型的变更。这可以帮助跟踪模式变更,并在需要时回滚。# 创建一个新的分支来实施模型变更 git checkout -b add-new-dimension # 添加新的维度表DDL git add new_dimension.sql # 提交变更 git commit -m "Add new dimension for customer loyalty program" # 合并到主分支 git checkout main git merge add-new-dimension -

增量模式更新:

设计模式变更策略,以最小化对现有数据和查询的影响。-- 增加新列到现有维度表 ALTER TABLE customer_dim ADD COLUMN loyalty_tier VARCHAR(20); -- 更新现有数据 UPDATE customer_dim SET loyalty_tier = 'Standard' WHERE loyalty_tier IS NULL; -- 为新列添加非空约束 ALTER TABLE customer_dim ALTER COLUMN loyalty_tier SET NOT NULL; -

性能监控:

实施持续的性能监控,及时发现和解决性能问题。import psycopg2 import time def monitor_query_performance(query): conn = psycopg2.connect("dbname=datawarehouse user=dw_user") cur = conn.cursor() start_time = time.time() cur.execute(query) end_time = time.time() execution_time = end_time - start_time print(f"Query execution time: {execution_time:.2f} seconds") cur.close() conn.close() return execution_time # 监控关键查询的性能 daily_performance = monitor_query_performance("SELECT * FROM daily_sales_summary") if daily_performance > 5: # 如果查询时间超过5秒 send_alert("Daily sales summary query is slow") -

数据质量管理:

实施持续的数据质量检查,确保数据仓库中的数据始终保持高质量。from great_expectations import DataContext def run_data_quality_checks(): context = DataContext("/path/to/great_expectations") suite = context.get_expectation_suite("sales_fact_suite") batch = context.get_batch({"path": "/data/sales_fact.csv"}, suite) results = context.run_validation(batch, expectation_suite=suite) if not results["success"]: send_alert("Data quality check failed for sales_fact") # 定期运行数据质量检查 schedule.every().day.at("01:00").do(run_data_quality_checks) -

文档化:

保持数据模型文档的更新,包括每个表和列的详细说明、数据字典和常见查询示例。# Sales Fact Table ## Description This table contains all sales transactions at the order item level. ## Columns - sale_id (BIGINT): Unique identifier for each sale item - order_date_key (INT): Foreign key to Time_Dim table - customer_key (INT): Foreign key to Customer_Dim table - product_key (INT): Foreign key to Product_Dim table - quantity (INT): Number of items sold - unit_price (DECIMAL): Price per unit - total_amount (DECIMAL): Total sale amount (quantity * unit_price) ## Common Queries 1. Total sales by date: ```sql SELECT t.full_date, SUM(s.total_amount) FROM sales_fact s JOIN time_dim t ON s.order_date_key = t.date_key GROUP BY t.full_date ORDER BY t.full_date -

弹性设计:

设计数据模型时考虑未来的扩展性,例如使用通用的分类表而不是硬编码的枚举值。-- 创建通用的分类表 CREATE TABLE category_types ( category_type_id SERIAL PRIMARY KEY, category_type_name VARCHAR(50) UNIQUE NOT NULL ); CREATE TABLE categories ( category_id SERIAL PRIMARY KEY, category_type_id INT REFERENCES category_types(category_type_id), category_name VARCHAR(50) NOT NULL, UNIQUE (category_type_id, category_name) ); -- 插入示例数据 INSERT INTO category_types (category_type_name) VALUES ('Product Category'), ('Customer Segment'); INSERT INTO categories (category_type_id, category_name) VALUES (1, 'Electronics'), (1, 'Clothing'), (2, 'New'), (2, 'Returning');

常见陷阱和如何避免

在设计和实施高性能数据仓库模型的过程中,有一些常见的陷阱需要注意:

-

过度规范化:

虽然在OLTP系统中,高度规范化的模型是合适的,但在数据仓库中可能导致性能问题。避免方法:在星型模式中,适度反规范化维度表是可以接受的,特别是对于slowly changing dimensions。

-- 适度反规范化的客户维度表 CREATE TABLE customer_dim ( customer_key INT PRIMARY KEY, customer_id VARCHAR(50), first_name VARCHAR(50), last_name VARCHAR(50), current_address VARCHAR(200), current_city VARCHAR(50), current_state VARCHAR(50), current_country VARCHAR(50), registration_date DATE ); -

忽视数据增长:

低估数据增长速度可能导致性能问题和存储压力。避免方法:定期监控数据增长,并在设计时考虑未来几年的数据量。

def monitor_data_growth(): conn = create_database_connection() cursor = conn.cursor() cursor.execute("SELECT COUNT(*) FROM sales_fact") current_count = cursor.fetchone()[0] cursor.execute("SELECT COUNT(*) FROM sales_fact WHERE order_date >= DATE_TRUNC('month', CURRENT_DATE - INTERVAL '1 month')") last_month_count = cursor.fetchone()[0] growth_rate = (last_month_count / current_count) * 100 if growth_rate > 10: # 如果月if growth_rate > 10: # 如果月增长率超过10% send_alert(f"Data growth rate is high: {growth_rate:.2f}%") # 定期运行数据增长监控 schedule.every().day.do(monitor_data_growth) -

忽视历史数据处理:

没有适当考虑如何处理历史数据变化可能导致分析错误。避免方法:实施 Slowly Changing Dimensions (SCD) 策略,特别是对于重要的维度如客户和产品。

-- 使用SCD Type 2的客户维度表 CREATE TABLE customer_dim ( customer_key SERIAL PRIMARY KEY, customer_id VARCHAR(50), first_name VARCHAR(50), last_name VARCHAR(50), email VARCHAR(100), address VARCHAR(200), effective_date DATE, end_date DATE, is_current BOOLEAN ); -- 更新客户信息的存储过程 CREATE OR REPLACE PROCEDURE update_customer_dim( p_customer_id VARCHAR(50), p_first_name VARCHAR(50), p_last_name VARCHAR(50), p_email VARCHAR(100), p_address VARCHAR(200) ) LANGUAGE plpgsql AS $$ BEGIN -- 结束当前记录 UPDATE customer_dim SET end_date = CURRENT_DATE - INTERVAL '1 day', is_current = FALSE WHERE customer_id = p_customer_id AND is_current = TRUE; -- 插入新记录 INSERT INTO customer_dim (customer_id, first_name, last_name, email, address, effective_date, end_date, is_current) VALUES (p_customer_id, p_first_name, p_last_name, p_email, p_address, CURRENT_DATE, '9999-12-31', TRUE); END; $$; -

不恰当的聚合级别:

选择错误的聚合级别可能导致数据丢失或性能问题。避免方法:仔细分析业务需求,选择适当的聚合级别,并在必要时保留细粒度数据。

-- 创建多级聚合表 CREATE TABLE sales_summary ( date_key INT, product_key INT, geography_key INT, total_sales DECIMAL(15,2), total_quantity INT, granularity VARCHAR(20), -- 'daily', 'monthly', 'yearly' PRIMARY KEY (date_key, product_key, geography_key, granularity) ); -- 填充聚合表 INSERT INTO sales_summary SELECT t.date_key, s.product_key, s.geography_key, SUM(s.total_amount) as total_sales, SUM(s.quantity) as total_quantity, 'daily' as granularity FROM sales_fact s JOIN time_dim t ON s.order_date_key = t.date_key GROUP BY t.date_key, s.product_key, s.geography_key UNION ALL SELECT DATE_TRUNC('month', t.full_date)::INT as date_key, s.product_key, s.geography_key, SUM(s.total_amount) as total_sales, SUM(s.quantity) as total_quantity, 'monthly' as granularity FROM sales_fact s JOIN time_dim t ON s.order_date_key = t.date_key GROUP BY DATE_TRUNC('month', t.full_date), s.product_key, s.geography_key; -

忽视数据安全和隐私:

在设计数据仓库模型时忽视安全和隐私考虑可能导致严重的后果。避免方法:实施适当的访问控制、数据加密和屏蔽敏感信息。

-- 创建角色和授予适当的权限 CREATE ROLE analyst; GRANT SELECT ON sales_summary TO analyst; -- 对敏感列进行加密 ALTER TABLE customer_dim ALTER COLUMN email TYPE bytea USING PGP_SYM_ENCRYPT(email::text, 'AES_KEY')::bytea; -- 创建视图来屏蔽敏感信息 CREATE VIEW customer_dim_masked AS SELECT customer_key, customer_id, first_name, last_name, CASE WHEN LENGTH(email::text) > 5 THEN LEFT(email::text, 2) || '***' || RIGHT(email::text, 2) ELSE '***' END as masked_email, address FROM customer_dim; -

忽视数据一致性:

在复杂的数据仓库环境中,确保跨多个表和数据集的一致性可能具有挑战性。避免方法:实施数据一致性检查,使用约束和触发器来维护referential integrity。

-- 添加外键约束 ALTER TABLE sales_fact ADD CONSTRAINT fk_sales_customer FOREIGN KEY (customer_key) REFERENCES customer_dim(customer_key); -- 创建触发器以确保一致性 CREATE OR REPLACE FUNCTION check_date_consistency() RETURNS TRIGGER AS $$ BEGIN IF NOT EXISTS (SELECT 1 FROM time_dim WHERE date_key = NEW.order_date_key) THEN RAISE EXCEPTION 'Invalid order_date_key: %', NEW.order_date_key; END IF; RETURN NEW; END; $$ LANGUAGE plpgsql; CREATE TRIGGER sales_fact_date_consistency BEFORE INSERT OR UPDATE ON sales_fact FOR EACH ROW EXECUTE FUNCTION check_date_consistency();

总结与展望

设计一个高性能的数据仓库模型是一个复杂而持续的过程。它需要深入理解业务需求、精心的技术设计、持续的优化和维护。通过遵循本文中讨论的原则和最佳实践,我们可以创建一个既能满足当前需求,又能适应未来变化的数据仓库模型。

关键要点回顾:

- 以业务需求为导向,选择适当的模型(如星型模式)。

- 仔细设计事实表和维度表,考虑粒度、历史跟踪和性能。

- 实施有效的ETL流程,包括数据质量检查和增量加载策略。

- 优化查询性能,使用分区、索引、物化视图等技术。

- 持续监控和优化数据仓库性能。

- 设计灵活可扩展的模型,为未来的变化做好准备。

- 注意常见陷阱,如过度规范化、忽视数据增长和安全性等。

展望未来,数据仓库技术还将继续发展。一些值得关注的趋势包括:

-

云原生数据仓库:越来越多的企业正在将其数据仓库迁移到云端,利用云服务提供的弹性和可扩展性。

-

实时数据仓库:随着业务对实时分析的需求增加,数据仓库正在向支持实时或近实时数据处理的方向发展。

-

机器学习集成:数据仓库正在与机器学习平台更紧密地集成,支持高级分析和预测建模。

-

自动化优化:利用AI技术,数据仓库系统将能够自动进行查询优化、索引推荐等。

-

数据湖和数据仓库的融合:我们可能会看到数据湖和数据仓库概念的进一步融合,形成更灵活的数据存储和分析解决方案。

无论技术如何发展,设计高性能数据仓库模型的核心原则仍将保持相关性。持续学习、实践和优化将是数据仓库专业人员的永恒主题。

希望这篇文章能为你设计高性能数据仓库模型提供有价值的指导。记住,每个数据仓库都是独特的,要根据具体的业务需求和技术环境来调整和优化你的设计。祝你在数据仓库设计的道路上取得成功!