DreamDissector 是一种文本生成3D对象的方法,通过将多对象文本生成的NeRF输入并生成独立的纹理网格,提供了对象级别的控制和多种应用可能性。

DreamDissector 可以生成具有合理交互的多个独立纹理网格,方便各种应用,包括对象级别的文本引导纹理、通过简单操作方便的手动用户几何编辑以及文本引导的可控对象替换。

相关链接

论文地址:https://arxiv.org/abs/2407.16260

代码地址:https://chester256.github.io/dreamdissector(即将推出)

论文阅读

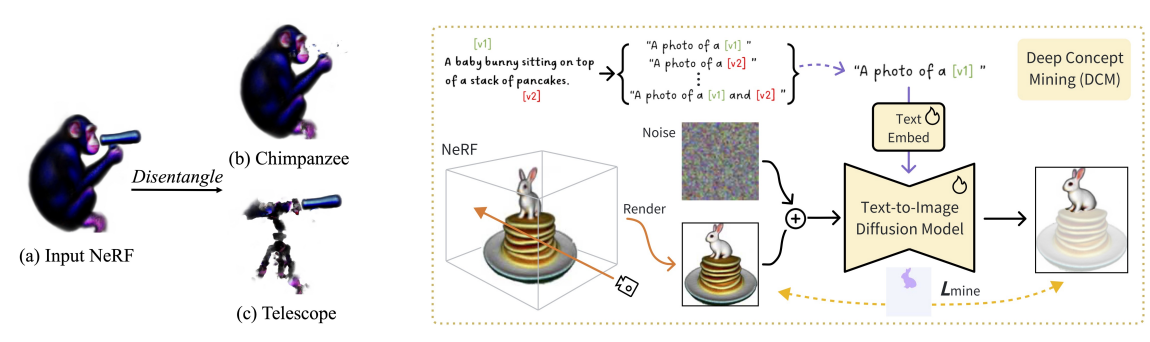

DreamDissector:从 2D 扩散先验学习解开文本到 3D 的生成

摘要

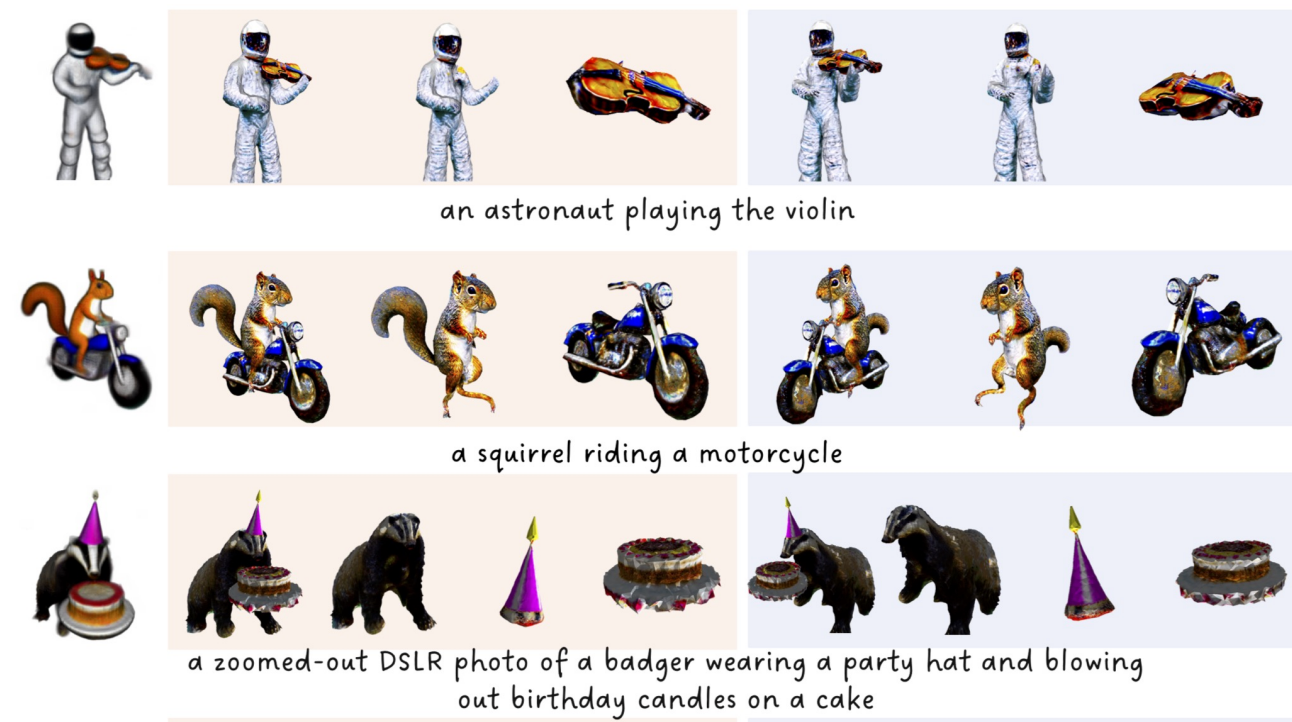

文本到 3D 生成最近取得了重大进展。为了增强其在实际应用中的实用性,生成具有交互的多个独立对象至关重要,类似于 2D 图像编辑中的层合成。然而,现有的文本到 3D 方法难以完成这项任务,因为它们旨在生成非独立对象或缺乏空间上合理交互的独立对象。

为了解决这个问题,我们提出了 DreamDissector,这是一种能够生成具有交互的多个独立对象的文本到 3D 方法。DreamDissector 接受多对象文本到 3D NeRF 作为输入并生成独立的纹理网格。为了实现这一点,我们引入了神经类别场 (NeCF) 来解开输入的 NeRF。此外,我们提出了由深度概念挖掘 (DCM) 模块促进的类别分数蒸馏采样 (CSDS),以解决扩散模型中的概念差距问题。通过利用 NeCF 和 CSDS,我们可以有效地从原始场景中得出子 NeRF,进一步细化可以增强几何和纹理。

我们的实验结果验证了 DreamDissector 的有效性,为用户提供了在对象级别控制 3D 合成的新方法,并可能为未来各种创意应用开辟途径。

方法

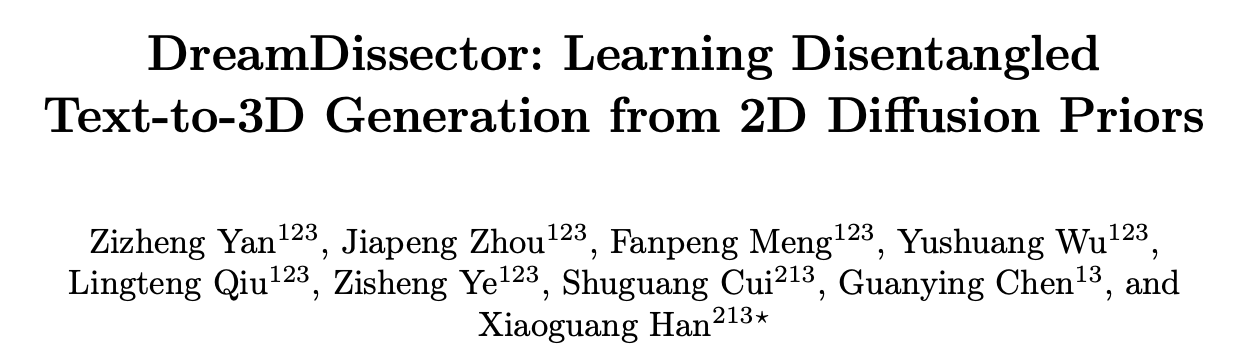

我们以由粗到精的方式生成多个独立的交互式 3D 对象。首先,我们渲染输入的文本到 3D NeRF 的视图以进行深度概念挖掘 (DCM),从而获得 T2I 扩散模型和相应的文本嵌入。然后,我们使用挖掘出的嵌入和 T2I 扩散模型,使用类别分数蒸馏采样 (CSDS) 来训练神经类别场 (NeCF)。在解开输入的 NeRF 后,我们将子 NeRF 转换为 DMTets 并对其进行微调以进一步细化。最后,我们导出具有改进的几何形状和纹理的独立表面网格。

左图:扩散模型中的概念差异。文本提示是“一只黑猩猩正在通过望远镜观察”。右图:深度概念挖掘 (DCM) 概述。我们使用掩蔽扩散损失对文本嵌入和 T2I 扩散模型进行微调。

效果

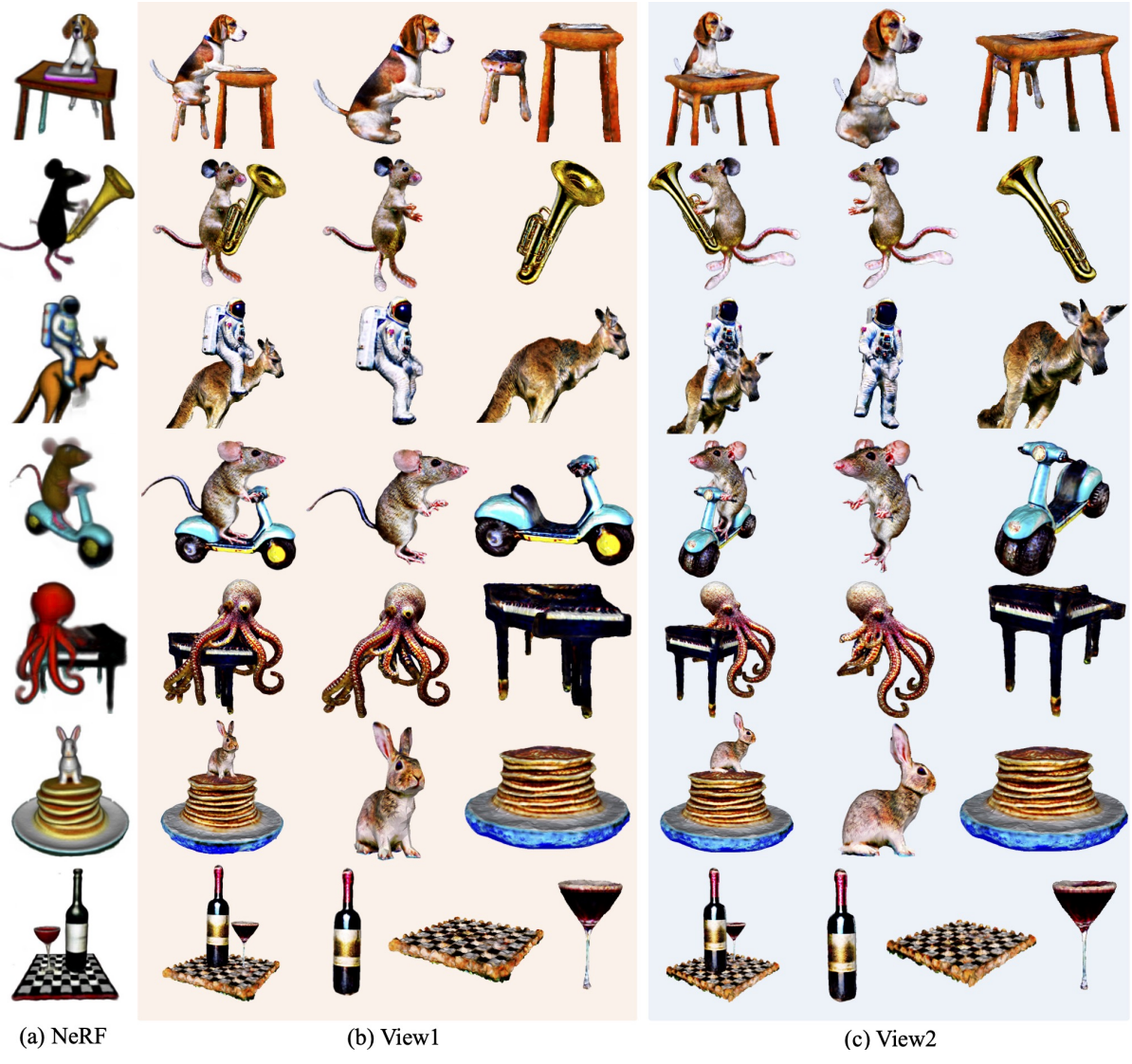

定性结果

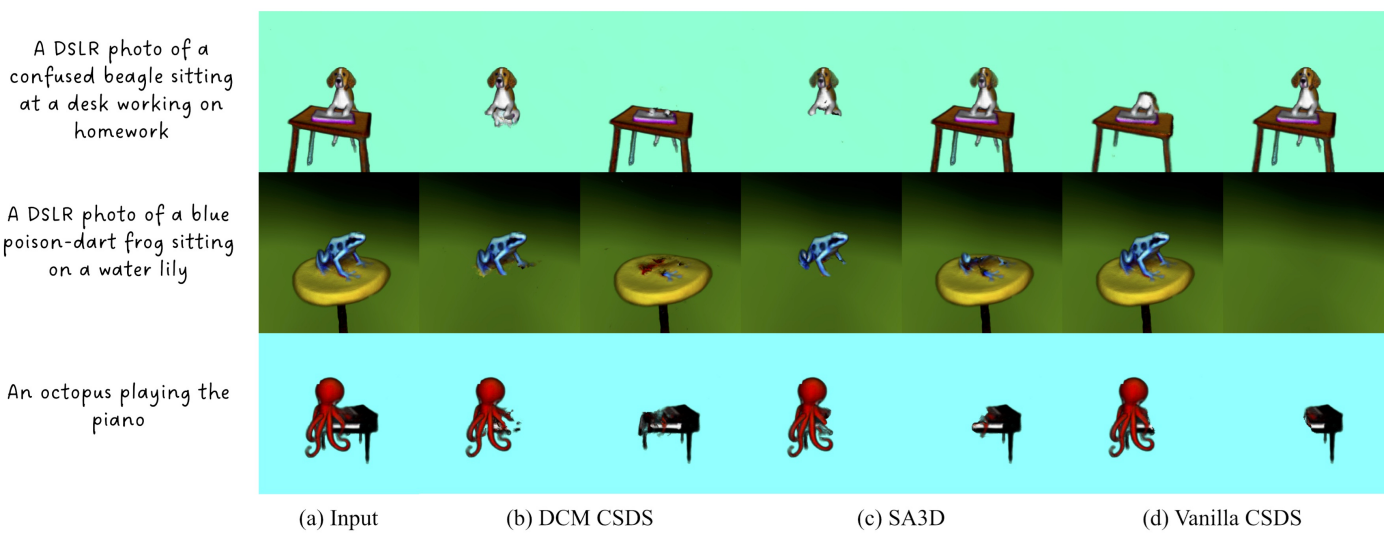

与两条基线比较。我们展示了独立的对象 便于比较。

使用不同的策略来解开 NeRF。我们的 DCM CSDS成功解开了子 NeRF,而 SA3D 和 vanilla CSDS 在某些情况下会失败。

DCM细化示意图。(a) 与伪影解除纠缠的NeRF; (b)原始稳定扩散采样图像(SD), (c) DCM采样图像(SD), (d)由于对原始SD进行微调而产生的不良结果,以及(e) DCM SD固定的伪影。

文本引导纹理编辑的应用示意图。

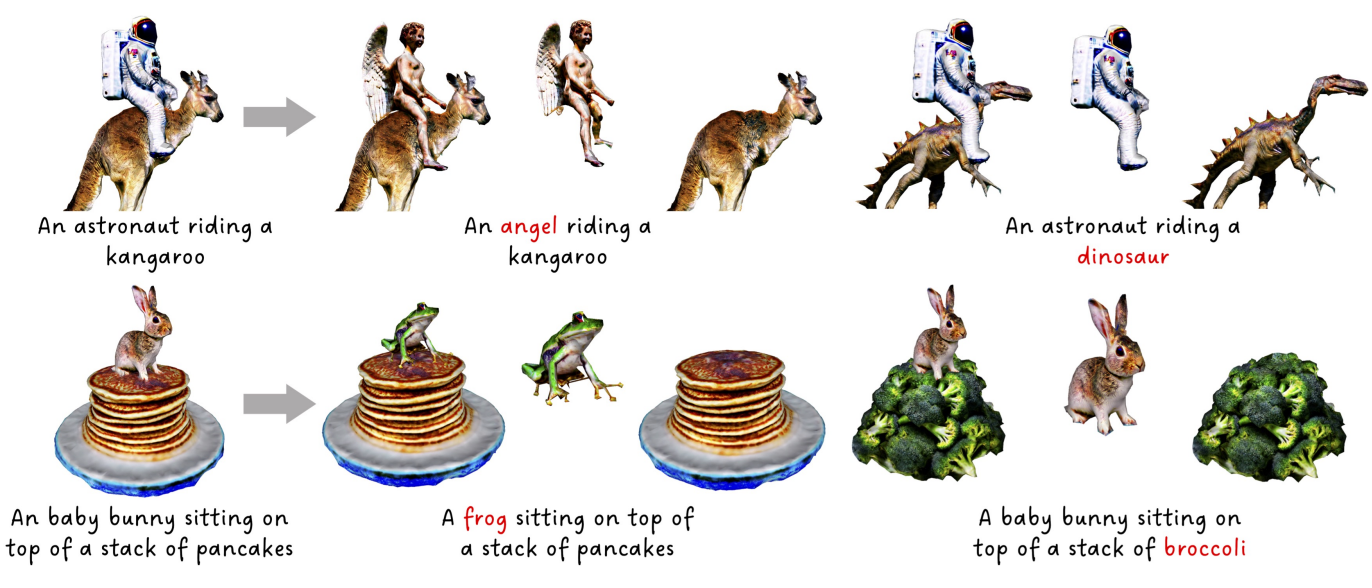

文本引导对象替换的应用示意图。

几何编辑的应用说明。

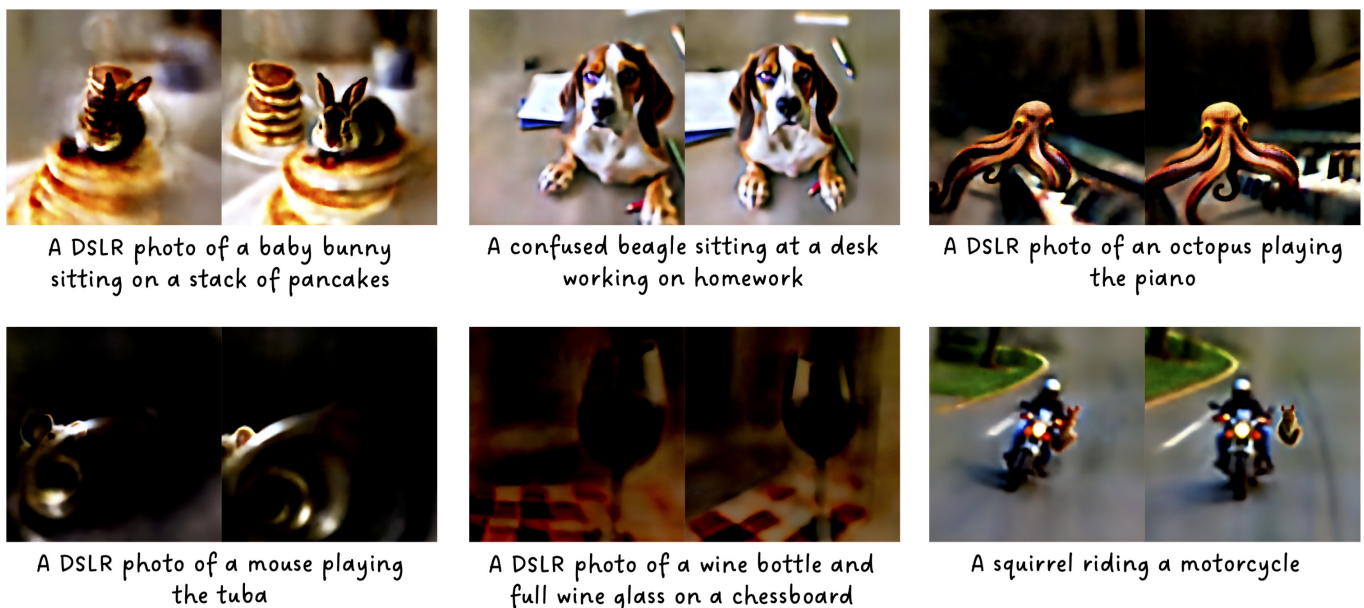

更多结果

结论

我们提出了 DreamDissector,这是一个新颖的框架,旨在生成由文本引导的多个独立交互的对象。DreamDissector 将多对象文本到 3D 神经辐射场 (NeRF) 作为输入,并生成多个纹理网格。我们引入了神经类别场 (NeCF),这是一种能够将输入 NeRF 分解为多个子 NeRF 的表示。为了训练 NeCF,我们提出了类别分数蒸馏采样 (CSDS) 损失。此外,我们观察到 2D 扩散模型中的概念差异问题,这会降低解缠性能。为了解决这个问题,我们引入了深度概念挖掘 (DCM) 来微调文本嵌入和 2D 扩散模型,从而有效地导出子 NeRF。此外,我们提出了一个两阶段细化过程来进一步细化几何和纹理,从而增强真实感。实验结果和进一步的应用展示了 DreamDissector 在现实场景中的有效性和实用性。