[pdf | proj | code]

本文首次提出大型重建模型(Large Reconstruction Model, LRM),实现5s内对单图物体的3D重建。在128张A100(40G)上训练30 epochs。

LRM包含三个部分,具体框架如下:

- 图片编码(Image Encoder):通过DINO提取图片特征,例如:对512 x 512 x 3的图像,可以得到32 x 32 x 768的特征。

- 图片-Triplane解码(Image-to-TriPlane Decoder):基础框架为Transformer,每个模块包含三个组件:Cross-Atten、Self-Atten和MLP。

- 在每个组件中,都包含相机特征调控(Modulation with camera features),将相机外参和相机内参映射为高维向量,通过adaptive layer norm (adaLN)调节输入特征:

,其中c是图像特征,预测的beta和gamma用于调节LN标准化后的输入特征。

,其中c是图像特征,预测的beta和gamma用于调节LN标准化后的输入特征。 - 在Cross-Atten中,可学习位置编码(Learning positional embeddings)作为query,和图像特征融合。

- 解码部分可表达为下式:

- 在每个组件中,都包含相机特征调控(Modulation with camera features),将相机外参和相机内参映射为高维向量,通过adaptive layer norm (adaLN)调节输入特征:

- TriPlane-NeRF:首先将低分辨的Triplane tokens(3 x 32 x 32)提升分辨率为(3 x 64 x 64)。其次,以类似EG3D的方式渲染图像并训练。

在训练时,LRM使用了Objaverse和MVImgNet作为训练集,训练图像都去除背景。训练目标为重建损失,包含MSE和LPIPS:

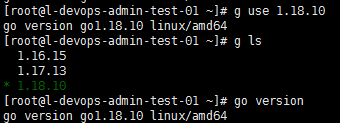

在推理时,LRM仅需要图片,输入相机参数为默认标准相机参数【参考代码】:

更多实验结果:

与One-2-3-45的比较:

一些bad cases:

消融实验:

数据:

训练中使用的视角数量:

scale-up:

![[C++] 初识 智能指针](https://i-blog.csdnimg.cn/direct/57a7acb425fc43e48f098c1c7cfa4b3b.jpeg)