https://arxiv.org/pdf/2408.05914

一.discriminative and robust model

早期传统的reid的工作方式,因无法在大规模数据集上产生有竞争力的结果,所以本文中为相关工作,并未成为本文方法。

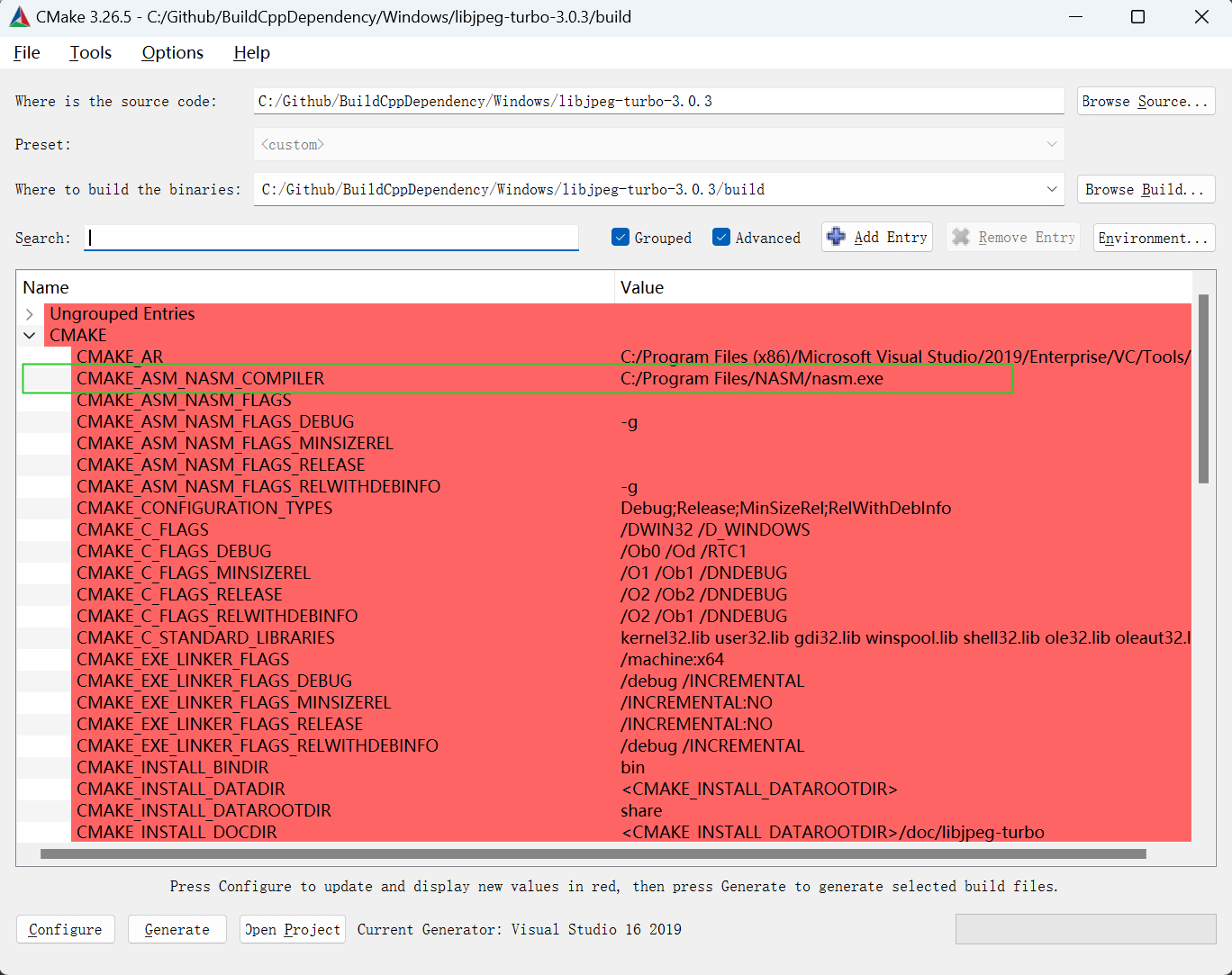

二.Dynamic Multimodal Feature Fusion Strategy

提取文本特征为T = [T1, T2, T3, T4, T5] ,图片特征为 I 将其特征融合为K = [I, T1, T2, T3, T4, T5],K 表示样本融合后的多模态特征。(ps:文本编码器模块,我们采用 BERT 模型。视觉特征提取器,采用 ResNet-50。)

三.Self-Attention Mechanism

数据集中存在明显的图像和文本数据差异,这不可避免地对模型的性能产生负面影响。为了克服这个问题,创造性地引入了一种基于自我注意机制的多模态融合策略(Dynamic Multimodal Feature Fusion Strategy)。

将图像与文本特征进行整合,值得注意的是,多模态融合组件由多个自注意力层组成,以完成多模态特征的融合。经过三个线性层后,这三个向量被输入到自我注意力模块中。

其中 Q、K、V 分别表示 Query、Key 和 Value,d 表示输入向量的维度。

四.identification loss and triplet loss function(损失函数)

可看往期文章。ResNet 学习

五.ResNet-50(backbone)

本文主网络