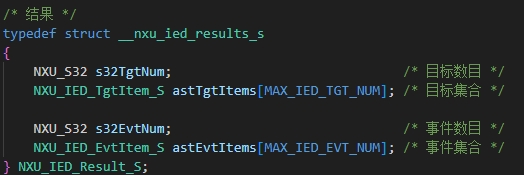

在当今数字化时代,数据已成为企业的核心资产,而数据驱动决策则是充分利用这一资产的关键方法。本系列文章全面探讨了从数据收集到分析,再到实际应用的整个过程,为读者提供了深入而实用的指导。让我们深入回顾这个journey,详细探讨每个主题的核心内容,并思考数据驱动决策的未来发展方向。

目录

- 系列文章

- 详细总结

- 1. 数据埋点:奠定坚实基础

- 1.1 数据埋点基础:理解与规划

- 1.2 埋点SDK与代码实战

- 1.3 数据质量保证:验证、清洗与管理

- 1.4 数据分析与可视化:从数据到洞察

- 2. 数据驱动文化:推动组织变革

- 2.1 形成数据驱动的决策文化

- 2.2 组织变革:从传统到数据驱动

- 2.3 评估数据驱动决策的ROI

- 3. 高级分析技术:深化数据洞察

- 3.1 AB测试:科学验证决策

- 3.2 个性化推荐:提升用户体验

- 3.3 机器学习在决策中的应用

- 3.4 预测分析:洞察未来趋势

- 4. 数据治理与伦理:确保可持续发展

- 4.1 数据治理框架的建立

- 4.2 数据安全策略的实施

- 4.3 数据伦理和隐私保护

- 4.4 在合规和创新之间寻找平衡

- 5. 实时处理与整合:应对数据复杂性

- 5.1 实时数据处理和流式分析

- 5.2 跨平台和多源数据整合

- 5.3 构建全面的数据视图

- 6. 数据可视化:讲好数据故事

- 6.1 可视化设计原则

- 6.2 高级可视化技术

- 6.3 数据叙事和故事板

- 6.4 可视化工具和框架

- 7. 数据驱动产品开发:创造价值

- 7.1 用户需求分析

- 7.2 数据驱动的产品设计

- 7.3 产品开发过程中的数据应用

- 7.4 产品上市后的数据分析

- 8. 未来趋势与挑战

- 8.1 人工智能和机器学习的深度应用

- 8.2 边缘计算与实时决策

- 8.3 数据隐私和安全的新挑战

- 8.4 数据民主化

- 8.5 跨学科融合

- 概要总结

- 1. 数据埋点:奠定基础

- 2. 数据驱动文化:组织变革

- 3. 高级分析技术:深化洞察

- 4. 数据治理与伦理:确保可持续性

- 5. 实时处理与整合:应对复杂性

- 6. 数据可视化:讲好数据故事

- 7. 数据驱动产品开发:创造价值

- 结语

系列文章

-

数据埋点系列 1 | 数据埋点基础:理解与规划

- 介绍了数据埋点的基本概念、重要性和规划策略

-

数据埋点系列 2 | 埋点SDK与代码实战

- 深入探讨了埋点SDK的实现和代码示例

-

数据埋点系列 3 | 数据质量保证:验证、清洗与管理

- 讨论了如何确保埋点数据的质量和可靠性

-

数据埋点系列 4 | 数据分析与可视化:从数据到洞察

- 介绍了如何分析埋点数据并创建有效的可视化

-

数据埋点系列 5 | 数据驱动决策:形成数据驱动文化

- 探讨了如何在组织中建立数据驱动的决策文化

-

数据埋点系列 6 | 数据驱动决策的实际应用:从理论到实践

- 提供了数据驱动决策的实际案例和应用方法

-

数据埋点系列 7 | 数据驱动决策的高级应用:跨行业案例与新兴趋势

- 讨论了数据驱动决策在不同行业的应用和新兴趋势

-

数据埋点系列 8 | 数据分析高级主题:AB测试、个性化与机器学习

- 深入探讨了高级数据分析技术及其在决策中的应用

-

数据埋点系列 9 | 数据伦理与隐私-在合规与创新间寻找平衡

- 讨论了数据使用中的伦理和隐私问题,以及如何平衡合规和创新

-

数据埋点系列 10 |数据治理与数据安全:构建可信赖的数据基础

- 探讨了数据治理框架和数据安全策略

-

数据埋点系列 11 |实时数据处理与流式分析:应对数据洪流的策略与实践

- 介绍了实时数据处理和流式分析的技术和应用

-

数据埋点系列 12 |数据驱动决策的组织变革:从传统到数据驱动的蜕变之路

- 讨论了如何在组织层面推动数据驱动文化的变革

-

数据埋点系列 13 |数据驱动决策的ROI评估:量化数据的价值

- 探讨了如何评估和证明数据驱动决策带来的商业价值

-

数据埋点系列 14 |跨平台和多源数据整合:构建全面数据视图的策略与实践

- 讨论了如何整合来自不同平台和来源的数据

-

数据埋点系列 15 |数据可视化高级技巧:从洞察到视觉故事

- 深入探讨了高级数据可视化技术和最佳实践

-

数据埋点系列 16 |预测分析和预测模型:用数据洞察未来

- 介绍了如何使用历史数据构建预测模型,指导未来决策

-

数据埋点系列 17 |数据驱动产品开发:用洞察力塑造卓越产品

- 探讨了如何将数据洞察应用于产品设计和开发过程

这个系列全面覆盖了从数据收集、处理、分析到应用的整个数据驱动决策流程。

详细总结

1. 数据埋点:奠定坚实基础

数据埋点是整个数据驱动决策过程的起点,它为后续的分析和决策提供了必要的原始数据。

1.1 数据埋点基础:理解与规划

- 核心概念:介绍了什么是数据埋点,为什么它对业务至关重要。

- 埋点类型:探讨了代码埋点、可视化埋点和无埋点等不同方法的优缺点。

- 规划策略:讨论了如何制定全面的埋点计划,包括确定关键指标(KPI)和设计埋点方案。

- 最佳实践:提供了埋点实施的最佳实践,如避免过度埋点、确保数据一致性等。

1.2 埋点SDK与代码实战

- SDK设计:深入探讨了埋点SDK的核心功能,包括事件跟踪、用户识别和会话管理。

- 代码示例:提供了多个平台(Web、iOS、Android)的埋点代码实现示例。

- 性能优化:讨论了如何优化埋点代码以减少对应用性能的影响。

- 错误处理:介绍了埋点过程中的错误处理和重试机制。

1.3 数据质量保证:验证、清洗与管理

- 数据验证:探讨了如何实施实时数据验证,确保收集的数据符合预定义的格式和规则。

- 数据清洗:介绍了常见的数据清洗技术,如处理缺失值、去除重复数据等。

- 数据管理:讨论了数据生命周期管理,包括数据存储、访问控制和数据归档。

- 质量监控:提供了建立数据质量监控系统的方法,以持续跟踪和改善数据质量。

1.4 数据分析与可视化:从数据到洞察

- 分析技术:介绍了描述性统计、推断统计等基本分析方法。

- 可视化工具:探讨了各种数据可视化工具和技术,如Matplotlib、Seaborn、D3.js等。

- 交互式仪表板:讨论了如何创建交互式数据仪表板,使用诸如Tableau或Power BI等工具。

- 数据叙事:强调了如何通过数据讲故事,将复杂的数据转化为易懂的洞察。

关键takeaway:高质量的数据收集和分析是一切数据驱动决策的基础。没有可靠和有意义的数据,再先进的分析技术也无法产生有价值的洞察。

2. 数据驱动文化:推动组织变革

仅有技术是不够的,我们还需要在组织层面建立数据驱动的文化,这需要从上到下的全面变革。

2.1 形成数据驱动的决策文化

- 领导力:讨论了高层管理者在推动数据驱动文化中的关键作用。

- 培训和教育:强调了提高全员数据素养的重要性,介绍了相关的培训计划。

- 激励机制:探讨了如何设计激励机制,鼓励员工在决策中使用数据。

- 成功案例:分享了多个成功实施数据驱动决策的企业案例。

2.2 组织变革:从传统到数据驱动

- 变革管理:讨论了如何管理从传统决策模式向数据驱动模式的转变。

- 组织结构:探讨了数据驱动组织的理想结构,包括新角色的设立(如首席数据官)。

- 跨部门协作:强调了打破数据孤岛,促进跨部门数据共享和协作的重要性。

- 技能发展:讨论了组织需要培养的关键数据技能,以及如何建立数据人才梯队。

2.3 评估数据驱动决策的ROI

- 衡量指标:探讨了如何定义和测量数据驱动决策的成功指标。

- ROI计算:提供了计算数据驱动项目ROI的方法和公式。

- 案例分析:通过具体案例展示了如何评估数据驱动决策带来的实际价值。

- 长期效益:讨论了数据驱动决策的长期效益,超越了短期财务指标。

关键takeaway:数据驱动不仅是一种技术,更是一种思维方式和组织文化。它需要从高层管理到一线员工的全面参与和支持,同时需要有效的变革管理和持续的价值评估。

3. 高级分析技术:深化数据洞察

随着基础打好,我们可以使用更高级的分析技术来获取更深入的洞察。

3.1 AB测试:科学验证决策

- 理论基础:介绍了AB测试的统计学原理和适用场景。

- 设计方法:讨论了如何设计有效的AB测试,包括样本量确定、随机化等。

- 结果分析:探讨了如何正确解读AB测试结果,避免常见的统计陷阱。

- 工具介绍:介绍了常用的AB测试工具,如Google Optimize、Optimizely等。

3.2 个性化推荐:提升用户体验

- 推荐算法:深入探讨了常见的推荐算法,如协同过滤、基于内容的推荐等。

- 实时推荐:讨论了如何实现实时个性化推荐,以及相关的技术挑战。

- 冷启动问题:探讨了推荐系统中的冷启动问题及其解决方案。

- 评估指标:介绍了评估推荐系统效果的关键指标,如点击率、转化率等。

3.3 机器学习在决策中的应用

- 监督学习:探讨了分类和回归等监督学习方法在决策支持中的应用。

- 无监督学习:讨论了聚类、降维等无监督学习技术如何帮助发现数据模式。

- 深度学习:介绍了深度学习在复杂决策问题中的应用,如图像识别、自然语言处理等。

- 模型解释性:强调了在使用复杂模型时确保模型可解释性的重要性。

3.4 预测分析:洞察未来趋势

- 时间序列分析:介绍了ARIMA、SARIMA等时间序列预测模型。

- 预测模型评估:讨论了如何评估预测模型的准确性和可靠性。

- 场景分析:探讨了如何使用预测模型进行不同场景的模拟和分析。

- 预测的局限性:强调了理解预测的不确定性和局限性的重要性。

关键takeaway:高级分析技术能够从数据中提取更深层次的洞察,但它们的应用需要谨慎,要考虑到统计显著性、模型假设和潜在的偏差。同时,解释这些高级分析结果并将其转化为可操作的决策同样重要。

4. 数据治理与伦理:确保可持续发展

随着数据的广泛使用,数据治理和伦理问题变得越来越重要,它们是确保数据驱动决策可持续发展的关键。

4.1 数据治理框架的建立

- 数据管理策略:讨论了如何制定全面的数据管理策略,包括数据分类、存储和访问控制。

- 数据所有权:探讨了如何明确数据所有权和责任,以及数据管理员的角色。

- 数据标准化:介绍了建立数据标准和元数据管理的重要性。

- 数据质量管理:提供了持续监控和改进数据质量的方法和工具。

4.2 数据安全策略的实施

- 数据加密:探讨了数据加密技术,包括传输加密和存储加密。

- 访问控制:讨论了实施细粒度访问控制的方法,如基于角色的访问控制(RBAC)。

- 安全审计:介绍了如何进行定期的安全审计和渗透测试。

- 事件响应:提供了数据泄露等安全事件的响应计划。

4.3 数据伦理和隐私保护

- 隐私设计:讨论了如何在产品设计阶段就考虑隐私保护(“Privacy by Design”)。

- 同意管理:探讨了如何获取和管理用户对数据使用的同意。

- 数据匿名化:介绍了数据匿名化和假名化技术。

- 伦理决策框架:提供了在数据使用中进行伦理决策的框架。

4.4 在合规和创新之间寻找平衡

- 法规遵从:讨论了GDPR、CCPA等主要数据保护法规的要求。

- 创新空间:探讨了如何在合规的前提下保持创新。

- 风险管理:介绍了数据相关风险的识别和管理方法。

- 透明度:强调了在数据使用方面保持透明的重要性。

关键takeaway:负责任的数据使用不仅是法律和道德的要求,也是赢得用户信任、确保业务可持续发展的关键。良好的数据治理和伦理实践可以成为组织的竞争优势。

5. 实时处理与整合:应对数据复杂性

现代数据环境的复杂性要求我们具备更高级的数据处理能力,特别是在实时处理和数据整合方面。

5.1 实时数据处理和流式分析

- 流处理框架:介绍了Apache Kafka、Apache Flink等流处理框架的特点和使用。

- 实时分析技术:讨论了滑动窗口、近似算法等实时数据分析技术。

- 低延迟处理:探讨了如何实现毫秒级的数据处理和决策。

- 使用场景:分析了实时处理在欺诈检测、推荐系统等领域的应用。

5.2 跨平台和多源数据整合

- 数据集成架构:讨论了数据湖、数据仓库等不同的数据集成架构。

- ETL vs ELT:比较了传统ETL和现代ELT方法的优缺点。

- 主数据管理:探讨了如何建立和维护统一的主数据视图。

- 数据质量控制:在数据整合过程中确保数据质量的方法和工具。

5.3 构建全面的数据视图

- 360度客户视图:讨论了如何整合多个来源的数据,构建全面的客户画像。

- 数据关联技术:介绍了实体解析、数据匹配等技术。

- 大数据存储:探讨了处理和存储大规模、多样化数据的技术。

- 数据可视化:如何有效地可视化和探索复杂的、多维度的数据。

关键takeaway:在数据量急剧增加和数据来源日益多样化的今天,能够实时处理和整合各种数据源的能力变得至关重要。这不仅需要先进的技术,还需要全面的数据战略和架构设计。

6. 数据可视化:讲好数据故事

数据可视化是将复杂的数据转化为直观、有洞察力的视觉表现的艺术和科学。它是数据分析和决策支持的关键环节。

6.1 可视化设计原则

- 清晰性和简洁性:讨论了如何去除视觉噪音,突出关键信息。

- 色彩使用:探讨了色彩在数据可视化中的作用,以及如何有效地使用色彩来传达信息。

- 图表选择:介绍了不同类型数据适合的图表类型,如何选择最合适的可视化方式。

- 交互设计:讨论了如何设计有效的交互元素,增强用户对数据的理解和探索。

6.2 高级可视化技术

- 多维数据可视化:探讨了如何可视化具有多个维度的复杂数据集。

- 地理空间可视化:介绍了地图可视化技术,包括热力图、流线图等。

- 网络和关系可视化:讨论了如何可视化复杂的网络结构和关系数据。

- 时间序列可视化:探讨了动态和交互式时间序列数据的可视化方法。

6.3 数据叙事和故事板

- 叙事结构:讨论了如何构建有说服力的数据故事结构。

- 上下文提供:强调了在数据可视化中提供足够上下文的重要性。

- 受众分析:探讨了如何根据不同受众定制数据可视化和叙事。

- 交互式故事板:介绍了创建交互式数据故事板的技术和工具。

6.4 可视化工具和框架

- 静态可视化:介绍了如 Matplotlib, Seaborn 等 Python 库的使用。

- 交互式可视化:探讨了 Plotly, Bokeh 等交互式可视化库的特点和应用。

- 仪表板工具:讨论了 Tableau, Power BI 等商业智能工具的功能和使用场景。

- 定制化开发:介绍了使用 D3.js 等低级库进行自定义可视化开发的方法。

关键takeaway:优秀的数据可视化不仅能清晰地展示数据,还能讲述引人入胜的数据故事,促进理解和决策。掌握高级可视化技巧可以大大提升数据分析的效果和影响力。

7. 数据驱动产品开发:创造价值

数据驱动决策的最终目标是创造价值,特别是在产品开发中,数据可以指导整个产品生命周期。

7.1 用户需求分析

- 用户行为数据:讨论了如何收集和分析用户行为数据,了解用户需求。

- 用户反馈分析:介绍了文本分析和情感分析技术在处理用户反馈中的应用。

- 市场调研:探讨了如何结合定量和定性数据进行全面的市场分析。

- 用户画像:讨论了如何基于数据构建详细的用户画像。

7.2 数据驱动的产品设计

- 特性优先级排序:介绍了如何使用数据来确定产品特性的优先级。

- 原型测试:讨论了如何使用A/B测试等方法验证产品概念和设计。

- 个性化设计:探讨了如何利用数据实现产品的个性化和定制化。

- 用户体验优化:介绍了如何通过数据分析持续优化用户体验。

7.3 产品开发过程中的数据应用

- 敏捷开发:讨论了如何在敏捷开发过程中有效地使用数据。

- 持续集成和部署:探讨了如何将数据分析集成到CI/CD流程中。

- 质量保证:介绍了基于数据的软件测试和质量保证方法。

- 性能优化:讨论了如何使用性能数据来优化产品。

7.4 产品上市后的数据分析

- 用户获取分析:探讨了如何分析和优化用户获取渠道。

- 留存率分析:介绍了分析和提高用户留存率的方法。

- 收入分析:讨论了如何分析产品收入和盈利能力。

- 客户生命周期价值:探讨了如何计算和优化客户生命周期价值。

关键takeaway:将数据洞察应用于产品开发的全过程,可以创造出更符合用户需求、更具市场竞争力的产品。数据驱动的产品开发是一个持续优化的过程,需要在产品的整个生命周期中不断收集和应用数据洞察。

8. 未来趋势与挑战

随着技术的不断进步,数据驱动决策的领域也在不断演进。以下是一些值得关注的趋势和潜在的挑战:

8.1 人工智能和机器学习的深度应用

- 自动化决策:探讨了AI系统在某些领域自主做出决策的可能性和挑战。

- 增强分析:讨论了如何将人工智能与人类智慧结合,实现更强大的决策支持。

- 可解释AI:强调了在使用AI进行决策时确保可解释性的重要性。

- 伦理考量:探讨了AI决策可能带来的伦理问题和解决方案。

8.2 边缘计算与实时决策

- 物联网数据:讨论了如何处理和分析来自大量IoT设备的数据。

- 边缘智能:探讨了在数据源头进行处理和决策的趋势和优势。

- 5G技术:讨论了5G如何促进实时数据传输和处理。

- 分布式系统:探讨了在分布式环境中进行数据分析和决策的挑战。

8.3 数据隐私和安全的新挑战

- 隐私保护计算:介绍了联邦学习、同态加密等新兴的隐私保护技术。

- 去中心化数据:探讨了区块链等技术在数据管理中的潜在应用。

- 法规演进:讨论了数据保护法规可能的发展方向及其影响。

- 安全威胁:探讨了针对数据和AI系统的新型安全威胁及防御策略。

8.4 数据民主化

- 自助分析工具:讨论了让非技术用户也能进行数据分析的工具和平台。

- 数据素养教育:强调了提高全民数据素养的重要性。

- 开放数据:探讨了开放数据对创新和决策的影响。

- 数据市场:讨论了数据作为资产进行交易的趋势和挑战。

8.5 跨学科融合

- 数据科学与领域知识:强调了将数据科学与具体业务领域知识结合的重要性。

- 认知科学:探讨了认知科学在改进数据可视化和决策支持中的应用。

- 行为经济学:讨论了行为经济学原理如何帮助理解和改进数据驱动决策。

- 系统思考:强调了在数据分析中采用系统性思考方法的重要性。

关键takeaway:数据驱动决策的未来充满机遇和挑战。组织需要不断适应新技术、新方法,同时应对日益复杂的伦理和隐私问题。保持学习和创新的心态至关重要。

概要总结

1. 数据埋点:奠定基础

数据埋点是整个数据驱动决策过程的起点。我们探讨了:

- 数据埋点的基本概念和重要性

- 埋点SDK的设计和实现

- 确保数据质量的方法

- 数据分析和可视化技术

关键takeaway:优质的数据收集是一切后续分析和决策的基础。没有可靠的数据,再先进的分析技术也无法产生有价值的洞察。

2. 数据驱动文化:组织变革

仅有技术是不够的,我们还需要在组织层面建立数据驱动的文化:

- 形成数据驱动的决策文化

- 推动组织变革,从传统模式向数据驱动模式转变

- 评估数据驱动决策的ROI

关键takeaway:数据驱动不仅是一种技术,更是一种思维方式。它需要从高层管理到一线员工的全面参与和支持。

3. 高级分析技术:深化洞察

随着基础打好,我们可以使用更高级的分析技术:

- AB测试方法论

- 个性化推荐技术

- 机器学习在决策中的应用

- 预测分析和预测模型

关键takeaway:高级分析技术能够从数据中提取更深层次的洞察,但它们的应用需要谨慎,要考虑到统计显著性和潜在的偏差。

4. 数据治理与伦理:确保可持续性

随着数据的广泛使用,数据治理和伦理问题变得越来越重要:

- 数据治理框架的建立

- 数据安全策略的实施

- 数据伦理和隐私保护

- 在合规和创新之间寻找平衡

关键takeaway:负责任的数据使用不仅是法律和道德的要求,也是赢得用户信任、确保业务可持续发展的关键。

5. 实时处理与整合:应对复杂性

现代数据环境的复杂性要求我们具备更高级的数据处理能力:

- 实时数据处理和流式分析

- 跨平台和多源数据整合

- 构建全面的数据视图

关键takeaway:在数据量急剧增加和数据来源日益多样化的今天,能够实时处理和整合各种数据源的能力变得至关重要。

6. 数据可视化:讲好数据故事

数据分析的结果需要通过有效的可视化来传达:

- 高级数据可视化技巧

- 将数据洞察转化为视觉故事

关键takeaway:优秀的数据可视化不仅能清晰地展示数据,还能讲述引人入胜的数据故事,促进理解和决策。

7. 数据驱动产品开发:创造价值

最终,数据驱动决策的目标是创造价值,特别是在产品开发中:

- 利用数据洞察指导产品设计

- 数据驱动的产品优化策略

- 持续的产品性能监控和改进

关键takeaway:将数据洞察应用于产品开发,可以创造出更符合用户需求、更具市场竞争力的产品。

结语

数据驱动决策已经成为现代组织的核心竞争力。从数据埋点开始,经过数据收集、处理、分析、可视化,到最终的决策和产品开发,每一步都至关重要。本系列文章全面探讨了这一过程中的关键环节,为读者提供了深入的理解和实践指导。

关键要点总结:

- 数据质量是一切的基础。没有高质量的数据,任何分析都将失去意义。

- 数据驱动文化需要自上而下的支持和全员参与。

- 高级分析技术如机器学习可以提供深刻洞察,但也需要谨慎应用。

- 数据治理和伦理考量对于长期成功至关重要。

- 实时处理和数据整合能力在当今复杂的数据环境中越来越重要。

- 有效的数据可视化和叙事是传达洞察、推动决策的关键。

- 将数据洞察应用于产品开发全流程可以创造卓越的产品。

- 持续关注新兴趋势和技术,保持学习和创新的心态。

最后,重要的是要记住,数据驱动决策不是简单地用数据替代人的判断,而是将数据洞察与人类的经验、直觉和创造力相结合。真正成功的数据驱动组织能够在这两者之间找到平衡,利用数据增强人的能力,而不是取代人。

在这个数据时代,掌握数据驱动决策的能力将成为个人和组织的核心竞争力。希望这个系列能为你在这个journey上提供有价值的指导。让我们共同努力,用数据的力量来创造更大的价值,推动业务和社会的进步!