回归预测|基于最大互信息与支持向量机结合的数据回归预测Matlab程序MIC-SVM 多特征输入单输出

文章目录

- 前言

- 回归预测|基于最大互信息与支持向量机结合的数据回归预测Matlab程序MIC-SVM 多特征输入单输出

- 一、MIC-SVM模型

- 最大信息系数(MIC)的原理

- 支持向量机(SVM)的原理

- MIC-SVM回归预测模型的工作流程

- 总结

- 二、实验结果

- 三、核心代码

- 四、代码获取

- 五、总结

前言

回归预测|基于最大互信息与支持向量机结合的数据回归预测Matlab程序MIC-SVM 多特征输入单输出

一、MIC-SVM模型

当然,下面是MIC-SVM回归预测模型的详细原理和流程:

最大信息系数(MIC)的原理

最大信息系数(MIC)是一种衡量两个变量之间依赖关系强度的统计量。MIC的核心思想是通过测量一个变量的所有可能的非线性依赖关系来评估其与另一个变量的关系。它可以捕捉到比线性相关性更复杂的模式。

原理:

- 信息量测量:MIC基于信息论,通过分割变量值的空间来最大化信息量。它评估的是一个变量对另一个变量信息传递的能力。

- 网格分割:将数据空间分割成多个网格,然后计算每个网格内的频率。MIC通过寻找最佳的网格分割方式来最大化两个变量之间的依赖关系。

计算方法:

- 数据分割:将数据空间划分为若干个网格。

- 计算信息量:计算每个网格中数据点的分布情况,并评估这些分布如何反映变量之间的关系。

- 优化网格分割:通过调整网格大小和分割方式,最大化信息量的传递。

- MIC值:MIC值是优化后得到的度量,用于评估两个变量之间的依赖关系强度。

支持向量机(SVM)的原理

支持向量机(SVM)是一种监督学习模型,广泛应用于分类和回归问题。SVM回归(SVR)是SVM的一个变种,用于处理回归任务。其基本思想是找到一个能够最小化预测误差的回归函数。

原理:

- 目标函数:SVM回归旨在找到一个回归函数,使得在给定的误差范围内,预测值和实际值的偏差最小化。

- ε-不敏感损失函数:SVM回归使用ε-不敏感损失函数,这意味着对那些偏差小于ε的预测结果不进行惩罚。这使得模型对小的预测误差具有鲁棒性。

- 核函数:SVM可以通过使用核函数将数据映射到更高维空间,以便在这个空间中找到线性回归函数。常用的核函数包括线性核、径向基核(RBF核)等。

- 支持向量:在训练过程中,模型会选择一些数据点(即支持向量)来定义回归函数。这些支持向量是决定回归函数的关键数据点。

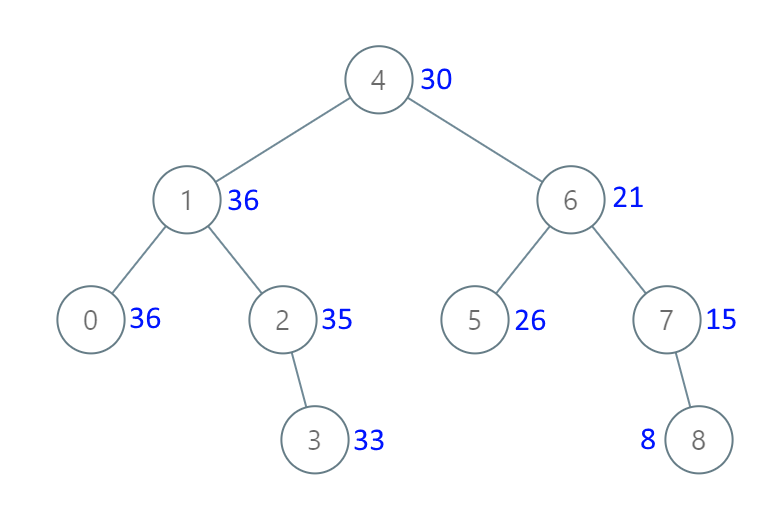

MIC-SVM回归预测模型的工作流程

-

数据预处理:

- 收集和整理数据,包括特征和目标变量。

-

特征选择:

- 计算MIC值:对所有特征与目标变量之间计算MIC值,以评估其非线性依赖关系。

- 筛选特征:根据MIC值选择与目标变量关系最强的特征。通常选择MIC值较高的特征,这些特征对目标变量的预测能力较强。

-

SVM回归模型训练:

- 构建SVM模型:使用筛选后的特征作为输入,通过训练SVM模型来学习数据中的回归关系。选择合适的核函数和参数,以优化模型的预测性能。

- 训练过程:模型通过最小化损失函数来拟合数据。训练过程中会调整模型参数以获得最优的回归函数。

-

模型评估:

- 预测:使用训练好的SVM回归模型对测试数据进行预测。

- 性能评估:通过评估指标(如均方误差MSE)来衡量模型的预测性能,确保其准确性和鲁棒性。

-

结果解释:

- 分析预测结果:解释模型的预测结果,并对模型的表现进行分析,以了解其在实际应用中的有效性。

总结

MIC-SVM回归预测模型将最大信息系数用于特征选择,以捕捉非线性关系,并通过支持向量机进行回归建模。这个组合方法可以在特征选择时充分考虑复杂的非线性关系,并通过SVM模型进行高效的预测。

二、实验结果

MIC-SVM回归预测

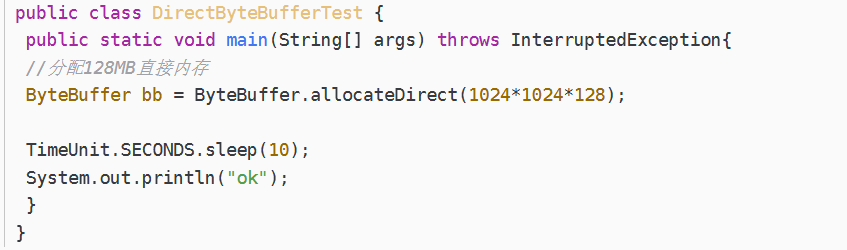

三、核心代码

%% 导入数据

res = xlsread('数据集.xlsx');

%% 数据分析

num_size = 0.7; % 训练集占数据集比例

outdim = 1; % 最后一列为输出

num_samples = size(res, 1); % 样本个数

res = res(randperm(num_samples), :); % 打乱数据集(不希望打乱时,注释该行)

num_train_s = round(num_size * num_samples); % 训练集样本个数

f_ = size(res, 2) - outdim; % 输入特征维度

%% 划分训练集和测试集

P_train = res(1: num_train_s, 1: f_)';

T_train = res(1: num_train_s, f_ + 1: end)';

M = size(P_train, 2);

P_test = res(num_train_s + 1: end, 1: f_)';

T_test = res(num_train_s + 1: end, f_ + 1: end)';

N = size(P_test, 2);

%% 数据归一化

[p_train, ps_input] = mapminmax(P_train, 0, 1);

p_test = mapminmax('apply', P_test, ps_input );

t_train = T_train;

t_test = T_test;

四、代码获取

私信即可 30米

五、总结

包括但不限于

优化BP神经网络,深度神经网络DNN,极限学习机ELM,鲁棒极限学习机RELM,核极限学习机KELM,混合核极限学习机HKELM,支持向量机SVR,相关向量机RVM,最小二乘回归PLS,最小二乘支持向量机LSSVM,LightGBM,Xgboost,RBF径向基神经网络,概率神经网络PNN,GRNN,Elman,随机森林RF,卷积神经网络CNN,长短期记忆网络LSTM,BiLSTM,GRU,BiGRU,TCN,BiTCN,CNN-LSTM,TCN-LSTM,BiTCN-BiGRU,LSTM–Attention,VMD–LSTM,PCA–BP等等

用于数据的分类,时序,回归预测。

多特征输入,单输出,多输出

![[Meachines] [Easy] Blue MS17-010永恒之蓝](https://img-blog.csdnimg.cn/img_convert/ac1de7777a3892c01991bff57e54bf89.jpeg)