文章目录

- 1、为什么要数据标准化

- 2、常用的两种数据标准化

- 1、0~1归一化

- 2、Z标准化

- 3、注意事项

1、为什么要数据标准化

主要是基于以下几个方面的原因:

-

消除量纲影响:在机器学习中,不同的特征往往具有不同的量纲和单位。例如,身高可能以厘米为单位,而体重可能以千克为单位。这种量纲差异会导致数据在分析和建模时受到不必要的影响。通过数据标准化,可以将数据转换为无量纲的形式,从而消除这种影响,使得不同特征之间可以直接进行比较和计算。这样,机器学习算法就能更准确地捕捉数据中的模式和规律。

-

提高算法性能:许多机器学习算法都假设输入特征是同等重要的,并且具有相似的尺度。如果不同特征的尺度差异很大,那么算法在训练过程中可能会受到较大影响,导致性能下降。通过数据标准化,可以使得所有特征都处于相同的尺度上,这有助于提高算法的稳定性和效率。例如,在梯度下降算法中,标准化后的数据能够使得梯度方向更加准确,从而减少迭代次数,加快收敛速度。

-

避免特征权重偏差:在某些机器学习算法中,如K-最近邻算法(KNN),特征之间的尺度差异会导致在计算距离时产生偏差。如果某个特征的取值范围远大于其他特征,那么该特征在计算距离时将占据主导地位,导致其他特征的贡献被忽视。通过数据标准化,可以使得所有特征在计算距离时具有相同的权重,从而避免这种情况的发生。

-

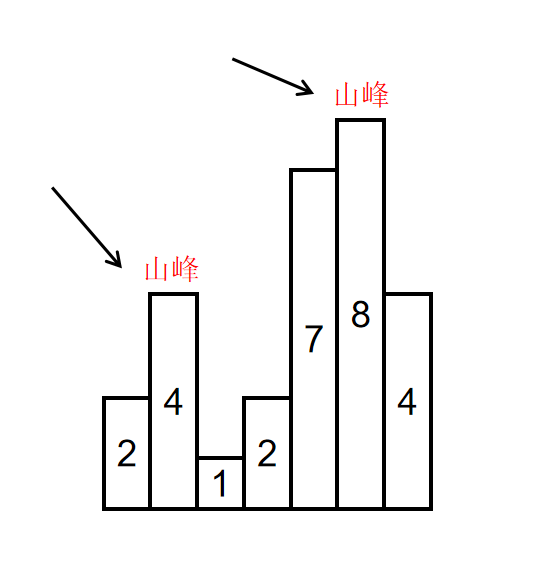

便于数据可视化:在数据可视化过程中,如果不同特征的尺度差异很大,那么绘制出的图形可能会很难解读。通过数据标准化,可以将所有特征都转换到相同的尺度上,使得图形更加直观和易于理解。这有助于研究人员更好地分析数据,发现其中的规律和模式。

-

提升模型泛化能力:数据标准化还可以提升模型的泛化能力。在训练过程中,如果模型过于依赖某些量纲较大的特征,那么当遇到新的数据时,这些特征的微小变化都可能导致模型性能的显著下降。通过数据标准化,可以使得模型更加关注数据本身的模式和规律,而不是数据的量纲和单位,从而提升模型的泛化能力。

2、常用的两种数据标准化

数据标准化的方法有多种,其中最常用的是最小-最大标准化(也称为0-1归一化)和Z标准化(也称为标准差标准化)。

1、0~1归一化

- 0~1归一化也叫做最大最小标准化(Min-Max Normalization),通过将原始数据线性地缩放到[0, 1]的范围内来实现,这种方法对于将数据限制在特定范围(如概率、百分比等)内非常有用

- 公式如下:

- 其中:

- X 是原始数据。

- X min是原始数据中的最小值。

- X max是原始数据中的最大值。

- X norm是归一化后的数据。

- 代码示例

-

运用numpy库中的方法创建一个包含随机数值的二维数组,模拟特征数据集

-

假设有5个样本,每个样本有3个特征

-

在Python中,可以使用sklearn.preprocessing.MinMaxScaler类来实现最大最小标准化

import numpy as np from sklearn.preprocessing import MinMaxScaler # 创建一个包含随机数值的二维数组,模拟特征数据集 # 假设有5个样本,每个样本有3个特征 data = np.random.rand(5, 3) * 10 # 生成一个5x3的数组,每个元素的值在0到10之间 print("原始数据:") print(data) # 使用MinMaxScaler进行归一化 min_max_scaler = MinMaxScaler() data_min_max = min_max_scaler.fit_transform(data) print("\nMinMaxScaler归一化后的数据:") print(data_min_max) """ 原始数据: [[5.45374108 6.36285388 6.89790337] [4.22031847 9.29446541 1.72869836] [6.29878395 8.68105164 8.78970701] [7.65555541 3.81574752 1.61238819] [9.50247279 8.58981375 9.87706441]] MinMaxScaler归一化后的数据: [[0.23350749 0.4649092 0.63953082] [0. 1. 0.01407317] [0.39348822 0.88803699 0.86843315] [0.65034771 0. 0. ] [1. 0.87138384 1. ]] """

-

2、Z标准化

-

Z标准化也称为Z-score标准化或标准差标准化是一种数据预处理技术,用于将数据转化为均值为0,标准差为1的标准正态分布。这种方法在数据分析和机器学习中非常常见,特别是当不同特征具有不同的尺度或单位时,通过Z标准化可以使这些特征在相同的尺度上进行比较和处理。

-

Z标准化的公式如下:

-

其中:

- x 是原始数据。

- μ 是所有样本数据的均值。

- σ 是所有样本数据的标准差。

- z 是转化后的数据,即Z分数。

-

Z标准化的步骤

- 计算均值:首先,需要计算给定数据集的所有样本的均值(μ)。

- 计算标准差:然后,计算数据集的标准差(σ),它衡量了数据点与均值的偏差程度。

- 应用公式:最后,使用Z标准化的公式将每个原始数据点转换为Z分数。

-

代码示例

- 与上述示例一样,运用numpy库中的方法创建一个包含随机数值的二维数组,模拟特征数据集

- 假设有5个样本,每个样本有3个特征

- 在Python中,可以使用sklearn.preprocessing.StandardScaler类或numpy的std和mean函数结合来实现Z-分数标准化,这里我们使用StandardScaler方法,因为此方法中包含了所有过程的计算,只需要传入数据即可

import numpy as np from sklearn.preprocessing import StandardScaler # 创建一个包含随机数值的二维数组,模拟特征数据集 # 假设有5个样本,每个样本有3个特征 data = np.random.rand(5, 3) * 10 # 生成一个5x3的数组,每个元素的值在0到10之间 print("原始数据:") print(data) # 使用StandardScaler进行标准化 scaler_Z = StandardScaler() data_scaled = scaler_Z.fit_transform(data) print("\nStandardScaler标准化后的数据:") print(data_scaled) """ 原始数据: [[2.91800254 3.2360031 9.66065598] [7.47746281 4.00855141 2.03950532] [9.8433753 8.32004568 4.55501016] [6.00990907 9.91191497 4.61528516] [0.15924446 1.95696181 6.33065699]] StandardScaler标准化后的数据: [[-0.69405259 -0.73160863 1.67789759] [ 0.64479923 -0.48048456 -1.35200705] [ 1.33953196 0.92100707 -0.35192975] [ 0.21386292 1.43845911 -0.3279665 ] [-1.50414152 -1.14737299 0.35400572]] """

3、注意事项

- 选择适当的方法:根据数据的特性和算法的需求选择合适的数据标准化方法。例如,如果数据集中存在异常值,Z标准化可能会受到影响,而最小-最大标准化则不受影响(但也可能因为异常值而改变缩放范围)。

- 考虑数据分布:数据标准化会改变数据的原始分布。在解释标准化后的数据时,需要考虑到这一点。

- 对测试集使用相同的参数:在训练集上进行数据标准化后,应使用相同的均值、标准差(对于Z标准化)或最小值、最大值(对于最小-最大标准化)来标准化测试集。

- 避免数据泄露:在实际应用中,需要确保在训练模型之前进行数据标准化,以避免在标准化过程中引入测试集的信息,从而导致数据泄露。