在大数据的世界里,处理海量数据的需求越来越多,而Hadoop作为开源的分布式计算框架,成为了这一领域的核心技术之一。

一、Hadoop简介

Hadoop是Apache Software Foundation开发的一个开源分布式计算框架,旨在使用简单的编程模型来处理大规模数据集。它的优势在于能够以横向扩展的方式处理大量数据,使得数据分析在廉价硬件集群上变得可行。

Hadoop的三大核心组件分别是:HDFS(Hadoop Distributed File System)、YARN(Yet Another Resource Negotiator)和MapReduce。这三者协同工作,共同实现了Hadoop的分布式存储与计算能力。

二、Hadoop核心组件解析

1. HDFS(Hadoop Distributed File System)

HDFS是Hadoop的分布式文件系统,专为大规模数据存储设计。HDFS能够将大文件切分成多个数据块,并将其分布在集群中的不同节点上。通过这种方式,HDFS不仅提升了数据访问速度,还增强了数据的可靠性。

HDFS的核心元素:

- NameNode:HDFS的主节点,负责管理文件系统的元数据(例如文件路径、块位置等)。

- DataNode:存储实际的数据块,并负责执行客户端的读写请求。

- Block(数据块):HDFS中数据的最小存储单元,默认大小为128MB。

2. YARN(Yet Another Resource Negotiator)

YARN是Hadoop的资源管理框架,它有效地管理了集群中的计算资源,并调度各种计算任务。YARN将资源管理与作业调度分离,使得Hadoop能够更好地扩展并支持多种数据处理模型。

YARN的核心元素:

- ResourceManager:集群的全局资源管理者,负责资源分配和任务调度。

- NodeManager:每个节点上的资源管理者,负责监控和报告节点的资源使用情况。

- ApplicationMaster:为每个应用程序分配资源,并管理其生命周期。

3. MapReduce

MapReduce是Hadoop的分布式计算模型,负责将大规模数据集分解成小任务,并在集群中并行处理。它将计算分为两个主要阶段:Map阶段和Reduce阶段。

MapReduce的处理过程:

- Map阶段:输入数据被分片并分配给多个Mapper,Mapper处理数据并生成键值对(如

<word, 1>)。 - Shuffle阶段:对Map阶段生成的键值对进行排序并分组,为Reduce阶段做准备。

- Reduce阶段:Reducer对分组后的键值对进行聚合处理,生成最终结果。

三、Hadoop的内部处理流程

为了更好地理解Hadoop的工作原理,我们以经典的WordCount示例来演示其处理流程。假设你要统计一个大型文本文件中每个单词的出现次数,Hadoop会执行以下步骤:

- 数据存储:将文本文件上传至HDFS,文件会被分割成多个块,并存储在不同的DataNode上。

- 任务提交:用户通过YARN提交MapReduce任务,ResourceManager为任务分配资源。

- Map阶段:Map任务从HDFS读取数据块并处理,生成

<word, 1>的键值对。 - Shuffle阶段:对Map阶段输出的键值对进行排序和分组,为Reduce阶段做准备。

- Reduce阶段:Reducer接收分组后的数据,计算每个单词的总次数,并输出最终结果到HDFS。

- 结果存储:最终结果保存在HDFS中,用户可以通过HDFS读取统计结果。

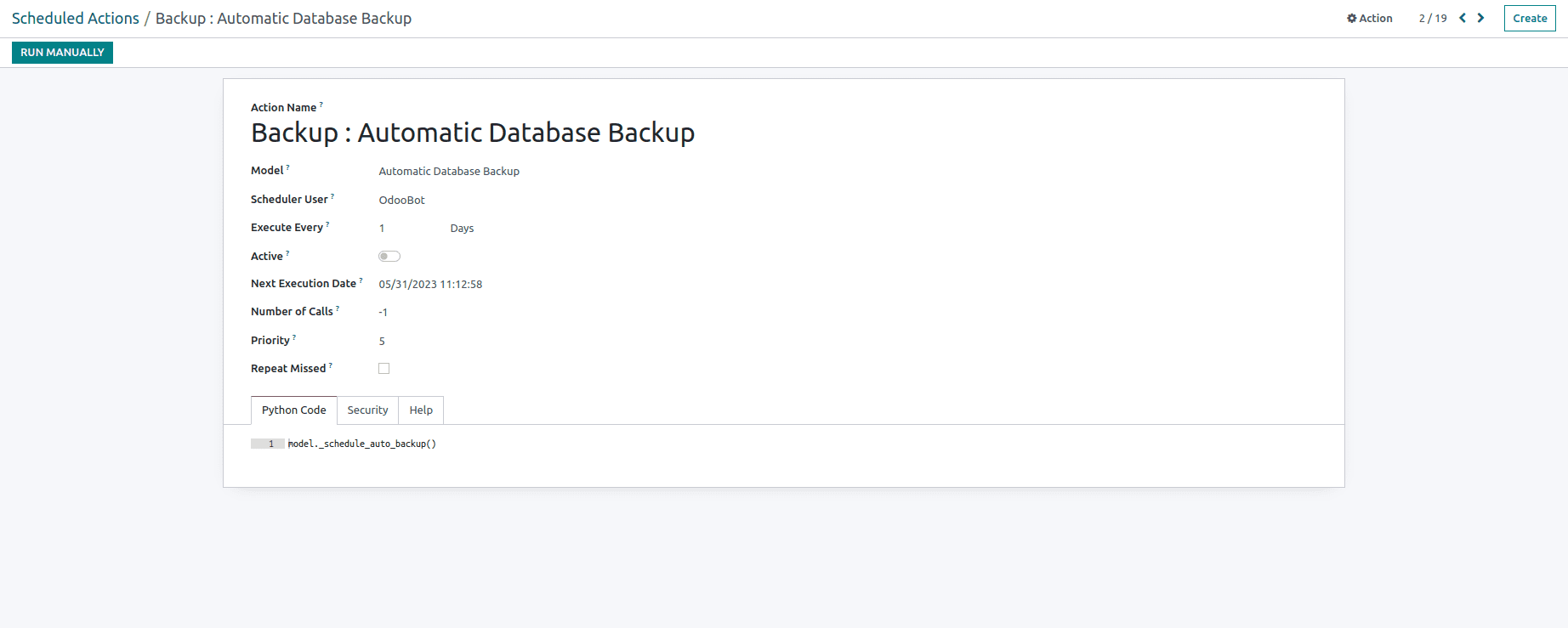

下图展示了Hadoop内部的处理流程:

四、总结

本文介绍了Hadoop的基本架构及其工作原理。通过理解Hadoop的核心组件HDFS、YARN和MapReduce,以及其内部的处理流程,你已经掌握了Hadoop的基础知识。接下来,可以深入学习Hadoop的高级功能与优化策略,为大数据处理打下坚实的基础。