图片由作者使用 DALL-E 拍摄

模型的涌现属性

突现属性不仅是人工智能的一个概念,也是所有学科(从物理学到生物学)的一个概念。这一概念一直让科学家着迷,他们既在描述这一概念,也在试图理解其起源。诺贝尔物理学奖得主PW Anderson用“更多即不同”这一观点综合了这一思想。从某种意义上说,它可以被定义为一种突现属性,即随着系统复杂性的增加而出现的属性,并且无法预测。

例如,你可以用小分子编码信息,但 DNA(大分子)编码的是基因组。或者少量的铀不会引起核反应。

“雪花中复杂的对称和分形 图案的形成体现了物理系统的涌现”。图片来源:此处

最近,人工智能模型也观察到了同样的行为,最常用的定义之一是:“如果某种能力在较小的模型中不存在,但在较大的模型中存在,那么这种能力就是新兴的。”

这意味着什么以及如何观察?

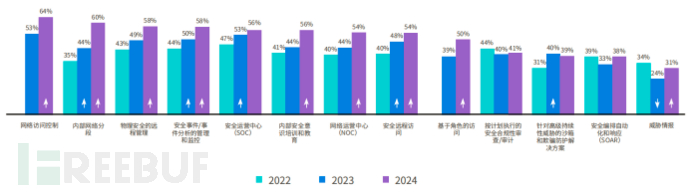

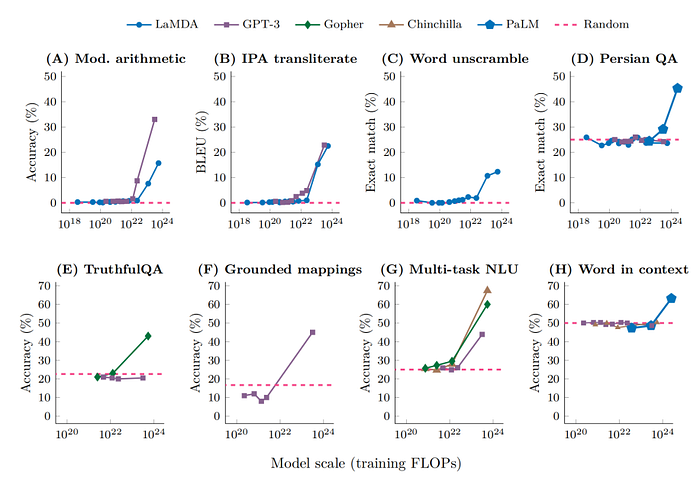

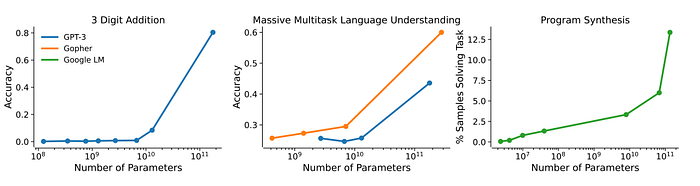

OpenAI 在一篇文章中指出,模型的性能遵循一个缩放定律:数据和参数越多,性能越好。在涌现属性的情况下,预期的是一种特定的模式:随着参数数量的增加,性能几乎是随机的,直到在某个阈值处观察到某种属性(性能开始明显改善)。基本上,我们会看到曲线的急剧转变(称为相变)。这也被称为涌现,因为通过检查小规模模型是无法预测的。

大型语言模型的新兴能力。图片来源(此处)

简而言之,如果一个属性满足以下两个条件,我们可以说它被认为是突发的:

- 锐度,存在与不存在之间的过渡是不连续的。

- 不可预测性,随着参数的增加,其出现无法预测

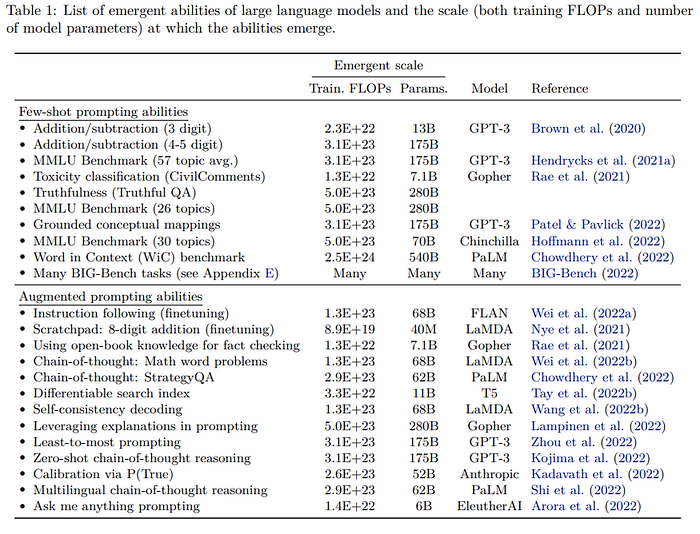

此外,扩展 Transformer 主要考虑三个因素:计算量、模型参数数量和训练数据集大小。

这三个因素使得模型成本高昂。另一方面,这些特性尤其受到追捧,也被用来作为增加参数数量的理由(尽管模型并没有得到最佳训练)。

图片来源:这里

一些研究也关注了为什么会出现这些特性,为什么会这样出现,以及为什么会出现在特定的阈值上。根据一些研究,可以预测某些特性的出现:

例如,如果多步骤推理任务需要 l 步连续计算,则可能需要深度至少为 O (l) 层的模型。(来源)

有人提出了其他解释,比如参数数量越多越有助于记忆。随着数据的增加,模型会获得知识,并在某个时候达到临界质量,从而能够支持该属性

此外,一些作者提出,不同的架构和更好的数据质量可能导致这些属性在更小的模型中出现。

LLaMA 就体现出了这一点,其中一个明显较小的 GPT-3 模型表现出了可比的特性和性能。

META 的 LLaMA:打败巨人的小型语言模型

META 开源模型将帮助我们理解 LM 偏见是如何产生的

medium.com

无论如何,问题仍然存在,为什么会出现这些属性?

Anthropic 在一项研究中指出:

大型生成模型具有高可预测性和高不可预测性(特定模型的能力、输入和输出无法提前预测)的矛盾组合。高可预测性是指模型损失随着训练资源的消耗而改善,并且往往与许多任务的性能提高呈松散相关。(来源)

简单来说,对于LLM来说,有些事情我们可以预测,有些事情我们无法预测。例如,缩放定律允许我们预测增加参数数量将提高规模性能,但同时,我们无法预测某些属性的出现,这些属性反而会随着参数的增加而突然出现。

因此根据这个原则,我们甚至不应该试图预测它们。

缩放定律可靠地预测模型性能。图片来源:此处

三个突发特定能力扩展属性的示例。图片来源:此处

为什么我们对预测这些属性如此感兴趣?

第一个原因是纯粹的经济学:如果某个属性仅在一定数量的参数下出现,我们就不能使用较小的模型。这会大大增加训练和硬件的成本。另一方面,如果无法预测某个属性,我们甚至无法估算获得该属性的成本。

其次,它证明了在寻找新属性的过程中参数过度增加的合理性,这些新属性出现在数万亿个参数中。毕竟,这可能是获得某些属性的唯一方法。

此外,这还会带来安全问题,因为我们无法预测模型在一定规模下会具有什么属性。模型可能会产生有问题的属性,并且可能不适合部署。此外,如此大的模型更难测试是否存在偏见和危害。

此外,缩放定律和突现特性一直是人们热衷于大型模型的原因之一。

这开启了一个可怕的场景,一方面,我们拥有大量开源模型,其训练成本降低,聊天机器人的使用增加。但另一方面,我们无法预测这些模型的属性。

无限巴别法学硕士图书馆

开源、数据和关注:法学硕士的未来将如何改变

towardsdatascience.com

如果新兴房地产只是海市蜃楼怎么办?

图片来自Unsplash 上的Nick Fewings

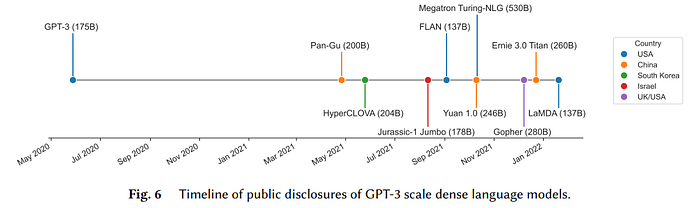

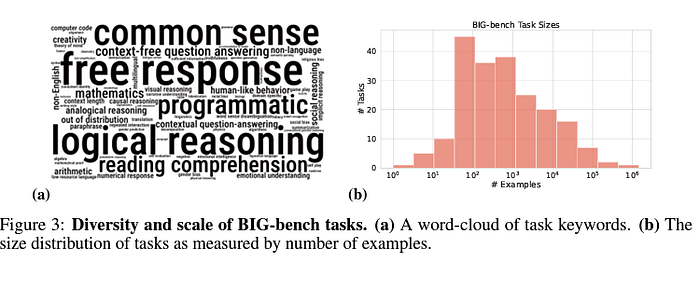

2020 年,谷歌研究人员意识到了法学硕士的潜力,并预测法学硕士将带来变革。因此,他们要求社区提供既不同又困难的任务示例,然后可以用来测试法学硕士的能力。因此,超越模仿游戏基准(BIG-bench) 项目诞生了。

该项目实际上也专注于研究突发事件和令人惊讶的特性并试图了解它们的起源。

图片来源:此处

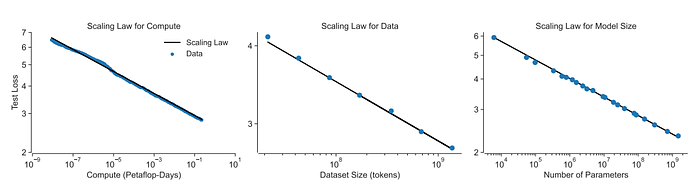

事实上,数据集和文章讨论了概率的出现并试图提供解释。例如,超过一百亿个参数的模型可以解决三位数加法或两位数乘法问题。

基于这篇文章,斯坦福大学的研究人员在最近的一篇论文中对语言模型的突现属性的概念本身提出了质疑。

大型语言模型的突发能力只是幻象吗?

最近的研究表明,大型语言模型表现出新兴能力,这种能力在小规模模型中并不存在……

arxiv.org

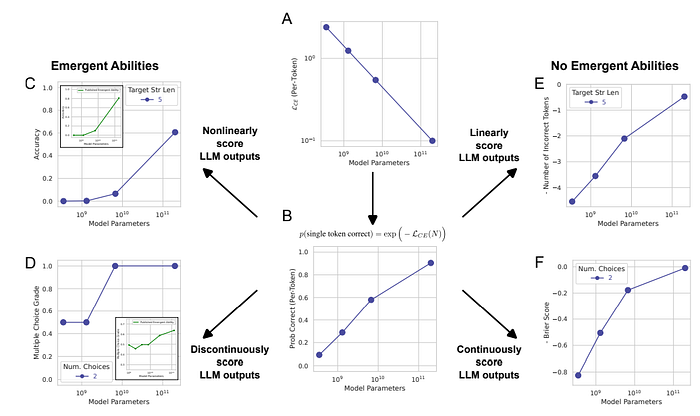

事实上,作者注意到,突现属性似乎仅出现在非线性或不连续的度量中。

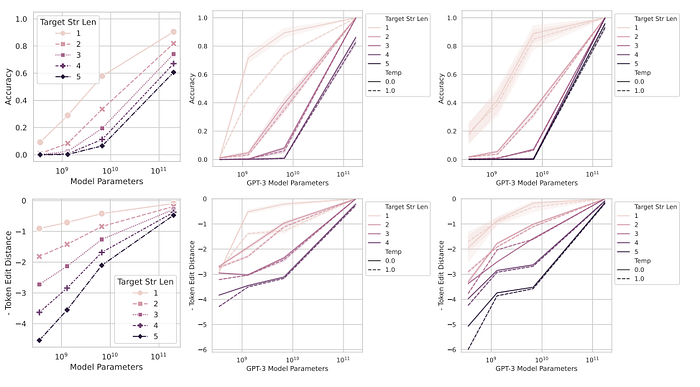

作者为这些特性的出现提供了另一种假设。他们认为,关键在于性能测量的选择。换句话说,随着模型规模的增加,每个标记的错误率平稳、连续且可预测地增长。但随后,研究作者使用不连续的指标来衡量任务的性能,因此看起来模型执行任务的速度突然加快了。

换句话说,小模型在某项任务上表现不错,但我们无法检测到它,因为所选的指标是不连续的,并且只有在一定的误差(在一定的模型尺寸上实现)下我们才能观察到任务中的表现。

图片来源:这里

据作者称,测试示例数量较少也导致小模型无法得到正确的评估。

为了证明这一点,作者从缩放定律开始,根据该定律,性能(或错误)随着指标数量的增加而增加,并且确实在不同量级上表现出一致性。正如作者所指出的,许多指标要求序列中的所有标记都是正确的,尤其是在处理长序列时会导致急剧增加。

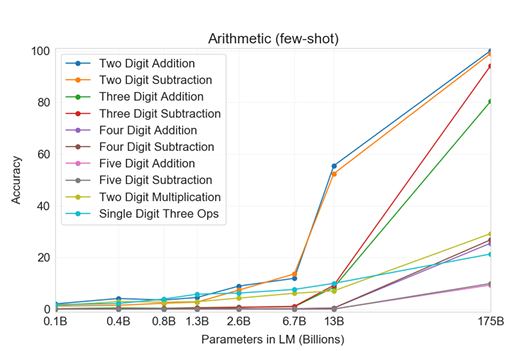

他们之所以能够使用 InstructGPT/GPT-3 进行这些实验,是因为遗憾的是无法访问 LaMDA、Gopher 和 Chinchilla 等模型。这阻止了他们对不同模型进行广泛的评估。由于 LLM 仅针对文本进行训练(而 GPT 针对预测下一个单词进行训练),因此 LLM 的令人惊讶的能力之一是整数算术任务。正如 GPT-3 介绍文章所示,此属性被定义为随尺度函数而出现的/

不同大小模型在小样本设置下所有 10 个算术任务的结果。图片来源:此处

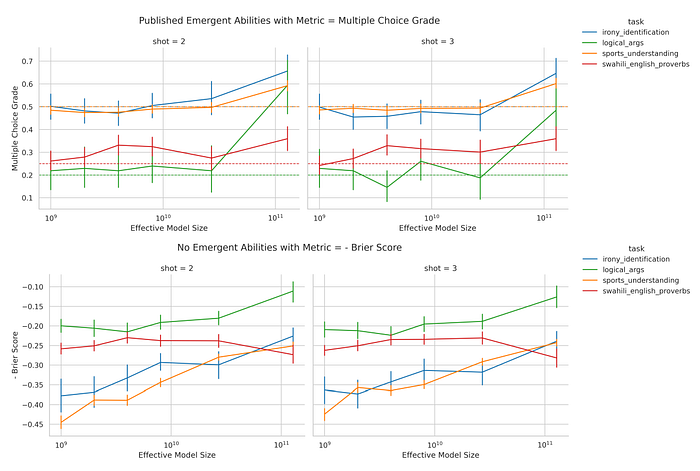

如图 (顶部) 所示,当使用非线性度量来衡量性能时,我们会看到一种突发属性。另一方面,当使用线性度量 (底部) 时,我们会看到性能随着规模的扩大而持续且可预测地增加。

图片来源:这里

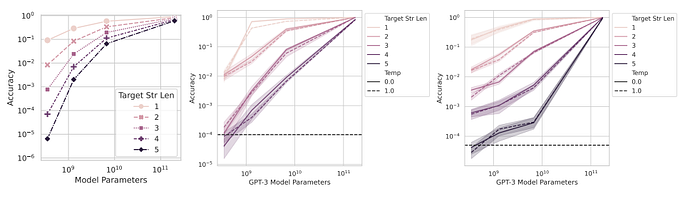

此外,作者指出,即使使用非线性指标,通过增加小模型评估的数据,效果也不会那么明显。换句话说,如果测试数据集较大,即使使用非线性指标,我们也不会观察到如此显著的效果。

事实上,低分辨率(少量测试数据)更有可能帮助小模型实现零精度,这支持了某个属性在某个阈值之后立即出现的说法。

图片来源:这里

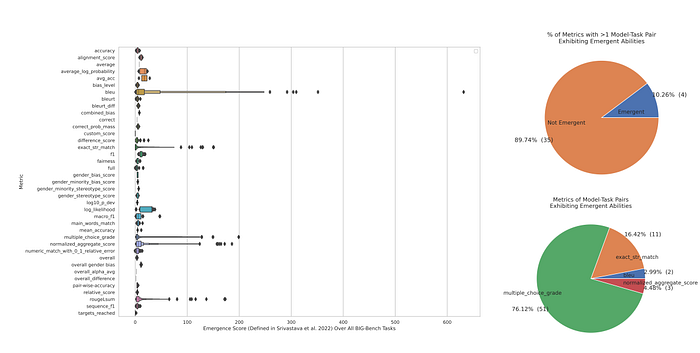

然后,作者决定使用 BigBench(因为它是公开的并且也有很好的记录)对新兴特性进行元分析。此外,该数据集提供了多个评估指标。当作者查看非线性指标(精确字符串匹配、多项选择等级、ROUGE-L-Sum)时,可以观察到新兴特性。另一方面,使用线性指标则没有观察到新兴特性。

最令人惊讶的发现是,92%的声称的新兴能力来自于使用两个不连续的指标——多项选择等级和精确字符串匹配。

因此,如果出现特性的原因确实是使用不连续指标,那么只需更改指标就足以使它们消失。保持模型和任务不变,只需更改评级指标,出现的特性就会消失。在这种情况下,作者只是重复使用了 LaMDA 系列模型的输出,并将指标从不连续(多项选择等级)更改为连续(Brier 分数)。

最后一个问题:但是如果通过选择不连续度量出现了突发属性,我们可以使用不连续度量来创建突发属性吗?

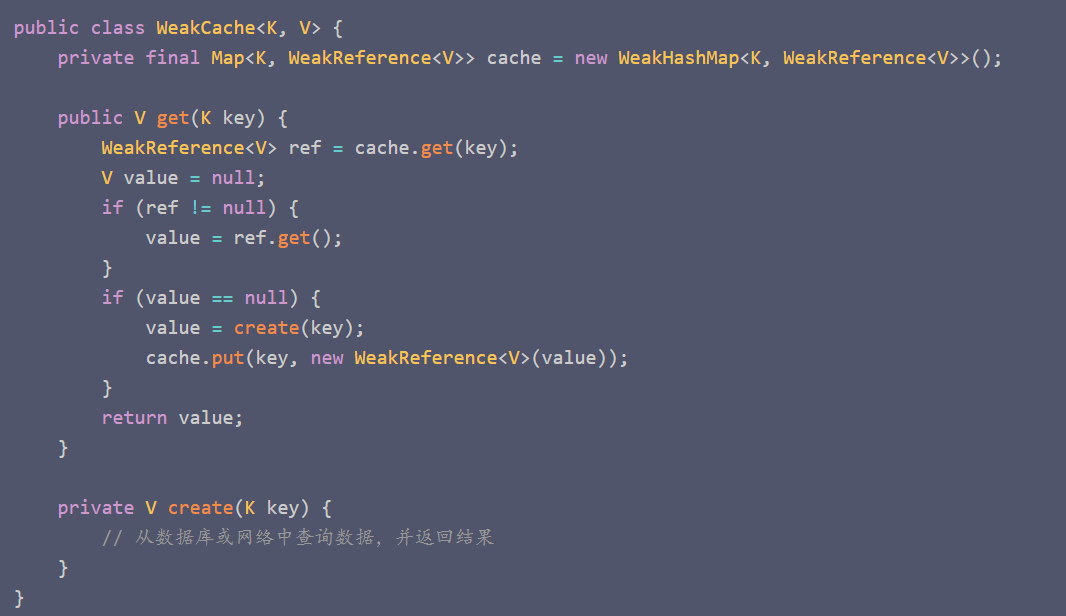

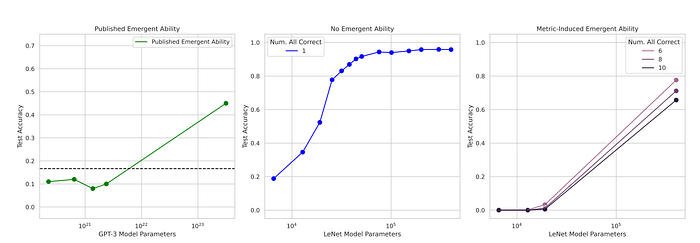

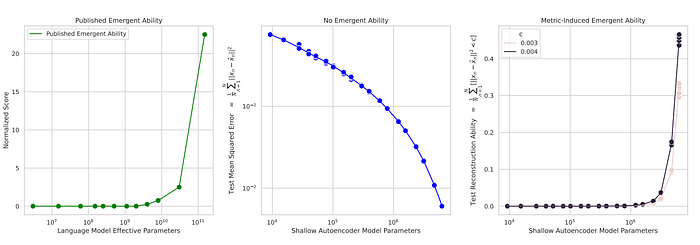

作者以手写数字数据集(MNIST 或数据科学家最喜欢的数据集)的分类能力为例。任何尝试在这个数据集上训练卷积网络的人都注意到,即使只有几层,也能获得不错的结果。增加层数可以提高准确性。如果它是一种突发属性,我们预计一开始准确度会接近于零,通过将参数增加到某个阈值以上,准确度将开始显着提高。

作者使用了LeNet系列(多个模型,参数数量不断增加)。他们只是选择了一个称为子集准确率的新指标:“如果网络正确分类了 K 个(独立)测试数据中的 K 个,则为 1,否则为 0。”

在使用测试准确度时,我们注意到准确度呈现典型的 S 形趋势,而采用新的不连续度量,似乎对手写数字进行分类的能力是一种新兴特性。

作者提供了另一个例子:使用自动编码器进行图像重建。只需创建一个新的不连续度量,重建自动编码器的能力就成为一种新兴特性。

作者总结道:

突发能力可能是研究人员选择的产物,而不是特定任务模型家族的基本属性(来源)

换句话说,如果有人想要一种突发属性,他们所要做的就是选择一个不连续的度量,然后神奇地他们会看到一个属性出现在某个参数阈值之上。

作者保守地表示,“这篇论文应该被解读为声称大型语言模型无法表现出突发能力。 ”他们只是声称迄今为止看到的属性是通过度量选择产生的。

现在确实如此,除非你看到黑天鹅,否则所有天鹅都是白的。但是,下一次出现新出现的属性时,必须检查它是在什么条件下出现的。此外,这再次呼吁重新考虑现在可能不适合衡量模型质量的基准。其次,法学硕士应该是开源的,因为任何主张都可能只是由于评估的选择。

临别感想

长期以来,涌现特性一直被认为是大型语言模型 (LLM) 最令人惊讶的行为之一。超过一定数量的参数就会出现一种能力,这一事实是一个令人着迷但同时也令人恐惧的概念。事实上,一方面,这进一步证明了寻找越来越大的模型的合理性。另一方面,潜在危险能力的出现毫无征兆,这是有问题的。

本文意外地展示了评估指标的选择如何导致属性的出现。这促使我们重新思考基准,并将重点放在评估指标的选择上。其次,涌现属性可能不存在。

更广泛地说,一直以来,许多作者都选择让他们的数据脱颖而出的评估指标。因此,只有当模型及其输出向公众开放以供独立科学调查时,我们才能确定声明的有效性。