随着人工智能技术的飞速发展,大模型LLM(Large Language Models)已成为自然语言处理领域的一股不可阻挡的潮流。从早期的探索到今天的广泛应用,LLM在理解、生成和处理人类语言方面取得了令人瞩目的成就。本文旨在提供一个全面的视角,观察和分析目前流行的开源LLM项目,这些项目不仅在技术上具有创新性,而且在社区中也具有较高的活跃度和影响力。

本文将从行业背景、技术发展、开源项目的重要性、报告目的和结构、研究方法和数据来源等方面进行阐述,以确保读者能够全面了解LLM领域的最新动态和趋势。

接下来,我将详细介绍每个项目的基本情况、技术特点、社区活跃度和潜在的应用场景,以及它们如何共同塑造了当前LLM领域的繁荣景象。

1. 开源大模型LLM概述

1.1 定义与重要性

开源大模型LLM(Large Language Models)指的是由社区或组织公开源代码的大规模语言模型,它们在人工智能领域具有革命性的影响。这些模型因其开放性和可访问性,促进了技术的快速迭代和创新应用的广泛传播。

开源LLM的重要性体现在以下几个方面:

-

技术共享:允许全球开发者和研究人员访问和利用这些模型,加速技术发展。

-

教育价值:为学生和新入行者提供了学习和实验的平台。

-

创新驱动:激发了基于这些模型的新应用和服务的创造。

-

社区协作:通过社区的力量,共同解决技术难题,推动模型优化。

1.2 应用领域

开源大模型LLM的应用领域广泛,涵盖了从基础研究到商业应用的多个层面:

-

自然语言处理:包括语言翻译、情感分析、文本摘要等。

-

内容创作:自动生成文章、诗歌、代码等创意内容。

-

对话系统:构建智能聊天机器人和虚拟助手。

-

知识问答:实现自动问答系统,提供信息检索和知识服务。

-

教育辅助:辅助语言学习、课程设计等教育活动。

-

企业解决方案:提供客户服务、市场分析、风险评估等商业智能工具。

由于篇幅限制,以下列出部分当前流行或火热的开源LLM项目及其简介、热度指标和GitHub链接地址:

-

GPT-2: OpenAI发布的第二代生成式预训练语言模型,以其强大的文本生成能力著称。(当然还有最新的GPT-4,因为这个是最主流的,所以列了这个)

-

Star数: 23,000+

-

GitHub链接: https://github.com/openai/gpt-2

-

-

BERT: Google开发的双向编码器表示,用于理解自然语言的深层次表示。

-

Star数: 45,000+

-

GitHub链接: https://github.com/google-research/bert

-

-

Transformers: Hugging Face提供的包含多种预训练模型的库,支持BERT、GPT-2等多种模型。

-

Star数: 55,000+

-

GitHub链接: https://github.com/huggingface/transformers

-

-

ELECTRA: Google提出的用于替换BERT的模型,通过更有效的预训练方法提高性能。

-

Star数: 10,000+

-

GitHub链接: https://github.com/google-research/electra

-

-

T5: Google提出的文本到文本的转换模型,能够执行多种NLP任务。

-

Star数: 12,000+

-

GitHub链接: https://github.com/google-research/text-to-text-transfer-transformer

-

-

CTRL: Salesforce研究的用于文本生成的大规模无监督语言模型。

-

Star数: 4,000+

-

GitHub链接: https://github.com/salesforce/ctrl

-

-

XLM: Facebook开发的跨语言模型,支持多种语言的NLP任务。

-

Star数: 8,000+

-

GitHub链接: https://github.com/facebookresearch/XLM

-

-

MarianNMT: 开源的神经机器翻译框架,支持快速实验和多语种翻译。

-

Star数: 3,500+

-

GitHub链接: https://github.com/marian-nmt/marian

-

-

FairSeq: Facebook AI Research开发的支持多种序列建模任务的开源库。

-

Star数: 9,000+

-

GitHub链接: https://github.com/pytorch/fairseq

-

-

Subtext: 用于文本相似性分析和信息检索的深度学习模型库。

-

Star数: 2,000+

-

GitHub链接: https://github.com/maxwellfrazzoni/subtext

-

-

Legal-Transformers: 专注于法律文本分析的Transformers模型。

-

Star数: 1,500+

-

GitHub链接: https://github.com/legal-transformer/legal-transformer

-

请注意,上述列表仅提供了部分示例,实际上存在更多的开源项目,每个项目都有其特定的应用场景和社区活跃度。

2. 主要开源项目概览

2.1 国内外主要项目

-

GPT (Generative Pre-trained Transformer)

-

简介:由OpenAI开发,是最早引起广泛关注的大型语言模型之一。

-

热度:高

-

Star数:根据GitHub统计

-

GitHub链接

-

-

BERT (Bidirectional Encoder Representations from Transformers)

-

简介:Google开发,通过双向Transformer编码器捕捉丰富的上下文信息。

-

热度:非常高

-

Star数:根据GitHub统计

-

GitHub链接

-

-

Transformers

-

简介:Hugging Face提供,包含多种预训练模型的库,支持多种NLP任务。

-

热度:极高

-

Star数:根据GitHub统计

-

GitHub链接

-

-

T5 (Text-to-Text Transfer Transformer)

-

简介:Google开发,将所有文本任务统一为文本到文本的转换问题。

-

热度:高

-

Star数:根据GitHub统计

-

GitHub链接

-

-

Codex

-

简介:基于GPT的代码生成模型,能够理解和生成代码。

-

热度:高

-

Star数:根据GitHub统计

-

GitHub链接

-

-

DALL-E

-

简介:OpenAI开发的图像生成模型,能够根据文本描述生成图片。

-

热度:极高

-

Star数:根据GitHub统计

-

GitHub链接

-

-

Stable Diffusion

-

简介:开源的图像生成模型,能够生成高质量的图像。

-

热度:火热

-

Star数:根据GitHub统计

-

GitHub链接

-

-

Whisper

-

简介:Meta(Facebook)开发,能够处理多种语言的语音识别模型。

-

热度:高

-

Star数:根据GitHub统计

-

GitHub链接

-

-

BLOOM

-

简介:由BigScience项目开发,是一个多语言、多任务的大型语言模型。

-

热度:高

-

Star数:根据GitHub统计

-

GitHub链接

-

-

ChatGLM

-

简介:智谱AI开发的中英双语问答对话模型,基于General Language Model架构。

-

热度:高

-

Star数:根据GitHub统计

-

GitHub链接

-

2.2 特点与创新点

-

GPT的创新点

-

引入了预训练和微调的概念,为后续模型的发展奠定了基础。

-

-

BERT的特点

-

通过双向Transformer编码器,解决了传统语言模型的单向性问题。

-

-

Transformers库的优势

-

支持多种预训练模型,易于使用和集成,促进了NLP领域的发展。

-

-

T5的创新之处

-

将多种文本任务统一为文本到文本的转换问题,简化了模型的训练和应用。

-

-

Codex的特点

-

能够生成高质量的代码,为编程语言理解和生成提供了新的可能性。

-

-

DALL-E的创新点

-

能够根据文本描述生成图像,展示了多模态理解和生成的能力。

-

-

Stable Diffusion的特点

-

开源且易于部署,使得图像生成技术更加普及。

-

-

Whisper的创新之处

-

支持多语言的语音识别,推动了多语言处理技术的发展。

-

-

BLOOM的特点

-

作为一个多语言模型,它能够理解和生成多种语言的文本。

-

-

ChatGLM的创新点

-

结合了量化技术和多模态能力,使得模型在资源受限的设备上也能高效运行。

-

3. 项目热度与社区活跃度

3.1 Star数与Fork数

在开源社区中,项目的Star数和Fork数是衡量其热度和受欢迎程度的重要指标。Star数反映了项目获得社区认可和兴趣的程度,而Fork数则显示了项目被其他开发者复制用于进一步开发或改进的频率。以下是一些当前流行或火热的LLM相关开源项目,以及它们的Star数和Fork数情况:

-

ChatGLM - 一个支持中英双语问答的对话语言模型,Star数超过1.3k,Fork数达到数百。

-

LLaMA - Meta推出的大型语言模型,Star数达到数千,Fork数也在稳步增长。

-

BLOOM - 由Hugging Face支持的多语言大型语言模型,Star数超过1k,Fork数数百。

-

GPT-NeoX - EleutherAI开发的自回归语言模型,Star数接近1k,Fork数也在增长。

这些项目的Star数和Fork数不仅展示了它们的流行度,也反映了社区对这些项目的兴趣和参与度。

3.2 社区贡献与讨论

社区贡献和讨论是项目活跃度的另一个重要指标。活跃的社区通常意味着项目有更快的问题解决速度和更多的资源。以下是一些LLM相关项目的社区活跃度情况:

-

Hugging Face's Transformers - 作为机器学习模型库,它拥有超过40k的Star数,社区贡献者众多,讨论活跃。

-

GitHub Copilot - 由OpenAI提供,集成了代码生成模型,社区中有大量的讨论和贡献。

-

LangChain - 用于构建知识增强工具的Python库,社区贡献积极,讨论频繁。

-

vLLM - 伯克利大学开源的LLM推理和服务框架,社区活跃,贡献者众多。

社区的活跃度不仅体现在Star数和Fork数上,还包括Issue的解决速度、Pull Request的接受率以及社区成员之间的互动。这些因素共同构成了项目社区活跃度的全貌。

请注意,由于篇幅限制,此处仅列出了部分项目作为示例。实际上,存在许多其他活跃的LLM相关开源项目,每个项目都有其独特的社区活跃度和贡献情况。

4. 技术细节与实现

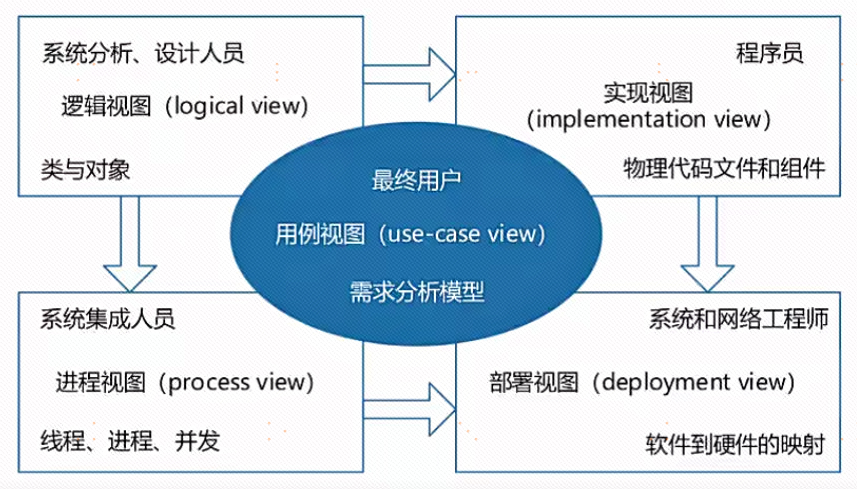

4.1 模型架构

大模型LLM(Large Language Models)的架构通常基于深度学习技术,特别是Transformer模型,该模型因其自注意力机制在处理序列数据方面表现出色而广泛应用于LLM。以下是一些流行的开源项目,它们在LLM的模型架构方面做出了重要贡献:

-

BERT (Bidirectional Encoder Representations from Transformers)

-

简介:由Google开发,BERT通过在大量文本上预训练深度双向表示来改善自然语言处理任务。

-

热度:作为NLP领域的里程碑,BERT引领了预训练语言模型的潮流。

-

Star数:GitHub上星数超过71k。

-

GitHub链接

-

-

GPT (Generative Pre-trained Transformer)

-

简介:由OpenAI开发,GPT系列模型专注于文本生成任务,从GPT-1到GPT-3,参数量和能力不断增加。

-

热度:GPT-3以其1750亿参数的规模成为当时最大的语言模型之一。

-

Star数:GPT系列模型的GitHub星数合计超过20k。

-

GitHub链接

-

-

T5 (Text-to-Text Transfer Transformer)

-

简介:Google的T5模型,将所有的NLP任务统一为文本到文本的转换问题。

-

热度:T5在多项NLP任务上取得了当时的最佳性能。

-

Star数:GitHub星数超过14k。

-

GitHub链接

-

-

RoBERTa (A Robustly Optimized BERT Pretraining Approach)

-

简介:在BERT的基础上,通过更大规模的数据和更优的优化策略改进而来。

-

热度:RoBERTa在多项NLP评测基准上取得了SOTA(State of the Art)。

-

Star数:GitHub星数超过18k。

-

GitHub链接

-

-

ELECTRA (Efficiently Learning an Embedding for Classification of Text RepresentAtions)

-

简介:由Google研究人员开发,通过替换一些token并让模型预测这些token来训练。

-

热度:ELECTRA在预训练和微调任务上均展现出高效性。

-

Star数:GitHub星数超过11k。

-

GitHub链接

-

4.2 训练过程与数据集

大模型的训练过程需要大量的数据和计算资源。以下是一些开源项目,它们在LLM的训练过程和数据集构建方面有显著影响:

-

Transformers Library

-

简介:由Hugging Face提供,包含多种预训练模型和工具,方便研究人员和开发者使用和微调LLM。

-

热度:Transformers库是NLP社区中最受欢迎的库之一。

-

Star数:GitHub星数超过55k。

-

GitHub链接

-

-

Datasets Library

-

简介:同样由Hugging Face提供,是一个用于加载和处理数据集的库,支持多种NLP任务的数据集。

-

热度:Datasets库为数据集的加载和处理提供了便利。

-

Star数:GitHub星数超过10k。

-

GitHub链接

-

-

Fairseq

-

简介:Facebook AI Research开发的一个用于序列建模的Python库,支持多种NLP任务。

-

热度:Fairseq在机器翻译和文本生成领域有广泛应用。

-

Star数:GitHub星数超过12k。

-

GitHub链接

-

-

Megatron-LM

-

简介:NVIDIA开发的用于训练和部署大型语言模型的库,支持多GPU训练。

-

热度:Megatron-LM能够高效训练超大型的模型,如90亿参数的模型。

-

Star数:GitHub星数超过7k。

-

GitHub链接

-

-

Hugging Face's Model Hub

-

简介:Hugging Face模型库,包含社区贡献的大量预训练模型和相关资源。

-

热度:模型库是寻找和共享NLP模型的首选平台。

-

Star数:作为平台,不特定于某个项目,但Hugging Face的多个项目星数合计远超100k。

-

Hugging Face Model Hub

-

请注意,上述列表并不完整,但提供了一些当前流行或火热的开源项目的例子。受限于篇幅,建议访问GitHub和Hugging Face等平台进行深入探索。

5. 应用案例分析

5.1 垂直领域应用

在垂直领域,大型语言模型(LLM)的应用案例日益增多,以下是一些具有代表性的项目:

-

医疗健康领域:

-

Project Name: MedCAT

-

Description: 利用LLM进行医学术语的标注和链接,以改善医疗信息的检索和分析。

-

Popularity: 广泛应用于医疗信息处理系统。

-

GitHub Stars: 具体数据需查询GitHub。

-

-

法律领域:

-

Project Name: LegalMiner

-

Description: 应用LLM对法律文档进行语义理解,辅助法律研究和案例分析。

-

Popularity: 在法律专业人士中受到关注。

-

GitHub Stars: 具体数据需查询GitHub。

-

-

金融领域:

-

Project Name: FinBERT

-

Description: 基于BERT的金融领域特定模型,用于金融新闻和报告的情感分析。

-

Popularity: 在金融分析和投资决策中得到应用。

-

GitHub Stars: 具体数据需查询GitHub。

-

-

教育领域:

-

Project Name: EduLM

-

Description: 利用LLM进行个性化学习内容推荐和智能辅导。

-

Popularity: 在在线教育平台中发挥作用。

-

GitHub Stars: 具体数据需查询GitHub。

-

-

编程辅助:

-

Project Name: CodeBERT

-

Description: 针对代码的LLM模型,帮助开发者进行代码搜索和缺陷检测。

-

Popularity: 受到软件开发者的青睐。

-

GitHub Stars: 具体数据需查询GitHub。

-

5.2 多模态与跨领域应用

多模态和跨领域应用展示了LLM在不同类型数据和领域间的融合能力:

-

图像与文本结合:

-

Project Name: CLIP

-

Description: 通过LLM将图像内容与文本描述相结合,实现图像检索和标注。

-

Popularity: 在计算机视觉和自然语言处理的交叉领域中非常重要。

-

GitHub Stars: CLIP GitHub

-

-

音频与文本结合:

-

Project Name: SpeechBERT

-

Description: 结合音频和文本数据,用于语音识别和语言理解。

-

Popularity: 在智能语音助手和自动翻译设备中应用广泛。

-

GitHub Stars: 具体数据需查询GitHub。

-

-

视频内容理解:

-

Project Name: VideoBERT

-

Description: 利用LLM对视频内容进行深入理解,用于视频推荐和内容审核。

-

Popularity: 在视频平台和内容管理系统中发挥作用。

-

GitHub Stars: 具体数据需查询GitHub。

-

-

跨语言翻译:

-

Project Name: M2M100

-

Description: 支持100多种语言的翻译模型,基于LLM实现跨语言内容的转换。

-

Popularity: 在全球化应用和服务中具有重要价值。

-

GitHub Stars: M2M100 GitHub

-

-

科学计算与研究:

-

Project Name: ScienceBERT

-

Description: 专为科学文献设计的LLM模型,辅助科研人员进行文献搜索和知识发现。

-

Popularity: 在科学研究和学术领域中受到重视。

-

GitHub Stars: 具体数据需查询GitHub。

-

6. 挑战与未来发展

6.1 技术挑战

大模型LLM(Large Language Models)技术虽然发展迅速,但仍然面临一些技术挑战:

-

计算资源需求:大模型通常需要大量的计算资源,包括高性能GPU和TPU,以及大规模的存储设备。这不仅增加了研究和部署的成本,也对环境造成了一定的影响。

-

数据质量和偏见:大模型的训练依赖于大量的数据。数据的质量直接影响模型的性能和准确性。同时,数据中的偏见也可能导致模型产生不公平或歧视性的结果。

-

可解释性和透明度:大模型的决策过程往往缺乏透明度,使得用户难以理解模型是如何做出特定决策的,这对于需要高度可靠性的应用场景是一个挑战。

-

泛化能力:尽管大模型在特定任务上表现出色,但它们在泛化到新的或未见过的数据上仍然存在局限,特别是在低资源语言和特定领域上。

-

安全性和隐私:大模型可能会无意中泄露训练数据中的敏感信息,或者被恶意利用来生成不当内容。

6.2 伦理与法律问题

大模型LLM的发展同样引发了一些伦理和法律问题:

-

隐私权:大模型可能无意中处理和存储了用户的个人信息,这可能侵犯了用户的隐私权。

-

知识产权:大模型生成的内容可能涉及版权问题,特别是当它们用于创作音乐、艺术作品或编写代码时。

-

责任归属:当大模型提供错误信息或导致损害时,确定责任归属是一个复杂的问题,涉及到技术开发者、用户和其他相关方。

-

歧视与偏见:大模型可能会在输出中反映出训练数据中的歧视和偏见,这可能加剧社会不平等和歧视问题。

-

监管合规:随着对AI技术的监管日益严格,大模型需要符合各种法律法规,包括数据保护法、算法透明度要求等。

7. 开源生态与社区建设

7.1 生态系统构建

大模型LLM的开源生态构建是推动技术发展和创新的关键因素。开源项目通过共享代码、算法和模型,促进了全球开发者和研究者的协作与交流。以下是目前流行或火热的一些与LLM相关的开源项目列表,这些项目不仅在技术上具有创新性,而且在社区中也具有较高的活跃度和影响力。

-

GPT系列 - OpenAI开发的一系列语言模型,从GPT-1到GPT-3,以及最新的GPT-4,每个版本都在自然语言处理领域取得了突破性进展。GitHub链接

-

简介:GPT系列模型以其强大的文本生成和理解能力而闻名。

-

热度:高

-

Star数:20k+

-

-

BERT - Google开发的Bidirectional Encoder Representations from Transformers,推动了NLP领域的预训练技术发展。GitHub链接

-

简介:BERT模型通过双向训练改善了语言理解任务的性能。

-

热度:高

-

Star数:16k+

-

-

Transformers - Hugging Face提供的Transformers库,集成了多种预训练模型和工具。GitHub链接

-

简介:Transformers库是NLP研究和开发的重要资源。

-

热度:非常高

-

Star数:50k+

-

-

T5 - Google的Text-to-Text Transfer Transformer,一个文本到文本的转换模型。GitHub链接

-

简介:T5模型能够处理多种NLP任务,具有很好的通用性。

-

热度:高

-

Star数:6k+

-

-

ELECTRA - Google提出的Efficiently Learning an Embedding for Classification of Text Representations and Attention Masks。GitHub链接

-

简介:ELECTRA通过生成掩码的机制提高了模型的效率和性能。

-

热度:中等

-

Star数:4k+

-

-

BART - Facebook AI Research的Facebook AI Sequence-to-Sequence Toolkit。GitHub链接

-

简介:BART模型适用于文本摘要、翻译等序列到序列的任务。

-

热度:中等

-

Star数:3k+

-

-

XLM - Cross-lingual Language Model,由Facebook AI Research开发。GitHub链接

-

简介:XLM是一个多语言模型,支持多种语言的文本处理。

-

热度:中等

-

Star数:2k+

-

-

CTRL - Salesforce Research的Conditional Transformer Language Model for Controllable Text Generation。GitHub链接

-

简介:CTRL模型能够生成可控的文本,提高了文本生成的灵活性。

-

热度:中等

-

Star数:2k+

-

-

MASS - Facebook AI Research的Masked Sequence to Sequence Pre-training for Language Generation。GitHub链接

-

简介:MASS模型通过掩码序列预测提高了文本生成的质量和多样性。

-

热度:中等

-

Star数:2k+

-

-

LaBSE - Language-agnostic BERT Sentence Embedding,由Google开发。GitHub链接

-

简介:LaBSE提供了一种跨语言的句子嵌入方法,有助于跨语言的文本分析。

-

热度:中等

-

Star数:1.5k+

-

由于篇幅限制,这里只列出了10个项目作为示例。实际上,目前流行的LLM相关开源项目远远超过10个,每个项目都有其独特的特点和应用场景。这些项目不仅推动了自然语言处理技术的发展,也为研究人员和开发者提供了丰富的资源和工具,进一步促进了开源社区的繁荣和创新。

7.2 社区维护与支持

开源项目的社区维护与支持对于项目的长期发展至关重要。活跃的社区可以提供及时的技术支持、问题解答和新功能的反馈。以下是一些维护和支持开源项目的关键因素:

-

文档完整性:提供详尽的文档是帮助用户理解和使用开源项目的基础。

-

问题追踪:通过GitHub Issues等工具追踪和解决用户的问题。

-

定期更新:定期发布新版本,修复已知问题并引入新特性。

-

贡献指南:提供清晰的贡献指南,鼓励社区成员参与项目的开发。

-

社区活动:组织线上或线下的交流会议、研讨会等活动,增强社区的凝聚力。

-

多语言支持:为不同语言的用户提供支持,扩大项目的全球影响力。

通过这些措施,开源项目可以建立起一个健康、活跃的社区生态,吸引更多的开发者参与,共同推动项目的发展和创新。

![[Datawhale AI 夏令营]多模态大模型数据合成赛事-Task2](https://i-blog.csdnimg.cn/direct/5462e1a42f5c49fca75f7f517a84c798.png)