摘要

对于自动导航的机器人来说,精确的状态估计是基本问题。为了实现局部精确和全局无漂移的位姿估计,通常将具有互补属性的多个传感器进行融合。在一个小的区域内,局部传感器,如相机、IMU、Lidar等,提供了精确的位姿,而在一个大场景环境下,全局传感器,如gps、magnetometer、barometer等,提供有噪声但全局无漂移的定位。在本文中,我们提出一种传感器融合框架,将局部状态和全局传感器融合,实现局部精确和全局无漂移的位姿估计。现有的VO/VIO方法产生的局部估计,在位姿图优化中与全局传感器融合。在图优化中,局部估计被对齐到全局坐标系中。同时,累计漂移被消除。

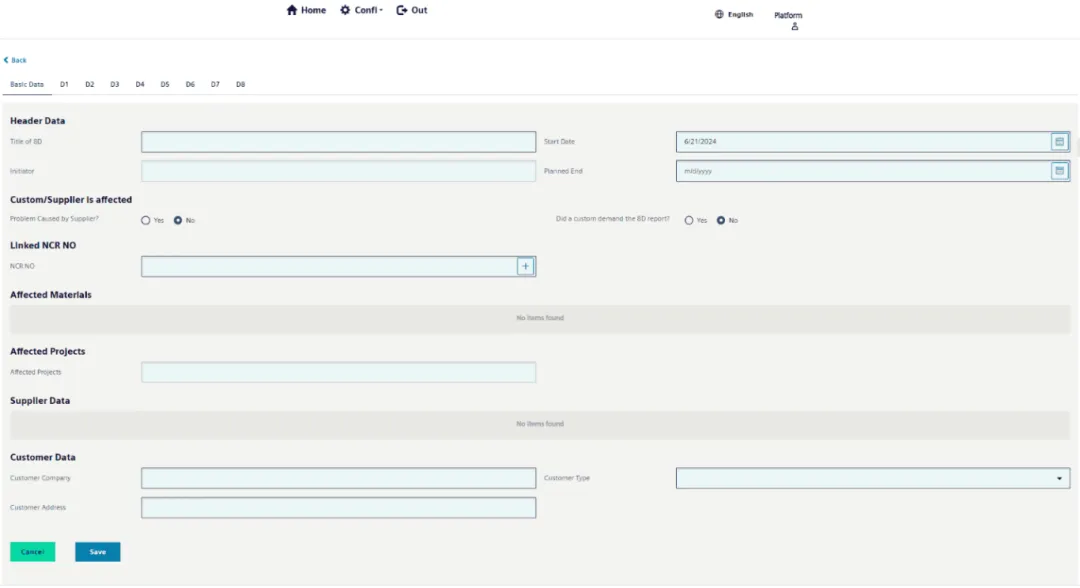

通用优化框架如下图1所示。

图1 通用优化框架图。全局估计器将局部估计与多种全局传感器融合,为了获得局部精确和全局无偏移的位姿估计。

一、概述

根据测量的参考框架,我们将传感器分为局部和全局类型。

1.局部传感器:摄像头、激光雷达LiDAR、IMU(加速度计和陀螺仪)等。这类传感器不是全局参考的,因此通常需要一个参考框架。一般来说,机器人的第一个姿态被设置为原点,以便启动传感器,机器人的姿态从起点开始逐步演变。因此,累积的漂移会随着与起点的距离增加而增长。

2.全局传感器:全球定位系统GPS、磁力计、气压计等。这类传感器是全局参考的。它总是在一个固定的全局坐标系下工作,例如地球坐标系。参考坐标系的原点是固定的,并且事先已知。它们的