大家好!今天我非常激动地向大家介绍一款新工具,叫做AutoGGUF。AutoGGUF是一款全新的图形用户界面,它是用Python语言编写的,基于PyQt6库。PyQt6是Python的一种绑定,用于创建图形用户界面。而AutoGGUF的设计初衷是简化使用Lama CPP库量化GGF模型的过程。

什么是量化?

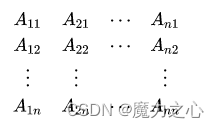

在深入介绍AutoGGUF之前,我们先来了解一下什么是量化。量化是一种技术,用于降低模型权重和激活值的精度。这种方法可以帮助减少内存使用和提高性能。在量化中,有一个关键概念叫做BPW(Bits Per Weights,即每个权重的位数)。BPW值决定了应用于模型的量化级别。BPW值越低,量化越激进,这虽然可以显著减少内存使用,但也可能影响模型的精度。

常见的BPW值包括:

- 32位:全精度,没有量化。

- 16位:半精度或16位浮点数。

- 8位:量化到8位,例如int8。

- 4位:量化到4位,例如int4。

- 2位:量化到2位。

- 最近还出现了1位量化。

GGF是什么?

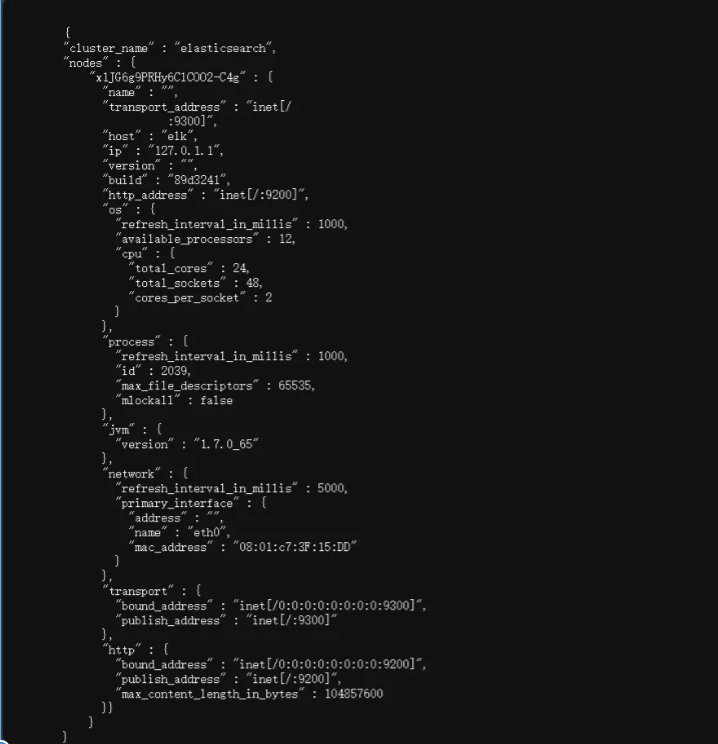

在这篇文章中,我们多次提到的GGF是什么呢?GGF代表Generalized Grouped Uniform Quantization Format(通用分组统一量化格式)。这种量化方案目前非常流行。在GGF中,量化级别由一个字符串代码表示,该代码指示了量化值的精度和格式。

例如,在Hugging Face上选择任意一个GGF模型,进入模型卡页点击文件,向下滚动,你会看到类似于“iq2 SX”这样的代码。这里的“Q”代表量化,“2”代表使用2位量化值的BPW。此外,还有“K”表示量化应用于权重值或内核值,“L”表示应用于低精度值,“M”表示中等精度,“S”表示小精度。

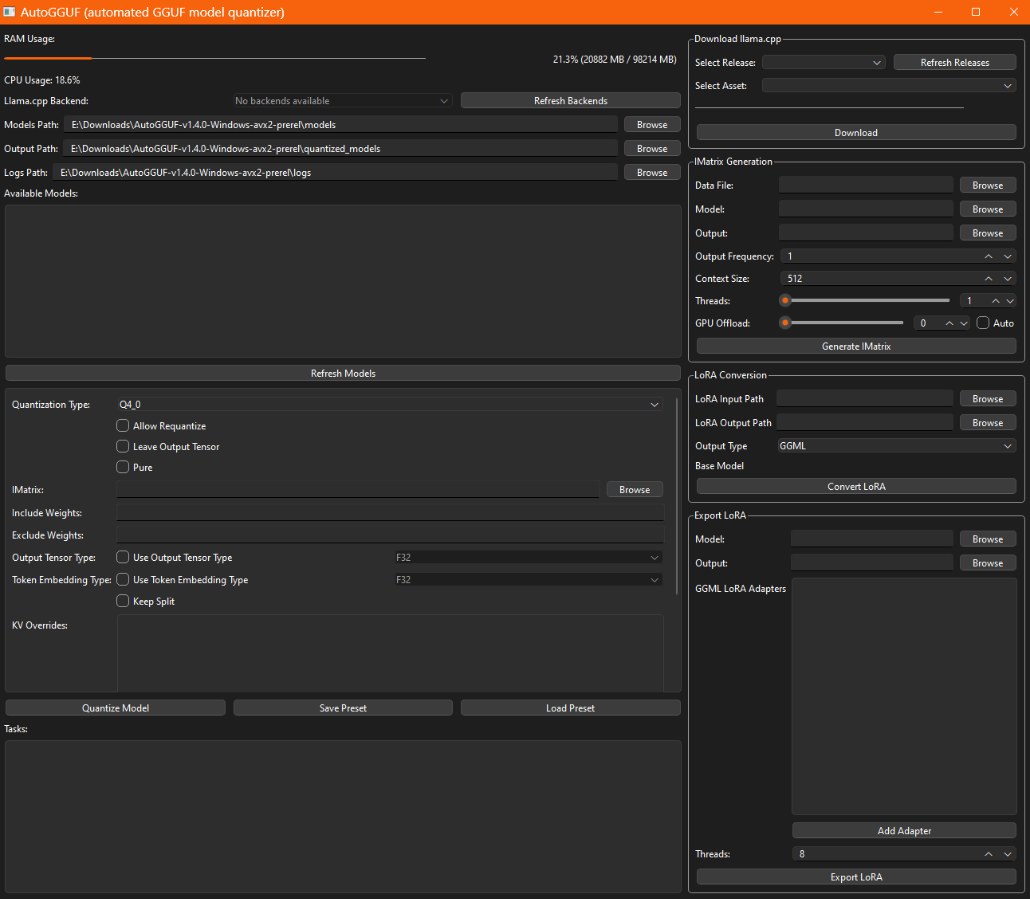

AutoGGUF的创新功能

AutoGGUF不仅仅是一个量化工具,它还具备许多创新功能:

- 自动下载和管理Lama CPP后端:这使得我们可以在C/C++格式中进行量化。

- 支持CUDA加速:利用NVIDIA的CUDA库加速GPU运算。

- 简化的模型选择和量化流程:提供可配置的量化参数。

- 系统资源监控:在操作过程中监控系统资源使用情况。

- 支持线程执行:如果操作系统支持的话。

- 广泛的日志记录:方便用户调试。

- 跨平台兼容:支持Windows和Ubuntu系统。

- 开源和多语言支持:采用MIT许可证,支持28种语言,便于多语言模型的量化。

如何安装和使用AutoGGUF

接下来,我们来看一下如何安装和使用AutoGGUF。在开始之前,特别感谢Mast Compute为这次演示提供GPU和虚拟机。如果你想租用GPU,Mast Compute是一个不错的选择。

首先,我们需要创建一个名为AutoGGUF的虚拟环境,并安装必要的依赖库,包括torch和transformers。然后,从GitHub克隆AutoGGUF的代码库并进入该目录。

conda create -n auto_gguf python=3.11 -y

conda activate auto_gguf

pip install torch transformers

git clone <AutoGGUF的GitHub链接>

cd auto_ggf

接下来,安装其他所需的依赖库,例如pyqt等。

pip install pyqt6

所有依赖安装完毕后,我们可以运行AutoGGUF。

python3 source/main.py

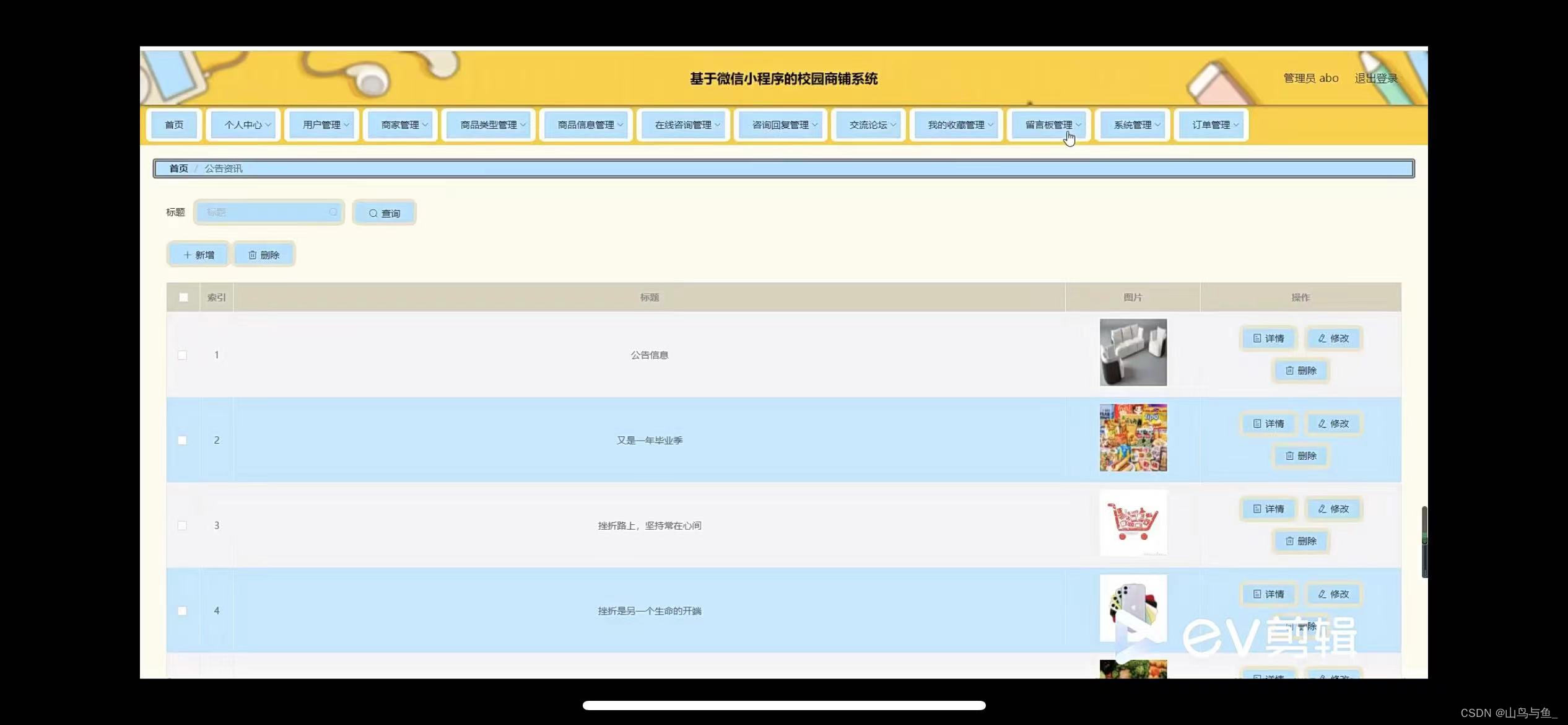

运行后,会打开一个GUI界面。你可以在界面上看到CPU使用率、RAM使用率等信息。你可以选择模型和量化级别,然后点击“量化模型”按钮开始量化。

总结

AutoGGUF是一款非常强大的工具,不仅简化了量化过程,还支持多种高级功能。如果你对量化技术感兴趣,AutoGGUF绝对是一个值得一试的工具。

![C语言程序设计-[4] 算法和程序结构](https://i-blog.csdnimg.cn/direct/bf674de5b3c1460f8737b7d274729a00.png)