欢迎来到雲闪世界。本文旨在讨论 word2vec 和 GloVe 算法的发展,因为这与这些算法的第二个应用目的有关:分析文本语料库中包含的概念。首先,根据 word2vec 算法的历史背景对其进行讨论。然后,描述类比完成任务,该任务突出了 word2vec 嵌入可能实现的语义算法的潜力。最后,将 GloVe 算法的发展与 word2vec 算法进行对比。

欢迎来到雲闪世界。本文旨在讨论 word2vec 和 GloVe 算法的发展,因为这与这些算法的第二个应用目的有关:分析文本语料库中包含的概念。首先,根据 word2vec 算法的历史背景对其进行讨论。然后,描述类比完成任务,该任务突出了 word2vec 嵌入可能实现的语义算法的潜力。最后,将 GloVe 算法的发展与 word2vec 算法进行对比。

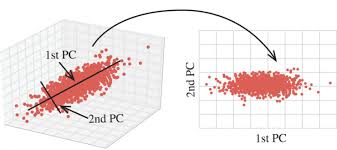

word2vec 算法 (Mikolov 等,2013a) 结合了两个主要技术见解:(1) 连续向量可用于表示语义信息 (2) 神经网络学习的内部表示具有概念意义。然而,当该算法于 2013 年推出时,语义信息的连续表示和内部表示的概念价值都不是新想法。更具体地说,在信息检索领域,潜在语义分析 (LSA;Deerwester 等,1990) 和潜在狄利克雷分配 (Blei 等,2003) 被提出作为统计方法,利用文本中潜在的语义信息来改进将单词视为指示特征(彼此独立存在)而不是有意义的符号(彼此相关存在)的方法。

此外,早在 1980 年代,人们就开始讨论神经网络在隐藏层中表示概念的能力(Hinton,1986 年)。虽然 Hinton(1986 年)讨论的概念不是使用现代词语表示法研究的那种人类可解释的概念(例如,Stoltz 和 Taylor,2019 年),但这项工作支持将在训练神经网络时学习到的内部表示用作非任意网络定义的概念,这些概念会在给定新数据时进行更新。尽管联结主义早期的工作具有理论见解,但它受到计算资源和数据可用性的限制,到 1990 年代,该领域进入了被称为 AI 寒冬的时代(McShane & Nirenburg,2021 年,第 1 章)。

然而,到了 2010 年代,大数据革命已如火如荼地展开,定量研究的重点开始从传统的数据建模技术(假设底层分布生成数据)转向算法技术(将底层分布置于黑匣子中)(Breiman,2001 年)。在这种背景下考虑神经语言建模时,可用的文本数据量超出了现有框架可以处理的处理能力。为了解决这个问题,Mikolov 等人(2009 年)发现,如果将训练分为两个步骤,语言模型的训练效率会更高:首先,可以通过简单的网络学习单词表示,然后,可以将这些表示作为输入传递给更复杂的网络,以便在单独的任务上进行进一步训练。

基于这一见解,Mikolov 等人 (2013a) 提出在以下任一任务中使用单层前馈神经网络对词语表征进行预训练:对于连续词袋 (CBOW) 任务,网络根据上下文预测单词;对于连续 skip-gram (SG) 任务,网络根据单词预测其上下文;在这两种情况下,上下文都定义为由中心词两侧可变数量的单词组成的窗口。Mikolov 等人 (2013a) 表明 SG 优于 CBOW(以及之前提出的两种方法),因此,SG 模型被扩展(Mikolov 等人,2013b)用于短语表征和进一步优化。具体而言,通过子采样,训练效率得到提高(由于训练期间预测频繁词的次数减少),并且学习了更规则的表征(由于频繁词对语义空间整体形状的拉动减少)。

除了将 word2vec 定位为可以解锁神经语言建模的预训练方法之外,Mikolov 等人 (2013a) 还提出了一种类比完成评估方案,强调了使用单词的连续表示可能进行的语义算法。在 Mikolov 等人 (2013a) 之前,单词表示质量通常通过检查具有相似表示的单词列表来评估(其中相似性定义为向量空间内的接近度,通常通过余弦距离计算);然而,Mikolov 等人 (2013a) 批评这种方法未能捕捉语言表现出的各种句法和语义相似性。例如,他们说,来自同一类别的单词之间的相似性(例如法国和意大利这样的国家)可能很容易 在语义空间中捕捉,但他们询问其他关系(例如big和greater之间的屈折关系)是否可以在同一空间中很好地捕捉。为了解决这一限制,他们的测试评估了九种句法关系和五种语义关系的表示质量。

因为相似词列表对于一起评估各种类型的相似性是无效的(即,相似词列表可能会显示以不同方式与给定单词相似的单词,但如果给定一个列表,则必须将这些差异区分开来),为了解决这个问题,Mikolov 等人(2013a)定义了一个类比完成任务,询问哪个单词D与单词C最相似,就像单词A与单词B最相似一样。通过这种方式,他们利用这样的洞察力来强制评估相似性类型:在语义空间内,可以执行诸如加法之类的简单向量运算,从而保留语义关系。语义空间的这一特征通常通过例如king − man + woman → queen来捕捉,自然语言处理文献及其他领域已对其进行了探索,以减轻偏见(例如 Caliskan,2016)和文化分析(例如 Kozlowski 等人,2019)。

鉴于 word2vec 作为预训练方法的价值以及它所实现的语义算法的奇特之处,此后不久就发表了一系列相关工作。也许最值得注意的是,Pennington 等人 (2014) 提出了用于单词表示的全局向量 (GloVe) 作为训练单词表示的替代方案。这项工作旨在通过阐明出现此类规律所需的属性来解决 word2vec 表示所捕获的语言规律起源的不透明性问题。为此,他们研究了不同类别的方法。更具体地说,根据 Pennington 等人 (2014) 的说法,有两类主要方法可用于训练单词表示:(1) 全局矩阵分解 (GMF) 方法(例如 LSA:Deerwester 等人,1990)和 (2) 局部上下文窗口 (LCW) 方法(例如 word2vec:Mikolov 等人,2013a、b)。 Pennington 等人 (2014) 坚持认为 LCW 方法没有充分利用词语与词语的共现,他们称其为“所有无监督学习词语表征的方法可用的主要信息来源” (p. 1533);然而,与 LCW 表征相比,使用现有 GMF 方法生成的表征在类比完成任务上表现不佳。

为了表明 word2vec 表示所展现的规律性并非 LCW 方法所特有,Pennington 等人 (2014) 构建了一个简单的共现概率矩阵,以表明可以直接从此类数据中提取语义信息。接下来,他们继续使用这个示例矩阵,讨论了共现概率比率的力量。如前所述,与原始共现概率相比,比率可以区分与探测词相关的单词和不相关的单词,重要的是,当以这种方式定义时,比率反映了类比任务的目标。换句话说,与原始概率不同,原始概率反映了 Mikolov 等人 (2013a) 批评的基本单词相似性任务,共现概率比率显示单词A和B是否以相同的方式与单词C相似。最后,他们根据从更丰富的语料库计算出的共现率训练全局对数双线性回归模型,评估类比完成任务中得到的表征,并取得最佳性能。因此,通过将类比完成评估方案强加的类比结构作为数据预处理步骤,Pennington 等人 (2014) 表明 GMF 方法在类比完成任务中的表现优于 LCW 方法。

总而言之,虽然 word2vec 被提议作为一种有效的神经语言建模预训练方法,但它训练的表示很快就被改编用于文本分析,因为它们定义的语义空间具有有趣的特性。此外,GloVe 在围绕 word2vec 的不断增长的工作中被定位为一项改进,它更好地利用了共现统计,支持类比在文本分析中建立意义维度的价值。这样,尽管这些方法的预期目的不同,但它们也标志着解锁概念的经验测量的关键发展。

感谢关注雲闪世界。(亚马逊aws和谷歌GCP服务协助解决云计算及产业相关解决方案)

订阅频道(https://t.me/awsgoogvps_Host)

TG交流群(t.me/awsgoogvpsHost)