Python 爬虫入门(五):使用 lxml 解析网页

- 前言

- 1. lxml 简介

- 1.1 什么是 lxml?

- 1.2 为什么选择 lxml?

- 1.3 安装 lxml

- 2. lxml 基础

- 2.1 解析 HTML/XML

- 2.2 XPath 表达式

- 2.3 使用 XPath 提取数据

- 3. 深入解析

- 3.1 处理命名空间

- 3.2 处理属性

- 3.3 处理文本和尾随文本

- 4. 性能优化

- 4.1 使用 iterparse 解析大型文件

- 4.2 避免 XPath 性能陷阱

- 5. 实战演练

- 5.1 项目概述

- 5.2 项目步骤

- 5.3 示例代码

- 总结

前言

欢迎来到“Python 爬虫入门”系列的第五篇文章。今天我们将深入了解HTML/XML解析库——lxml,教你如何使用它来解析网页。

1. lxml 简介

1.1 什么是 lxml?

lxml 是一个Python库,提供了对HTML和XML文件的高效处理能力。

它支持XPath和XSLT,使得在大量数据中查找和提取信息变得非常简单。

1.2 为什么选择 lxml?

- 速度快:lxml 使用C语言编写,因此解析速度非常快。

- 功能强大:支持XPath和XSLT,可以轻松处理复杂的查询。

- 易于使用:API设计简洁,易于学习和使用。

1.3 安装 lxml

使用 pip 安装 lxml:

pip install lxml

2. lxml 基础

2.1 解析 HTML/XML

使用 lxml 解析HTML/XML文件非常简单。

从 lxml 库中导入 etree 模块:

from lxml import etree

使用 etree 解析HTML/XML字符串或文件:

# 解析字符串

html = """

<!DOCTYPE html>

<html>

<head>

<!-- 这里可以添加头部信息,比如CSS链接、JavaScript文件链接等 -->

</head>

<body>

<h1>Hello, World!</h1>

<!-- 这里可以添加更多的HTML内容 -->

</body>

</html>

"""

root = etree.HTML(html)

# 解析文件

tree = etree.parse('demo.html')

root = tree.getroot()

2.2 XPath 表达式

XPath 是一种在XML文档中查找信息的语言。

lxml 利用XPath提供了强大的查询功能。

- 节点轴:如 child::, parent::, descendant:: 等。

- 节点测试:如 *(任意元素节点), text()(文本节点)等。

- 谓语表达式:如 [position()=1](第一个节点), [@attr=‘value’](具有特定属性的节点)等。

2.3 使用 XPath 提取数据

3. 深入解析

3.1 处理命名空间

在解析带有命名空间的XML时,你需要在XPath表达式中声明命名空间。

3.2 处理属性

使用 @ 符号可以轻松获取元素的属性。

3.3 处理文本和尾随文本

在解析元素时,除了获取其子元素外,还可以获取其文本和尾随文本。

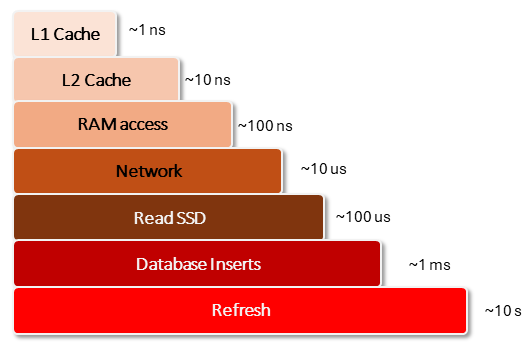

4. 性能优化

4.1 使用 iterparse 解析大型文件

当处理大型XML文件时,使用 iterparse 可以节省内存。

for _, element in etree.iterparse('large_file.xml', events=('end',)):

if element.tag == 'target_element':

process(element)

element.clear()

4.2 避免 XPath 性能陷阱

编写高效的XPath表达式可以显著提高解析速度。

- 避免使用通配符 *,因为它会匹配所有元素。

- 使用谓语表达式限制搜索范围。

5. 实战演练

5.1 项目概述

假设我们使用 lxml 解析一个新闻网站,提取新闻标题和链接。

5.2 项目步骤

- 发送 HTTP 请求获取网页内容。

- 使用 lxml 解析网页。

- 使用 XPath 提取新闻标题和链接。

- 将结果保存到文件。

5.3 示例代码

import requests

from lxml import etree

# 发送请求

response = requests.get('http://xxx.com/news')

root = etree.HTML(response.content)

# 提取新闻标题和链接

news = root.xpath('//div[@class="news-list"]//a')

for item in news:

title = item.xpath('text()')[0]

link = item.get('href')

print(f'Title: {title}, Link: {link}')

# 保存结果到文件

with open('news.txt', 'w') as f:

for item in news:

title = item.xpath('text()')[0]

link = item.get('href')

f.write(f'{title}, {link}\n')

总结

通过本文的学习,相信你已经掌握了 lxml 的基本使用方法,包括如何解析HTML/XML文件、使用XPath表达式提取数据、处理命名空间和属性、以及性能优化技巧。

如果你觉得本文对你有帮助,请不吝点赞和分享。