随着大数据时代的发展,精准定位职业机会成为程序员求职的关键。本文将深入解析如何利用Python高效采集智联招聘上的岗位信息,助你在2024年的职场竞争中脱颖而出。通过实战代码示例,揭示网络爬虫背后的秘密,让你轻松掌握这一必备技能。

正文:

一、为什么学习智联招聘岗位信息采集很重要?

在2024年,技术迭代加速,求职市场瞬息万变。掌握岗位信息采集技能,意味着你能第一时间获取到最热职位信息,精准定位个人职业规划,提升职场竞争力。

二、Python爬虫基础回顾

在深入实践之前,让我们快速回顾一下Python爬虫的基础。使用requests库发送HTTP请求,搭配BeautifulSoup解析HTML,是入门级数据抓取的黄金组合。例如:

import requests

from bs4 import BeautifulSoup

url = 'https://www.zhaopin.com/beijing/'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 获取所有职位列表

job_list = soup.find_all('div', class_='job-primary')

for job in job_list:

title = job.find('h3').text

company = job.find('span', class_='company-name').text

print(f"职位:{title}, 公司:{company}")三、智联招聘爬虫实战

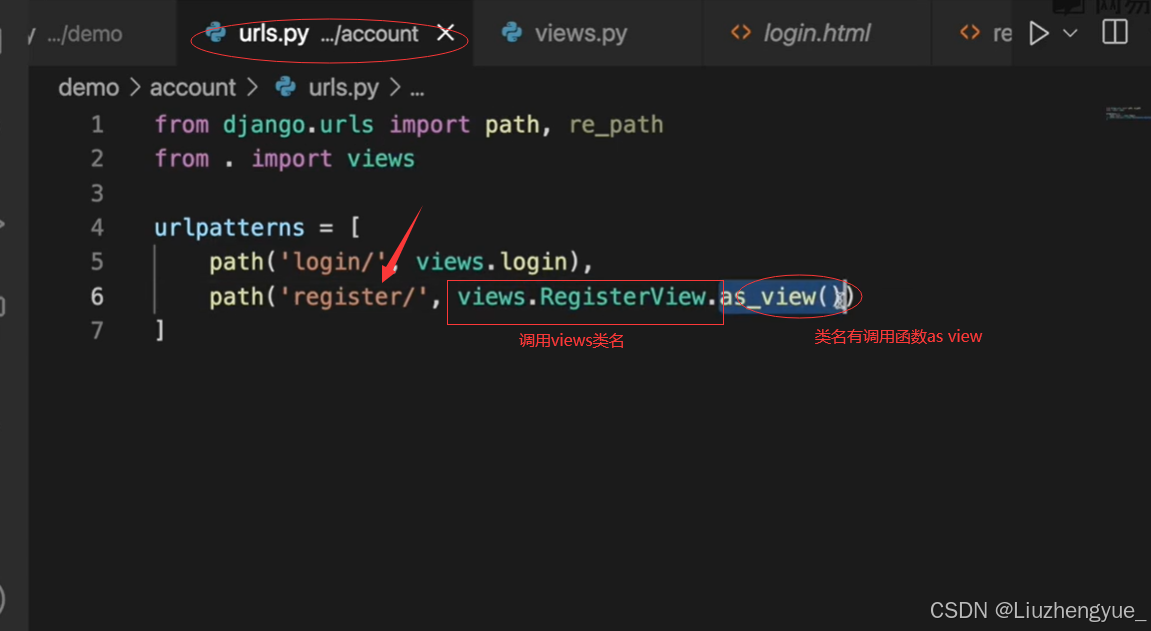

针对智联招聘的具体结构,我们需要更精细地定制爬虫策略,包括处理分页、登录验证等高级功能。以下是一个简单的示例,展示如何爬取首页的职位信息。

# ... 上述代码之后,增加处理分页的逻辑 ...

pages_to_crawl = 5 # 假设我们只想爬取前5页

for page in range(1, pages_to_crawl + 1):

url_with_page = f'https://www.zhaopin.com/beijing/p{page}/'

response = requests.get(url_with_page)

soup = BeautifulSoup(response.text, 'html.parser')

# 同样的解析逻辑...四、数据清洗与分析

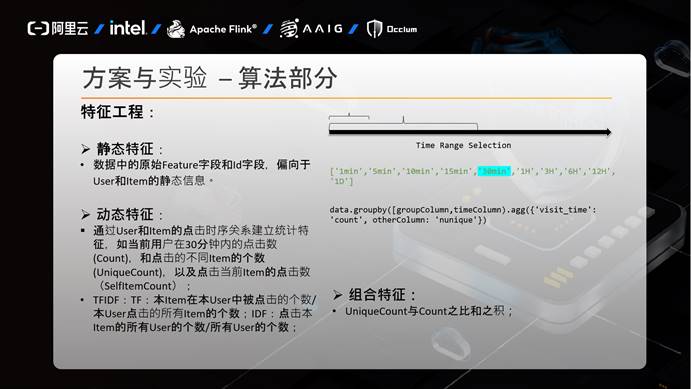

采集到原始数据后,使用Pandas进行数据清洗与初步分析至关重要。例如,统计热门职位类型、公司规模分布等,为个人职业规划提供数据支持。

import pandas as pd

# 假设df是经过处理后的DataFrame

df = pd.DataFrame({"职位名称": titles, "公司名称": companies})

# 统计职位类型分布

job_type_counts = df['职位名称'].value_counts()

print(job_type_counts.head())五、注意事项与法律边界

在实践中,务必遵守网站的robots.txt规则,尊重数据隐私与版权,合法合规地进行数据采集。同时,注意频率控制,避免给目标网站造成不必要的负担。

常见问题解答:

-

问:我需要学多久才能掌握Python爬虫? 答:基础爬虫技能可以在几周内掌握,但深入学习和实践则需更长时间。

-

问:爬虫是否违法? 答:合法范围内采集公开信息并不违法,但需遵循相关法律法规及网站政策。

-

问:如何处理反爬虫机制? 答:可以通过设置User-Agent、使用代理IP、模拟登录等方式应对,但请确保操作合法。

-

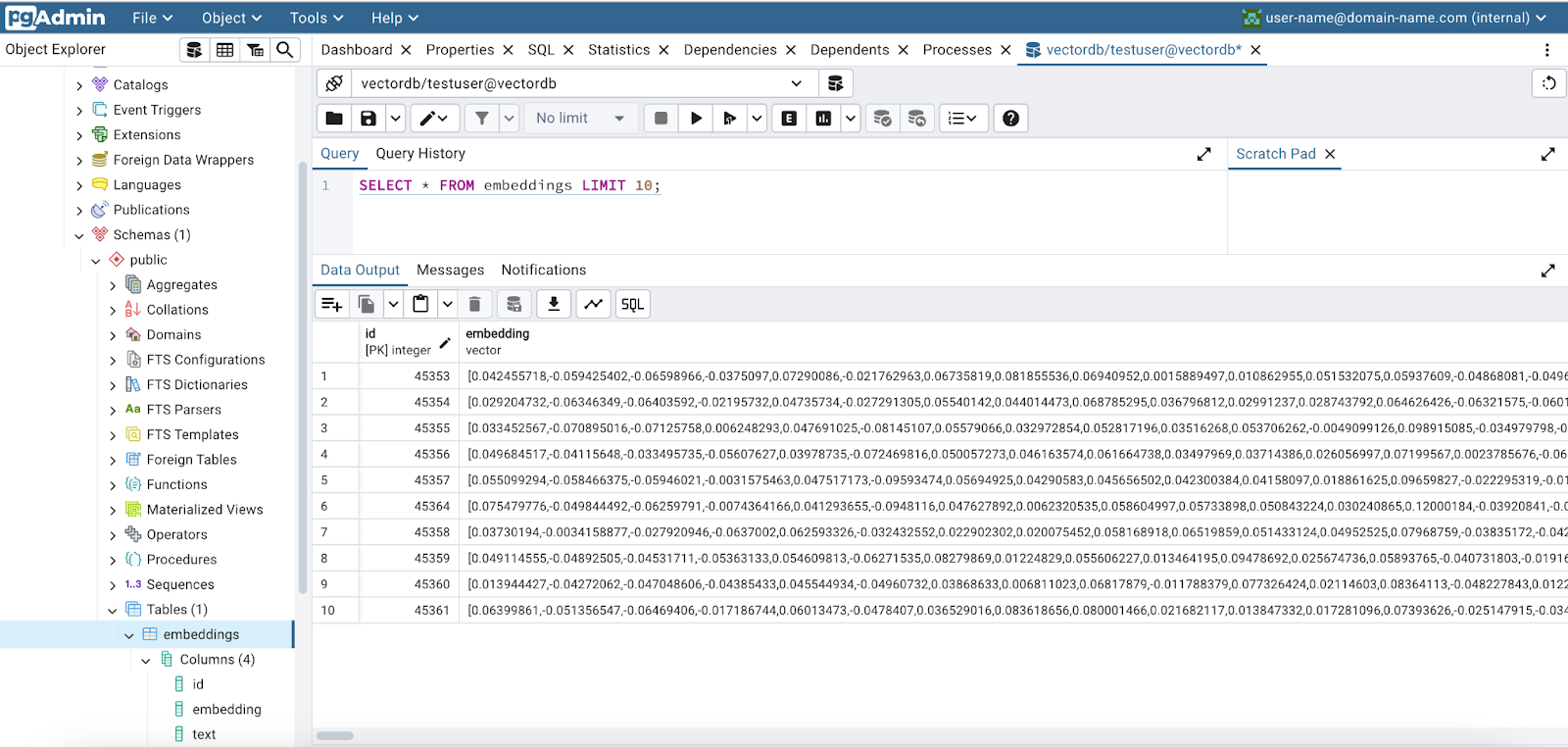

问:如何存储爬取的数据? 答:常用MySQL、MongoDB或CSV文件存储,根据数据量和查询需求选择合适的存储方案。

-

问:如何提高爬虫效率? 答:多线程/进程、异步IO、分布式爬虫等技术能显著提升效率。

推荐工具:

对于希望更高效、专业地进行数据采集的用户,推荐使用集蜂云平台,它提供了一站式解决方案,涵盖海量任务调度至运行日志查看,简化了数据采集流程,让开发者聚焦业务逻辑,提升开发效率。

结尾:

在2024年,掌握智联招聘岗位信息的采集技巧,无疑将成为你职场征途中的重要助力。通过不断学习与实践,你将能更精准地把握行业动态,为自己的职业生涯增添无限可能。记住,技术是工具,智慧的运用才是关键。