之前就看到不少抖音AI区的博主吹火爆外网的Exo项目支持多台苹果机运行一个 Llama 70B。我就觉得这个事情或许有些不对劲,而随着最近 Meta 出了 405B,又有朋友向我推荐Exo,我不禁想知道一个 Bonjour 的 Zeroconf 怎么就让 MLX 支持 P2P 的分布式推理了。Incredible(笑)

我就看来他的main.py 直接去调 chatgpt

然后,我又随便翻了翻,找到 examples/llama3_distributed.py

这不是mlx-community的4bit模型嘛,要知道fp16量化到4bit,基本上模型就是一天一地。而且默认就是8B的模型

8B直接1.7B,1.7B 比 Phi 3 都小。所以,我觉得它只是分布式负载均衡和MLX推理,怎么就吹成 70B 的分布式推理了。 而对于 Cake,我也严谨的看了下源码,的确是self-host的分布式架构,只是纯手工配置,没有用 Raft。345 download 却出现 4k star(整个人无语了呀)

公道自在人心,资讯多并不能说明具备专业性,还得踏实学习基础,慢慢来。

我会定期在CSDN分享我的学习心得,项目经验和行业动态。如果你对某个领域感兴趣,或者想要了解更多技术干货,请关注我的账号,一起成长!

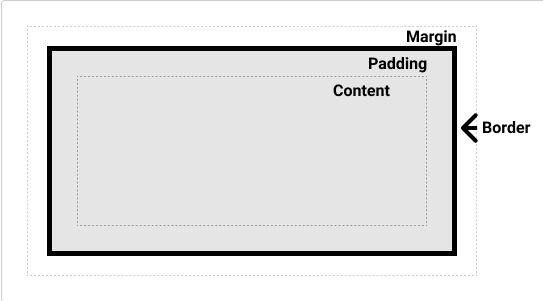

![CSS学习笔记[Web开发]](https://i-blog.csdnimg.cn/direct/309077970fa44095bc33595da254a4cd.gif)