Hi,大家好,我是半亩花海。接着上次的最速下降法(梯度下降法)继续更新《白话机器学习的数学》这本书的学习笔记,在此分享多项式回归这一回归算法原理。本章的回归算法原理基于《基于广告费预测点击量》项目,欢迎大家交流学习!

目录

一、多项式回归概述

二、案例分析

1. 设置问题

2. 定义模型

3. 多项式回归

一、多项式回归概述

多项式回归是一种基于多项式函数的回归分析方法,用于拟合数据中的非线性关系。与简单的线性回归不同,多项式回归通过引入多项式项来建模数据的非线性特征,从而提高了模型的灵活性和适用性。

二、案例分析

1. 设置问题

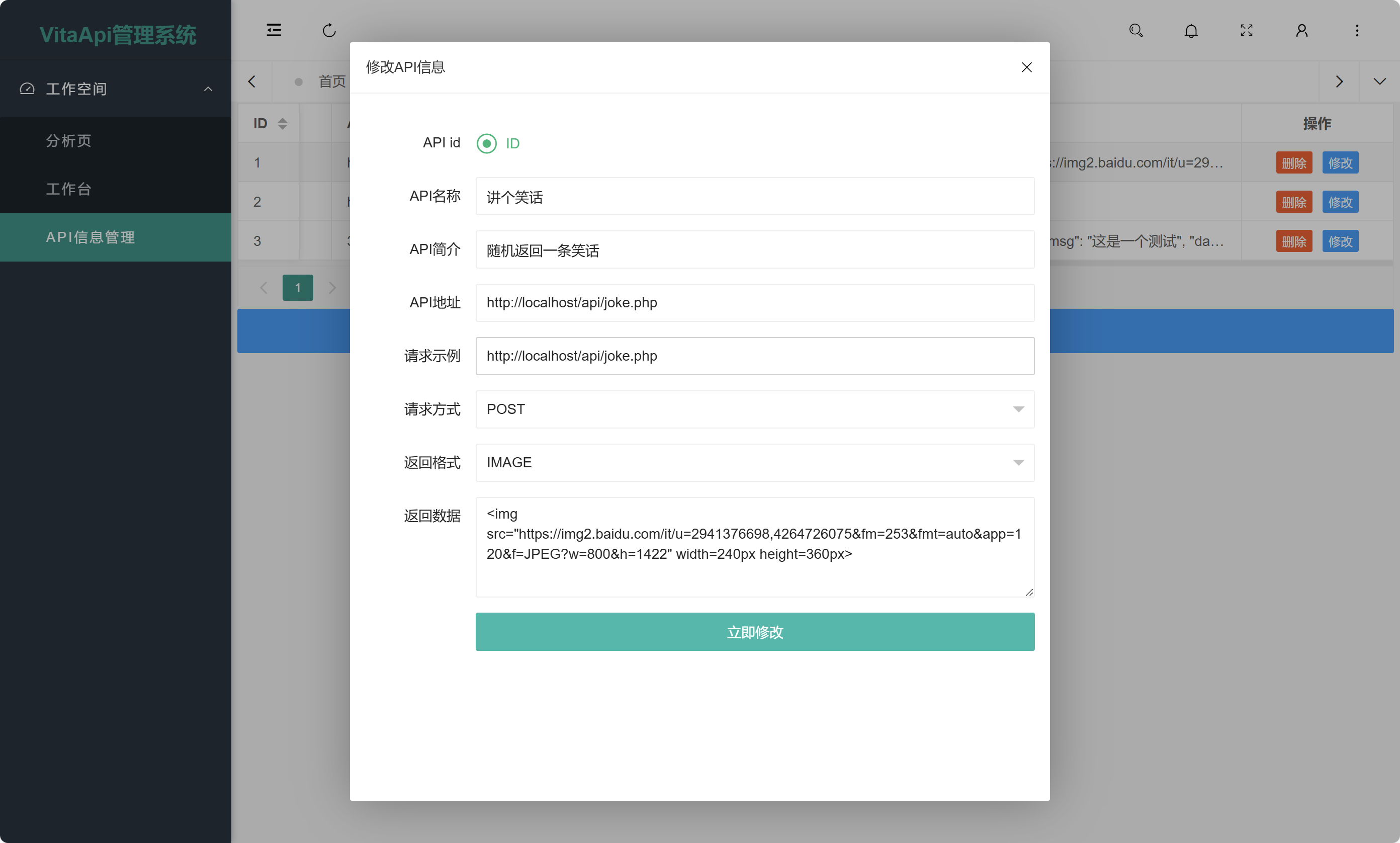

还记得前两节我们定义的用于预测的一次函数吗?

因为是一次函数,所以它的图像是直线。

不过,对于一开始我在图中添加的数据点来说,直线一定是最好的拟合方式吗?曲线拟合的效果会更好吗?

2. 定义模型

通过清晰直观地观察下图,并经过探索我们会发现,其实曲线相对来说会比直线拟合得更好。

如此看来,曲线似乎看起来更拟合数据。在此,我们可以把 定义为二次函数,便能用它来表示这条曲线,如下所示:

再或者,用更大次数的表达式也可以。这样就能表示更复杂的曲线了,如下所示:

在找出最合适的表达式之前,需要不断地去尝试。当然这里有个误区,并不是说函数次数越大,拟合得就越好,难免也会出现过拟合的问题(在深度学习中会接触到)。

3. 多项式回归

回到我们定义的二次函数中,我们增加了 这个参数,接下来得需要推导出

更新表达式,和上一节“最速下降法”里面的原理一样,用目标函数对

进行偏微分便就能求出来。

设 、

,再将

对

偏微分,求出更新表达式。

对

微分即

的部分应该和前一节里的求法是一样的,如下式。

所以我们只要求 对

的微分即可,如下式。

得出最终的参数更新表达式如下所示:

那么即使增加参数,比如有 、

等,我们依然可以用同样的的方法求出它们的更新表达式。像这样增加函数中多项式的次数,然后再使用函数的分析方法(偏微分)被称为多项式回归。

![[k8s源码]9.workqueue](https://i-blog.csdnimg.cn/direct/709510ef534647f6bb8b4fcd1324e720.png)

![BUUCTF [MRCTF2020]Ezpop](https://i-blog.csdnimg.cn/direct/0371319440d7436e8706d1d68c27c0f0.png)