目录

- 1. 什么是数据编织?

- 2. 数据编织的工作原理

- 3. 代码示例

- 4. 数据编织的优势

- 5. 应用场景

- 6. 数据编织 vs 数据仓库

- 6.1 数据存储方式

- 6.2 数据更新和实时性

- 6.3 灵活性和可扩展性

- 6.4 查询性能

- 6.5 数据治理和一致性

- 6.6 适用场景

- 6.7 代码示例比较

- 7. 数据编织 vs 数据湖

- 7.1 数据存储和结构

- 7.2 数据处理方式

- 7.3 数据治理和质量控制

- 7.4 查询和分析能力

- 7.5 使用场景

- 7.6 代码示例比较

- 7.7 总结

- 总结

1. 什么是数据编织?

数据编织(Data Weaving)是一种高级数据集成技术,旨在将来自不同源头、格式各异的数据进行无缝整合,以创建一个统一的、可查询的数据视图。这种方法不同于传统的ETL(提取、转换、加载)过程,它更加灵活、动态,能够在不破坏原始数据结构的情况下创建数据之间的关联。

数据编织的核心理念是:

- 保留原始数据的完整性

- 创建数据之间的逻辑链接

- 提供实时的数据整合视图

- 支持跨源数据的复杂查询

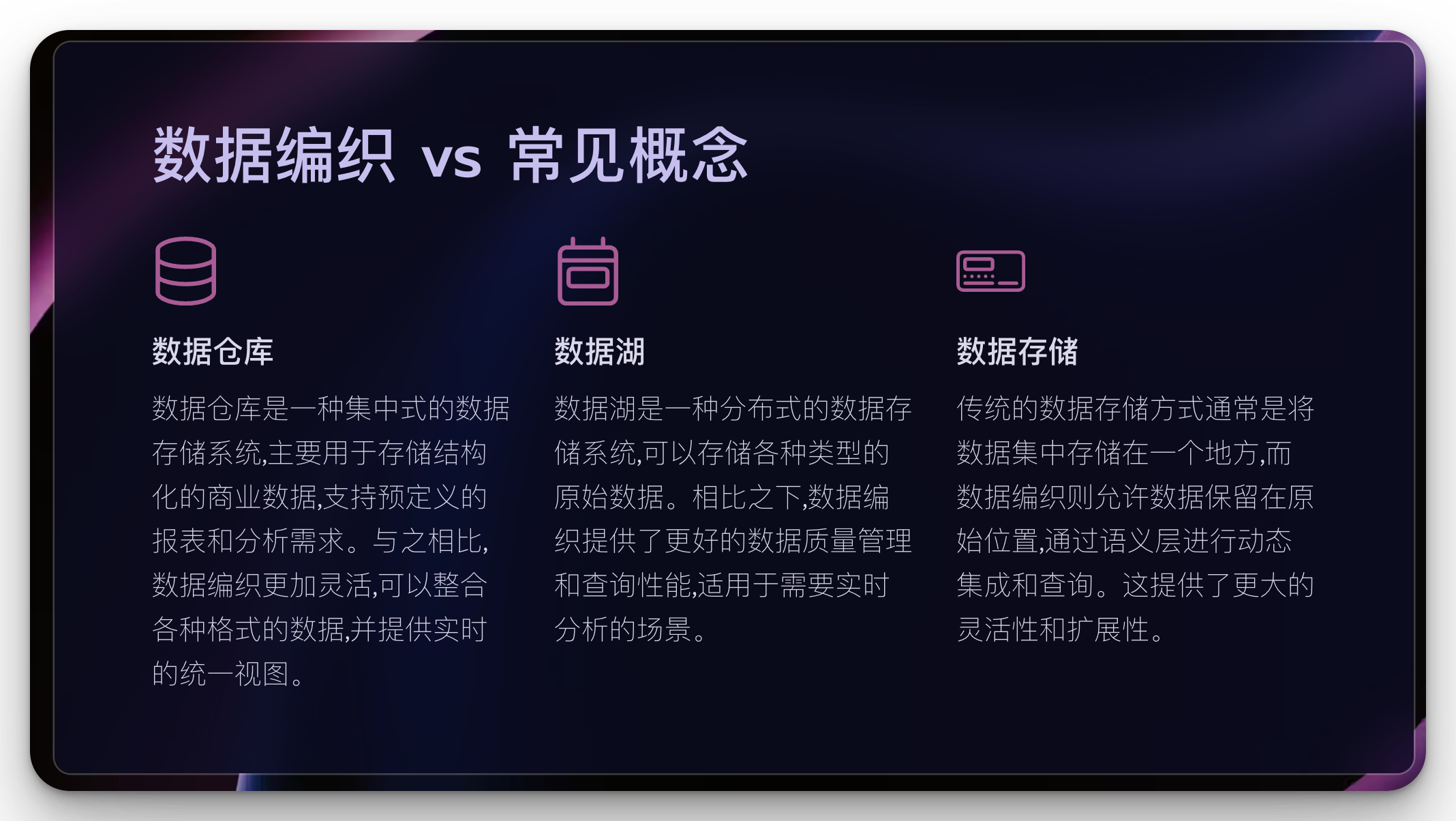

对比一下常见的概念

| 特征 | 数据编织 | 数据仓库 | 数据湖 |

|---|---|---|---|

| 数据存储 | 虚拟集成,数据保留在原始位置 | 集中式存储,结构化数据 | 分布式存储,支持所有类型数据 |

| 数据结构 | 通过语义层定义 | 预定义的模式(如星型、雪花) | 灵活,支持结构化、半结构化、非结构化 |

| 数据处理 | 实时查询转换 | ETL(提取、转换、加载) | ELT(提取、加载、转换) |

| 更新频率 | 实时/近实时 | 定期批量更新 | 可以实时或批量 |

| 数据量 | 中等到大 | 大 | 极大 |

| 数据质量 | 依赖源系统,通过语义层提升 | 高,经过清洗和转换 | 原始数据,质量参差不齐 |

| 查询性能 | 对于跨源查询较快 | 对预定义查询很快 | 可能较慢,需要优化 |

| 灵活性 | 非常高 | 相对固定 | 高 |

| 用户群 | 业务分析师,数据科学家 | 业务用户,分析师 | 数据科学家,高级分析师 |

| 主要用途 | 实时数据集成,跨系统分析 | 报表,商业智能 | 大数据分析,机器学习 |

| 数据治理 | 通过元数据和语义映射 | 集中化管理,易于实施 | 挑战大,需要额外工具 |

| 成本 | 中等 | 高 | 相对较低 |

| 实现复杂度 | 中等 | 高 | 低到中等 |

| 扩展性 | 高 | 受限于中央系统 | 非常高 |

| 历史数据处理 | 取决于源系统 | 优秀 | 优秀 |

| 数据探索 | 受限于预定义的语义层 | 受限于预定义的模式 | 非常适合 |

| 适用场景 | 需要实时、统一数据视图的企业 | 需要稳定、一致报告的企业 | 需要存储和分析大量多样化数据的组织 |

|

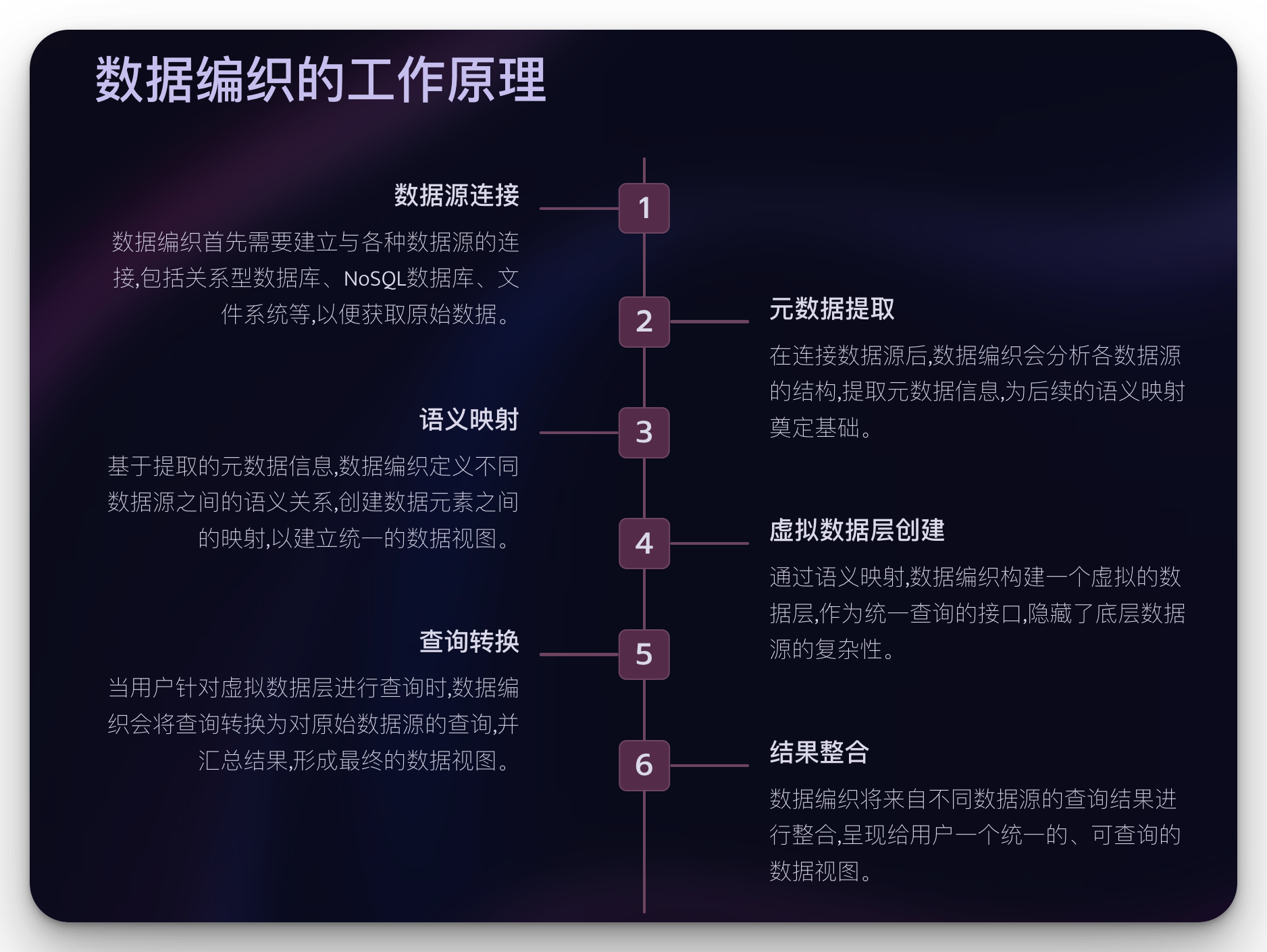

2. 数据编织的工作原理

数据编织通过以下步骤实现:

-

数据源连接: 建立与各种数据源的连接,包括关系型数据库、NoSQL数据库、文件系统等。

-

元数据提取: 分析各数据源的结构,提取元数据信息。

-

语义映射: 定义不同数据源之间的语义关系,创建数据元素之间的映射。

-

虚拟数据层创建: 基于语义映射构建一个虚拟的数据层,作为统一查询的接口。

-

查询转换: 将针对虚拟数据层的查询转换为对原始数据源的查询。

-

结果整合: 汇总来自不同数据源的查询结果,形成最终的数据视图。

3. 代码示例

下面是一个使用Python实现简单数据编织的示例代码:

import pandas as pd

from sqlalchemy import create_engine

class DataWeaver:

def __init__(self):

self.data_sources = {}

self.virtual_view = None

def add_data_source(self, name, connection_string):

engine = create_engine(connection_string)

self.data_sources[name] = engine

def create_virtual_view(self, mapping):

self.virtual_view = mapping

def query(self, query_string):

results = {}

for source, fields in self.virtual_view.items():

if source in self.data_sources:

engine = self.data_sources[source]

sql = f"SELECT {', '.join(fields)} FROM {source}"

results[source] = pd.read_sql(sql, engine)

return pd.concat(results.values(), axis=1)

# 使用示例

weaver = DataWeaver()

# 添加数据源

weaver.add_data_source('customers', 'sqlite:///customers.db')

weaver.add_data_source('orders', 'sqlite:///orders.db')

# 创建虚拟视图

weaver.create_virtual_view({

'customers': ['id', 'name', 'email'],

'orders': ['customer_id', 'order_date', 'total_amount']

})

# 执行查询

result = weaver.query("SELECT * FROM virtual_view")

print(result)

这个简化的例子展示了数据编织的基本概念。在实际应用中,数据编织系统会更加复杂,需要处理更多的数据源类型、更复杂的查询转换和更高效的数据整合策略。

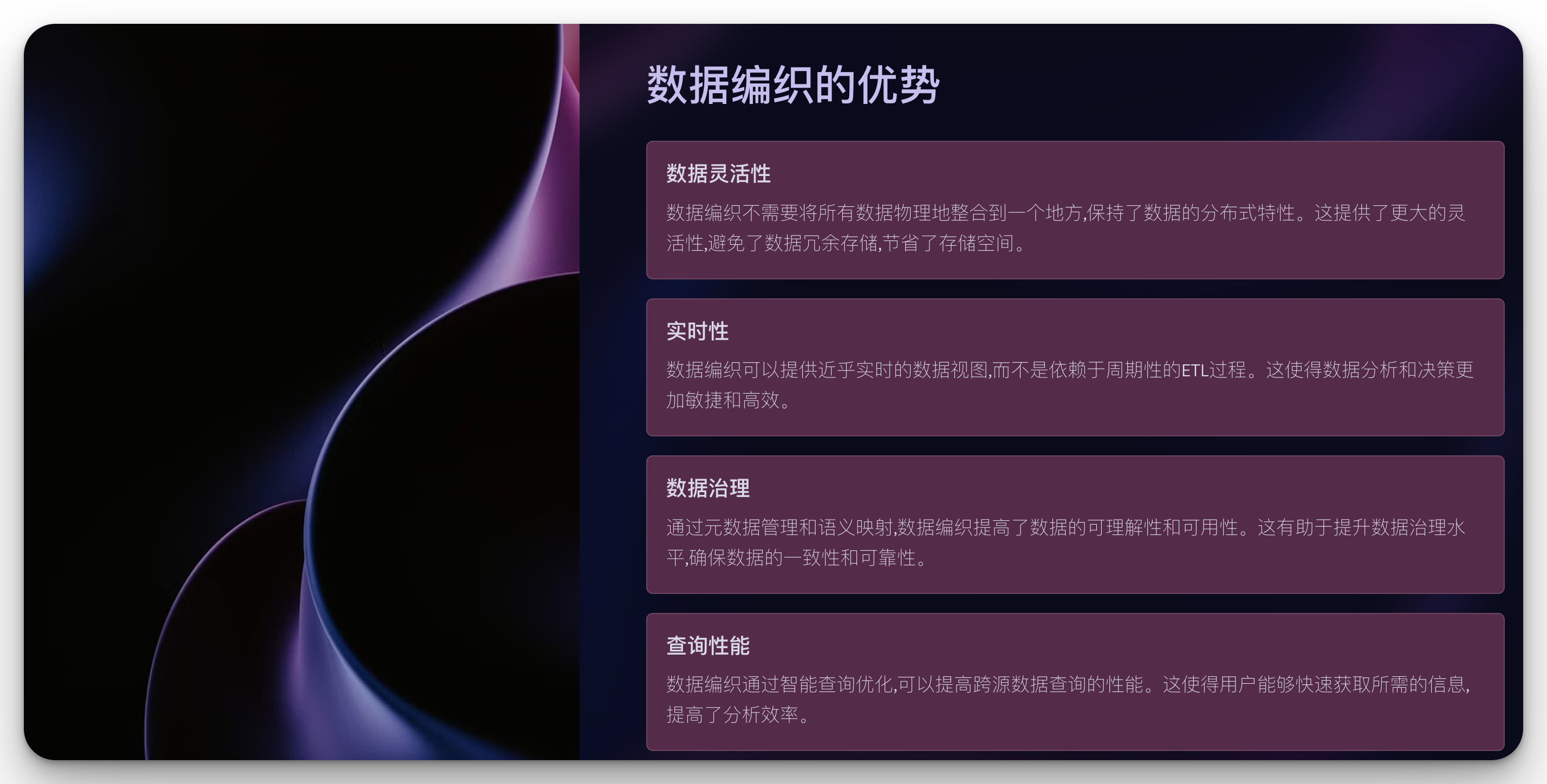

4. 数据编织的优势

-

数据灵活性: 不需要将所有数据物理地整合到一个地方,保持了数据的分布式特性。

-

实时性: 可以提供近乎实时的数据视图,而不是依赖于周期性的ETL过程。

-

降低存储成本: 避免了数据冗余存储,节省了存储空间。

-

数据治理: 通过元数据管理和语义映射,提高了数据的可理解性和可用性。

-

查询性能: 通过智能查询优化,可以提高跨源数据查询的性能。

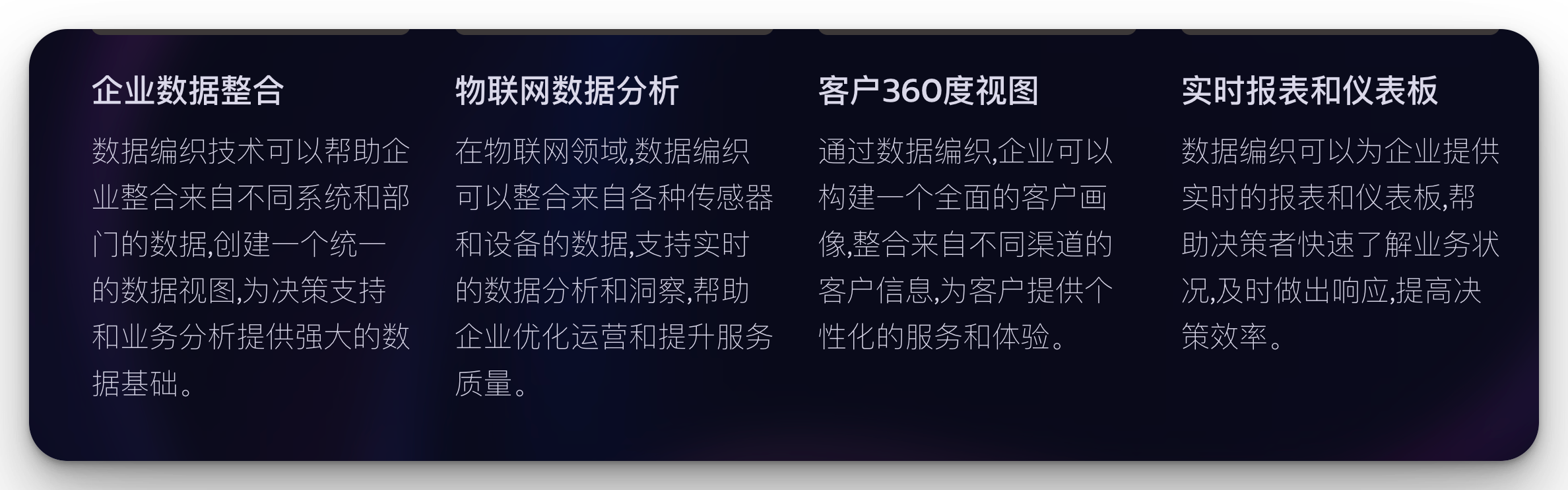

5. 应用场景

数据编织技术在多个领域都有广泛应用,例如:

- 企业数据整合

- 物联网数据分析

- 客户360度视图

- 实时报表和仪表板

- 大数据湖和数据仓库的结合

6. 数据编织 vs 数据仓库

虽然数据编织和数据仓库都旨在整合和管理数据,但它们在方法和应用上有显著差异。让我们来详细比较一下:

6.1 数据存储方式

-

数据仓库:

- 采用集中式存储模型

- 将数据从各源系统提取、转换后存入一个集中的仓库

- 通常使用结构化的模式,如星型或雪花模式

-

数据编织:

- 采用分布式的虚拟集成模型

- 数据保留在原始源系统中

- 创建一个虚拟层来整合和呈现数据,无需物理移动

6.2 数据更新和实时性

-

数据仓库:

- 通常采用批量更新模式

- 数据更新有一定的延迟,通常是每日或每周

- 适合历史数据分析和趋势报告

-

数据编织:

- 支持实时或近实时的数据访问

- 直接从源系统获取最新数据

- 适合需要最新数据的实时分析和决策支持

6.3 灵活性和可扩展性

-

数据仓库:

- 架构相对固定,修改模式需要较大工作量

- 扩展性受限于中央存储系统的容量

- 添加新数据源可能需要重新设计ETL流程

-

数据编织:

- 高度灵活,可以轻松添加或修改数据源

- 扩展性强,可以无缝集成新的数据系统

- 适应性强,能快速响应业务需求变化

6.4 查询性能

-

数据仓库:

- 对预定义的查询和报表性能优秀

- 可以通过预聚合和索引优化提高性能

- 复杂查询可能需要大量计算资源

-

数据编织:

- 复杂查询性能可能不如优化过的数据仓库

- 但对于跨源的即时查询有优势

- 通过智能查询优化和缓存策略可以提高性能

6.5 数据治理和一致性

-

数据仓库:

- 提供一个"单一事实来源"

- 数据一致性高,易于实施数据治理

- 适合需要严格数据质量控制的场景

-

数据编织:

- 保留原始数据的完整性

- 通过元数据管理和语义映射实现数据治理

- 需要更复杂的机制来确保跨源数据的一致性

6.6 适用场景

-

数据仓库:

- 适合大规模的历史数据分析

- 企业级报表和商业智能应用

- 需要高度结构化和一致性的数据环境

-

数据编织:

- 适合需要实时数据整合的场景

- 动态的、跨系统的数据分析

- 快速变化的业务环境,需要灵活数据访问

6.7 代码示例比较

为了更直观地展示两种方法的区别,让我们看一下简化的代码示例:

数据仓库ETL过程:

import pandas as pd

from sqlalchemy import create_engine

# 连接源数据库和数据仓库

source_engine = create_engine('sqlite:///source.db')

warehouse_engine = create_engine('sqlite:///warehouse.db')

# 提取数据

df = pd.read_sql("SELECT * FROM source_table", source_engine)

# 转换数据

df['new_column'] = df['column_a'] + df['column_b']

# 加载到数据仓库

df.to_sql('warehouse_table', warehouse_engine, if_exists='replace')

数据编织过程:

import pandas as pd

from sqlalchemy import create_engine

class DataWeaver:

def __init__(self):

self.sources = {}

def add_source(self, name, connection_string):

self.sources[name] = create_engine(connection_string)

def query(self, virtual_query):

results = {}

for source, query in virtual_query.items():

results[source] = pd.read_sql(query, self.sources[source])

return pd.concat(results.values(), axis=1)

# 使用示例

weaver = DataWeaver()

weaver.add_source('source1', 'sqlite:///source1.db')

weaver.add_source('source2', 'sqlite:///source2.db')

result = weaver.query({

'source1': "SELECT column_a, column_b FROM table1",

'source2': "SELECT column_c FROM table2"

})

这些示例清楚地展示了两种方法在数据处理上的根本区别。

数据仓库方法涉及数据的提取、转换和加载,而数据编织方法则是通过虚拟查询直接访问源数据。

总的来说,数据编织和数据仓库各有其优势和适用场景。数据编织为现代数据集成提供了更灵活、实时的解决方案,特别适合快速变化的业务环境。而数据仓库则在处理大规模历史数据分析和提供一致的企业级报告方面仍然占据重要地位。在实际应用中,许多组织选择结合这两种方法,以充分利用它们的优势。

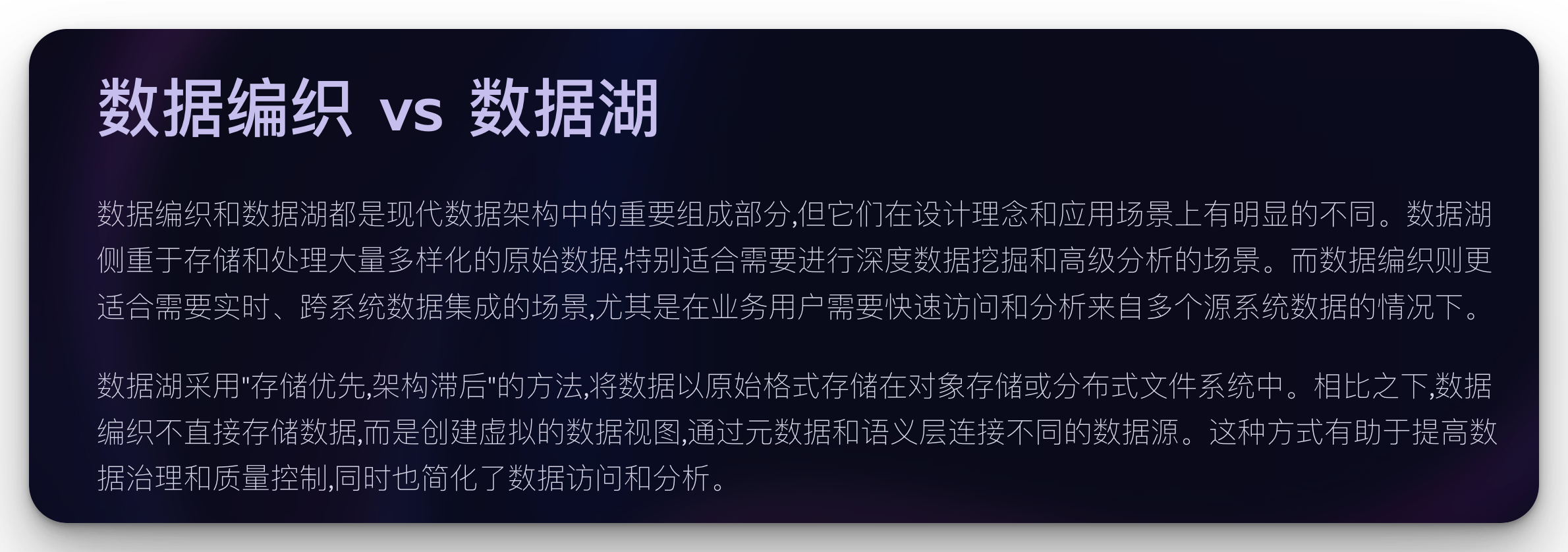

7. 数据编织 vs 数据湖

数据编织和数据湖都是现代数据架构中的重要组成部分,但它们在设计理念和应用场景上有明显的不同。让我们来比较一下:

7.1 数据存储和结构

-

数据湖:

- 存储大量原始数据,包括结构化、半结构化和非结构化数据

- 数据以原始格式存储,通常使用对象存储或分布式文件系统

- “存储优先,架构滞后”(Schema-on-read)的方法

-

数据编织:

- 不直接存储数据,而是创建虚拟的数据视图

- 通过元数据和语义层连接不同的数据源

- 保持数据在原始位置,创建逻辑关联

7.2 数据处理方式

-

数据湖:

- 支持批处理和流处理

- 通常需要数据科学家或数据工程师来处理和分析数据

- 适合大规模数据探索和高级分析

-

数据编织:

- 主要关注实时数据集成和查询

- 通过预定义的语义映射简化数据访问

- 适合业务用户进行即时数据分析和报告

7.3 数据治理和质量控制

-

数据湖:

- 数据治理是一个挑战,容易变成"数据沼泽"

- 需要额外的工具和流程来确保数据质量和可追溯性

- 适合存储大量原始数据,但可能导致数据冗余

-

数据编织:

- 通过元数据管理和语义映射提供更好的数据治理

- 保持数据在原始源中,减少数据冗余

- 更容易实现数据血缘和影响分析

7.4 查询和分析能力

-

数据湖:

- 支持深度分析和机器学习任务

- 查询性能可能较慢,特别是对于未优化的数据

- 适合大规模数据挖掘和复杂分析

-

数据编织:

- 优化用于快速、跨源数据查询

- 提供统一的数据访问层,简化复杂查询

- 适合实时报告和交互式分析

7.5 使用场景

-

数据湖:

- 大数据存储和分析

- 数据科学和机器学习项目

- 长期数据存档和合规性要求

-

数据编织:

- 企业数据集成和实时报告

- 客户360度视图

- 跨系统数据分析和决策支持

7.6 代码示例比较

为了更直观地理解两者的区别,让我们看一下简化的代码示例:

数据湖处理示例(使用PySpark):

from pyspark.sql import SparkSession

# 创建Spark会话

spark = SparkSession.builder.appName("DataLakeProcessing").getOrCreate()

# 从数据湖读取数据

raw_data = spark.read.format("parquet").load("s3://data-lake-bucket/raw-data/")

# 数据处理

processed_data = raw_data.filter(raw_data.column_a > 100)\

.groupBy("column_b")\

.agg({"column_c": "sum"})

# 将结果写回数据湖

processed_data.write.format("parquet").mode("overwrite").save("s3://data-lake-bucket/processed-data/")

数据编织示例:

class DataWeaver:

def __init__(self):

self.sources = {}

self.semantic_layer = {}

def add_source(self, name, connection_string):

self.sources[name] = create_engine(connection_string)

def define_semantic_mapping(self, virtual_table, mapping):

self.semantic_layer[virtual_table] = mapping

def query(self, virtual_query):

# 解析虚拟查询,映射到实际数据源

actual_queries = self.translate_query(virtual_query)

results = {}

for source, query in actual_queries.items():

results[source] = pd.read_sql(query, self.sources[source])

return pd.concat(results.values(), axis=1)

def translate_query(self, virtual_query):

# 这里应该包含复杂的查询转换逻辑

# 简化版本仅作演示

return {source: f"SELECT {', '.join(columns)} FROM {table}"

for source, (table, columns) in self.semantic_layer.items()}

# 使用示例

weaver = DataWeaver()

weaver.add_source('source1', 'postgresql://user:pass@localhost:5432/db1')

weaver.add_source('source2', 'mysql://user:pass@localhost:3306/db2')

weaver.define_semantic_mapping('virtual_customer_view', {

'source1': ('customers', ['id', 'name', 'email']),

'source2': ('orders', ['customer_id', 'order_date', 'total'])

})

result = weaver.query("SELECT * FROM virtual_customer_view")

这些示例展示了数据湖和数据编织在数据处理方式上的根本区别。数据湖侧重于大规模数据的存储和处理,而数据编织侧重于创建虚拟的、统一的数据视图。

7.7 总结

数据湖和数据编织各有其优势和适用场景:

-

数据湖适合存储和分析大量多样化的原始数据,特别是在需要进行深度数据挖掘和高级分析的场景。

-

数据编织则更适合需要实时、跨系统数据集成的场景,尤其是在业务用户需要快速访问和分析来自多个源系统数据的情况下。

在实际应用中,许多组织选择将数据湖和数据编织结合使用,以充分利用两者的优势。例如,可以使用数据湖存储和处理大量原始数据,然后通过数据编织技术为这些数据创建更易于访问和分析的虚拟视图。

这种组合方法可以提供强大的数据存储和处理能力,同时也确保了数据的可访问性和实时性,从而满足各种复杂的业务需求。

总结

数据编织作为一种先进的数据集成方法,为大数据时代的数据管理和分析提供了新的可能。

它不仅提高了数据的可用性和灵活性,还为企业提供了更快速、更全面的数据洞察能力。

随着技术的不断发展,数据编织必将在大数据生态系统中扮演越来越重要的角色。