TextIn文档解析测评工具,全面评测文档解析产品能力

关注TechLead,复旦AI博士,分享AI领域全维度知识与研究。拥有10+年AI领域研究经验、复旦机器人智能实验室成员,国家级大学生赛事评审专家,发表多篇SCI核心期刊学术论文,上亿营收AI产品研发负责人。

今天向大家介绍一款全面展示文档解析产品能力的工具——TextIn文档解析测评工具,https://github.com/intsig/markdown_tester

这个工具的主要作用是帮助需要解析PDF的用户直观地筛选出最适合自己场景的产品。

用户需求的多样性

TextIn团队在与用户的交流中发现,用户的需求非常多样化,包括年报、财报、论文、政策文件、企业内部文件、教科书、试卷和公式等。尽管所有解析产品的目标都是成为“全能选手”,但在当前阶段,各产品能力的差异仍然存在。因此,提供一个能节省用户选择和测试时间的工具是非常必要的,这也是我们推出TextIn文档解析测评工具的初衷。希望这个工具能够帮助用户更好地聚焦于业务场景。

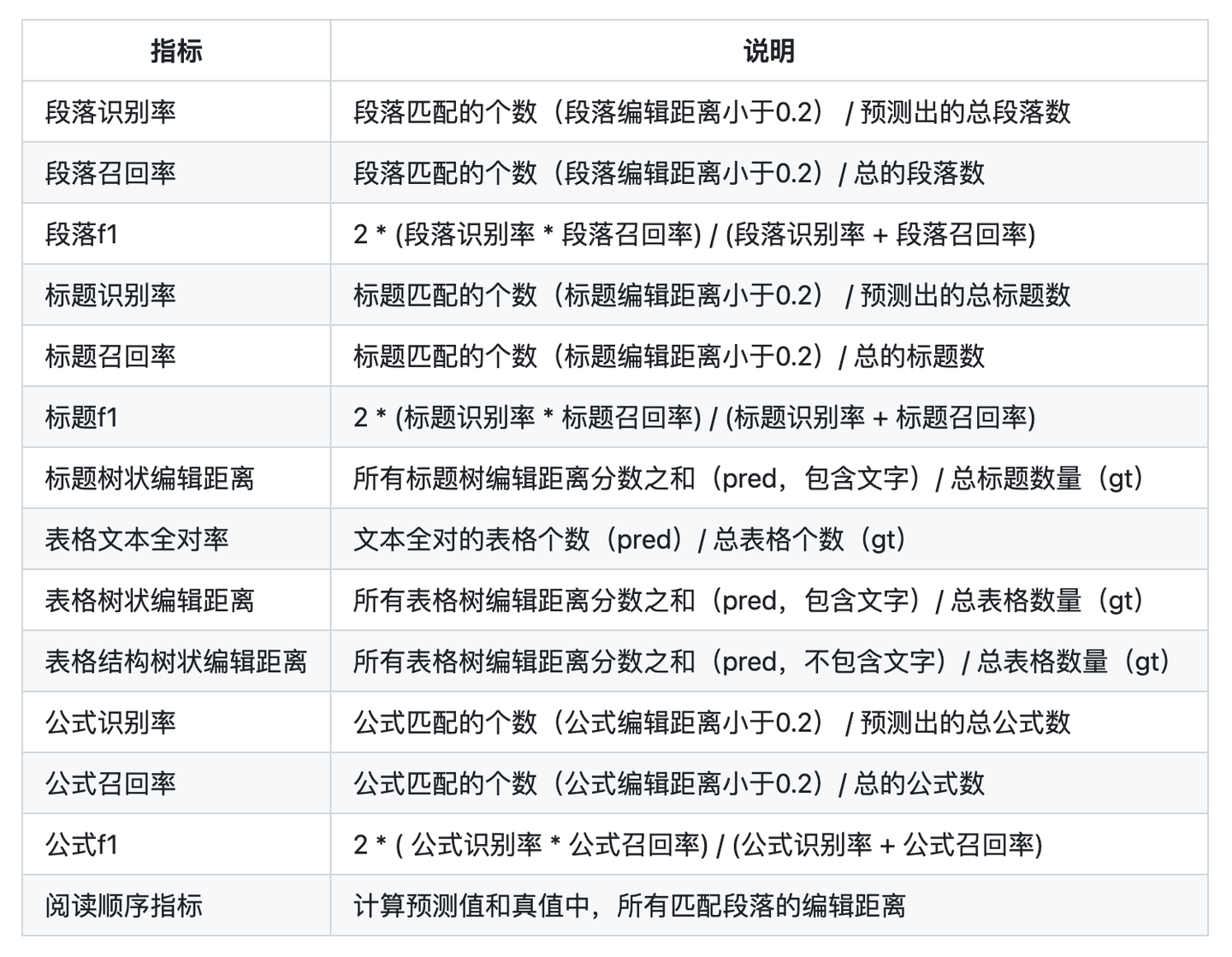

测评指标介绍

TextIn文档解析测评工具将测评指标分为五个维度:表格、段落、标题、阅读顺序和公式。这些维度通过定量测评来展示各解析产品的具体表现。

工具使用方法

测评工具的使用方法非常便捷,支持上传任意样本。以下是具体的操作步骤:

安装软件包

运行以下命令安装必要的软件包:

./install.sh

样本文件组织

将待测评样本按照以下结构放置:

dataset/

├── pred/

│ ├── gpt-4o/

│ ├── vendor_A/

│ ├── vendor_B/

│ ├── ...

├── gt/

运行测评命令

使用以下命令进行测评:

python run_test.py --pred_path path_to_pred_md --gt_path path_to_gt_md

其中:

path_to_pred_md:预测值文件所在文件夹。path_to_gt_md:真值文件所在文件夹。

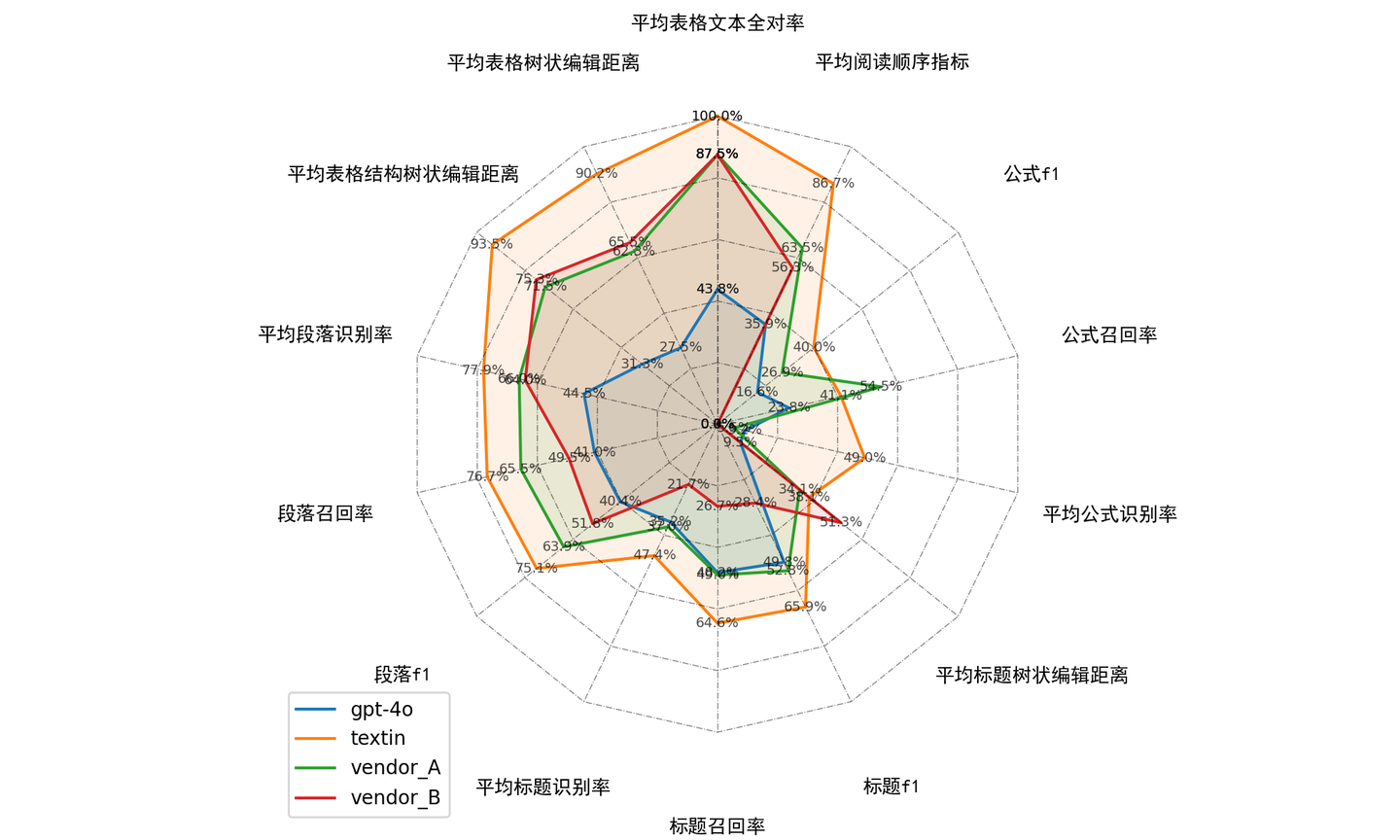

示例与结果展示

TextIn官方提供了一个测试集案例来展示用法。输出结果包括表格数据结果和直观的雷达图。这款工具被称为文档解析效果评估的“瑞士军刀”,无论用户是文档处理的专家,还是有文档解析需求的用户,都能快速、高效地评估各款解析产品在业务场景下的能力。

工具公开的初衷

TextIn团队决定将这款内部使用的“瑞士军刀”公开,主要是因为近期收到越来越多的测评工具需求。在没有测试工具之前,用户评估各款解析产品效果主要依靠问答效果随机测试,并人工二次检索文档,这种方式不仅耗费人力,而且科学性低、准确度低。

在使用TextIn团队分享的测试工具后,客户不再需要“肉眼观测”解析效果。这主要是因为大语言模型的发展改变了需求和产品形态。传统的OCR技术在处理表格时,可能只输出每个单元格的位置和数值。但当用大模型来回答问题时,更需要的是表格中的数据内容,而且数据越清晰,答案的质量就越高。

评估文档解析产品

如何比较不同文档解析产品在业务场景下的表现?TextIn团队公开测评工具的目的就是将这些问题透明化。因此,在设计和优化这套工具的过程中,TextIn团队关注以下要素:

- 确定评测的主要目标和关键指标

- 选择能够准确反映性能的评价指标

- 减少不必要的复杂性

- 确保符合行业标准和最佳实践

- 让评价结果易于解读和理解

- 保持评价过程的透明度

希望TextIn团队的测评工具能够帮助大家解决评估所需产品的难题。

测评工具入口链接