本期为TechBeat人工智能社区第609期线上Talk。

北京时间7月17日(周三)20:00,俄亥俄州立大学博士生—汪博石的Talk已经准时在TechBeat人工智能社区开播!

他与大家分享的主题是: “Transformer模型能否进行隐式的推理?关于Grokking和泛化的深入探索”,在本次Talk中,他系统性地研究Transformer是否可以获得隐式推理的能力。并通过一系列实验和对于模型内部的分析揭示了Grokking对于获得隐式推理能力的重要性,其背后的过程和原因,以及Transformer模型对于不同任务的系统性泛化能力的差异。

Talk·信息

▼

主题: Transformer模型能否进行隐式的推理?关于Grokking和泛化的深入探索

嘉宾:俄亥俄州立大学博士生 汪博石

时间:北京时间 7月17日(周三)20:00

地点:TechBeat人工智能社区

点击下方链接,即可观看视频!

TechBeatTechBeat是荟聚全球华人AI精英的成长社区,每周上新来自顶尖大厂、明星创业公司、国际顶级高校相关专业在读博士的最新研究工作。我们希望为AI人才打造更专业的服务和体验,加速并陪伴其成长。![]() https://www.techbeat.net/talk-info?id=888

https://www.techbeat.net/talk-info?id=888

Talk·介绍

▼

现今的大语言模型虽然能力广而出众,但许多工作发现它们依旧很难基于参数知识做隐式推理。这项缺陷会导致他们内部的知识和规则的表示冗余而难以更新,同时限制它们的泛化能力。在这篇工作中,我们系统性地研究Transformer是否可以获得隐式推理的能力。我们的一系列实验和对于模型内部的分析揭示了Grokking对于获得隐式推理能力的重要性,其背后的过程和原因,以及Transformer模型对于不同任务的系统性泛化能力的差异。

Talk大纲

1. 背景 - Transformer语言模型的隐式推理能力的欠缺

2. 我们为什么要关注隐式推理和参数化知识?

3. 我们的研究方法与评估设计

4. Grokking现象与其背后原理的深入分析

5. 模型的内部电路(circuits)与系统性泛化

6. 参数知识对于复杂推理的重要性

7. 总结与展望

Talk·预习资料

▼

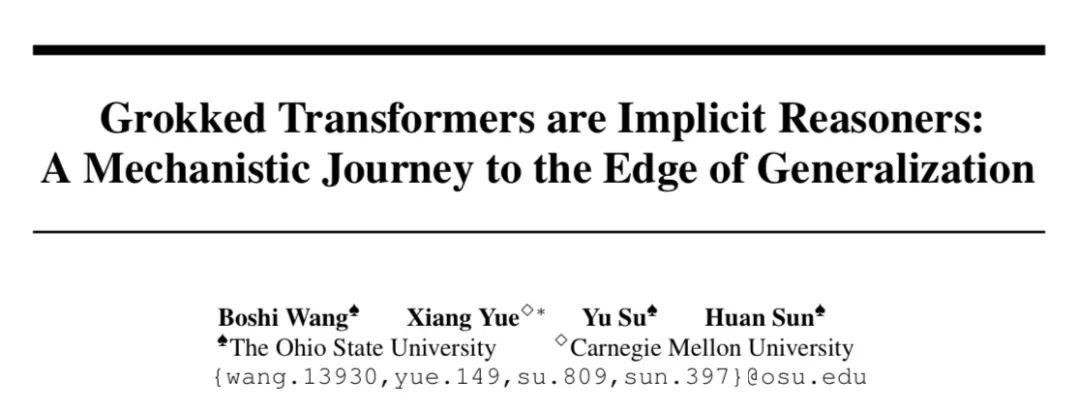

论文链接:

https://arxiv.org/abs/2405.15071

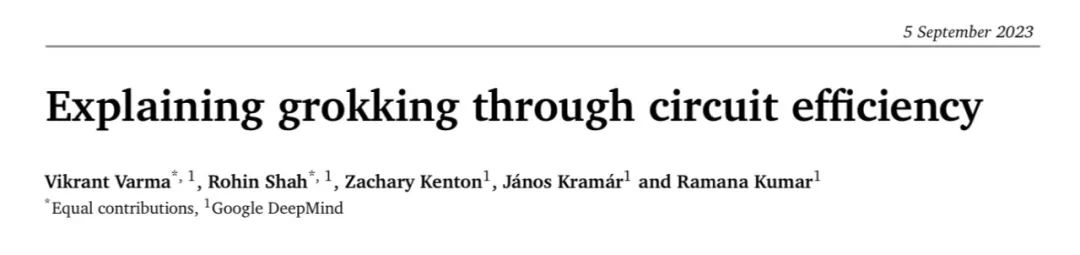

论文链接:

https://arxiv.org/abs/2309.02390

论文链接:

https://arxiv.org/abs/2201.02177

Talk·提问交流

▼

在Talk界面下的【交流区】参与互动!留下你的打call🤟和问题🙋,和更多小伙伴们共同讨论,被讲者直接翻牌解答!

你的每一次贡献,我们都会给予你相应的i豆积分,还会有惊喜奖励哦!

Talk·嘉宾介绍

▼

汪博石

俄亥俄州立大学 · 博士生

汪博石是俄亥俄州立大学的三年级博士生,在Huan Sun教授的指导下进行研究。他的主要研究方向为评估、理解和提升语言模型的知识和推理能力。他曾经在自然语言处理和人工智能领域的顶级会议上发表多篇论文,其中在ACL-23发表的理解大模型的思维链能力(Chain-of-Thought)的工作曾获得最佳论文荣誉提名奖。他的近期研究兴趣主要集中在Transformer模型的隐式推理能力和其相关的影响。

个人主页:

https://www.techbeat.net/grzytrkj?id=40608

关于TechBeat人工智能社区

▼

TechBeat(www.techbeat.net)隶属于将门创投,是一个荟聚全球华人AI精英的成长社区。

我们希望为AI人才打造更专业的服务和体验,加速并陪伴其学习成长。

期待这里可以成为你学习AI前沿知识的高地,分享自己最新工作的沃土,在AI进阶之路上的升级打怪的根据地!

更多详细介绍>>TechBeat,一个荟聚全球华人AI精英的学习成长社区