为什么要用代理呢?这个就涉及到安全问题了,你要是用一个IP频繁的访问人家网站,这不就是在搞事情么,人家网站肯定得把你的IP禁掉。所以我们爬虫的时候就得经常换IP,就是拿别人的IP不同人的IP访问网站去爬取数据。

我们去找一个免费IP拿来用,我这百度搜了一下

我们随便找一个IP试试

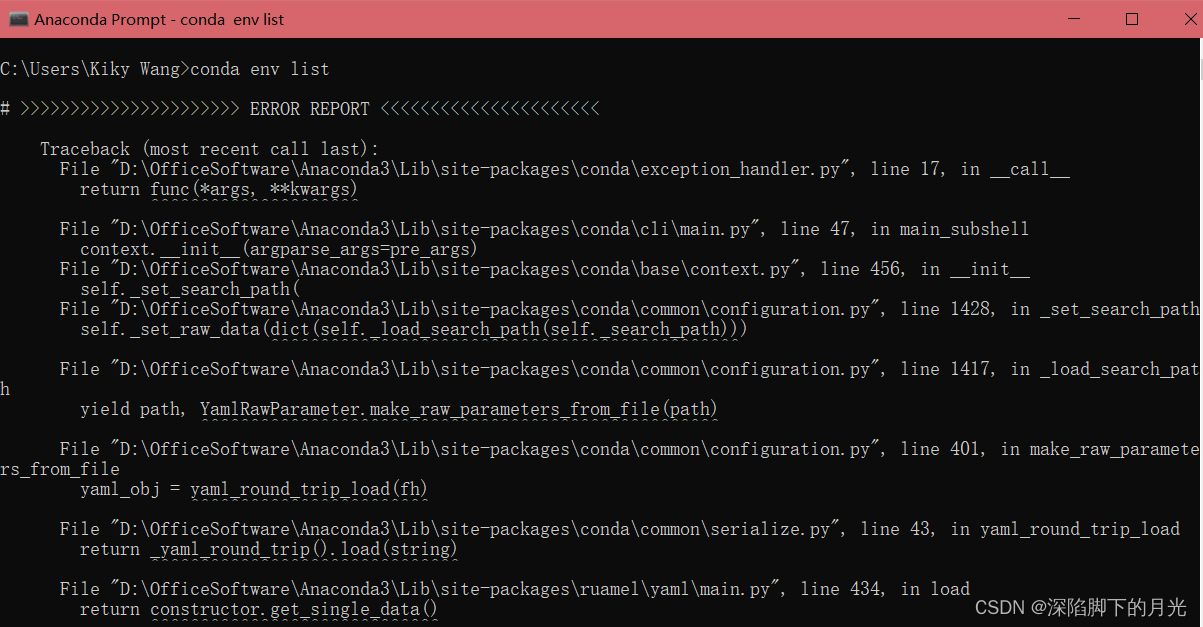

这里用到了urllib.request的ProxyHandler对象,不多说,上代码

from urllib.request import build_opener

from urllib.request import ProxyHandler

#创建proxy对象,就是设置代理ip和端口

proxy=ProxyHandler({'https':'159.226.227.78:80'})

#创建opener对象

opener=build_opener(proxy)

# 专门找了一个访问不复杂的网站

url='http://www.nuvszd.com.faloo.com'

resp=opener.open(url)

print(resp.read().decode('gbk'))

查看结果还可以,这个能用,返回数据正常

<!DOCTYPE html>

<html xmlns="http://www.w3.org/1999/xhtml">

<head>

<meta http-equiv="content-type" content="text/html;charset=gb2312" />

<title>飞卢小说,飞要你好看|小说,小说网-飞卢小说网</title>

<meta content="小说,小说网,飞卢小说网,原创小说,小说阅读,小说阅读网,好看的小说,同人小说,火影小说,综漫小说,海贼小说,小说排行榜,免费小说,都市小说,网游小说" name="keywords" />

<meta content="飞卢小说网,最热门的免费小说网站,提供都市小说、玄幻小说、穿越小说、言情小说、同人小说等免费小说在线阅读与下载。大神小说齐聚飞卢,每日万字更新。" name="description" />

<meta http-equiv="X-UA-Compatible" content="IE=edge,chrome=1" />

<meta name="renderer" content="webkit" />

<meta content="小说阅读网@faloo.com" name="author" />