说在开始

学习下mindspore中对tensor的处理逻辑。

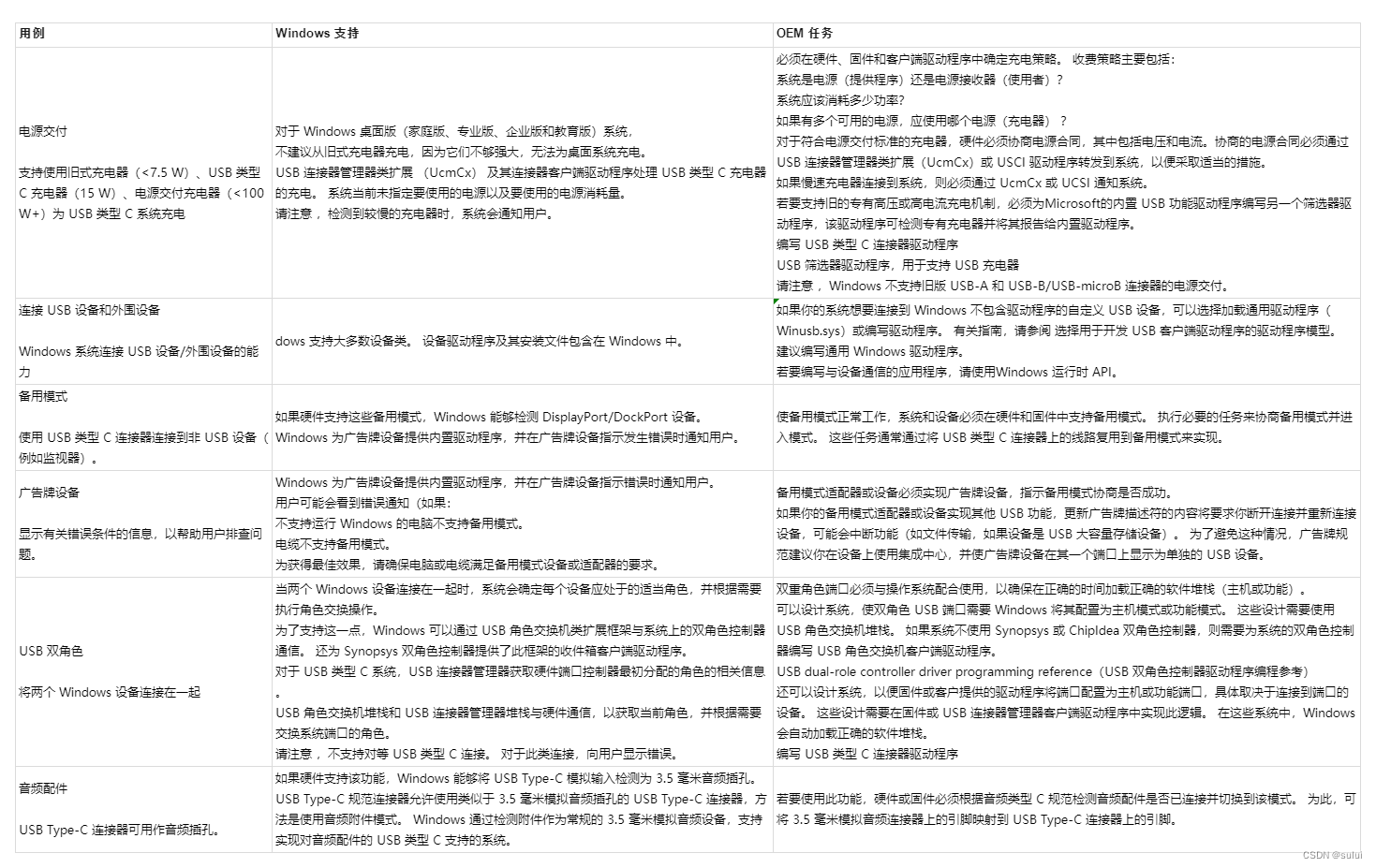

Tensor属性

张量的属性包括形状、数据类型、转置张量、单个元素大小、占用字节数量、维数、元素个数和每一维步长。

形状(shape):Tensor的shape,是一个tuple。

数据类型(dtype):Tensor的dtype,是MindSpore的一个数据类型。

单个元素大小(itemsize): Tensor中每一个元素占用字节数,是一个整数。

占用字节数量(nbytes): Tensor占用的总字节数,是一个整数。

维数(ndim): Tensor的秩,也就是len(tensor.shape),是一个整数。

元素个数(size): Tensor中所有元素的个数,是一个整数。

每一维步长(strides): Tensor每一维所需要的字节数,是一个tuple。

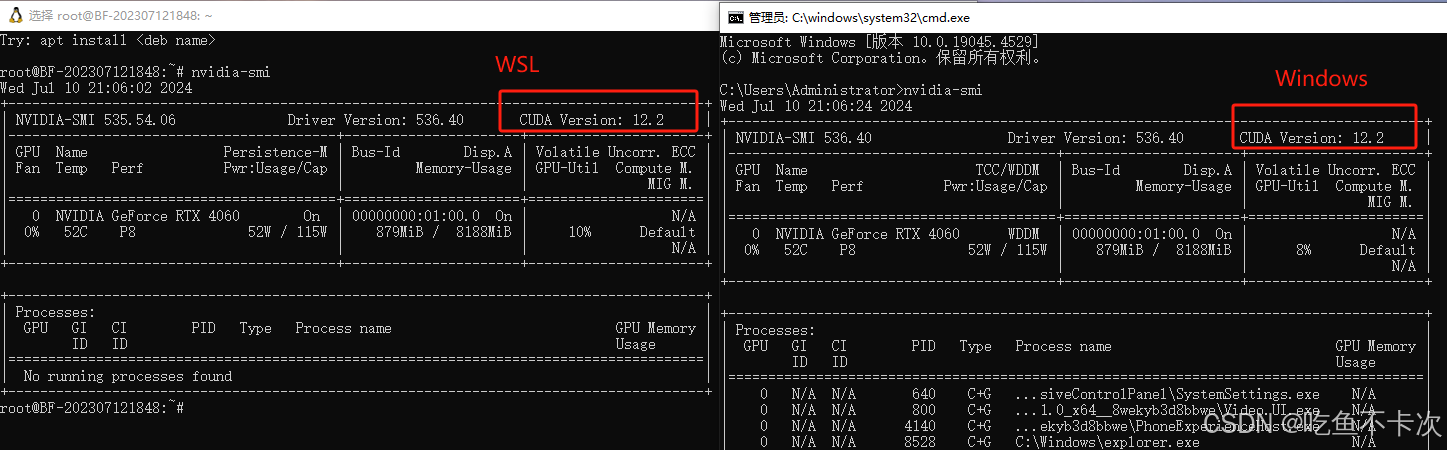

接下来这个例子很有趣:

stride的结果很奇怪,为什么是(8, 4)呢,理论上应该是(2, 1)才对,通过查看了解到:

PyTorch:stride() 返回值以元素为单位。

NumPy 和 MindSpore:strides 属性返回值以字节为单位。

这个的确是比较特殊的。但是在看ascend的使用方法上,内部使用的stride其实是和torch对齐的,应该只是在最上层有一些包装,是和numpy对齐了。

张量索引

这部分的逻辑主要涉及index和index_put算子,这里的实现逻辑实现起来是相对复杂的,并不像数学运算的算子那么容易。

张量运算

这里的处理逻辑能理解,特殊的是像concat和stack算子,在之前的学习中,给我带来了比较大的压力。

看下面两个例子:

和numpy转换

分别使用asnumpy和from_numpy实现目的。

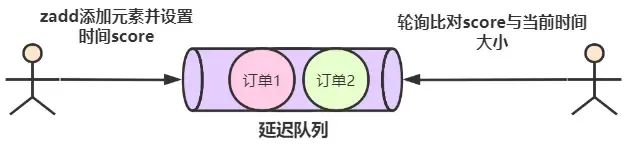

稀疏张量

实际的使用中接触较少,但是记得在搜索场景的模型中,是有用过稀疏tensor的。这部分在tensor flow中有介绍过的, 不过在大模型领域中介绍的较少。

打卡

最后还要记录打卡:

整体看,和pytorch还是比较接近的,不过部分逻辑不一致会和numpy比较接近。接下来要学习训练框架的内容了。