最近在做文本风格转化,涉及千万token级别的文本。想用大模型转写,在线的模型一来涉及数据隐私,二来又不想先垫钱再找报销。本地的7-9B小模型又感觉效果有限,正好实验室给俺配了4卡3090的机子,反正也就是做个推理,也不训练不微调,就想试试本地72B大模型能不能跑起来。

先上结论:

- 模型:Qwen-72B-Chat-Int4

- 使用2张3090 24G就能跑起来,但是上下文长度在一千汉字左右就会爆显存OOM

- 使用4张3090 24G也可以跑,上下文长度可以拓展到万字级别

- 速度:短上下文约10字/s,勉强够用:

下面讲讲怎么做的:

首先,有博主做了双卡3090部署Qwen2-72B-Int4的教程:

大模型笔记之-Qwen72B-chat-int4部署 |使用双卡3090成功运行_运行qwen-72b-CSDN博客

笔者也是看着该教程跑起来的,但是完全按照该教程会出现很多的问题:比如刚跑起来的时候,推理速度非常慢,大约1token/s,官方文档里面同样模型用A100能做到11.32token/s,完全没道理的。

整体流程:

1. 下载模型

从魔搭社区下载,不需要梯子

from modelscope.hub.snapshot_download import snapshot_download

model_dir = snapshot_download('qwen/Qwen-72B-Chat-Int4')

# 在当前目录下创建一个名为model_dir的txt文件,里面包含model_dir变量的内容

with open('model_dir.txt', 'w') as f:

f.write(model_dir)2. 配置环境

笔者cuda driver版本(通过nvidia-smi查看)是12.0,使用cuda runtime版本(通过nvcc -V查看)也应为12.0/12.1,否则后面源码编译flash-attention时会报ptxas版本错误:(以前都是runtime<=driver就行了,现在终于碰见一种情况必须==了)

ptxas *.ptx, line 9; Fatal : Unsupported .version 8.0; current version is ‘7.1’ ptxas fatal

2.1. 基础conda环境

conda安装:

python==3.10

pytorch==2.1.0

pytorch-cuda==12.1

由于conda里面 cuda toolkit / cuda runtime 没有 12.0版本(conda search cudatoolkit最高11.8),所以还得源码编译,但是实验室的服务器咱也没有root权限,所以参考这篇文章中修改路径的做法:不用sudo权限安装cuda10.1_非sudo用户安装cuda-CSDN博客

2.2. Qwen pip依赖

接着就是安装Qwen需要的pip依赖,首先下载Qwen git仓库

git clone https://github.com/QwenLM/Qwen.git

安装pip依赖:

#1.切换至项目目录下

cd Qwen

#2.安装项目依赖

pip install -r requirements.txt

#使用镜像源加速 pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple/

#3.使用web_demo.py 还需要安装web依赖

pip install -r requirements_web_demo.txt

2.3. 安装量化模块auto-gptq

因为我们用Int4量化版本,所以需要安装auto-gptq量化包。在官方指南中,直接使用了pip安装,事后笔者发现这样安装会出现严重问题(事实上,这样子做可能会让推理速度降至1/10,而且还很难排查),在此我们先给出完美方案(参考Auto-GBTQ源码编译):

git clone https://github.com/PanQiWei/AutoGPTQ.git && cd AutoGPTQ

pip install numpy gekko pandas

# 有点小久

pip install -vvv --no-build-isolation -e .2.4. 安装flash-attention(可选)

flash-attention据悉可以加速模型加载和推理,笔者自己感觉没什么区别。

注意要安装的话需要将cuda runtime(nvcc -V)和cuda driver(nvidia-smi)的版本对齐。

git clone https://github.com/Dao-AILab/flash-attention

cd flash-attention && pip install .

# 下方安装可选,安装可能比较缓慢。

# pip install csrc/layer_norm

# 如果flash-attn版本高于2.1.1,下方无需安装。

# pip install csrc/rotary3. 运行

Qwen git repo中cli_demo和web_demo均可运行

3.1. 修改DEFAULT_CKPT_PATH

修改DEFAULT_CKPT_PATH为前文1.中model_dir(cli_demo 19行,web_demo 18行)

3.2. 修改device_map为多卡配置

(cli_demo 52行,web_demo 48行):

2卡参考大模型笔记之-Qwen72B-chat-int4部署 |使用双卡3090成功运行_运行qwen-72b-CSDN博客

4卡:

# 偏向于少分配给卡0,因为在推理时卡0需要承担高负载

device_map = {'transformer.wte': 0, 'transformer.drop': 0, 'transformer.rotary_emb': 0, 'transformer.h.0': 0,

'transformer.h.1': 0, 'transformer.h.2': 0, 'transformer.h.3': 0, 'transformer.h.4': 0,

'transformer.h.5': 0, 'transformer.h.6': 0, 'transformer.h.7': 0, 'transformer.h.8': 0,

'transformer.h.9': 1, 'transformer.h.10': 1, 'transformer.h.11': 1, 'transformer.h.12': 1,

'transformer.h.13': 1, 'transformer.h.14': 1, 'transformer.h.15': 1, 'transformer.h.16': 1,

'transformer.h.17': 1, 'transformer.h.18': 1, 'transformer.h.19': 1, 'transformer.h.20': 1,

'transformer.h.21': 1, 'transformer.h.22': 1, 'transformer.h.23': 1, 'transformer.h.24': 1,

'transformer.h.25': 1, 'transformer.h.26': 1, 'transformer.h.27': 1, 'transformer.h.28': 1,

'transformer.h.29': 1, 'transformer.h.30': 1, 'transformer.h.31': 1, 'transformer.h.32': 1,

'transformer.h.33': 1, 'transformer.h.34': 1, 'transformer.h.35': 1, 'transformer.h.36': 2,

'transformer.h.37': 2, 'transformer.h.38': 2, 'transformer.h.39': 2, 'transformer.h.40': 2,

'transformer.h.41': 2, 'transformer.h.42': 2, 'transformer.h.43': 2, 'transformer.h.44': 2,

'transformer.h.45': 2, 'transformer.h.46': 2, 'transformer.h.47': 2, 'transformer.h.48': 2,

'transformer.h.49': 2, 'transformer.h.50': 2, 'transformer.h.51': 2, 'transformer.h.52': 2,

'transformer.h.53': 2, 'transformer.h.54': 2, 'transformer.h.55': 2, 'transformer.h.56': 2,

'transformer.h.57': 2, 'transformer.h.58': 2, 'transformer.h.59': 2, 'transformer.h.60': 2,

'transformer.h.61': 3, 'transformer.h.62': 3, 'transformer.h.63': 3, 'transformer.h.64': 3,

'transformer.h.65': 3, 'transformer.h.66': 3, 'transformer.h.67': 3, 'transformer.h.68': 3,

'transformer.h.69': 3, 'transformer.h.70': 3, 'transformer.h.71': 3, 'transformer.h.72': 3,

'transformer.h.73': 3, 'transformer.h.74': 3, 'transformer.h.75': 3, 'transformer.h.76': 3,

'transformer.h.77': 3, 'transformer.h.78': 3, 'transformer.h.79': 3, 'transformer.ln_f': 3,

'lm_head': 3}

# 也可以用这个

device_map = 'balanced_low_0'静态负载:

3.3. 修改模型加载方式为AutoGPTQ

web_demo 50-55行

cli_demo 54-59行

model = AutoGPTQForCausalLM.from_quantized(

args.checkpoint_path,

device_map=device_map,

trust_remote_code=True,

resume_download=True,

# use_marlin=True,

).eval()如果用的是gptq v7.0,会让你用use_marlin:

INFO - You passed a model that is compatible with the Marlin int4*fp16 GPTQ kernel but use_marlin is False. We recommend using `use_marlin=True` to use the optimized Marlin kernels for inference. Example: `model = AutoGPTQForCausalLM.from_quantized(..., use_marlin=True)`.

但是不知道为什么,用了就报错,所以我注释掉了。

加载模型速度对比:

# 加载模型612.5322902202606s

model = AutoGPTQForCausalLM.from_quantized(

args.checkpoint_path,

device_map=device_map,

trust_remote_code=True,

resume_download=True,

use_marlin=False,

).eval()

# 加载模型612s

model = AutoModelForCausalLM.from_pretrained(

args.checkpoint_path,

device_map=device_map,

trust_remote_code=True,

resume_download=True,

use_flash_attn=True

).eval()

可以看出加载模型GPTQ快20%,官方文档说GPTQ推理速度也快20%,没实测,但显然和上面的观察结果一致。

3.4. 修改web_demo中的服务器地址,否则局域网无法访问

33行,改IP为0.0.0.0

parser.add_argument("--server-name", type=str, default="0.0.0.0",

help="Demo server name.")4. 关于我是如何发现并把推理速度提升10倍的

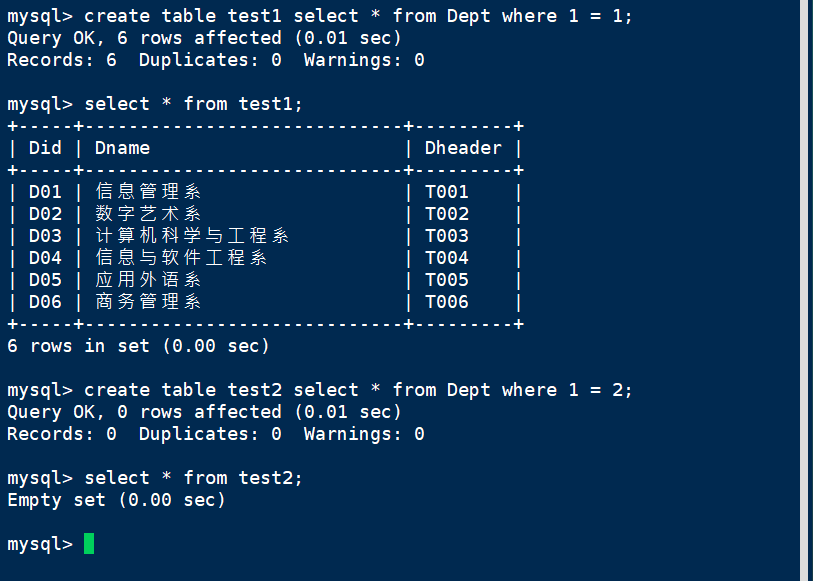

最初按照官方文档做完之后,双卡/四卡3090推理速度在1token/s左右,是官方1张A100速度的10%,完全不符合逻辑。本来打算放弃了,突然看到官方文档里有一句话说用AutoGPTQ加载能快20%,于是我就试了试AutoGPTQForCausalLM而不是AutoModelForCausalLM加载模型

model = AutoGPTQForCausalLM.from_quantized()但是其中给了我警告(AutoModelForCausalLM没有给过这个警告):

意思是我的auto-gptq包没装好,其中的Exllamav2没有安装,这会导致推理显著变慢。

于是我按着gptq主页:AutoGPTQ/AutoGPTQ: An easy-to-use LLMs quantization package with user-friendly apis, based on GPTQ algorithm. (github.com)的教程从源码编译装好了,速度就拉满了。

现在3090多卡速度(10token/s)和官方单张A100速度(10token/s)接近,可以看出其实卡间通讯其实并不是瓶颈。