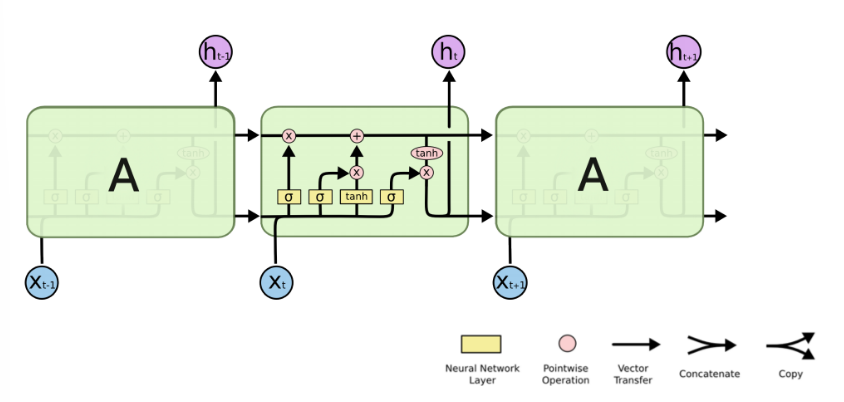

一、BiFPN原理

1.1 基本原理

BiFPN(Bidirectional Feature Pyramid Network),双向特征金字塔网络是一种高效的多尺度特征融合网络,其基本原理概括分为以下几点:

- 双向特征融合:BiFPN允许特征在自顶向下和自底向上两个方向上进行融合,从而更有效地结合不同尺度的特征。

- 加权融合机制:BiFPN通过为每个输入特征添加权重来优化特征融合过程,使得网络可以更加重视信息量更大的特征。

- 结构优化:BiFPN通过移除只有一个输入边的节点、添加同一层级的输入输出节点之间的额外边,并将每个双向路径视为一个特征网络层,来优化跨尺度连接。

如下图所示:

(a) FPN (Feature Pyramid Network): 引入了自顶向下的路径来融合从第3层到第7层(P3 - P7)的多尺度特征。

(b) PANet: 在FPN的基础上增加了自底向上的额外路径。

© NAS-FPN: 使用神经架构搜索(NAS)来找到不规则的特征网络拓扑,然后重复应用相同的块。

(d) BiFPN: 通过高效的双向跨尺度连接和重复的块结构,改进了准确度和效率之间的权衡。

我们可以看出BiFPN通过双向路径允许特征信息在不同尺度间双向流动,这种双向流动可以看做是在不同尺度之间进行有效信息交换。这样的设计旨在通过强化特征的双向流动来提升特征融合的效率和有效性,从而提高目标检测的性能。

1.2 双向特征融合

双向特征融合在BiFPN中指的是一种机制,它允许在特征网络层中的信息在自顶向下和自底向上两个方向上流动和融合。这种方法与传统的单向特征金字塔网络(如PANet)相比,能够在不同层级之间更高效地融合特征,而无需增加显著的计算成本。

在BiFPN中,每一条双向路径(自顶向下和自底向上)被视作一个单独的特征网络层,然后这些层可以被重复多次,以促进更高级别的特征融合。这样做的结果是一个简化的双向网络,它增强了网络对特征融合的能力,使网络能够更有效地利用不同尺度的信息,从而提高目标检测的性能。

2.3 加权融合机制

加权融合机制是BiFPN中用于改进特征融合效果的一种技术。在传统的特征金字塔网络中,所有输入特征通常在没有区分的情况下等同对待,这意味着不同分辨率的特征被简单地相加在一起,而不考虑它们对输出特征的不同贡献。然而,在BiFPN中,观察到由于不同的输入特征具有不同的分辨率,它们通常对输出特征的贡献是不等的。

为了解决这个问题,BiFPN提出了为每个输入添加一个额外的权重,并让网络学习每个输入特征的重要性,融合的权重在训练过程中学习,确保了最佳的特征整合。

二、如何添加

2.1 BiFPN代码

在’ultralytics/nn/modules’目录下,创建一个py文件粘贴进去,bifpn.py

import torch.nn as nn

import torch

class swish(nn.Module):

def forward(self, x):

return x * torch.sigmoid(x)

class Bi_FPN(nn.Module):

def __init__(self, length):

super().__init__()

self.weight = nn.Parameter(torch.ones(length, dtype=torch.float32), requires_grad=True)

self.swish = swish()

self.epsilon = 0.0001

def forward(self, x):

weights = self.weight / (torch.sum(self.swish(self.weight), dim=0) + self.epsilon) # 权重归一化处理

weighted_feature_maps = [weights[i] * x[i] for i in range(len(x))]

stacked_feature_maps = torch.stack(weighted_feature_maps, dim=0)

result = torch.sum(stacked_feature_maps, dim=0)

return result

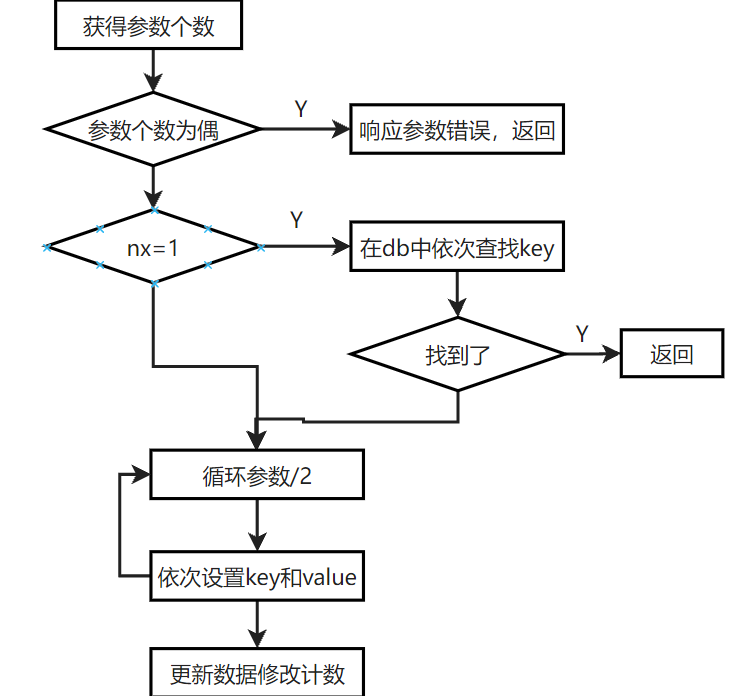

2.2 修改一

找到如下的文件’‘ultralytics/nn/tasks.py’',在文件的开头处导入我们的模块。

from .modules.bifpn import Bi_FPN

2.3 修改二

找到parse_model的方法,在下面注册我们的模块。

三、yaml文件配置

# Ultralytics YOLO 🚀, AGPL-3.0 license

# YOLOv8 object detection model with P3-P5 outputs. For Usage examples see https://docs.ultralytics.com/tasks/detect

# Parameters

nc: 80 # number of classes

scales: # model compound scaling constants, i.e. 'model=yolov8n.yaml' will call yolov8.yaml with scale 'n'

# [depth, width, max_channels]

n: [0.33, 0.25, 1024] # YOLOv8n summary: 225 layers, 3157200 parameters, 3157184 gradients, 8.9 GFLOPs

s: [0.33, 0.50, 1024] # YOLOv8s summary: 225 layers, 11166560 parameters, 11166544 gradients, 28.8 GFLOPs

m: [0.67, 0.75, 768] # YOLOv8m summary: 295 layers, 25902640 parameters, 25902624 gradients, 79.3 GFLOPs

l: [1.00, 1.00, 512] # YOLOv8l summary: 365 layers, 43691520 parameters, 43691504 gradients, 165.7 GFLOPs

x: [1.00, 1.25, 512] # YOLOv8x summary: 365 layers, 68229648 parameters, 68229632 gradients, 258.5 GFLOPs

# YOLOv8.0n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 3, C2f, [128, True]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 6, C2f, [256, True]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 6, C2f, [512, True]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 3, C2f, [1024, True]]

- [-1, 1, SPPF, [1024, 5]] # 9

# YOLOv8.0n head

head:

- [4, 1, Conv, [256]] # 10-P3/8

- [6, 1, Conv, [256]] # 11-P4/16

- [9, 1, Conv, [256]] # 12-P5/32

- [-1, 1, nn.Upsample, [None, 2, 'nearest']] # 13 P5->P4

- [[-1, 11], 1, Bi_FPN, []] # 14

- [-1, 3, C2f, [256]] # 15-P4/16

- [-1, 1, nn.Upsample, [None, 2, 'nearest']] # 16 P4->P3

- [[-1, 10], 1, Bi_FPN, []] # 17

- [-1, 3, C2f, [256]] # 18-P3/8

- [1, 1, Conv, [256, 3, 2]] # 19 P2->P3

- [[-1, 10, 18], 1, Bi_FPN, []] # 20

- [-1, 3, C2f, [256]] # 21-P3/8

- [-1, 1, Conv, [256, 3, 2]] # 22 P3->P4

- [[-1, 11, 15], 1, Bi_FPN, []] # 23

- [-1, 3, C2f, [512]] # 24-P4/16

- [-1, 1, Conv, [256, 3, 2]] # 25 P4->P5

- [[-1, 12], 1, Bi_FPN, []] # 26

- [-1, 3, C2f, [1024]] # 27-P5/32

- [[21, 24, 27], 1, Detect, [nc]] # Detect(P3, P4, P5)

然后,即可运行成功!