腾讯和上交发布了一个根据图片生成跳舞视频的项目MimicMotion。效果同时支持面部特征和唇形同步,不止可以搞跳舞视频,也可以做数字人。

MimicMotion方案优化的内容有:

-

引入基于置信度的姿态引导机制。确保生成的视频在时间上更加连贯流畅。

-

开发了基于姿态置信度的区域损失放大技术。能够显著减少生成图像中的扭曲和变形。

-

提出创新的渐进式融合策略。能够在可接受的计算资源消耗下,实现任意长度视频的生成。

相关链接

代码地址:https://github.com/tencent/MimicMotion

论文地址:https://arxiv.org/abs/2406.19680

论文阅读

MimicMotion :利用置信度感知姿势引导生成高质量人体运动视频

摘要

近年来,生成式人工智能在图像生成领域取得了长足进步,催生出各种应用。然而,视频生成在可控性、视频长度、细节丰富度等各方面仍面临巨大挑战,阻碍了这项技术的应用和普及。本文提出了一个可控的视频生成框架MimicMotion,可以在任意动作引导下生成任意长度的高质量视频。

与以前的方法相比,我们的方法有几个亮点。首先,通过置信度感知的姿势引导,可以实现时间平滑性,从而利用大规模训练数据增强模型鲁棒性。其次,基于姿势置信度的区域损失放大显著缓解了图像的失真。最后,为了生成长而流畅的视频,提出了一种渐进式潜在融合策略。通过这种方式,可以在可接受的资源消耗下生成任意长度的视频。经过大量的实验和用户研究,MimicMotion在多个方面比以前的方法有了显著的改进。

方法

MimicMotion 将图像到视频的扩散模型与新颖的置信感知姿势引导相结合。该模型的可训练组件包括时空 U-Net 和用于引入姿势序列作为条件的 PoseNet。置信感知姿势引导的主要特点包括:1) 姿势序列附有关键点置信度分数,使模型能够根据分数自适应地调整姿势引导的影响。2) 置信度高的区域在损失函数中被赋予更大的权重,从而放大它们在训练中的影响。

置信度感知姿势引导

我们利用姿势指导框架上的亮度来表示姿势估计的置信度。

特定区域手动精炼机

我们实施了一种基于置信度阈值生成掩码的掩码策略。我们取消掩码置信度得分超过预定义阈值的区域,从而识别可靠区域。在计算视频扩散模型的损失时,未掩码区域对应的损失值会按一定比例放大,因此它们可以比其他掩码区域对模型训练产生更大的影响。

逐渐潜在融合以实现时间平滑

我们提出了一种渐进式方法来生成具有时间平滑度的长视频。在每个去噪步骤中,首先使用训练模型对视频片段进行单独去噪,以相同的参考图像和相应的姿势子序列为条件。在每个去噪步骤中,重叠帧(在图中虚线框内标记)根据其帧位置逐步融合。

效果展示

跳舞&谈话

定量评估

我们的方法实现了更好的手部生成质量,并且更准确地遵循参考姿势。请注意,我们的方法不是在 TikTok 数据集上进行训练的。

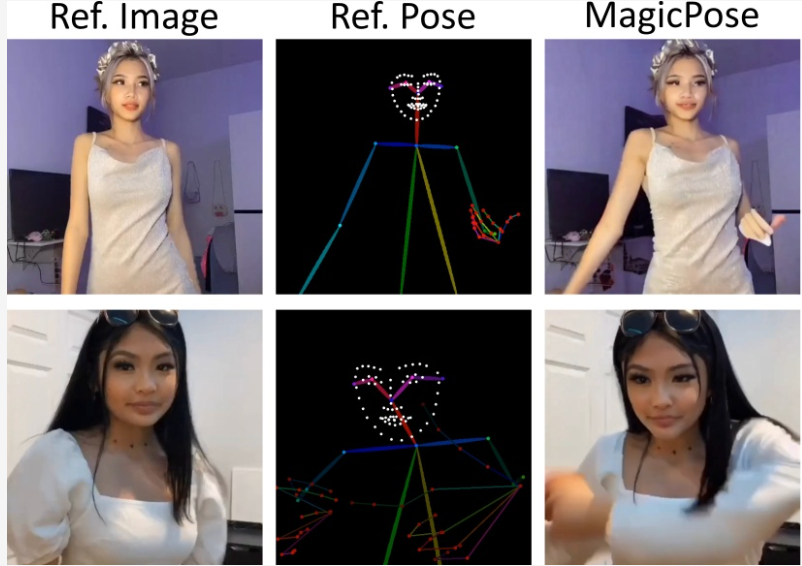

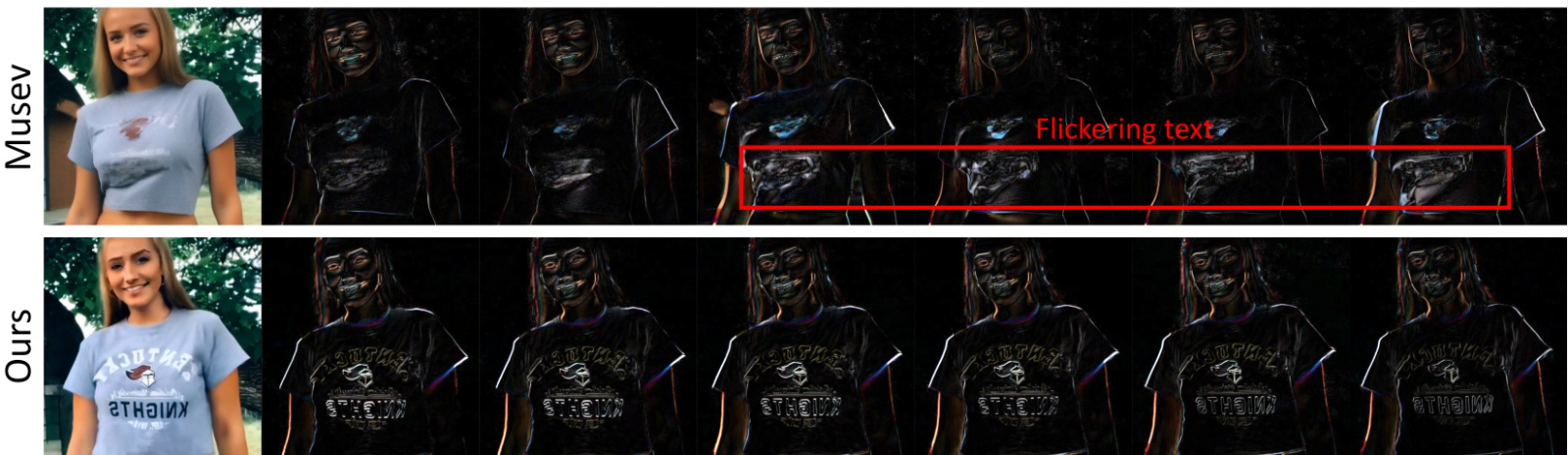

我们对 TikTok 数据集 seq 338 中的第 106 帧以及连续帧之间的像素差异进行了可视化。MagicPose 表现出突然的过渡,而 Moore 和 MuseV 表现出纹理和文本的不稳定性。相比之下,我们的方法表现出稳定的帧间差异和更好的时间平滑度。

时间平滑度与最先进方法的比较

定量评估

MimicMotion(我们的)在TikTok数据集测试分裂上优于基线方法的偏好。相比其他方法,用户更喜欢MimicMotion。

消融研究

置信度感知姿势引导

这种设计增强了对错误引导信号(姿势 1 和 2)的生成鲁棒性,并提供了可见性提示来解决姿势模糊性(姿势 3)。

手部区域增强

在相同的参考图像和姿势指导下,通过手部增强训练可以持续减少手部扭曲并增强视觉吸引力。

渐进性潜在融合

渐进式潜在融合可实现平滑过渡并避免跨视频片段边界的突然变化,从而增强长视频生成的整体视觉时间连贯性。

结论

在本研究中,我们引入了 MimicMotion,这是一种姿势引导的人体视频生成模型,它利用置信度感知姿势引导和渐进式潜在融合来制作高质量的长视频,其中人体运动由姿势引导。通过大量的实验和消融研究,我们表明我们的模型对嘈杂的姿势估计具有出色的适应性,提高了手部质量并确保了时间平滑度。将置信度得分整合到姿势引导中、增强手部区域损失以及实施渐进式潜在融合对于实现这些改进至关重要,从而产生更具视觉吸引力和逼真的人体视频生成。