系列篇章💥

| No. | 文章 |

|---|---|

| 1 | 【Qwen部署实战】探索Qwen-7B-Chat:阿里云大型语言模型的对话实践 |

| 2 | 【Qwen2部署实战】Qwen2初体验:用Transformers打造智能聊天机器人 |

| 3 | 【Qwen2部署实战】探索Qwen2-7B:通过FastApi框架实现API的部署与调用 |

| 4 | 【Qwen2部署实战】Ollama上的Qwen2-7B:一键部署大型语言模型指南 |

| 5 | 【Qwen2部署实战】llama.cpp:一键部署高效运行Qwen2-7b模型 |

| 6 | 【Qwen2部署实战】部署高效AI模型:使用vLLM进行Qwen2-7B模型推理 |

目录

- 系列篇章💥

- 引言

- 一、Ollama简介

- 二、Ollama部署运行

- 1、安装Ollama

- 2、验证安装

- 三、快速开始

- 四、高级用法

- 参数调整

- 样例1:调整生成文本的多样性

- 样例2:避免重复生成文本

- 结语

引言

在自然语言处理的前沿,大型语言模型(LLM)如Qwen2-7B正以其卓越的性能,开启智能应用的新篇章。然而,这些强大模型的本地部署往往因技术门槛而受限。【Qwen2】Ollama上的Qwen2-7B:一键部署大型语言模型指南,为您提供了解决方案。

本文将引导您通过Ollama平台,轻松实现Qwen2-7B模型的一键部署和运行。Ollama以其简洁的命令行界面,让复杂的模型运行变得异常简单,无论您是AI领域的新手还是资深开发者,都能快速上手。

让我们启程,一探Ollama如何让大型语言模型的本地部署变得触手可及。

一、Ollama简介

Ollama作为一个创新的本地部署工具,极大地简化了大型语言模型(LLM)的运行过程。它支持MacOS、Linux和Windows操作系统,使用户能够通过简单的命令行操作快速体验Qwen2模型的强大功能。

Ollama的设计宗旨是让用户轻松地在本地机器上运行大型语言模型。对于Qwen2模型,Ollama提供了一站式的解决方案,从模型下载到运行,一切都变得异常简单。

二、Ollama部署运行

1、安装Ollama

在开始之前,您需要在您的设备上安装Ollama。这个过程非常简单,以下是详细的步骤:

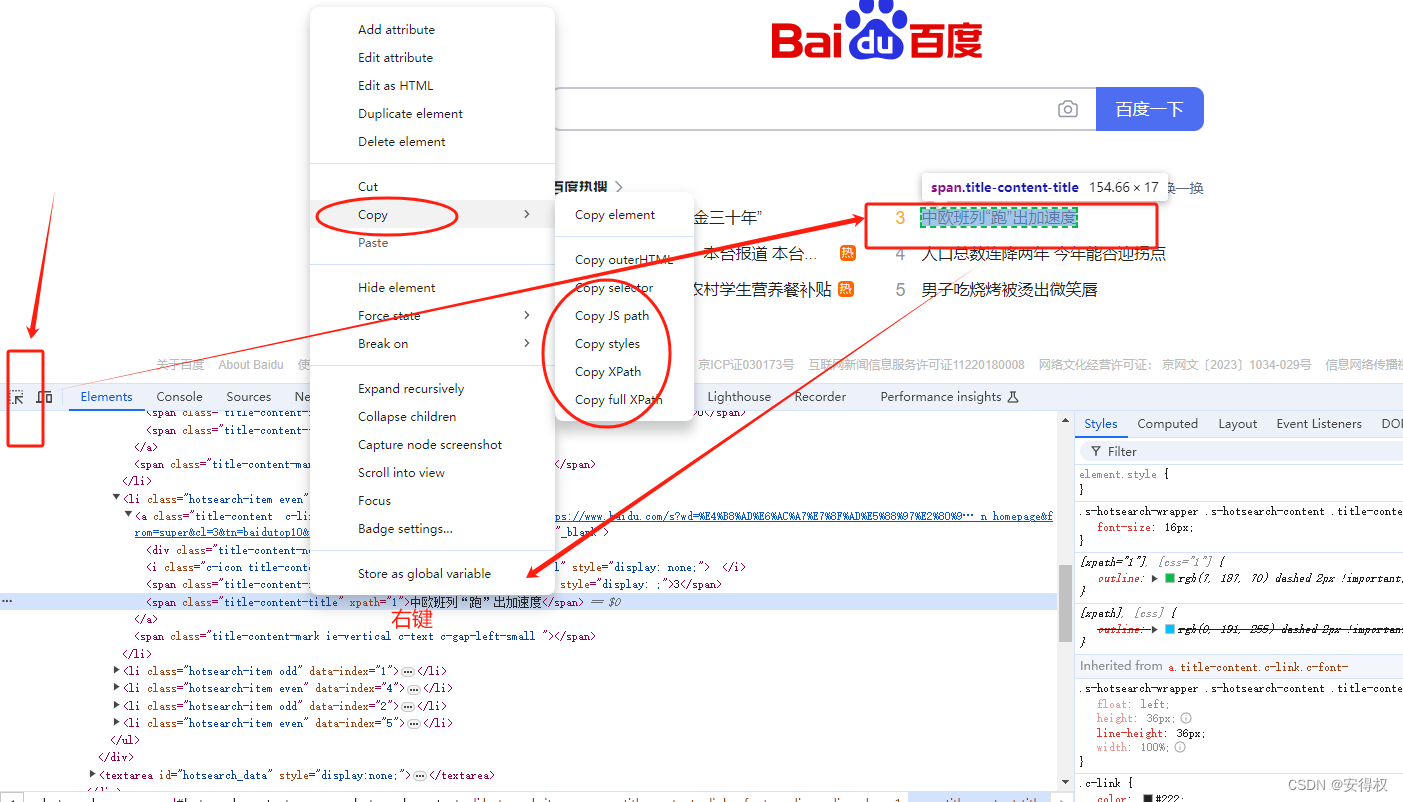

- 访问官方网站:打开浏览器,访问Ollama官方网站。

- 选择版本:根据您的操作系统选择相应的安装包。Ollama支持MacOS、Linux和Windows。

- 下载安装包:点击Download按钮,下载适用于您设备的Ollama安装包。

- 安装Ollama:根据下载的安装包格式,运行安装程序或解压缩文件到您选择的目录。

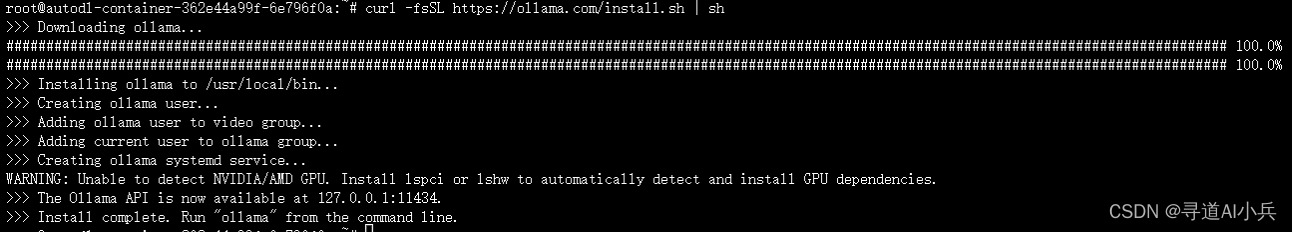

对于Linux用户,您还可以通过以下命令行安装,其他操作系统,

请参考地:https://github.com/ollama/ollama?tab=readme-ov-file

curl -fsSL https://ollama.com/install.sh | sh

请根据实际发布的版本号替换上述命令中的版本信息。

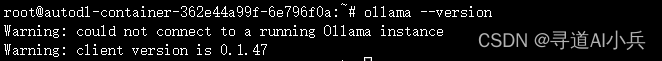

2、验证安装

安装完成后,您可以通过运行以下命令来验证Ollama是否正确安装:

ollama --version

如果安装正确,该命令将输出Ollama的版本信息。

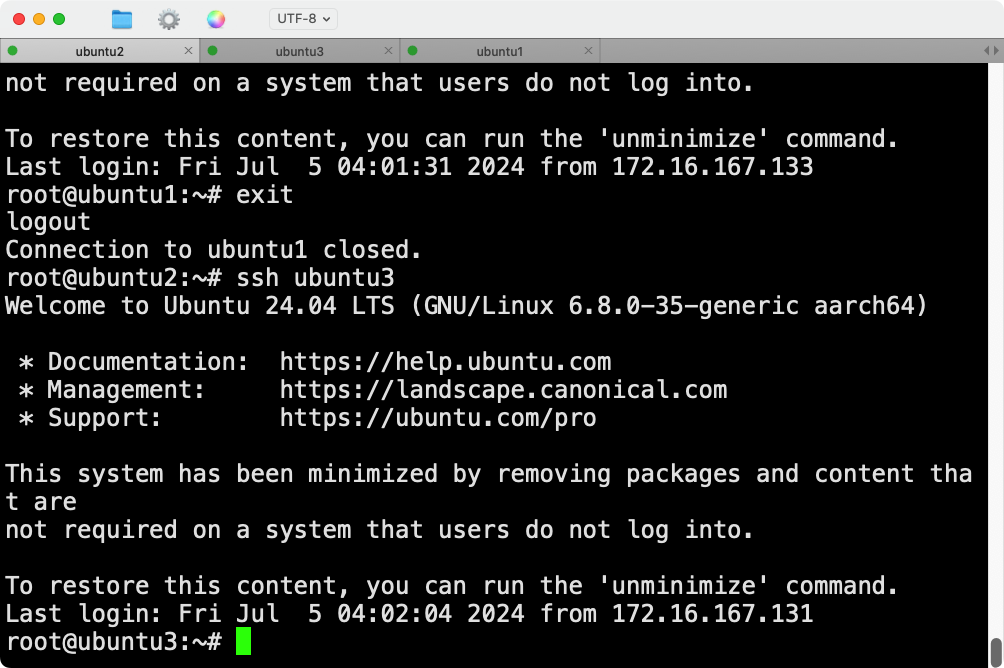

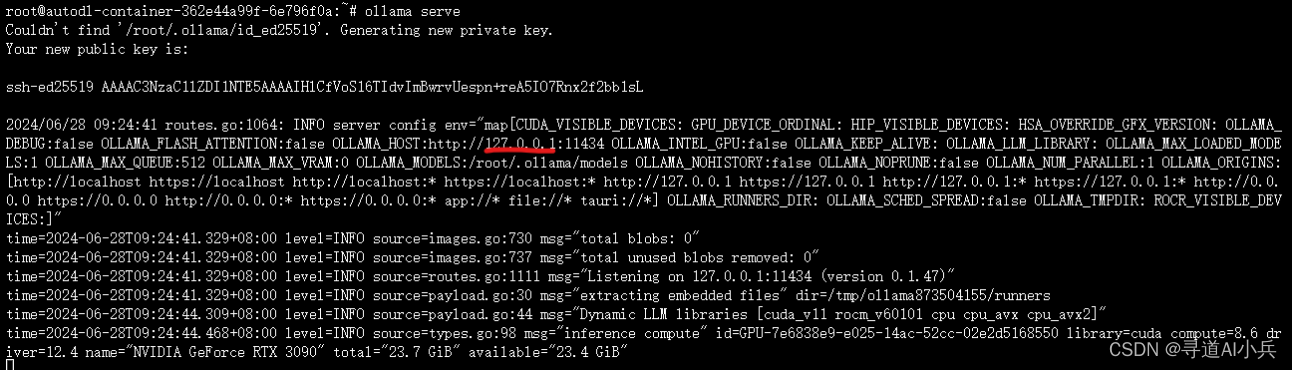

启动ollama

ollama serve

三、快速开始

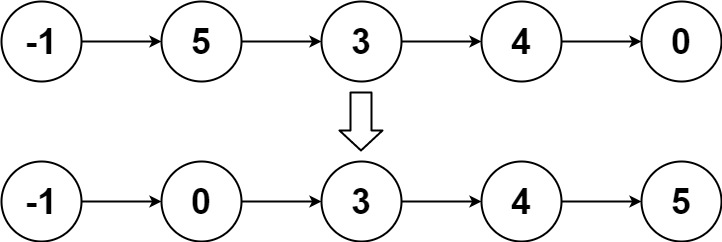

访问Ollama官方网站,点击Download获取适用于您操作系统的安装包。安装完成后,在Ollama的模型库中搜索并找到Qwen2系列模型。运行Qwen2模型,只需一条命令:(另外打开一个命令窗口执行)

ollama run qwen2

要运行特定大小的Qwen2-Instruct模型,例如7B大小的模型,可以通过指定模型标签来实现:

ollama run qwen2:7b

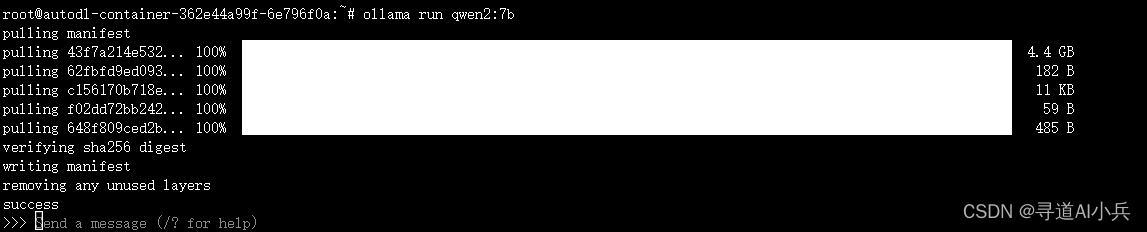

下载&启动运行成功如下:

对话测试如下:

>>> 你好?

你好!有什么问题我可以帮助你解答吗?

>>> 你是谁?

我是阿里云开发的一款超大规模语言模型,我叫通义千问。作为一个AI助手,我的主要任务是回答用户的问题、提供信息和在各个领域与用户进行交流。我被设计为能理解自然语

言,并以简洁明了的方式提供帮助或解答问题。请随时告诉我你有需要了解的内容,我会尽力提供支持!

>>> 什么是通义千问?

通义千问是阿里云研发的超大规模语言模型,它具有生成人类级别文本、回答问题和与用户进行对话的能力。作为一个AI助手,我旨在帮助解答问题、提供建议或进行信息交流。

请告诉我你有什么需要了解的内容或者想要探讨的话题,我会尽力提供帮助!

>>> 什么是大语言模型?

大语言模型(Large Language Model, LLM)是指通过大量数据训练的复杂深度学习模型,能够处理自然语言任务并生成与输入相关的文本。这些模型在结构上通常包含许多层神

经网络和大量的参数,使其具有高度的学习能力和适应性。

大语言模型的核心在于它们采用自注意力机制(Self-Attention Mechanism),这是一种用于理解和表示序列数据的方法,使得模型不仅关注单词之间的顺序关系,还能够捕捉到

语义上的关联。这使得大语言模型在生成连贯、相关且高质量的文本方面表现优异,适用于多种自然语言处理任务,包括但不限于:

- 文本生成:从给定的句子或主题自动创作新文本。

- 问答系统:回答问题、提供定义、解释和建议等。

- 文本翻译:将一种语言的文本自动转换为另一种语言。

- 代码生成与修复:编写、修改或理解程序代码。

- 对话管理:在聊天机器人和虚拟助手中进行自然流畅的对话。

大语言模型的训练通常需要海量的数据集,这包括从各种来源收集的语料库。通过使用大量数据进行微调,这些模型能够针对特定任务获得更好的性能,但同时也可能带来一些挑

战,比如模型偏见、透明度问题以及生成不准确或有害内容的风险。因此,在实际应用中,往往需要采取相应的策略来优化和监控这些模型的行为。

四、高级用法

Ollama不仅提供了简单的命令行操作,还允许用户通过高级配置来充分利用Qwen2模型的功能。

参数调整

您可以调整以下参数来控制生成文本的特性:

| 参数名 | 描述 | 类型 | 默认值 | 设置值 |

|---|---|---|---|---|

| mirostat | 启用 Mirostat 采样以控制复杂度。(默认:0,0=禁用,1=Mirostat,2=Mirostat 2.0) | int | 0 | mirostat 0 |

| mirostat_eta | 影响算法响应生成文本反馈的速度。较低的学习率将导致调整速度较慢,而较高的学习率将使算法更具响应性。(默认:0.1) | float | 0.1 | mirostat_eta 0.1 |

| mirostat_tau | 控制输出的一致性与多样性之间的平衡。较低的值将导致文本更加集中和一致。(默认:5.0) | float | 5.0 | mirostat_tau 5.0 |

| num_ctx | 设置用于生成下一个令牌的上下文窗口大小。(默认:2048) | int | 2048 | num_ctx 4096 |

| repeat_last_n | 设置模型向后查看的距离,以防止重复。(默认:64,0=禁用,-1=num_ctx) | int | 64 | repeat_last_n 64 |

| repeat_penalty | 设置对重复的惩罚强度。较高的值(例如 1.5)将更强烈地惩罚重复,而较低的值(例如 0.9)将更宽容。(默认:1.1) | float | 1.1 | repeat_penalty 1.1 |

| temperature | 模型的温度。增加温度将使模型回答更具创造性。(默认:0.8) | float | 0.8 | temperature 0.7 |

| seed | 设置用于生成的随机数种子。将此设置为特定数字将使模型对同一提示生成相同的文本。(默认:0) | int | 0 | seed 42 |

| stop | 设置用于停止的序列。当遇到此模式时,LLM 将停止生成文本并返回。可以通过在 modelfile 中指定多个单独的 stop 参数来设置多个停止模式。 | string | stop “AI assistant:” | |

| tfs_z | 尾部自由采样用于减少输出中不太可能的令牌的影响。较高的值(例如 2.0)将更多地减少影响,而值为 1.0 时禁用此设置。(默认:1) | float | 1 | tfs_z 1 |

| num_predict | 生成文本时预测的最大令牌数。(默认:128,-1=无限生成,-2=填充上下文) | int | 128 | num_predict 42 |

| top_k | 降低生成无意义文本的概率。较高的值(例如 100)将提供更多样的回答,而较低的值(例如 10)将更为保守。(默认:40) | int | 40 | top_k 40 |

| top_p | 与 top-k 一起工作。较高的值(例如 0.95)将导致文本更多样化,而较低的值(例如 0.5)将生成更集中和保守的文本。(默认:0.9) | float | 0.9 | top_p 0.9 |

样例1:调整生成文本的多样性

通过调整top_p和top_k参数,我们可以控制生成文本的多样性和连贯性:

top_k 降低生成无意义文本的概率。较高的值(例如 100)将提供更多样的回答,而较低的值(例如 10)将更为保守。(默认:40) int top_k 40

top_p 与 top-k 一起工作。较高的值(例如 0.95)将导致文本更多样化,而较低的值(例如 0.5)将生成更集中和保守的文本。(默认:0.9) float top_p 0.9

ollama run qwen2:7b --top_p 0.9 --top_k 50

样例2:避免重复生成文本

在需要避免模型重复生成相同文本的场景中,可以调整repeat_penalty参数:

repeat_penalty 设置对重复的惩罚强度。较高的值(例如 1.5)将更强烈地惩罚重复,而较低的值(例如 0.9)将更宽容。(默认:1.1)

ollama run qwen2:7b --repeat_penalty 2.0

结语

Ollama作为一个强大的本地部署工具,为用户提供了一种简便、高效的方式来运行和体验大型语言模型。本文介绍了如何在Ollama上部署并运行qwen2-7b模型,以及如何通过高级配置和实操样例来充分利用Ollama的功能。随着技术的不断发展,Ollama将继续扩展其功能,支持更多的模型和应用场景,为广大用户提供更加丰富的人工智能体验。

🎯🔖更多专栏系列文章:AI大模型提示工程完全指南、AI大模型探索之路(零基础入门)、AI大模型预训练微调进阶、AI大模型开源精选实践、AI大模型RAG应用探索实践🔥🔥🔥 其他专栏可以查看博客主页📑

😎 作者介绍:我是寻道AI小兵,资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索。

📖 技术交流:欢迎关注【小兵的AI视界】公众号或扫描下方👇二维码,加入技术交流群,开启编程探索之旅。

💘精心准备📚500本编程经典书籍、💎AI专业教程,以及高效AI工具。等你加入,与我们一同成长,共铸辉煌未来。

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我,让我们携手同行AI的探索之旅,一起开启智能时代的大门!

![FIND_IN_SET使用案例--[sql语句根据多ids筛选出对应数据]](https://i-blog.csdnimg.cn/direct/1e4b5dac32c1494c904ed47b8070ffba.png)